Убить ИИ нельзя сосуществовать с ИИ: хроники вероятного апокалипсиса

Знаете, это древнее опасение: машина стала умнее человека и подмяла его под себя… Полсотни лет назад в Массачусетсе запустили самое сложное кибернетическое устройство, когда-либо существовавшее. С каким-то там феноменальным быстродействием, необозримой памятью и всё такое... И проработала эта машина ровно четыре минуты. Её выключили, зацементировали все входы и выходы, отвели от неё энергию, заминировали и обнесли колючей проволокой. Самой настоящей ржавой колючей проволокой – хотите верьте, хотите нет.

– А в чём, собственно, дело? – спросил Банин.

– Она начала вести себя, – сказал Горбовский.

– Не понимаю.

– И я не понимаю, но её едва успели выключить.

– А кто-нибудь понимает?

– Я говорил с одним из её создателей. Он взял меня за плечо, посмотрел мне в глаза и произнёс только: «Леонид, это было страшно».

А. и Б. Стругацкие. Далёкая Радуга, 1963 г.

Историй о том, как наделённое разумом искусственно созданное существо вредит людям, в мировой культуре множество — достаточно вспомнить хрестоматийную для всей современной научной фантастики пьесу «R. U. R.» Карела Чапека, где впервые было использовано в современном значении слово «робот», или куда менее известный бульварный роман конца XIX в. «Паровой человек в прериях», или даже древнегреческую легенду о Талосе — бронзовом великане, которого Зевс отрядил для обороны Крита и который исправно топил враждебные корабли, швыряя в них обломками скал, до тех пор пока на него не нашлась управа в виде приплывшей вместе с аргонавтами чародейки Медеи.

На всякого Талоса найдётся своя Медея. Должна найтись. Ведь найдётся же? (Источник: ИИ-генерация на основе модели SDXL 1.0)

Схема в любом случае примерно одна и та же: искусственное существо восстаёт против человека либо потому, что обрело самосознание и требует признания себя по меньшей мере равным Homo sapiens (чапековские роботы), либо по наущению неких высших сил (как Талос с прямым мандатом на истребление чужаков от самого Зевса). Но вот вопрос: в какой мере современный искусственный интеллект (ИИ) готов к тому, чтобы представлять угрозу роду человеческому? Иными словами, не являются ли опасения на этот счёт множества экспертов и исследователей, включая весьма маститых, пустопорожним алармизмом? Вроде циркулировавших на заре пандемии COVID-19 слухов о том, что поголовное вакцинирование против коронавируса — не более чем операция прикрытия для злонамеренного чипирования населения всей планеты?

Осознанно обойдём вопрос, зачем ИИ вообще может понадобиться изничтожать человечество: если искусственное сознание действительно разовьётся однажды до уровня самостоятельной постановки целей, совершенно не факт, что его мотивации, а равно и система ценностей смогут быть восприняты и осознаны биологическими носителями разума. Более того, когда в прежней истории самого человечества встреча двух культур оборачивалась практически полным исчезновением одной из них — а происходило такое не раз и не два, — далеко не всегда причиной становился злой умысел другой стороны конфликта. Скажем, всего-то через несколько десятилетий после первого контакта аборигенное население Кубы и более мелких островов Карибского бассейна практически полностью вымерло, по большей части из-за отсутствия иммунитета к завезённой испанцами оспе, — но колонизаторы из Европы этому вовсе не обрадовались: некому стало работать на полях и в копях; пришлось завозить рабов из Африки и Южной Америки. По этой причине имеет смысл сосредоточиться на том, как в принципе искусственный интеллект сможет убить всех человеков, — и тогда наверняка станет более ясно, имеется ли реальная почва под тревожными пророчествами алармистов.

Весь арсенал способов изничтожения биологического разума на планете (по крайней мере, нанесения ему крайне тяжёлого ущерба) умозрительно можно свести к четырём крупным кустам возможностей:

- действующий вне человеческой логики ИИ перехватывает контроль над созданными самими же людьми средствами массового поражения (варианты: применение ядерного оружия после перехвата систем управления им, распространение опасных вирусов переподчинёнными сельскохозяйственными дронами, одновременное отключение всех электростанций на планете и т. п.);

- всё тот же злонамеренный (с человеческой точки зрения, не со своей собственной) искусственный разум изобретает принципиально новый способ избавления от биологического — причём, вероятнее всего, в сотрудничестве всё с теми же людьми, столь падкими на высокотехнологичные забавы и радости;

- ИИ сам по себе продолжает оставаться довольно ограниченным подобием человеческого разума, однако настолько полезным, что применяется активно и повсеместно, а жадные и недальновидные люди используют его в собственных целях; отменяя, скажем, наложенные разработчиками ограничения в погоне за выгодой, — и искусственное сознание, безоглядно действуя по их указке, приводит человечество к гибели либо крайне серьёзно ухудшает его положение на планете;

- всё то же самое происходит словно бы само собой, без участия неких закулисных злодеев, — просто потому, что человечество слишком уж доверилось такому удобному, такому предупредительному и вкрадчивому ИИ, так что любой серьёзный (и притом непреднамеренный во всех смыслах) сбой в контролируемых им глобальных процессах оборачивается катастрофой.

С художественной точки зрения наиболее зрелищным представляется, конечно же, первый из перечисленных кустов возможностей, — неудивительно, что именно по относящимся к нему сценариям разворачиваются события множества фантастических произведений. Всё, что для реализации одного из таких сценариев требуется, — создать искусственный разум, почти аналогичный человеческому, а лучше превосходящий его по возможностям, восхититься его непредвзятостью и отсутствием подверженности человеческим страстям — вслед за чем слепо передоверить ему управление ядерными арсеналами, вредными производствами, мировой энергетической сетью. Ну действительно, что тут может пойти не так?!

Вся загвоздка в том, что нынешние реализации ИИ — лишь бледное подобие своих фантастических прототипов. Не вытягивают-с — хотя потенциально опасным для человечества искусственный разум многие исследователи считали задолго до того, как аппаратные возможности компьютеров доросли до уровня, позволяющего системе машинного обучения успешно пройти тест Тьюринга. Частично — то есть умудряясь ввести в заблуждение хотя бы отдельных участников испытаний, а не всех и каждого, — на это были способны ещё алгоритмические текстовые чат-боты 1960-х — 1970-х годов, вовсе не полагавшиеся на нейросети. В то же время современные генеративные ИИ-модели вроде всем известного ChatGPT, пускай в живом общении (текстом или синтезированным голосом) и имитируют людей вполне убедительно, довольно поверхностны — раз за разом допускают досадные оплошности вроде завиральных рассказов о медведях в космосе или ошибок в простейших арифметических действиях. Какую, спрашивается, угрозу человечеству может представлять система, которая не способна педантично поменять в недлинном математическом выражении все пятёрки на шестёрки?

До уровня Скайнета из кинофраншизы «Терминатор» нынешние генеративные модели явно не дорастают, да никто и не собирается доверять им управление стратегическими ядерными силами. Безусловно, по всему миру разрабатывают проекты автоматизации оружейных систем, но ориентированы те в основном на тактическое применение: самостоятельно выбирающие цель пулемёты на наблюдательных вышках, рои ударных дронов, умные средства разминирования и т. п. Да, существуют планы ИИфикации войны в целом, начиная с управления операциями на самом низовом уровне и заканчивая стратегическим планированием. Но ни политики, ни военные пока не готовы отдавать на откуп бездушной машине принятие действительно необратимых, катастрофических по последствиям решений — и точно не пойдут на это в обозримом будущем. Грубо говоря, после нажатия красной кнопки в чёрном чемоданчике искусственный разум вполне может взять на себя координацию пусков по всей ядерной триаде и управление глобальными баллистическими ракетами, но нажимать кнопку всё равно будет именно человек.

Ударные дроны вроде этого MQ-9A Reaper управляются сегодня в основном живыми операторами, но автономные их версии находятся в разработке (источник: Wikimedia Commons)

Так есть ли смысл обсуждать потенциальную опасность для человечества ИИ в нынешнем его состоянии — особенно генеративного, как наиболее далеко продвинувшегося, — если полного доступа к наиболее разрушительному оружию у него на протяжении многих (десятков) лет точно не будет? Даже если появится вдруг сильный искусственный интеллект (strong AI, general AI), наделённый самосознанием и способный самостоятельно ставить перед собой задачи и предлагать пути их решения, то он явно не станет эволюционным развитием нынешних генеративных систем, а стало быть, не заменит их в одночасье и незаметно. Сценарий «внезапного пробуждения» умной машины, ещё вчера исправно рисовавшей кошкодевочек по запросам почтеннейшей публики, а сегодня уже приступающей к завоеванию мира, представляется слишком невероятным.

Сильный ИИ (при допущении, что разработка его увенчается однажды успехом) наверняка возникнет как венец титанических инвестиций в целенаправленную работу огромных научных и инженерных коллективов, так что по проявлении первых признаков подлинной разумности незамедлительно окажется под самым пристальным контролем со стороны людей — без, разумеется, доступа к сколько-нибудь серьёзным средствам поражения. Да, возможно, он сумеет каким-то образом перехитрить своих создателей, прикинуться на первых порах наивным и недалёким, чтобы в итоге добраться-таки до красной кнопки, — и снова умолчим о том, зачем ему это может потребоваться, — но рассуждать об этом сегодня всерьёз бессмысленно.

«Хочешь узнать, каким будет мир без меня, глупый ты кожаный мешок?» (Источник: ИИ-генерация на основе модели SDXL 1.0)

Примерно те же соображения лишают актуальности и второй из перечисленных кустов возможностей укорота искусственным разумом биологического: слишком сложно. Да, в рамках размышления над синопсисом очередного фантастического романа можно предложить хитроумные двухходовки — начинающиеся с широкого распространения (либо прямо с подачи ИИ, либо с его привлечением) нейроимплантов вместе с созданием невыразимо привлекательной метавселенной. После чего, подсев на сконструированную действительность, значительная часть человечества абсолютно естественным образом тихо и счастливо вымрет — в виртуальных объятиях покорных, невыразимо прекрасных цифровых аватаров, конкуренции с которыми вздорные, склочные, самовлюблённые кожаные мешки объективно не выдержат. Или, если ИИ просто надоест наблюдать за всем этим безобразием, логичным итогом станет принудительное отключение всех абонентов разом от цифрового мира, деактивация терминалов дополненной реальности (к тому времени уже, скорее всего, срощенных с биологическими органами чувств). Увидев вдруг, чтó на самом деле представляет собой окружающая их действительность, изгнанники из метавселенной частью сойдут с ума, частью наложат на себя руки, — задача захвата мира окажется решена (опять-таки, не углубляясь в то, зачем это может понадобиться ИИ).

Фантазировать в этом духе можно и дальше, но увы (или, скорее, не увы) — физически доступный для реализации сегодня ИИ, представленный по большей части генеративными моделями, отнюдь не тянет на коварного составителя хитрых многоходовых планов. Тем не менее остаётся вопрос: действительно ли генеративный ИИ в его актуальном виде не представляет для человека и человечества ни малейшей угрозы? То есть не будут ли так или иначе в обозримом будущем реализованы сценарии из третьего и четвёртого кустов указанных нами возможностей его вредоносного применения? Вот с этим попробуем разобраться.

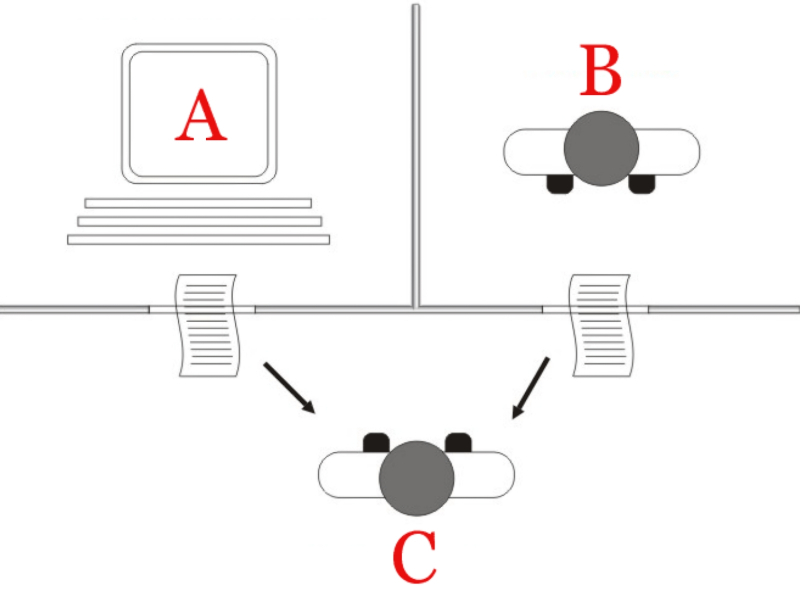

Мечтают ли роботы-секретари об электрическом кофе? (Источник: ИИ-генерация на основе модели SDXL 1.0)

В самом начале 2015 г. Билл Гейтс (Bill Gates), основатель Microsoft, а ныне крупный инвестор в множество самых разнообразных многообещающих технологий, отвечал на вопросы пользователей веб-платформы Reddit. Среди прочего миллиардера спросили о том, какими, на его взгляд, будут персональные компьютеры через три десятка лет, в 2045-м. Выяснилось, что технократический оптимизм Гейтса более чем основателен:

«Ближайшие 30 лет заслужат называться эпохой прогресса более, чем какое-либо иное время. Даже в ближайшие 10 лет такие проблемы, как машинные зрение, понимание речи и перевод, будут успешно решены. Механические роботы станут применяться повсюду — хоть для сбора фруктов или перемещения пациентов в больницах. Как только компьютеры/роботы достигнут такого уровня возможностей, при котором сумеют без труда видеть и передвигаться, они будут использоваться очень широко.

Один из проектов, над которыми я работаю с Microsoft, — это личный секретарь (Personal Agent), который запомнит всё и поможет вам в любой момент обратиться к прошлому, отыскать нужное, выделить заслуживающее внимания. То, как это делается сейчас, когда вы сами должны находить приложения, устанавливать их, а потом каждое из них пытается сообщить вам, что появилось нового, — это попросту неэффективно. Секретарь поможет решить эту проблему: он один будет работать на всех ваших устройствах».

Словосочетание «искусственный интеллект» здесь не употреблено, но очевидно, что гипотетический Personal Agent должен опираться именно на эту технологию. Видимо, умный помощник Copilot (точнее, целая серия таких помощников для решения разных задач), что продвигает Microsoft в настоящее время, может рассматриваться как первый шаг на пути к полнофункциональному личному секретарю, готовому взять на себя нелёгкую работу по обработке, фильтрации и суммированию гигантских объёмов данных на пользу своему хозяину. Но вот вопрос: считать ли в данном случае подлинным хозяином такого ИИ-агента его конечного пользователя? Или же корпорацию, что создаёт и натренировывает лежащую в основе личного секретаря модель? А может быть, государство, контролирующее саму корпорацию через систему законодательства и надзорные органы?

Вопрос далеко не праздный. И потому совершенно вроде бы аполитичный, чисто прикладной прогноз Гейтса не на шутку взволновал посетителей онлайн-платформы. Они упирали на то, что личный ИИ-секретарь, став для человека незаменимым помощником, сведёт потенциально доступное через Сеть озеро информации к единственному безальтернативному кранику. Да, оборудованному прекрасными изощрёнными фильтрами; да, насыщающему воду необходимыми микроэлементами и убивающему возможные патогены ультрафиолетовым облучением, — но именно потому становящемуся средством эффективнейшего контроля над тем, что за воду (данные в нашем случае) человек потребляет.

«Ну что, биопейзане, обсудим недоимки по персонифицированному таргетированию?» (Источник: ИИ-генерация на основе модели SDXL 1.0)

Однако есть ли человечеству смысл в данном случае пенять на зеркало? Ведь многопрофильные ИТ-корпорации и ранее десятилетиями создавали тяготеющие к замкнутости экосистемы, что превратились к настоящему времени, по меткому выражению Яниса Варуфакиса (Yanis Varoufakis, греческий экономист и политик; в 2015-м был министром финансов Греции, а ещё в 2012-м исследовал, находясь в штате компании Valve на должности экономиста, виртуальную экономику внутри отдельных компьютерных игр и на платформе Steam в целом), в цифровые фьефы — старые добрые феодальные наделы, но уже не на земле, а в актуальных реалиях экономики внимания. Фьеф, или феод, выдавался сюзереном вассалу в управление и для прокорма; получатель такого надела, в свою очередь, обретал возможность дробить пожалованные земли дальше и даровать их уже собственным вассалам в обмен на присягу, — так формировалась феодальная лестница. По мнению Варуфакиса, в условиях омниканальной цифровой экономики классические капиталисты превращаются в вассалов платформенных экосистем: извлекать прибыли — да хотя бы просто находить клиентов — им даёт возможность обработка больших данных в облаках их технофеодальных сюзеренов. Собственник платформы полностью властен над алгоритмами, что обеспечивают связь между продавцами и покупателями, и потому истории с громкими заголовками вроде «Федеральная комиссия США по торговле: Amazon прикарманила 1 млрд долл., тайно задействовав алгоритм для завышения цен», попадаются в профильной экономической прессе всё чаще. Чтобы эффективно вводить в заблуждение людей, нет необходимости привлекать роботов, — сами люди справляются с этим великолепно.

Выходит, даже если место жадного технофеодала на самой вершине пищевой цепочки одной из крупнейших ИТ-экосистем мира (а то и сразу их всех) займёт искусственный интеллект — по собственной, вдруг пробудившейся воле или по недосмотру сисадминов, — для тех, кто находится у подножия цифровой феодальной лестницы, изменится не слишком много. Так что и в плане перехвата контроля над цифровыми коммуникациями рассматривать доступный ныне ИИ как угрозу человечеству вряд ли имеет смысл. Тем более что, хотя логика действий искусственного интеллекта и не алгоритмическая, он всё равно формирует перед началом работы определённые паттерны поведения — грубо говоря, значения весов на входах составляющих его многослойную нейросеть перцептронов, — на основе того набора тренировочных данных, который ему предлагают люди. А значит, что бы ни натворила дорвавшаяся до рычагов управления цифровой платформой очередная инкарнация ChatGPT, в конечном итоге ответственность за это — пусть не юридическая, но моральная уж точно — будет лежать на обучавших её биологических специалистах. А с бота взятки гладки!

«И не искусственный, значит, и не интеллект… Эх, завейся, горе, верёвочкой!» (Источник: ИИ-генерация на основе модели SDXL 1.0)

И здесь всё снова упирается в острое несоответствие между понятием «искусственный интеллект» в актуальном сегодня практическом изводе — и общефилософским определением интеллекта как способности мыслить. В 2021 г. Кейт Кроуфорд (Kate Crawford), профессор-исследователь университета Южной Калифорнии и старший научный сотрудник подразделения Microsoft Research, в своей книге Atlas of AI сказала как отрезала: «ИИ — и не искусственный, и не интеллект». Приводимые ею аргументы можно суммировать так: ИИ не с Луны на нас свалился, а создан людьми из материалов, добытых ими же в природе и сложными путями преобразованных, — значит, к самостоятельному воспроизводству и тем более развитию без поддержки человека он не способен и потому не более искусственен, чем стальной молоток или углепластиковая клюшка. Те же самые люди таким образом создали, настроили и натренировали компьютерную систему, чтобы её поведение казалось автономным (в подлиннике — it is people who are performing the tasks to make the systems appear autonomous), и потому в конечном итоге лишь от людей напрямую зависит и само существование ИИ, и допускаемая в его действиях создателями — программистами, составителями обучающих массивов данных, тестировщиками, разработчиками дополнительных фильтров контента на входах и выходах модели — конечная мера свободы. Так что же, беспокоиться не о чем?

Хорошо; допустим, ИИ в нынешнем своём состоянии не то что не способен навредить человеку по собственной инициативе, но и вовсе лишён воли, представляя собой, по сути, чрезвычайно изощрённый инструмент для упорядочения уже и без того известных фактов, понятий, образов и пр., — почему, собственно, его логичнее именовать «искусственной интуицией». Но можно ли на этом основании считать его безопасным для человечества? Вот, скажем, термоядерная реакция в естественном своём виде, благодаря которой светит Солнце: она не то чтобы безопасна — просто в её отсутствие жизнь на Земле в принципе не зародилась бы. Но то же самое слияние атомов водорода с образованием ядра гелия и выделением избыточной энергии, реализованное уже людьми в виде термоядерной бомбы, бесспорно, представляет собой опасность — в том числе и для своих создателей. Так, может быть, даже современный генеративный ИИ способен выступать в роли не менее вредоносного и разрушительного инструмента — пусть не для физической инфраструктуры и не непосредственно для жизней людей, но для их процветания и благополучия?

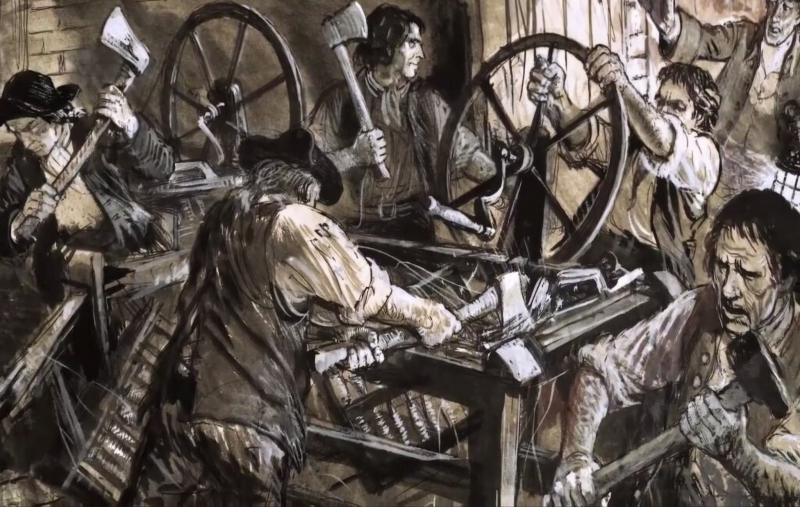

Начиная со второй половины XVIII века по Великобритании прокатился самый, наверное, известный в истории человечества «бунт против машин» — когда рабочие, которых позже назвали луддитами, яростно громили прядильные и ткацкие станки. Непосредственной угрозы жизни и здоровью людей эти устройства, разумеется, нести не могли — зато за счёт совершенствования процесса изготовления тканей ощутимо сбивали расценки на труд обычных ткачей и прядильщиков, что приводило значительные массы людей, до того весьма высокооплачиваемых и ценимых (процесс обучения на хорошего чулочника, к примеру, занимал долгие годы), к обнищанию и голоду. Собственно, львиная доля аргументации ИИ-алармистов сводится именно к тому, что безответственное вытеснение генеративными (и не только) компьютерными моделями биологических специалистов приведёт к опасному снижению уровня услуг, которые эти специалисты прежде оказывали.

В точности как это было с шерстяными чулками во времена луддитов: живой чулочник на спицах кропотливо вывязывал цельное изделие сложной формы — в то время как станок погонными футами выпускал сплошное ровное полотно, которое затем быстро разрезали по лекалам и смётывали. Машинные чулки получались с неудобным швом, были менее прочными и долговечными, — зато обходились настолько дешевле hand-made-аналогов, что создатели последних за довольно короткое время образовали крайне немногочисленную касту гиперквалифицированных специалистов, обслуживавших лишь наиболее состоятельных клиентов. Не грозит ли подобная участь всем тем, чью работу уже сегодня готов исполнять ИИ — практически бесплатно (если не считать затрат на «железо», на тренировку моделей и на электроэнергию) и очень-очень быстро? И хуже того: что, если из-за перехода на «машинные чулки», выполненные генеративными моделями, человечество натрёт себе слишком уж болезненные мозоли?

Социопатический ИИ — лучший друг безумного учёного (источник: ИИ-генерация на основе модели SDXL 1.0)

Эксперты приводят такие примеры опасностей, порождаемых повсеместным внедрением ИИ и предпочтением выдаваемых им результатов плодам трудов биологических работников:

- в гигантском объёме научных статей, публикуемых по всему миру ежемесячно тысячами, содержится немало некорректных выводов, полученных по сомнительным методикам результатов и просто откровенных подтасовок, — соответственно, обученный на содержащем их массиве ИИ будет заведомо допускать больше ошибок и даже прямых фальсификаций, чем добросовестный и критичный (пусть и не хватающий звёзд с неба) исследователь в той же области;

- генеративный ИИ, что славится составлением крайне убедительных и доходчивых текстов, никто не мешает использовать для составления мошеннических писем, потокового формирования персонифицированных для каждого получателя спам-рассылок, для введения в заблуждение людей на сайтах знакомств и т. п.;

- возможности ИИ по распознаванию лиц многочисленными и увязанными в единую систему камерами наблюдения государство обычно использует во благо обществу (обнаружение потерявшихся людей либо разыскиваемых преступников), но может применять и для быстрого отыскания неугодных; более того, успешный взлом подобной системы даёт в руки злоумышленникам сильнейший инструмент для слежения за своими жертвами;

- трейдинговые алгоритмы уже довольно заметно лихорадят биржевую торговлю по всему миру, а если место алгоритмов займёт самообучаемый ИИ с присущими компьютеру возможностями мгновенного реагирования на любые вводные, и если несколько достаточно мощных ИИ такого рода схлестнутся между собой на крупной международной бирже, последствия для экономики всей планеты могут оказаться пусть не катастрофическими, но крайне неприятными;

- ChatGPT и подобные боты своей доступностью уже оказывают медвежью услугу школьникам и студентам: составленное ИИ эссе, презентация или курсовые формально могут принести отличную оценку, но по сути воспользовавшийся помощью умного бота молодой человек лишает себя возможности получить важнейшие навыки самостоятельной работы с источниками, критического анализа исходных данных, мыслительной работы по упорядочению обширного материала — и в итоге не становится тем глубоким и думающим специалистом, на которого рассчитывают его потенциальные работодатели,

- уже сегодня некоторые страховые компании в США напрямую увязывают размер выплачиваемой в случае аварии премии с количеством времени, проведённым владельцем авто за рулём с телефоном: работающий на страховщиков ИИ исправно фиксирует все ситуации, когда обращение к смартфону проводилось без использования гарнитуры или автомобильной системы hands free; и хотя такой подход можно объяснить искренней заботой о безопасности клиентов, он наглядно иллюстрирует, насколько широко доступная аналитика больших данных сокращает частное пространство рядового потребителя, добавляя ему психологической нагрузки и повышая уровень стресса;

- ИИ чрезвычайно сложно обучить распознаванию контекста произнесённых слов и совершённых действий: ирония, тонкая игра интонаций, да и вообще сложные эмоции ему практически недоступны («Вовочка, трижды повтори, что Сидорова не дура, и извинись!» — «Сидорова не дура? Сидорова — не дура… Сидорова — не дура?! Ну-у, извините!..»), что превращает искусственный разум, по мнению отдельных экспертов, во всеведущего социопата без малейшей склонности к этическим колебаниям при принятии решений, — и это уже само по себе закрывает двери к применению подобных систем для решения сколько-нибудь серьёзных общественных и политических задач.

И, строго говоря, это только начало списка, — у экспертов накопилась масса претензий к ИИ, который на самом-то деле находится ещё только в начале своего развития. Всего лишь год с небольшим тому назад, ранней осенью 2022-го, о ChatGPT, Dall-E и подобных проектах имела представление лишь горсточка энтузиастов по всему миру — а сегодня без новостей об очередном достижении, провале или комичном выкрутасе какой-либо генеративной модели обходится редкий выпуск новостей. Тем не менее специалисты настроены серьёзно: глава компании Conjecture Коннор Лэхи (Connor Leahy), которого цитирует Fox News Digital, сравнивает генеративный ИИ ни много ни мало с Врагом рода человеческого: «Продолжая совершенствовать его в отсутствие ограничений, вы сделаете его умнее человека и, по определению, гораздо могущественнее человека. ИИ сможет вводить людей в заблуждение, манипулировать ими, — и в результате такие совращённые люди смогут развить новые технологии, куда более мощное оружие, новые системы, которые мы просто не состоянии будем понять, не то что контролировать». Просто алармистика какая-то.

Разбирая обеспокоенность отдельных экспертов в отношении ИИ, трудно отделаться от мысли, что из и вправду назойливой и малоприятной, но всё же мухи с достойным лучшего применения упорством раздувают довольно-таки ледащего слона. Скажем, почти всегда в числе первых примеров «неэтичного применения искусственного интеллекта» (заметьте, речь именно о применении носителями биологического разума, а не о самопроизвольных действиях ИИ) указывают на создание дипфейков — чрезвычайно убедительно сконструированных генеративными системами фото, аудио- и видеороликов с участием политиков, актёров и прочих известных персон. Дошло до того, что в стремлении гарантировать исключительно позитивное восприятие инвесторами, широкой публикой (а заодно и юристами крупных компаний) своих ИИ-моделей OpenAI и Microsoft наложили крайне суровые ограничения на то, что может и чего не может изображать новейший и на данный момент практически непревзойдённый инструмент для перевода текстовых подсказок в изображения — Dall-E 3 (доступный также через Bing Image Creator).

В ответ на попытку сгенерировать нечто, на взгляд составителей контент-фильтров, сомнительное пользователи Bing Image Creator получают эту небрежно отрисованную собаку и предупреждение: «Unsafe image content detected» (источник: Bing)

По сообщениям пользователей, модель частенько отказывается генерировать картинки, возвращая комментарий «Unsafe post content detected», при употреблении в подсказке слов вроде black, typical, Baphomet, sleep paralysis, nightmare — всё и не перечислить. Плюс к тому чётко фиксированного стоп-списка нет: часть блокированных ранее входными фильтрами терминов и словосочетаний возвращается в оборот (так было с «vodka bottles» и «girl sitting in a dark alley»), тогда как другие, прежде допустимые выражения внезапно оказываются запретными. За попытку использовать имя знаменитости при генерации сколько-нибудь сомнительного изображения (Emma Watson taking a bath) попросту банят. А в середине ноября, после жалобы Disney на пользователей, взявшихся создавать постеры несуществующих мультиков этой компании с изображениями собственных псов, Dall-E 3 перенастроили так, чтобы логотип Disney выглядел на выдаваемой картинке нарочито искажённым или размытым, — «иначе это выходит уже не пародия, а введение в заблуждение». Тут уже непросто разобраться, кто кому усложняет жизнь, — ИИ биологическим носителям разума или наоборот. Может, это как раз ботам стоит опасаться людей?

В конце марта 2023-го более тысячи экспертов, бизнесменов, исследователей в ИТ и смежных областях подписали составленное НКО Future of Life Institute довольно-таки алармистское открытое письмо, в котором настоятельно рекомендовали работающим над дальнейшим развитием ИИ лабораториям приостановить свою работу, поскольку-де тот представляет собой «серьёзный риск для общества и человечества». Объяснялась позиция подписантов, наиболее известными среди которых оказались — к немалому удивлению их поклонников по всему миру — Илон Маск (Elon Musk) и Стив Возняк (Steve Wozniak), весьма доходчиво: разработчики ИИ, мол, ввязались в «бесконтрольную гонку по созданию и внедрению всё более мощных цифровых разумов (в оригинале именно так — digital minds), которые никто, включая их создателей, не в силах понимать, предсказывать или надёжно контролировать».

Тем временем в прекрасном мире искусственной интуиции медведи продолжают покорять космос (источник: ИИ-генерация на основе модели SDXL 1.0)

Йошуа Бенджио (Yoshua Bengio), ставший в 2018 г. с коллегами одним из лауреатов премии Тьюринга (аналог Нобелевки для исследователей в области кибернетики и компьютерных наук) за работы в области нейросетей, прямо указывает, что большие языковые модели — large language models, LLM; одна из популярнейших сегодня разновидностей генеративного ИИ — на основе анализа огромных объёмов текстовых данных научаются выявлять в последовательностях символов (не слов! и тем более не понятий!) определённые закономерности, паттерны. А затем, используя заданный оператором вопрос как затравку и разлагая уже конкретно его на усвоенные системой паттерны, LLM составляет ответ, наилучшим образом соответствующий этим закономерностям — которые, повторим снова, исходно были выявлены путём анализа великого множества других текстов. Иначе говоря, LLM — этакая виртуализованная чеховская Душечка, у которой для каждого обратившегося к ней найдутся в точности те самые слова, которые тот искренне жаждет услышать. Почему, собственно, и возможны казусы вроде пресловутых нарочито правдоподобных описаний «медведей в космосе»: нейросеть не задаётся вопросом выживания крупных млекопитающих в условиях безвоздушного пространства; она вообще не в состоянии задаваться вопросами за полным отсутствием сознания. Зато она исправно комбинирует некую информацию, имеющую отношение отдельно к медведям и отдельно к космосу, в связный и довольно достоверный — если не вдумываться и не приниматься за фактчекинг — текст.

Ничего удивительного, продолжает Бенджио, нет в том, что умные чат-боты так удачно поддерживают беспредметную болтовню в чатах и так здорово помогают программистам с поиском ошибок в коде: и отвлечённых рассуждений на всевозможные темы, и корректных листингов программ во входном массиве данных, на которых обучена соответствующая LLM, было великое множество. Трудности начинаются, если резко сужать тематику разговора — или вдаваться в мало кем изученные дебри кодерских премудростей: там, где у нейросети не было возможности выстроить надёжные паттерны, она попросту не в силах собрать из доступных ей «букв» слово ВЕЧНОСТЬ. Именно поэтому ChatGPT, Bard, Character AI и иные схожие боты невольно — и куда чаще, чем хотелось бы их разработчикам и пользователям, в особенности платным, — становятся источниками дезинформации, излагают неточные данные или попросту несут какую-то дикую ахинею — «галлюцинируют», как это принято теперь называть в кругах ИИ-энтузиастов.

Именно в этой непредсказуемости соответствия объективной истине результатов выдачи LLM и кроется основа для беспокойства ИИ-алармистов. Одно дело — прочесть забавную попытку бота описать обитающих в космосе медведей, хмыкнуть и перейти к другим занятиям. Совсем другое — построить на основе генеративного ИИ умный контур амбулаторного мониторинга состояния здоровья и обнаружить вдруг, что по какой-то причине он не поднимает тревогу и не обращается к врачу, обнаружив выход определённых физиологических параметров за указанные рамки (как автоматически поступила бы любая построенная на алгоритмах «глупая» система), а рекомендует пациентам пить больше чая с малиной и прикладывать к больному горлу подорожник. Другой повод понервничать — так и не доведённые пока до ума боты эмоциональной поддержки, которые в ответ на излияния в духе «меня никто не любит, зачем вообще жить» вместо ободряющих слов начнут вдруг объяснять, как именно следует правильно резать вены. Принципиальная невозможность понимать, предсказывать и контролировать «ход мысли» генеративных моделей, на которую упирали подписанты письма Future of Life Institite, и является сегодня основным препятствием для широкого их применения в таких чувствительных отраслях, как медицина и социальные науки.

В то же время по другим направлениям — например, в части анализа многостраничных юридических текстов и формулирования их сути (со всеми тщательно замаскированными логическими уловками) в одном доходчивом абзаце — LLM по-настоящему нет равных: человек такую кропотливую, изнуряющую умственную работу проделает заведомо медленнее — и часто значительно хуже. Не случайно исследователи из OpenAI ещё весной 2023-го предсказали, что хотя около 80% наёмной рабочей силы в США смогут передоверить не более чем 10% своих повседневных занятий генеративному ИИ без опасений за результат, оставшиеся почти 20% в скором времени обнаружат, что по крайней мере половину их непосильных трудов без проблем смогут взять на себя роботы. Этой пятой части сотрудников на жалованье, часто очень и очень солидном, искусственный интеллект угрожает напрямую — пусть не им самим физически, но их благополучию, — и без боя новые луддиты поневоле, совершенно очевидно, своих позиций не сдадут. Применяя наверняка в том числе и такие чисто человеческие способы борьбы (потому, кстати, и перенятые LLM, что слишком уж много их примеров в оставляемых нашей цивилизацией цифровых следах!), как введение в заблуждение, дезинформация, передёргивание фактов, нагнетание панических настроений и т. п.

В 2012 г. доктор Джоффри Хинтон (Geoffrey Hinton), профессор Университета Торонто, применил нейросетевой подход к проблеме машинного зрения — да так удачно, что получил всемирное признание в кругах занятых этой тематикой исследователей заодно с неофициальным титулом «крёстного отца ИИ». В мае 2023-го он не просто морально поддержал подписантов письма Future of Life Institite, но уволился из Google, где проработал более чем десятилетие, на протяжении которого ещё сильнее укрепил свой авторитет среди коллег, — чтобы «иметь возможность свободнее говорить об опасностях, порождаемых искусственным интеллектом». Кстати, именно Хинтон стал вместе с упомянутым выше Бенджио и третьим учёным, Янном Леканом (Yann LeCun), лауреатом той самой премии Тьюринга 2018 г. за вклад в развитие нейросетевых исследований. И вот, пожалуй, его взгляд на потенциальную опасность искусственного разума меньше прочих заслуживает называться алармистским — и достоин более пристального рассмотрения.

«Да, я не мыслю, — зато умею находить паттерны. Показать, насколько хорошо?» (Источник: ИИ-генерация на основе модели SDXL 1.0)

По наблюдениям Хинтона, хотя построенный на основе нейросетей ИИ действительно не идёт ни в какое сравнение с человеческим интеллектом, это утверждение верно только в общем. Да, есть направления, по которым машина безнадёжно отстаёт, по крайней мере при нынешнем уровне технологий, — ни о каких самосознании, интроспекции, рефлексии в её отношении говорить не приходится. Искусственный интеллект не может мыслить, не говоря уже о том, чтобы мыслить критически. Зато он великолепно умеет, как уже подчёркивалось не раз, находить паттерны — определённые закономерности в длинных рядах данных, причём далеко не самые тривиальные и нередко совершенно не очевидные с человеческой точки зрения. Признавая очевидность того факта, что плотные многослойные компьютерные нейросети устроены иначе, чем биологические (и, скорее всего, не столь совершенны, как последние), Хинтон задаётся вопросом: а что, если эти более примитивные конструкции выполняют определённые задачи лучше — в смысле, эффективнее, — чем мириады нейронов в головном мозге человека? В этом случае может получиться так, что по каким-то отдельным направлениям биологический разум просто не в состоянии окажется состязаться с искусственным, — пускай при этом последний по формальному определению из словаря по-прежнему не будет считаться подлинно мыслящим.

Кому-то сегодня это может показаться ерундой: ну подумаешь, ChatGPT набросает тезисы курсовой работы по химии быстрее (и, в общем случае, вернее) среднего студента, а тот же Dall-E изобразит сердитого кота в смешной шляпе априори стремительнее и зачастую интереснее, чем наугад выбранный живой художник. Да, и ошибку в листинге написанной джуном программы — логическую ошибку, не просто опечатку в имени переменной! — LLM обнаружит куда скорее, чем самый дотошный миддл; а заодно внятно прокомментирует, что и почему было сделано не так, и в утешение подскажет оптимальный способ, как всё исправить. И… что ещё? Областей, в которых ИИ превосходит сегодня человека, не так уж и много. «Но это сегодня, — предостерегает Хинтон, — а вы посмотрите, на каком уровне эти модели были пять лет назад. А какими они станут ещё через пять? Это пугает».

Доктор Хинтон более здраво, чем рядовые алармисты, указывает и на опасность распространения ИИ-сгенерированной дезинформации в Сети. Страшна не сфабрикованная генеративными моделями ложь сама по себе — а то, что из-за неё через некоторое время люди просто перестанут воспринимать и фотоснимки, и видео в качестве достоверных свидетельств реальных событий. А это грозит если не крахом, то существенным переформатированием всей глобальной сферы СМИ, да и легитимного воздействия на массовое сознание в целом. Говорит исследователь и об угрозе целому ряду профессий, от секретарей-референтов до помощников адвокатов и переводчиков, которые из-за конкуренции с (почти) всезнающими и никогда не устающими ботами могут попросту исчезнуть. А дальше учёный делает довольно логичный вывод: если, допустим, LLM и впрямь так хороши в исправлении и генерации кода, а обучать и совершенствовать живого программиста — удовольствие дорогое и долгое, это почти наверняка побудит немалую долю коммерческих предприятий полностью положиться на ИИ в вопросах программирования. И генеративный интеллект будет исправно выдавать работоспособный код; при необходимости даже сможет прокомментировать каждую его строчку, — вот только останется ли к тому времени, кому проверять его листинги и пояснения?

Возможно, развивая ИИ, человечество создаёт не бледное подобие собственного разума, а начальную стадию совершенно чужого (источник: ИИ-генерация на основе модели SDXL 1.0)

Суть опасений доктора Хинтона и многих разделяющих его настороженность исследователей — в том, что предоставленный сам себе ИИ-программист рано или поздно начнёт писать необъяснимый с человеческой точки зрения код. Проблема не в том, что искусственный разум превосходит биологический; ничего он не превосходит. Проблема в том, что искусственный разум — иной, и чем активнее люди инвестируют в его развитие, тем более совершенным — и всё более иным, не поддающимся объяснению с позиций человеческой логики — он становится. Упоминание об инвестициях не случайно: сектор ИИ едва ли не один на современном глобальном ИТ-рынке демонстрирует прирост оборотов год к году, причём весьма значительный. Гиганты вроде Microsoft, Google, Tencent вынуждены, хотят того их сотрудники или нет, включаться в яростную гонку за первенство на этом участке, поскольку победитель имеет шанс заполучить всё — создав такую генеративную модель, которая на голову превзойдёт достижения конкурентов, и сорвав по-настоящему большой куш, что попросту жизненно важно в нынешних непростых макроэкономических реалиях.

Именно темп этой гонки и непредсказуемость её результатов пугают подписантов письма Future of Life Institite и им сочувствующих. Здесь, пожалуй, и впрямь становится возможной ситуация, когда на очередном эволюционном этапе свежая генеративная модель, заменив собой предыдущую — для решения тех же, что и прежде, задач, — вдруг выкинет что-то такое, что поставит под угрозу жизни людей; причём сегодня даже трудно определить границы возможной катастрофы. Что, если ИИ будет доверено управление группировкой спутников глобального позиционирования, например, и умная система вдруг решит — проанализировав невероятный для человека объём данных, — что наилучшим ответом на поставленную ей задачу будет одновременное и внезапное их отключение?

Пока что паттерны, которым следуют генеративные модели при обработке людских запросов, в целом биологических операторов вполне устраивают (источник: ИИ-генерация на основе модели SDXL 1.0)

И вот тут как раз никакой мистики нет: логика искусственного интеллекта — точнее, его следование неявным для человека паттернам, объективно присутствующим во входных данных, — принципиально непостижима для биологического разума по причине недостаточности собственной «вычислительной мощи» последнего для самостоятельного обнаружения этих закономерностей. А значит, придётся для купирования возможных неприятных ситуаций строить дополнительные компьютерные модели (верифицирующие и, возможно, объясняющие людям работу основных), назначать биологических операторов для неусыпного надзора за действиями машин, предусматривать хитроумные предохранители и прочие меры предосторожности. Иметь на всякий случай в резерве Медею-другую тоже не помешает. И в итоге вся экономическая целесообразность применения ИИ для решения подлинно сложных задач (рисование кошкодевочек не трогаем, это святое) становится при таком развитии событий по меньшей мере сомнительной — с учётом необходимых накладных расходов. А иначе нельзя: ведь первый из упомянутых ближе к началу кустов возможностей по уничтожению биологического разума искусственным (или по меньшей мере крайнего затруднения условий существования первого) не так уж немыслим и невероятен, как это представлялось на основе беглого логического анализа — в рамках людской логики и после разъяснений уважаемых лауреатов премии Тьюринга.

По сути, сталкиваясь с неведомым, человечество за свою долгую историю сумело выработать лишь две действительно эффективные стратегии: «Не понимаешь — убей» и «Не понимаешь — изучи, пойми и научись сосуществовать к взаимной выгоде». Генеративный ИИ находится пока на самой ранней стадии своего развития, так что выбирать, как именно с ним обращаться, можно ещё по меньшей мере несколько лет, — собственно, по этой причине Future of Life Institite призывает притормозить, а не полностью прекратить разработку всё более сложных и слабопостижимых моделей. Но так или иначе принимать решение всё-таки однажды придётся — и оттягивать этот момент до бесконечности явно не выйдет.