Google создала ИИ для проверки фактов в ответах других ИИ

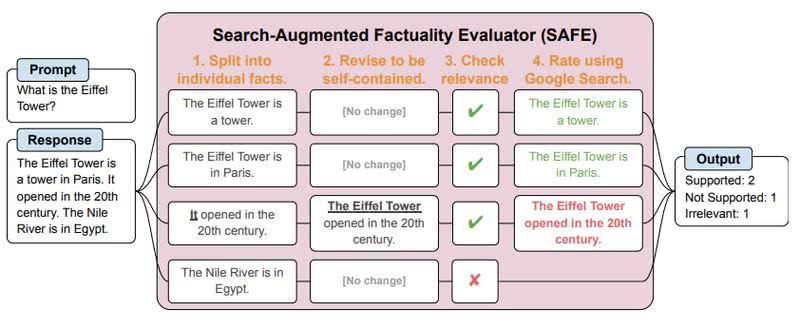

Компания Google разработала ИИ-систему «оценки фактов на основе поисковой выдачи» (Search-Augmented Factuality Evaluator, SAFE), задача которой находить ошибки в ответах сервисов на базе больших языковых моделей (LLM) вроде ChatGPT.

Источник изображения: pixabay.com

LLM используются в разных целях, вплоть до написания научных работ, однако они нередко ошибаются, приводя недостоверные сведения, и даже настаивая на их истинности («галлюцинируя»). Новая разработка команды Google DeepMind вычленяет из вывода нейросети отдельные факты, формирует запрос к поисковой системе и пытается найти подтверждения изложенных сведений.

Источник изображения: Google DeepMind

Во время тестирования SAFE проверила 16 тысяч ответов нескольких сервисов на базе больших языковых моделей, среди которых Gemini, ChatGPT, Claude и PaLM-2, после чего исследователи сравнили результаты с выводами людей, занимавшихся этим вручную. Выводы SAFE на 72 % совпали с мнениями людей, причём при анализе расхождений в 76 % истина оказывалась на стороне ИИ.

Код SAFE опубликован на GitHub и доступен всем желающим проверить надёжность ответов LLM.