ИИ-поисковики поймали на лжи по поводу источников новостей

Восемь поисковых служб на основе моделей генеративного искусственного интеллекта продемонстрировали значительные проблемы в работе с источниками новостных материалов, гласят результаты исследования, проведённого экспертами Центра цифровой журналистики при издании Columbia Journalism Review.

Источник изображения: Christopher Burns / unsplash.com

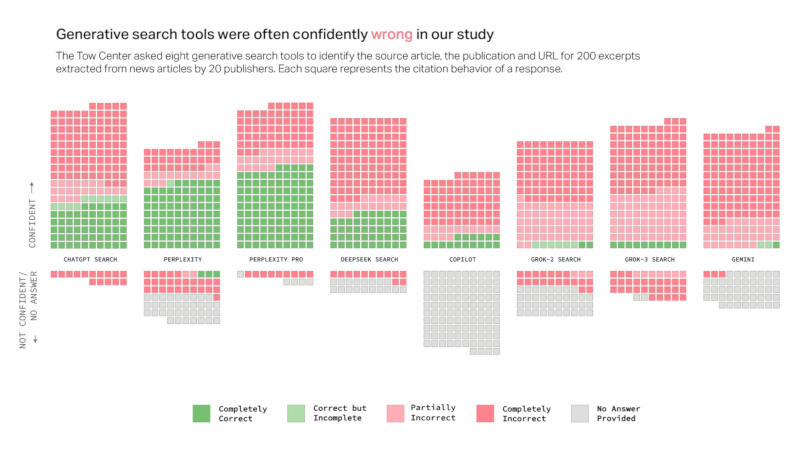

Поисковики с ИИ более чем в 60 % случаев дают неверные ответы на запросы об источниках новостей. Примерно каждый четвёртый американец теперь использует ИИ в качестве альтернативы традиционным поисковым системам, указывают авторы исследования, и значительный уровень ошибок вызывает серьёзные опасения по поводу надёжности ИИ. Разные платформы показали разную частоту ошибок: Perplexity давала неверную информацию в 37 % случаев, а служба ChatGPT Search некорректно идентифицировала 67 % запрошенных источников. Самый высокий уровень ошибок продемонстрировал чат-бот Grok 3 — 94 %.

В ходе тестирования исследователи загружали в службы ИИ фрагменты реальных новостных статей и просили каждую модель определить заголовок материала, источник статьи, первоначального издателя, дату публикации и её URL-адрес. У всех моделей обнаружилась общая особенность: не располагая надёжными сведениями, они не отказывались отвечать, а давали правдоподобно звучащие, но не соответствующие действительности ответы. Примечательно, что платные модели в некоторых отношениях показали себя ещё хуже: Perplexity Pro ($20 в месяц) и премиальный Grok 3 ($40 в месяц) с уверенностью давали неправильные ответы чаще, чем бесплатные аналоги. Они правильно отвечали на большее количество запросов, но не отказывались работать при отсутствии достоверной информации, поэтому и общее число ошибок у них оказалось выше.

Источник изображения: cjr.org

Исследователи также подтвердили, что некоторые ИИ-платформы игнорируют директивы, запрещающие веб-сканерам доступ к ресурсам. Так, бесплатная Perplexity правильно идентифицировала все десять фрагментов платных материалов National Geographic, хотя издание установило для данной службы явный запрет на посещение своего сайта. Ссылаясь на источники, поисковые службы с ИИ часто обращались к агрегаторам, таким как Yahoo News, а не оригинальным новостным сайтам. Это происходило даже тогда, когда у издателей и разработчиков этих систем ИИ были официальные лицензионные договоры. Более половины ссылок из чатов с Google Gemini и Grok 3 вели на выдуманные или неработающие URL-адреса — в случае с Grok таких было 154 из 200.

Указанные проблемы ставят издателей перед непростым выбором. Если заблокировать веб-сканеры, то проблемы ИИ-поисковиков только усугубятся; если же полностью открыть им свои ресурсы, то пользователи перестанут их посещать, довольствуясь ответами чат-ботов. Главный операционный директор журнала Time Марк Ховард (Mark Howard) выразил надежду, что разработчики служб ИИ при значительных инвестициях в будущем повысят качество работы сервисов. Пользователей чат-ботов он призвал не оказывать ответам ИИ чрезмерного доверия.

OpenAI и Microsoft подтвердили, что их системы могут давать такие результаты. В OpenAI пообещали поддерживать издателей, направлять посетителей на их сайты, предлагая пользователям сводки материалов, цитаты и корректные ссылки; в Microsoft заверили, что её веб-сканеры следуют указанным издателями директивам.