GIGABYTE 3D1-68GT. "Вдвое - лучше!"

Стр.1 - Предисловие. Комплектация.

Предисловие

О видеокартах компании Gigabyte, носящими необычное имя - 3D1, мы впервые услышали в декабре прошлого года. Видеокарта 3D1-68GT продолжает славную традицию двухчиповых решений. Но прежде чем перейти к знакомству непосредственно с 3D1-68GT, ненадолго окунемся в историю.

Идея запрячь в одну упряжку два графических процессора, сама по себе не нова. Более или менее успешные попытки предпринимались уже давно. Почившая в бозе амбициозная 3dfx выпускала видеокарты с двумя, и даже 4-мя видеопроцессорами на борту. Разработка ATI по имени Rage Fury MAXX тоже несла на одной плате два видеопроцессора. Что мы видим сейчас? Как вы знаете, NVIDIA, купив 3dfx со всеми ее наработками, несколько переработала идею объединения производительности двух видеопроцессоров и предложила устанавливать в одну систему две отдельные видеокарты, работающие в связке. Подобный подход получил признание и со стороны ее главного конкурента. Разумеется, я имею ввиду ATI и технологию CrossFire.

Как справедливо заметил кто-то из классиков, история развивается по спирали. Создавая первую 3D1, инженеры Gigabyte взяли идею, в общем-то лежащую на поверхности, и объединили два видеочипа 6600GT на одной PCB. В итоге получилась видеокарта, по производительности превосходившая в определенных приложениях лидеров того времени.

"Первый блин", вопреки пословице, получился вполне удачным. Впечатление не портили даже некоторые ограничения, присущие собственно чипу 6600GT. Ну и пусть, что 128-битная шина памяти не давала развернуться в полную силу в "тяжелых" режимах, с включенными сглаживанием (антиалиасингом) и анизотропной фильтрацией. Важно не это. Выпустив видеокарту 3D1, компания Gigabyte не только проложила дорогу к новым решениям на базе стандартных видеопроцессоров, но и открыла новые горизонты для фантазий - объединение в одной системе уже двух двухчиповых видеокарт, соответственно - 4 графических видеопроцессора.

Выбор 6600GT в качестве основы для первой 3D1 был, в общем-то, обоснован. Создание PCB для размещения на ней двух видеопроцессоров, интерфейса связи между ними, собственной видеопамяти для каждого из GPU, усложненной системы питания - потребовало немалых усилий.

GIGABYTE 3D1-68GT

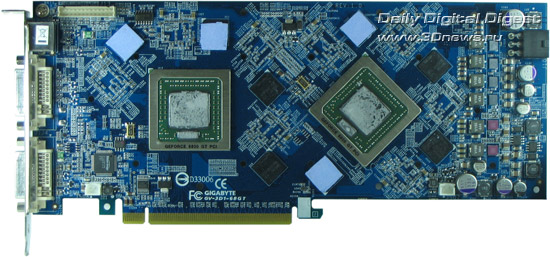

Остается только догадываться, с какими трудностями столкнулись инженеры Gigabyte при создании 3D1-68GT. Тем не менее, они не дали себе поблажки - объединили на одной PCB две полноценные GeForce 6800GT, разместили аж 512 Мб видеопамяти, по 256 МБ каждому видеочипу да по отдельной шине в 256 бит. Усилили систему питания, навесили мощную систему охлаждения и повысили частоты по сравнению со стандартными.

Посмотрим, наконец, что же из этого всего получилось.

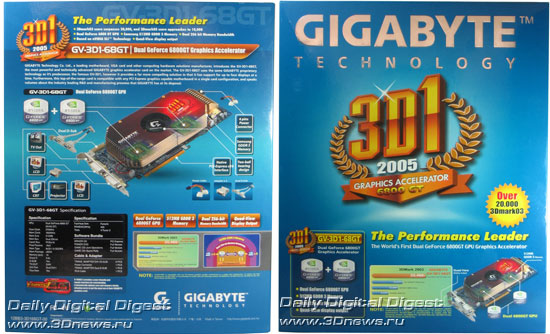

Для удобства просмотра, на одной фотографии приведены виды коробки как спереди, так и сзади. Коробка оформлена в нежных сине-голубых тонах. На лицевой стороне упаковки (фото справа), вместо уже привычных сказочных героев или инопланетных монстров - обрамленная венком и ленточкой надпись "3D1". Такой скромный намек на превосходство. Понятно, что по замыслу оформителей - венок не за второе место. : Надпись "2005", присутствующая на ленточке, позволяет предположить, что в следующем году мы увидим очередное решение из серии 3D1. Внизу указаны главные "фичи" видеокарты 3D1-68GT, результаты бенчмарков (конечно же 3DMark), и фото самой видеокарты.

На обороте центральную часть занимает фото 3D1-68GT с подробным описанием всех особенностей и возможностей видеокарты. Здесь же указаны подробные спецификации (о которых несколько позже).

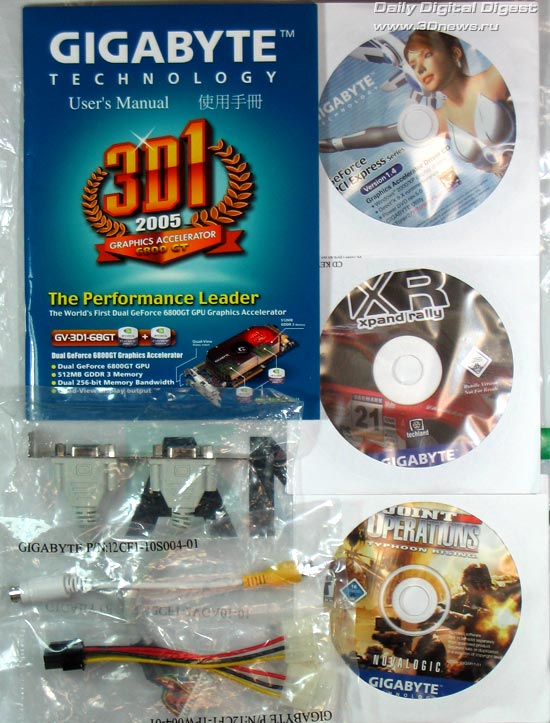

- Руководство пользователя

- Диск, включающий - драйверы видеокарты, DirectX, PowerDVD 5.0 и фирменную утилиту для разгона видеокарт под названием V-Tuner2.

- Диски с играми XpandRally и Joint Operations

- Специальная планка для подключения двух дополнительных разъемов D-SUB

- Два переходника DVI/D-SUB

- Переходник дополнительного питания

- Переходник для ТВ-выхода S-Video/Composite

А вот игр могло бы быть побольше, да и сами игры посовременнее. Все-таки видеокарта претендует на топовый уровень производительности, и стоить будет немало денег. С другой стороны, для России этот вопрос, по вполне очевидным причинам, не является критичным.

…и, разумеется, сама видеокарта

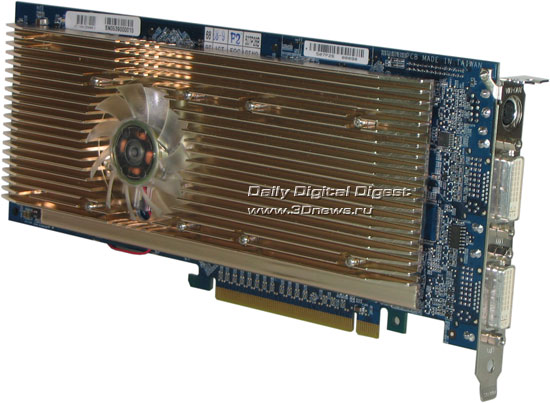

Фотография в данном ракурсе, к сожалению, не может передать объем. И уж никакая фотография не в состоянии передать вес предмета. А 3D1-68GT, поверьте, весьма и весьма объемна и обладает значительным весом. В первую очередь - из-за массивной системы охлаждения, которая закрывает поверхность PCB с обеих сторон практически полностью.

Стр.2 - Система охлаждения. Дизайн видеокарты.

Система охлаждения.

Вид спереди, другой ракурс. Оцените высоту радиатора. Она настолько большая, что внутри радиатора спокойно помещается довольно толстый кулер. Как вы понимаете, соседний PCI слот будет надежно перекрыт. Устанавливать что-либо во второй PCI слот не рекомендуется. Можно ненароком перекрыть поток воздуха к кулеру. Крышка радиатора с фирменной эмблемой нужна не только для красоты. Она служит для направления потока воздуха вдоль ребер радиатора, идущих параллельно длинной стороне видеокарты по всей длине.

Вид спереди со снятой крышкой. На этой фотографии видно, что на самом деле радиатор, установленный на лицевой стороне видеокарты, состоит из двух частей. Как вы думаете, почему? Ответ очевиден - для того чтобы обеспечить качественный прижим радиатора к каждому из графических процессоров. При использовании сплошного радиатора это было бы очень затруднительно выполнить. Поскольку между GPU и радиатором находится только тонкий слой термоинтерфейса, потребовалось бы либо очень точное выравнивание видеопроцессоров по высоте и плоскости, либо замена термопасты на так называемую "терможвачку", что могло заметно ухудшить режим охлаждения и без того горячих видеочипов.

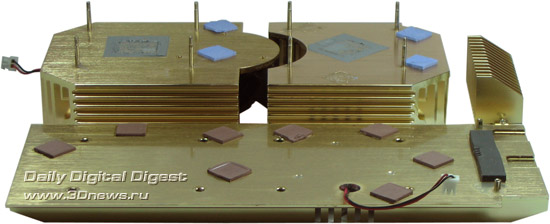

Вид сзади. Как видите, и на обратной стороне видеокарты установлен кулер. Виной тому - увеличенный объем видеопамяти. Размерам радиатора (только для видеопамяти!) может позавидовать любая видеокарта среднего ценового диапазона. Такое решение выглядит несколько избыточным, но является вполне логичным с точки зрения общей концепции оформления системы охлаждения.

Радиатор, закрывающий силовые элементы системы питания в этом ракурсе практически сливается с главным радиатором. Концепция коснулась и его.

Вот так выглядят радиаторы в снятом состоянии с обратной стороны. Все поверхности отполированы практически до зеркального блеска и оставляют самое приятное впечатление. Хотя для чипов памяти это большого значения не имеет, поскольку в качестве термоинтерфейса использованы терморезинки. Как видно по данной фотографии, радиаторы крепятся не к PCB, а друг к другу, образуя своеобразный бутерброд, внутри которого находится видеокарта.

Посмотрим, что же скрывается под всем этим массивным великолепием.

Обратите внимание, насколько плотно размещены элементы. Те места, которые на первый взгляд кажутся пустыми, на самом деле - хитросплетения дорожек, ведущие к чипам памяти. Как видно, второй видеопроцессор повернут относительно первого на 45 градусов. Можно было бы ожидать, что общий рисунок расположения микросхем видеопамяти относительно GPU будет сохранен и аналогичным образом повернут, тем не менее, это не так. Простой поворот потребовал бы увеличить размеры PCB. Инженеры Gigabyte не стали искать легких путей, а проявили чудеса изворотливости.

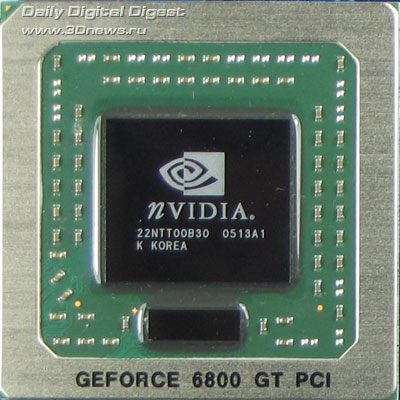

Так выглядит один из двух графических процессоров, установленных на плате. Выпущен на 13-й неделе 2005 года. Пусть номер недели выпуска вас не смущает. Забегая вперед, скажу, что в тестах оба процессора показали себя более чем достойно.

Установленная память - производства Samsung, с временем выборки 1,6 нс и, соответственно, максимальной рабочей частотой 1200 МГц DDR. В то время как штатная частота видеопамяти для 3D1-68GT составляет 1000 МГц. Такой запас по частоте видеопамяти позволяет надеяться на существенное увеличение производительности видеоподсистемы.

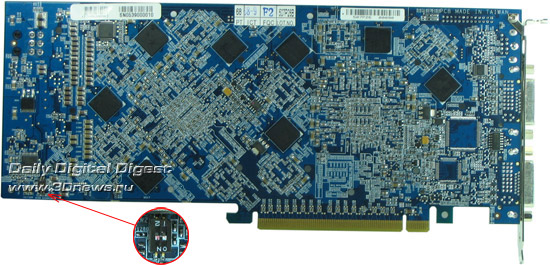

На оборотной стороне видеокарты картина полностью аналогичная - огромное количество мелких элементов, плотный монтаж, вторые 8 чипов памяти.

На этом, пожалуй, закончим пристальное разглядывание видеокарты и перейдем к тестам.

Стр.3 - Разгон. Тестирование.

Спецификации

Для справки, приведем спецификации видеокарты 3D1-68GT:

- Два видеопроцессора GeForce 6800GT, частота работы 375 МГц

- Общий объем установленной видеопамяти - 512 Мб, 16 чипов в упаковке BGA, по 8 на каждой стороне видеокарты

- Шины памяти - две, каждая шириной 256 бит (каждый GPU использует свои 256 Мб памяти)

- Тип памяти - DDR3, с временем выборки 1,6 нс, рабочая частота 1000 МГц

- Интерфейс - PCI-E 16x

Как видите, частоты GPU несколько завышены по сравнению со стандартными 350 МГц для 6800GT. Что именно явилось первопричиной такого завышения частоты, сказать сложно. Может быть, сконструированная система охлаждения настолько хорошо справлялась со своими обязанностями, что было решено поднять рабочую частоту GPU. А может быть и наоборот, повышение частоты привело к необходимости разрабатывать столь массивную систему охлаждения. Мне кажется, наиболее вероятной причиной могло быть желание производителя получить результат, уверенно превышающий красивый порог в 20000 "попугаев" 3DMark03. Почему именно в 3DMark03, спросите вы, хотя на дворе 2005-й год, да и тот уже заканчивается? Ответ на этот вопрос мы получим, когда перейдем к тестам. С другой стороны, как известно, многие видеокарты на базе 6800GT спокойно разгоняются до частот соответствующих 6800Ultra. Однако "штатный разгон" несколько скромнее. Естественными ограничителями здесь выступают уже не столько разгонный потенциал GPU, сколько возросшее совокупное энергопотребление и тепловыделение тандема видеочипов.

Частота памяти полностью соответствует штатной для 6800GT, несмотря на то, что установленная память позволяет работать на большей частоте. В общем-то, разумно. Дальнейшее повышение частоты памяти не так радикально сказывается на производительности, а вышеупомянутые ограничения по энергопотреблению и тепловыделению играют свою роль и здесь.

Однако, несмотря на всю продуманность конструкции и выбранных режимов работы, без ложки дегтя все же не обошлось. Как оказалось, видеокарта всегда работает на одних и тех же частотах, что в режиме 3D, что в режиме 2D. Как вы понимаете, такое поведение не может положительно сказаться на тепловом режиме видеокарты и всей системы в целом.

Вторая ложка дегтя заключается в том, что на 3D1-68GT не реализован мониторинг температур. Ни RivaTuner, ни фирменная утилита V-Tuner2 не обнаружили никаких датчиков температуры, поэтому просто ничего не показали. Управление скоростью вращения кулеров видеокарты также не обнаружилось, что выглядит уже логично - ведь видеокарта греется всегда и по максимуму.

Сложно сказать, что послужило причиной указанных недоработок. Возможно, это связано с тем, что инженерам Gigabyte пришлось написать для 3D1-68GT собственный биос и возникли какие-то проблемы. Может быть это издержки двухчиповости и нестандартного дизайна. А может просто не хватило времени. На стабильности работы видеокарты это, в общем-то, не сказывается. А позаботиться о хорошей системе вентиляции корпуса и мощном надежном блоке питания придется в любом случае.

Разгон

Прежде чем разгонять видеокарту "ручками", я опять решил проверить работу автоматики, и "попросил" систему определить оптимальные частоты. Результат превзошел ожидания. Драйверы согласились, что 375 МГц для GPU хорошо, но мало, и выставили 394 МГц, а память решили сильно особо не трогать и дали ей всего 1030 Мгц. Неплохо. Памятуя о разгонном потенциале 6800GT до уровня 6800 Ultra и запасе по частоте памяти, я, естественно, на этом не остановился и решил еще немножко подразогнать 3D1-68GT. В итоге видеокарта показала стабильную работу на частотах 425/1200 Мгц. Как видите, частоты соответствуют штатным частотам 6800 Ultra и даже чуть их превышают (по памяти).

Тестирование

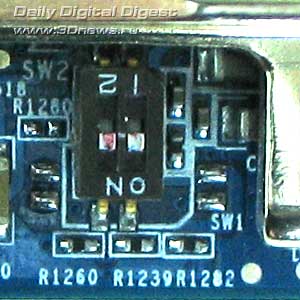

Предварительные замечания (для тех, кто не любит читать мануалы). Если установить 3D1-68GT в материнскую плату, которая SLI не поддерживает, видеокарта будет работать как одиночная 6800GT, но, согласитесь, какой тогда смысл в наличии двух GPU? Поэтому, для работы видеокарты 3D1-68GT в режиме максимальной производительности материнская плата, поддерживающая SLI - необходима! Однако здесь есть некоторые тонкости. Несмотря на то, что поддержка SLI необходима, переключатель на материнской плате, изменяющий режим работы Normal/SLI, необходимо выставить в Normal. А на видеокарте необходимо поставить переключатель SW1 в положение "ON" (белые точки - вниз), как показано на рисунке.

Сам переключатель расположен на тыльной стороне видеокарты.

Внимание! Для переключения SW1 в другое положение радиатор с видеокарты снимать не надо! Радиатор его не закрывает.

Конфигурация тестового стенда:

|

Стенд

|

PCI-E

|

|

CPU

|

|

|

MB

|

|

|

Memory

|

|

|

OS

|

WinXP + SP2 + DirectX 9.0c

|

|

PSU

|

Для тестирования использовались последние WHQL-драйверы NVIDIA - ForceWare 78.01 WHQL.

Видеокарта 3D1-68GT тестировалась в двух режимах. Первый - номинальные частоты 375/1000 МГц. Второй - разогнанный вариант, частоты 425/1200 МГц (GPU/память соответственно). Результаты сравнивались GeForce 7800GT, 7800GTX, и, поскольку 3D1-68GT по сути есть две 6800GT в SLI режиме, нам было интересно сравнить ее с топовым SLI-решением сегодняшнего дня - 7800GTX-SLI.

Итак, результаты:

Как и следовало ожидать, на номинальных частотах 3D1-68GT уверенно обходит 7800GT/GTX и приближается к результату 10 000 "попугаев". При разгоне планка в 10 000 "попугаев" взята! Разогнанная 3D1-68GT даже обходит 6800 Ultra-SLI, по всей видимости, за счет чуть большей частоты видеопамяти. 7800GTX-SLI, разумеется, остается недосягаемой.

Расстановка сил сохраняется. Обратите внимание - 3D1-68GT показывает 20 327 "попугаев" 3DMark'03 в номинальном режиме. Теперь понятно, почему на коробке приведены результаты именно в 3DMark'03? На номинальных частотах до рубежа 10 000 в 3DMark'05 видеокарта 3D1-68GT не дотягивает, в 3DMark'03 - успешно показывает 20 000 "попугаев". Цифра красивее! :) Идем дальше.

Несмотря на "двухголовость" и разгон, в этом разрешении 3D1-68GT не может превзойти даже одиночную 7800GT. По всей видимости, недостаток производительности центрального процессора не позволяет 3D1-68GT развернуться в полную силу. Посмотрим, что будет при более высоких разрешениях.

Предположение оказалось верным. 3D1-68GT показывает результаты уже сравнимые с 7800GTX, а 7800GT отстает на 10%.

Очередное повышение нагрузки на видеоподсистему еще раз подтверждает, что 3D1-68GT к этому вполне готова. И если ее предшественница 3D1 (на базе двух 6600GT) в самых "тяжелых" графических режимах уступала одиночным высшим представителям семейства 6ххх, то 3D1-68GT на равных борется в высшей лиге сегодняшнего дня.

Низкое разрешение и недостаток мощи CPU сглаживает разницу в результатах. Кажется, что еще чуть-чуть и 3D1-68GT "поборет" 7800GTX-SLI, но чуда не случилось.

Разница становится заметнее. Посягнуть на первенство 7800GTX-SLI уже не представляется возможным, но и соперники в лице 7800GT/GTX уже не так сильно дышат в затылок.

Картина принципиально не меняется.

Самая "тяжелая" игра расставляет все по местам. Серьезные оптимизации видеочипов поколения G70 не прошли даром. 3D1-68GT изо всех сил старается держаться на уровне. Помогает только разгон.

Ситуация чуть лучше. 3D1-68GT между двух огней. 7800GT поджимает снизу, 7800GTX - сверху.

Картина принципиально не изменяется, но есть один сюрприз. Разогнанная 3D1-68GT так и не смогла пройти весь тест до конца. Вернее, она его проходила, без артефактов, но регулярно возникало зависание на последнем кадре теста, как следствие - узнать итоговый результат не получилось. На номинальных частотах никаких проблем не возникало. Тем не менее, на графике я оставил разогнанную 3D1-68GT на прежнем месте. Следует трактовать это как - "здесь могли бы быть результаты разогнанной 3D1-68GT, если бы непонятный глюк на последнем кадре не помешал бы их получить" :)

Стр.4 - Выводы. Заключение.

Выводы

Безусловно, видеокарта 3D1-68GT - очень интересный продукт. Ожидать его широкого распространения на массовом рынке вряд ли стоит. Да и, признаться, уже несколько поздновато. Конечно, производительность, демонстрируемая 3D1-68GT очень и очень неплоха. Но как вы могли убедиться на примере F.E.A.R - меряться силами в играх нового поколения даже с одиночными лидерами сегодняшнего дня 3D1-68GT удается с большим трудом. Реалии таковы, что со временем разница будет становиться все более и более заметной. Тем не менее, здесь и сейчас, 3D1-68GT - продукт, который обращает на себя внимание.

"Двухголовые" видеокарты серии 3D1 открывают еще одну очень интересную возможность - в Интернет можно найти сообщения об успешной переделке чипсетов NForce 4-4x в полноценные NForce 4 SLI. Разумеется, от такой переделки на материнской плате дополнительного полноразмерного слота PCI-E не появится, но появляется возможность установить в единственный слот PCI-E 16x видеокарту серии 3D1 и существенно поднять производительность видеоподсистемы. Мне могут возразить - зачем такие извращения? Все равно одиночные 7800GT/GTX показывают близкую производительность. Я сознательно подчеркиваю - решение из серии 3D1. Ибо путь проложен, и двухголовые решения на базе современнейших видеопроцессоров рано или поздно появятся.

С другой стороны, видеокарта 3D1-68GT имеет все шансы стать раритетом, и кто знает, может через пару лет на аукционе за нее можно будет выручить кучу денег? : К сожалению, не все необычное со временем переходит в разряд ценного антиквариата. Вы бы отдали большие деньги за первую клавиатуру била Гейтса? Я лично - нет. А вот его энцефалограмма мозга, когда он писал первую MS-DOS - наверняка бы стала хитом торгов. Как пособие для начинающих программистов. Мол - "стремитесь к этому, и вас ждет великое будущее". Адептов подобного подхода все же хочу предупредить - решив написать свою первую программу и стремясь быть настолько похожим на Била Гейтса, будьте осторожны, ну добьетесь вы такого же альфа-ритма, но не получится ли у вас в итоге... та же самая MS-DOS? :) Впрочем, я несколько отвлекся.

По информации сотрудников российского представительства компании Gigabyte, рекомендованная цена на 3D1-68GT установлена в $599. Видеокарты должны появиться в течение нескольких недель. Представители Gigabyte рекомендуют обращаться к официальным дистрибьюторам компании.

-

Подведем итоги:

- Требования к системе, выдвигаемые к системе со стороны 3D1-68GT довольно серьезны. Необходимо наличие поддержки SLI, мощного блока питания, хорошего охлаждения.

- Цена несколько превышает средний уровень видеокарт на основе 7800GT/GTX, но меньше, чем суммарная стоимость двух отдельных видеокарт 6800GT, и уж конечно значительно меньше двух 7800GT/GTX.

- Производительность 3D1-68GT в большинстве современных игр близка по производительности 6800 Ultra-SLI и превосходит производительность одиночных 7800GT/GTX на величину до 25%.

- 3D1-68GT - стильная имиджевая штучка.

Что из вышеперечисленного наиболее важно, каждый решит для себя сам. Несомненно одно, 3D1-68GT - удачный продукт, хоть и несколько припозднившийся с выходом на рынок.

Заключение

3D1 на базе двух 6600GT была первой удачной ласточкой за последние пару лет, хотя ограничение шины GPU в 128 bit и не позволило ей развернуться в полную силу. Видеокарта 3D1-68GT - достойная преемница 3D1. Надеюсь, что инженеры Gigabyte хорошо освоили практику создания видеокарт на базе двух графических процессоров, и в недрах лабораторий вовсю идет работа над двухчиповыми картами следующего поколения.

Действительно, почему бы не сделать 3D1 сразу на двух чипах 7800GTX? Энергопотребление 7800GTX меньше, чем у 6800Ultra. Видеопроцессоры 7800GTX поддерживают память до 512 МБ - отличный шанс первыми в мире выпустить видеокарту с ГИГАБАЙТОМ видеопамяти на борту. Пусть сейчас столько и не нужно, но, определенно, компании GIGABYTE будет чем похвастаться, если конечно ее не опередят.

Имеют ли право на жизнь решения типа 3D1? Ответ - да!

Будут ли они привлекательны для пользователя? Вопрос, конечно, более сложный. Как уже говорилось, требования к системе для двух видеокарт в SLI и одной двухчиповой видеокарты - одинаковы. Конфигурация системы, состоящей из двух видеокарт - более гибкая. Но у двухчиповых видеокарт есть еще одно потенциальное преимущество. Может быть, когда-нибудь, NVIDIA все-таки решится на этот шаг - поддержку четырех видеопроцессоров в одной системе. Зачем-то же компания выпускает чипсеты серии NForce 4 SLI x16? В этом свете установка двух двухчиповых видеокарт типа 3D1 в систему с двумя слотами PCI-E 16x уже не кажется совсем уж фантастичной.

Понадобится ли SLI-мостик для соединения двух двухчиповых видеокарт? Сложно сказать. Нынешние конструкции видеокарт серии 3D1 не предусматривают этого. Возможно, потребуется изменение и без того сложной разводки. Надеемся, что инженеры с честью преодолеют все эти проблемы и еще не раз удивят нас необычными решениями.

Безусловно, чтобы в полной мере насладится мощью четырех видеопроцессоров в одной системе, придется еще многое сделать. Драйверы, допускающие подобное, по слухам уже на подходе. Но есть существенное ограничение со стороны CPU - производительности центрального процессора уже не всегда хватает, чтобы полностью загрузить даже две видеокарты. С другой стороны, широкое распространение двуядерных CPU рано или поздно заставит разработчиков оптимизировать программное обеспечение с учетом реальной многоядерности CPU, и мы еще не раз увидим обновление старых рекордов.

И, напоследок, еще одна безумная фантазия. Интересно, если NVIDIA все-таки осуществит поддержку 4-х видеопроцессоров в одной системе, возьмутся ли инженеры компании Gigabyte за создание "четырехголовой" видеокарты? И как тогда она будет называться? 3D2? 3D4? 3D-QUAD? Думаю, ни инженеры Gigabyte, ни специалисты по маркетингу сейчас еще не знают ответа на эти вопросы. Время покажет.

А пока мы с большим удовольствием вручаем компании Gigabyte награду "За инновационный дизайн".