Работа над ошибками. Обзор GeForce GTX 580

Вступление. Внешний вид

Анонса первых графических ускорителей на основе архитектуры Fermi ждали достаточно долго. Почти до самого момента официального представления GeForce GTX 480 профильные форумы и сайты постоянно пополнялись очередными порциями слухов и домыслов относительно характеристик будущего флагмана NVIDIA. И вот, наконец, анонс состоялся, все характеристики GF100 стали известны, как стали известны и результаты тестирований, проведённых в десятках лабораторий по всему миру. В этот момент всем стало ясно, что, несмотря на некоторое превосходство GeForce GTX 480 над Radeon HD 5870, триумфального шествия не получилось, и не только потому, что отрыв от одночипового флагмана конкурента оказался в большинстве случаев небольшим. Кроме производительности, такие характеристики как энергопотребление, нагрев и уровень шума новинки, а также её цена, были далеки от характеристик основного конкурента, причём не в лучшую сторону. Совершенно очевидно, что в такой ситуации NVIDIA необходимо принимать решительные меры по устранению недостатков, заняться полировкой продукта, определяющего имидж компании на рынке. Сегодня нам с вами предстоит оценить результаты такой полировки. Итогами кропотливой работы инженеров NVIDIA стал графический процессор GF110 и ускоритель GeForce GTX 580 на его основе, о котором и пойдёт сегодня речь.

Как и в случае с недавно анонсированными ускорителями AMD Radeon HD 6870/6850, новый GeForce GTX 580 не является чем-то революционным. Основная задача, которая стояла перед инженерами компании, заключалась в исправлении допущенных ранее ошибок, а также увеличение производительности для более существенного отрыва от основного конкурента, пока ещё флагманского ускорителя AMD – Radeon HD 5870.

Прежде всего, поговорим о том, что изменилось в GPU GF110 в сравнении с GF100.

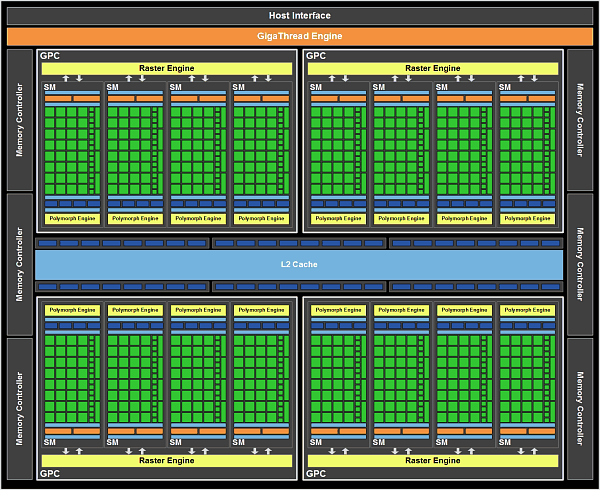

Ещё до выхода первых ускорителей на основе микроархитектуры Fermi, мы поделились с нашими читателями информацией о возможностях старшего GPU в новой линейке чипов NVIDIA - GF100. Итак, изначально в GF100 предусмотрено четыре кластера обработки графики GPC (Graphics Processing Clusters), каждый из них содержит отдельный движок растеризации и по четыре потоковых мультипроцессора (SM – Streaming Multiprocessors). Каждый потоковый мультипроцессор, в свою очередь, имеет по одному модулю полиморфных преобразований Polymorph Engine (который отвечает за выборку вершинных атрибутов и тесселляцию), а также содержит по 32 CUDA-ядра. Кроме того, внутри каждого SM присутствуют по четыре выделенных текстурных блока. Графический процессор GF100 содержит 48 блоков обработки растра (ROP), которые отвечают за блендинг пикселей, сглаживание, а также атомарные операции с памятью. Все ROP сгруппированы в шесть блоков по восемь модулей в каждом. На каждый из шести таких блоков приходится по одному 64-битному контроллеру памяти, ширина шины видеопамяти составляет 384 бита.

К сожалению, первый ускоритель на базе новой архитектуры, GeForce GTX 480, так и не получил всех вычислительных возможностей, которые были заложены инженерами NVIDIA в GPU GF100. Дело в том, что в серийных моделях GTX 480 был отключен один из 16 потоковых мультипроцессоров, в результате, несмотря на свой статус, новая топ-модель лишилась 32 ядер CUDA, четырех текстурных блоков и одного Polymorph Engine. Вероятнее всего, на такой шаг инженеры NVIDIA пошли исключительно из-за производственных проблем, которые достаточно долго преследовали компанию при подготовке к выходу решений на базе Fermi. Впрочем, сейчас это уже не так важно, ведь новый GPU GF110 получил в своё распоряжение все 16 SM, а значит и 512 полноценных ядер CUDA, 64 блока TMU и 16 модуля Polymorph Engine. Более того, инженеры NVIDIA провели ряд модификаций, которые позволили GeForce GTX 580 выполнять полноскоростную фильтрацию текстур с плавающей запятой и 16-битной точностью (FP16), что делает возможным увеличение производительности в тех приложениях, которые требуют большого объема работы с текстурами. Дело в том, что скорость текстурирования на GeForce GTX 480 падает вдвое при использовании 64-битных (fp16x4) форматов с нетривиальной фильтрацией. Например, при текстурировании из формата fp16x4 с билинейной фильтрацией скорость падает до 30 пикселей на такт (PPC), по сравнению с 60 PPC для 32-битных форматов. На GeForce GTX 580 текстурирование из таких форматов происходит на "полной скорости", т.е. и 32-битные, и 64-битные форматы с билинейной фильтрацией работают со скоростью в 64 PPC.

Кроме того, в GeForce GTX 580 был усовершенствован блок отбраковки невидимых поверхностей Z-cull. В случае с графическим процессором GF100, при использовании определенных форматов Z-буфера, эффективность блока Z-cull падала. Благодаря введению в GF110 новых форматов представления буфера глубины в Z-cull, эта проблема была решена.

В целом рост производительности GeForce GTX 580 относительно предыдущего флагмана GeForce GTX 480 в большей степени произойдёт благодаря увеличению количества активных функциональных блоков и росту рабочих частот и в меньшей степени благодаря архитектурным улучшениям, связанным с усилением блока Z-Cull, а также ростом скорости FP16 фильтрации текстур.

Здесь появляется вполне оправданный вопрос: как же быть с энергопотреблением новых ускорителей, ведь не секрет, что одним из существенных недостатков предыдущего флагмана - GeForce GTX 480 было далеко не лучшее соотношение производительности на ватт потребляемой энергии. В случае с новыми GeForce GTX 580 эта проблема также была решена, поскольку инженеры NVIDIA провели глубокий редизайн GPU, используя в критических местах транзисторы с меньшими токами утечки. Это позволило не только поднять рабочие частоты GTX 580 относительно значений предыдущего топа, но при этом ещё и уменьшить энергопотребление нового флагмана в сравнении с GeForce GTX 480!

Для наглядного сравнения характеристик старших представителей семейства Fermi обратимся к таблице:

| GeForce GTX 470 | GeForce GTX 480 | GeForce GTX 580 | |

| Техпроцесс GPU, нм | 40 | ||

| Кластеры обработки графики, шт. | 4 | ||

| Кол-во потоковых мультипроцессоров | 14 | 15 | 16 |

| Кол-во ядер CUDA | 448 | 480 | 512 |

| Кол-во текстурных блоков | 56 | 60 | 64 |

| Кол-во блоков ROP | 40 | 48 | 48 |

| Частота GPU, МГц | 607 | 700 | 772 |

| Частота ядер CUDA, МГц | 1215 | 1401 | 1544 |

| Эффективная частота видеопамяти, МГц | 3348 | 3696 | 4008 |

| Тип видеопамяти | GDDR-5 | ||

| Объём видеопамяти, Мбайт | 1280 | 1536 | 1536 |

| Ширина шины памяти, бит | 320 | 384 | 384 |

| Поддержка DirectX | 11 | ||

| Максимальная TDP, Вт | 215 | 250 | 244 |

| Рекомендованная мощность БП, Вт | 550 | 600 | 600 |

| Предельная температура GPU, °C | 105 | 105 | 97 |

| Рекомендованная розничная стоимость на момент анонса, дол. США / Ориентировочная стоимость в магазинах Москвы, руб. | 349 / 9000 | 499 / ~13500 | 499 / ??? |

Что касается рекомендованной стоимости GeForce GTX 580, то она составляет 499 долларов США, в то время как стоимость GeForce GTX 480 в московской рознице уже составляет порядка 420 долларов (около 13,5 тыс. руб). Таким образом, обе топ-модели NVIDIA и GTX 480 и GTX 580 по цене располагаются между Radeon HD 5870 и Radeon HD 5970. На наш взгляд, такая ценовая политика является весьма разумной и до выхода новых Hi-End решений AMD ускорители GeForce GTX 580 будут достойными кандидатами к приобретению, разумеется, если отечественные магазины не взвинтят цены на 50-70% относительно рекомендованной NVIDIA стоимости.

Подводя промежуточные итоги, отметим ключевые моменты, на которых сосредоточились инженеры компании NVIDIA при разработке GeForce GTX 580:

- Рост производительности GeForce GTX 580 в сравнении с GTX 480 за счёт увеличения количества функциональных блоков, тактовых частот, а также некоторых архитектурных изменений;

- Снижение энергопотребления GeForce GTX 580;

- Улучшение температурного режима GPU GF110;

- Улучшение акустических характеристик системы охлаждения GeForce GTX 580.

Ну что же, поставленные цели, как нам кажется, отражают пожелания поклонников Hi-End продукции NVIDIA, остаётся на практике проверить, что же получилось, но прежде чем мы перейдём к практическим испытаниям GeForce GTX 580, давайте немного поговорим о технологиях, поддерживаемых современными GPU NVIDIA.

В сравнении с GeForce GTX 480 и другими представителями архитектуры Fermi, новый GeForce GTX 580 не получил поддержку каких-либо новых технологий.

Как и большинство других современных ускорителей NVIDIA, GeForce GTX 580 полностью поддерживает технологии NVIDIA PhysX и CUDA, которые позволяют использовать ресурсы графического процессора для разного рода параллельных вычислений, например, аппаратное ускорение PhysX используется для включения ряда физических спецэффектов в играх, основанных на движке PhysX. К сожалению, на данный момент игр с поддержкой технологии NVIDIA PhysX не так много, хотя среди них есть и весьма выдающиеся проекты, например, Batman Arkham Asylum, Mafia II и Metro 2033.

Никуда не делась и поддержка NVIDIA 3DVision, особенностям работы которой мы посвятили отдельный материал.

Нельзя также не упомянуть технологии NVIDIA Surround и NVIDIA 3DVision Surround. По сути, NVIDIA Surround представляет собой несколько ограниченный аналог технологии Eyefinity, которую компания AMD анонсировала ещё осенью 2009 года. Суть NVIDIA Surround заключается в том, что подключив к компьютеру три монитора, пользователь может объединить их в единое рабочее пространство, рассматриваемое системой как один большой монитор. Ограничения NVIDIA Surround связаны с невозможностью объединения в единое пространство более трёх мониторов, а также с необходимостью использования как минимум пары видеокарт NVIDIA в режиме SLI для активации технологии NVIDIA Surround.

Что же касается NVIDIA 3DVision Surround, то эта технология позволяет получить дополнительный эффект присутствия в виртуальных мирах благодаря совместному использованию 3D-очков NVIDIA и трёх 120 Гц-мониторов. К сожалению, на данный момент мы не сможем поделиться своими впечатлениями от работы с NVIDIA Surround/3DVison Surround, однако в будущем, если у нас будет такая возможность, мы обязательно это сделаем.

Ну, а теперь, пришла пора познакомиться с GeForce GTX 580, встречайте:

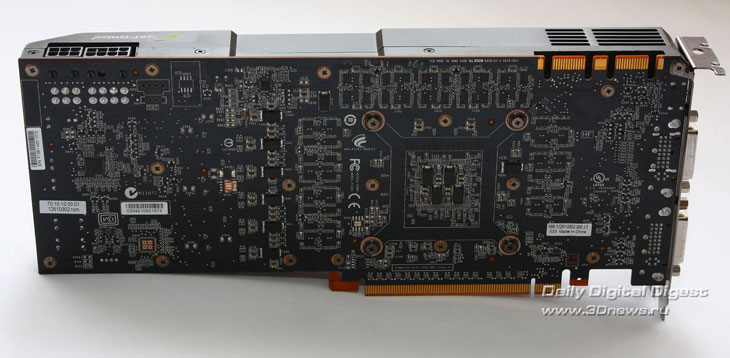

В нашей тестовой лаборатории оказался эталонный образец ускорителя GeForce GTX 580. Несмотря на то, что новая СО GTX 580 заметно отличается от кулера эталонной версии GTX 480, в дизайне системы охлаждения новинки просматриваются характерные черты, свойственные многим Hi-End продуктам NVIDIA. Тут можно провести аналогию с автопромом, например, машины марки BMW имеют ряд характерных особенностей, которые делают эти авто узнаваемыми даже при существенном изменении дизайна кузова.

На панели выводов GeForce GTX 580, помимо вентиляционных отверстий, присутствуют три цифровых разъёма: два DL-DVI и один Mini-HDMI.

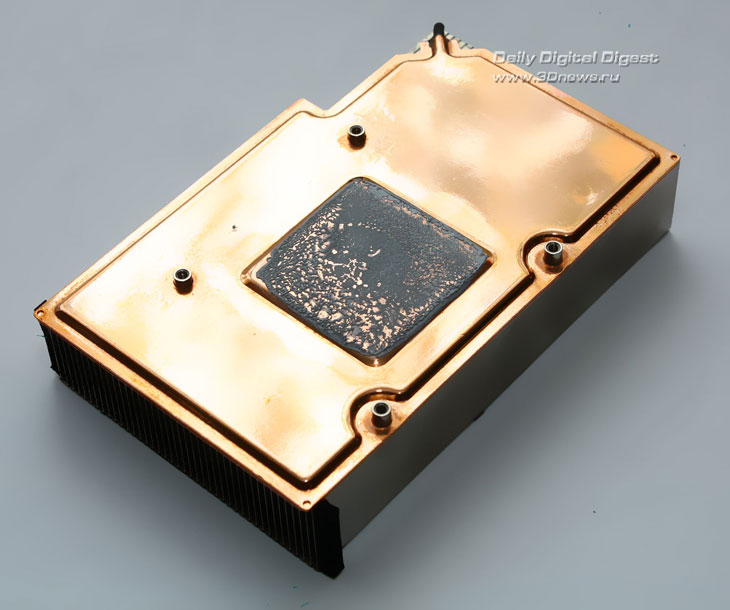

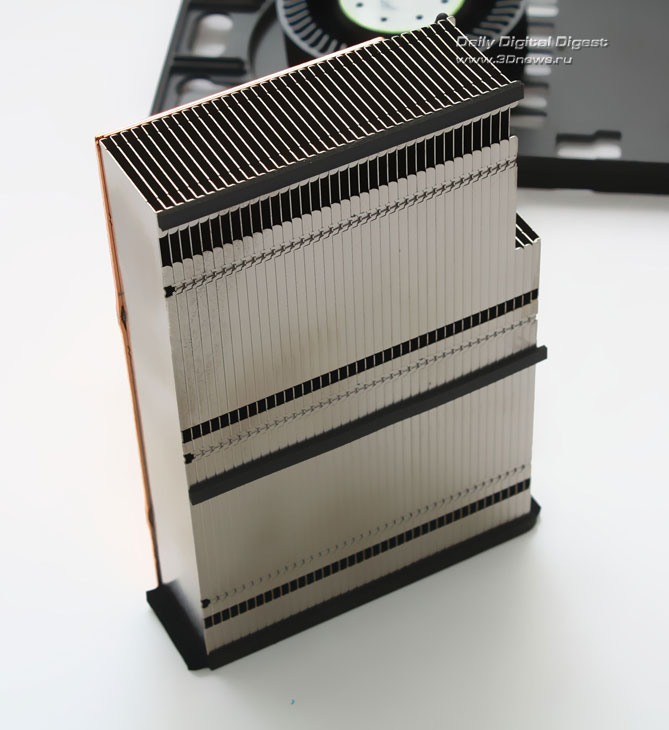

Демонтируем систему охлаждения GeForce GTX 580.

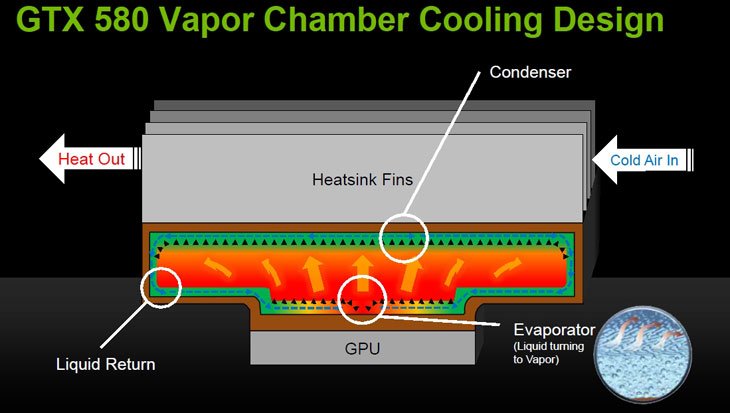

Как вы, наверное, уже успели заметить, новая система охлаждения GTX 580 лишена тепловых трубок, которые присутствовали в СО GeForce GTX 480.

На сей раз система охлаждения топового ускорителя NVIDIA основана на испарительной камере. Графический процессор контактирует с площадкой, прямо над которой располагается герметичный отсек - в нем находится жидкость с низкой температурой кипения. При повышении температуры жидкость меняет своё агрегатное состояние и превращается в газ, перенося с собой тепло к верхней части системы охлаждения. Слегка остывая, газ конденсируется и вновь превращается в жидкость, затем цикл повторяется заново. В свою очередь турбина прогоняет прохладный воздух сквозь нагретые рёбра радиатора и выводит тепло за пределы корпуса. Видеопамять, а также элементы системы питания контактируют с металлическим основанием кулера через специальные термопрокладки.

Небольшой “срез” хвостовой части кожуха системы охлаждения позволяет эффективнее охлаждать связку из нескольких видеокарт, поскольку способствует лучшему прохождению воздушных потоков между двумя близко расположенными ускорителями.

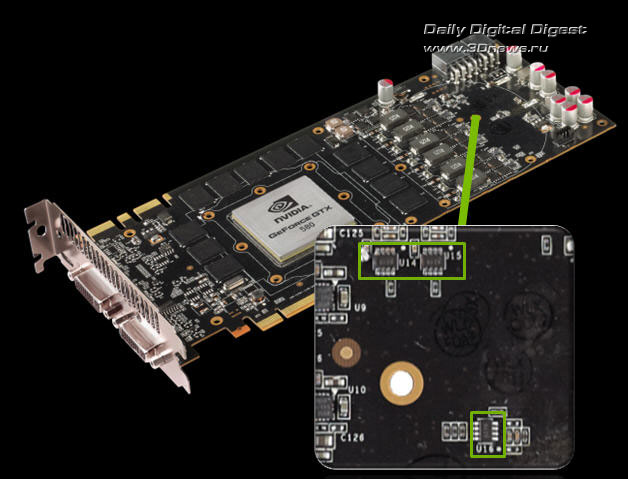

Графический процессор GF110 имеет шесть фаз питания, которые управляются контроллером CHiL Semiconductor CHL8266, точно такой же был установлен на эталонных версиях GeForce GTX 480. Питание памяти выполнено по схеме 1+1 (1 фаза Vdd + 1 фаза Vddq), управляется контроллером Anpec APW7066. Аналогичный контроллер применялся когда-то на GeForce 9800 GTX. В данном случае одним двухканальным контроллером управляются оба напряжения, относящиеся к видеопамяти (Vdd и Vddq), по одному каналу на каждое напряжение.

Следующим нововведением стал механизм аппаратного мониторинга силы тока и напряжений на основных 12 В линиях питания видеокарты (6 и 8-контактные разъёмы питания, а также слот PCI-Express). Если на видеокарту подводится избыточная мощность, превосходящая допустимые спецификациями значения, драйвер автоматически снижает тактовые частоты ускорителя, чтобы не допустить его выхода из строя. Особо производитель отмечает тот факт, что современный драйвер NVIDIA автоматически снижает рабочие частоты ускорителя на 50% при запуске утилит для стресс-тестирования, вроде OCCT или FurMark. По мнению инженеров NVIDIA, подобные программы создают критическую нагрузку на видеокарту, в то время как реальные приложения такой нагрузки никогда не создают. Именно поэтому и было принято решение по искусственному снижению частот силами драйверов. Сообщается также, что конечным пользователям возможности снять это ограничение предоставлено не будет. К сожалению, в данный момент ни одна из утилит не способна отследить снижение частот, вызванное срабатыванием механизма защиты в драйверах, однако после выхода соответствующих обновлений пользователь сможет заметить все изменения в работе видеокарт GeForce GTX 580.

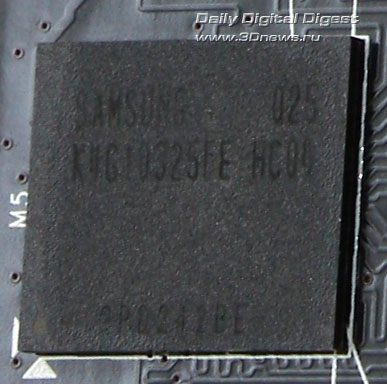

Ускоритель GeForce GTX 580 комплектуется чипами памяти производства Samsung. Маркировка чипов K4G10325FE-HC04, их номинальная частота составляет 5 ГГц QDR, в данном случае память работает на частоте 4 ГГц QDR. Суммарный объём установленной видеопамяти составляет 1536 Мбайт.

Разгон. Тестирование. Выводы

На очереди практические испытания. Приступим. Для начала ознакомьтесь с конфигурацией тестового стенда и списком тестовых пакетов.

| Центральный процессор | Intel Core i7 870 @ 4.0 ГГц (200x19) |

| Система охлаждения | GlacialTech F101 + 2 x 120-мм кулера |

| Материнская плата | ASUS Maximus III Extreme |

| Оперативная память | DDR3 Super Talent 2x2 Гбайт @ 1890MHz @ 9-9-9 |

| Блок питания | IKONIK Vulcan 1200 Вт |

| Жёсткий диск | Samsung SpinPoint 750 Гбайт |

| Корпус | Cooler Master Test Bench 1.0 |

| Операционная система | Windows 7 Ultimate x64 |

| Версия драйверов для карт AMD | Catalyst 10.10 + Catalyst App Profiles 10.10 |

| Версия драйверов для карт NVIDIA | Программное обеспечение NVIDIA версии 260.99 для GeForce GTX 480 Программное обеспечение NVIDIA версии 262.99 для GeForce GTX 580 |

Тестирование проводилось в следующих приложениях:

| 3DMark Vantage | Пресеты Performance, High, Extreme |

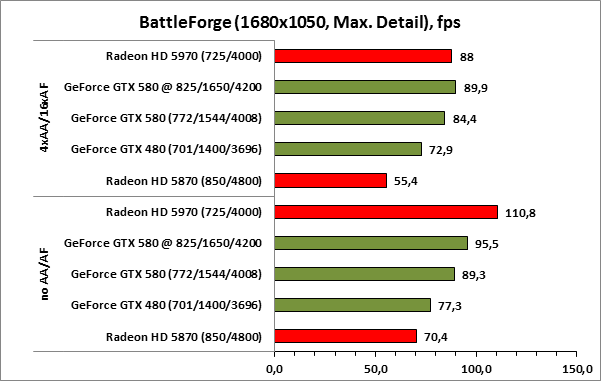

| Battleforge DX 10 | Максимальная детализация, 1920x1200/ 1680x1050 no AA/AF Максимальная детализация, 1920x1200/ 1680x1050 4xAA/AF |

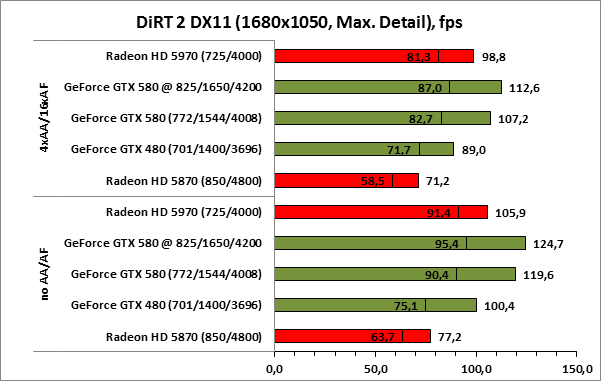

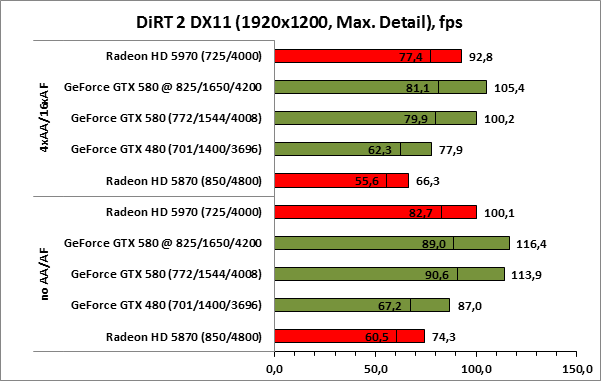

| Colin McRae DiRT 2 DX 11 | Ультра детализация, 1920x1200/ 1680x1050 no AA/AF Ультра детализация, 1920x1200/ 1680x1050 4xAA/AF |

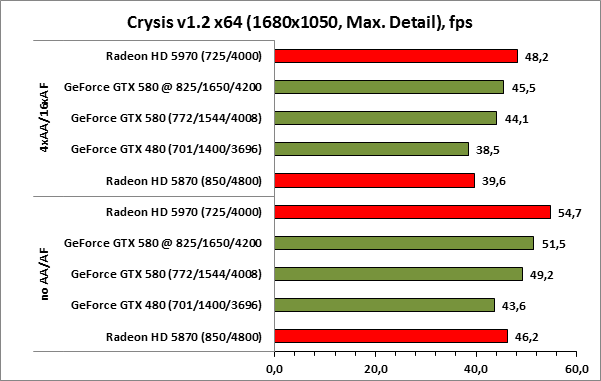

| Crysis v 1.2 x64 DX 10 | Очень высокая детализация, 1920x1200/ 1680x1050 no AA/AF Очень высокая детализация, 1920x1200/ 1680x1050 4xAA/AF |

| Just Cause 2 DX 10 | Очень высокая детализация, 1920x1200/ 1680x1050 no AA/AF Очень высокая детализация, 1920x1200/ 1680x1050 4xAA/AF |

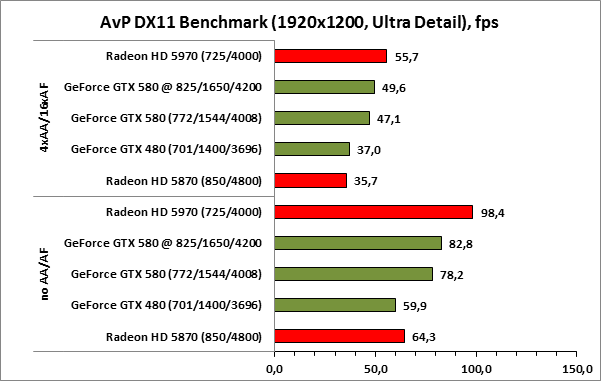

| Alien versus Predator DX 11 Benchmark | Очень высокая детализация, 1920x1200/ 1680x1050 no AA/AF Очень высокая детализация, 1920x1200/ 1680x1050 4xAA/AF |

| FarCry 2 DirectX 10 benchmark | Ультра детализация, 1920x1200/ 1680x1050 no AA/AF Ультра детализация, 1920x1200/ 1680x1050 4xAA/AF |

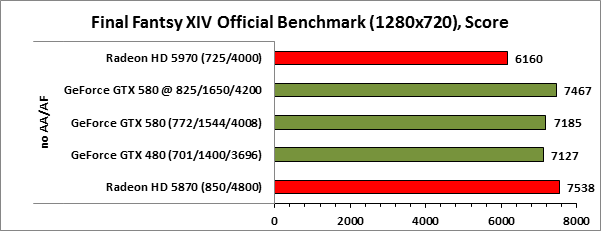

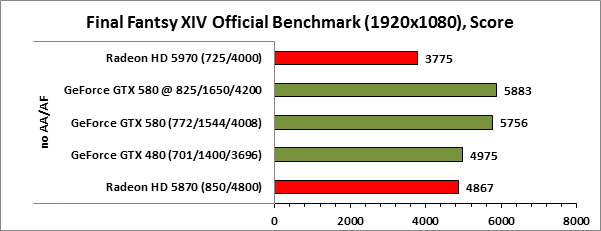

| Final Fantasy XIV | Режим Low, 1280x720 no AA/AF Режим High, 1920x1200 no AA/AF |

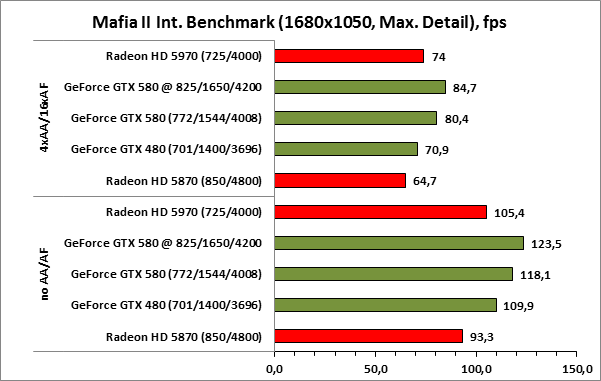

| Mafia II | Максимальная детализация, 1920x1200/ 1680x1050 no AA/AF, технология NVIDIA PhysX выключена Максимальная детализация, 1920x1200/ 1680x1050 no 4xAA/16xAF, технология NVIDIA PhysX выключена |

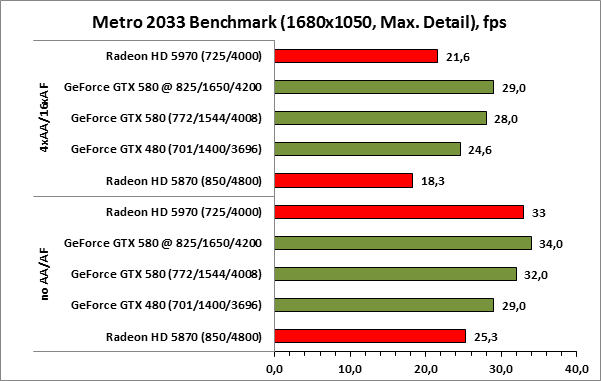

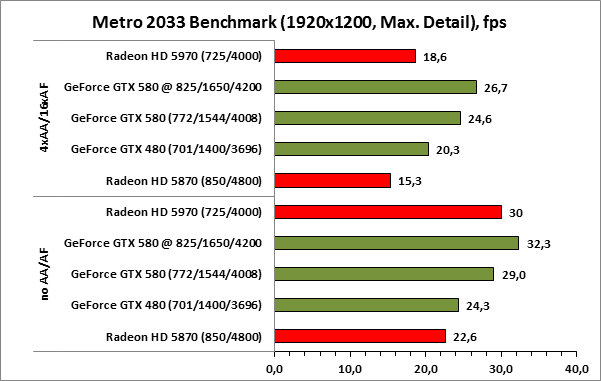

| Metro 2033 DX11 Benchmark | Максимальная детализация, 1920x1200/ 1680x1050 no AA/AF, технология NVIDIA PhysX выключена, DOF и тесселляция включена Максимальная детализация, 1920x1200/ 1680x1050 no 4xAA/16xAF, технология NVIDIA PhysX выключена, DOF и тесселляция включена |

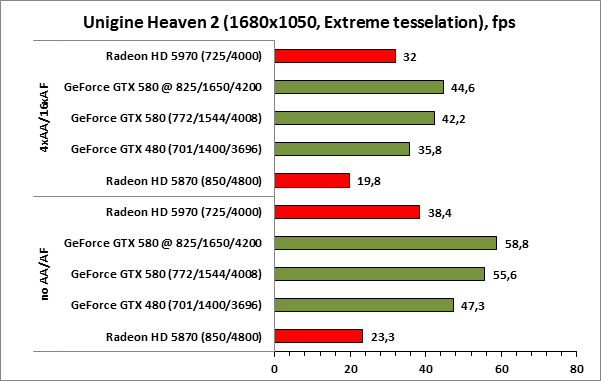

| Unigine Heaven 2.0 | Максимальная детализация, Тесселляция в режиме Extreme, 1920x1200/1680x1050 no AA/AF Максимальная детализация, Тесселляция в режиме Extreme, 1920x1200/1680x1050 4xAA/16xAF |

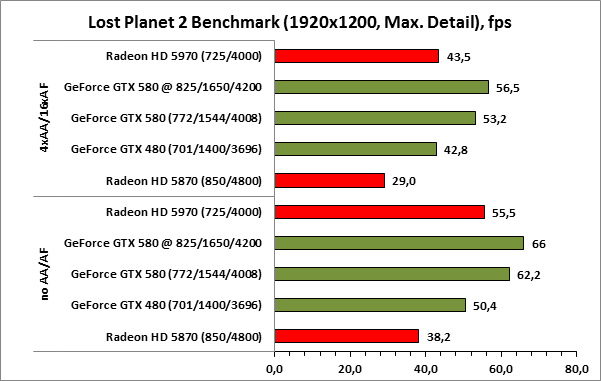

| Lost Planet 2 Benchmark | DX11, Максимальная детализация, тесселляция включена, 1920x1200/1680x1050 no AA/AF DX11, Максимальная детализация, тесселляция включена, 1920x1200/1680x1050 4xAA/16xAF |

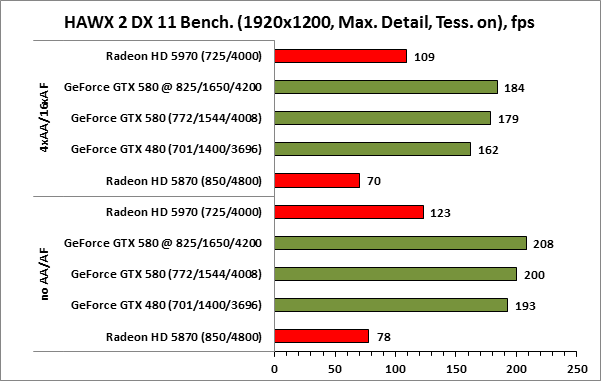

| HAWX 2 Benchmark (Release) | DX11, Максимальная детализация, тесселляция включена, 1920x1200/1680x1050 no AA/AF DX11, Максимальная детализация, тесселляция включена, 1920x1200/1680x1050 4xAA/16xAF |

В тестировании принимали участие следующие видеокарты:

- NVIDIA GeForce GTX 480 1536 Мбайт (701/1400/3696);

- NVIDIA GeForce GTX 580 1536 Мбайт (772/1544/4008);

- AMD Radeon HD 5870 (850/4800);

- AMD Radeon HD 5970 (725/4000).

Обычно для разгона видеокарт мы используем утилиту MSI Afterburner, не изменили традиции мы и на этот раз. Вторая версия Afterburner без проблем опознала ускоритель GeForce GTX 580 и позволила регулировать его тактовые частоты, а также снимать температурные показатели. В результате наших манипуляций с частотами GTX 580, удалось добиться стабильной работы ускорителя во всех тестах с частотной формулой 825/1650/4200 МГц для графического ядра, шейдерных блоков и видеопамяти, соответственно.

⇡#Замечания о работе ускорителя в режиме максимальной загрузки при помощи стресс-тестов

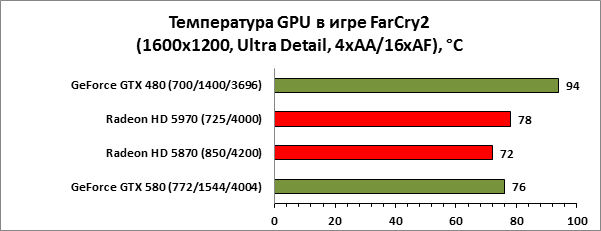

Как мы писали выше, новые драйверы NVIDIA (262.99 и старше) определяют запуск утилит стресс тестирования (OCCT, FurMark 1.8) и занижают рабочие частоты ускорителя на 50%. При этом диагностическое ПО сторонних разработчиков пока не в состоянии корректно отследить такое снижение. В нашем случае, после запуска FurMark 1.8.5 были получены весьма сомнительные результаты, поэтому в этот раз мы решили не использовать стресс-тестирование для оценки температуры и энергопотребления, ограничившись лишь игровым режимом в Far Cry 2.

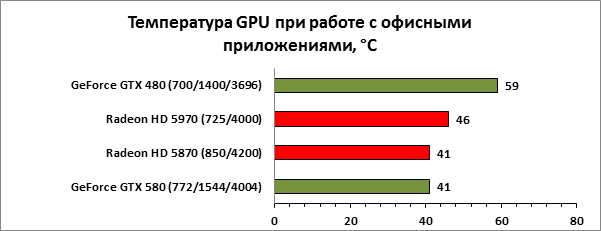

⇡#Температура и энергопотребление

Как правило, во всех наших тестах температура графических процессоров AMD оказывается ниже, чем температура GPU равноценных ускорителей NVIDIA, в случае, если установлена эталонная система охлаждения. В данном случае ситуация иная. В офисном режиме температура графического процессора GeForce GTX 580 находится на одном уровне с GPU Radeon HD 5870, в игровом режиме GF110 оказывается всего на 4 градуса горячее, что очень даже неплохо, поскольку менее производительный GF100 в аналогичных условиях прогревался до 94 градусов Цельсия!

Для получения подобного результата, как мы уже говорили выше, инженеры NVIDIA не только использовали новую систему охлаждения, принцип работы которой идентичен принципу работы СО Radeon HD 5970, но и провели серьёзную “транзисторную” модернизацию GPU. Обратим ваше внимание, что на протяжении всего процесса тестирования шум системы охлаждения GeForce GTX 580 не выделялся на фоне шума остальных компонентов системы. С нашей точки зрения это очень хороший результат, особенно учитывая прошлые “заслуги” NVIDIA в плане нагрева GPU и уровня шума стандартных систем охлаждения. Посмотрим, как обстоят дела с аппетитом GTX 580.

В типичных режимах с энергопотреблением у GeForce GTX 580 тоже наблюдается полный порядок. Да, Radeon HD 5870 по-прежнему экономичнее, однако разница между GTX 580 и HD 5870 настолько незначительна, что в данном случае можно засчитать ничью.

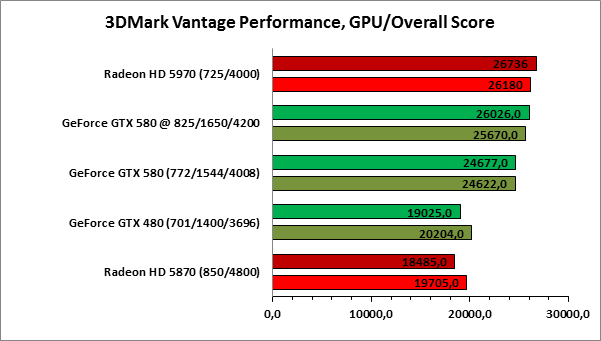

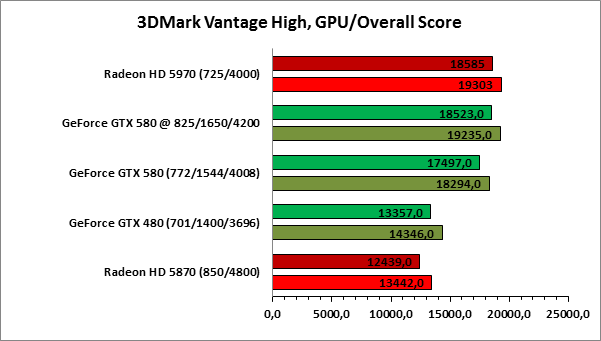

В отличие от GeForce GTX 480, который хоть и опережает Radeon HD 5870, но делает это не очень уверенно, ускоритель GeForce GTX 580 отрывается от конкурента достаточно заметно. Более того, даже без разгона GeForce GTX 580 находится в опасной близости от флагмана компании AMD – ускорителя Radeon HD 5970.

Как мы уже неоднократно отмечали, архитектура GF100 (а значит и GF110) оптимизирована для работы в сверхтяжёлых режимах. В режимах без сглаживания с существенным отрывом от всех прочих ускорителей идёт Radeon HD 5970, но как только включается полноэкранное сглаживание, двухчиповый флагман AMD начинает сдавать позиции, не сильно опережая неразогнанный ускоритель GeForce GTX 580 в разрешении 1680x1050 и отставая от него при работе с разрешением 1920x1200.

Как известно, гоночный симулятор Colin McRae DiRT 2 стал одной из первых игр, поддерживающих DirectX 11 и тесселляцию, использование которой в этой игре видно далеко не всегда, а в процессе гонки эффект от неё и вовсе с трудом различим. Тем не менее, даже несмотря на невысокую степень тесселляции, GeForce GTX 580 выглядит очень уверенно, обгоняя даже Radeon HD 5970 вне зависимости от выбранного режима. Безусловно, даже в самом тяжёлом режиме DiRT 2 прекрасно работает на Radeon HD 5870, и уж тем более на Radeon HD 5970, однако счётчик кадров упрямо показывает перевес представителей зелёного лагеря, в этом тесте GeForce GTX 580 одерживает убедительную победу. Посмотрим, что будет дальше.

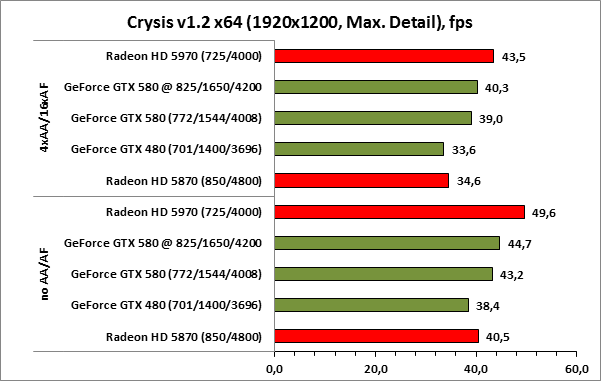

Культовый Crysis, ставший на несколько лет вперёд чуть ли не эталоном с точки зрения графики. До сих пор по качеству картинки этот проект может без особого труда соперничать со многими играми, вышедшими в этом году. В данном случае GeForce GTX 580 уступает старшему ускорителю на базе GPU Cypress и лишь незначительно опережает одночиповый Radeon HD 5870.

Превосходство ускорителя GeForce GTX 580 над своим предшественником GeForce GTX 480 составляет порядка 15%, однако этого оказывается вполне достаточно для того, чтобы даже без разгона обойти Radeon HD 5970! Отличный результат.

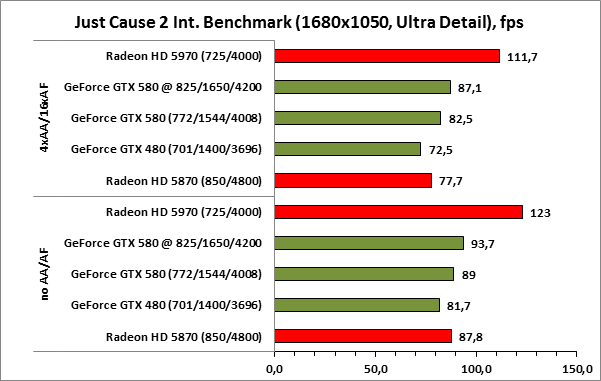

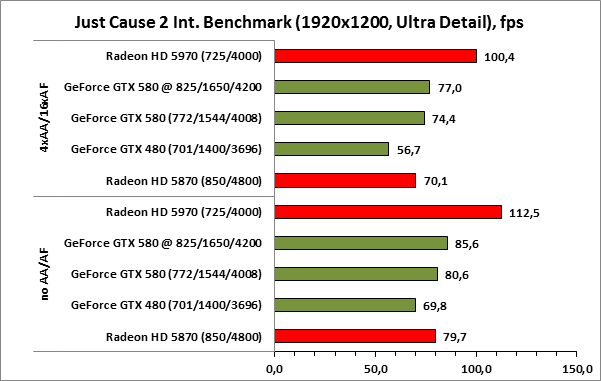

В игре Just Cause 2 новый флагман NVIDIA опережает GeForce GTX 480 примерно на 10-15%, в зависимости от используемого графического режима, в данном случае такого перевеса хватает лишь для того, чтобы соперничать с Radeon HD 5870, в то время как HD 5970 вне досягаемости.

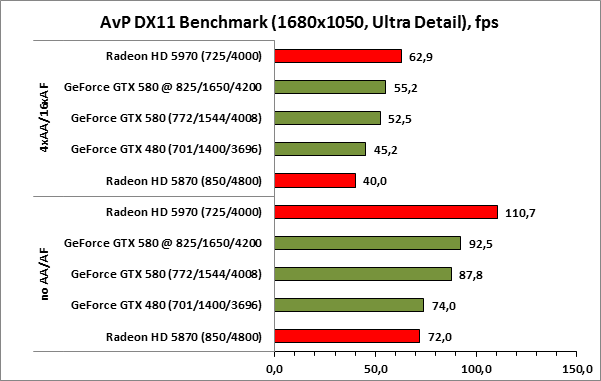

Ускоритель GeForce GTX 580 в игре Alien versus Predator легко кладёт на лопатки Radeon HD 5870 даже в относительно “простых” режимах без сглаживания и анизотропной фильтрации, но даже после разгона флагман NVIDIA не сумел догнать и уж тем более перегнать Radeon HD 5970.

Официальный бенчмарк Final Fantasy XIV не лучшим образом относится к многочиповым решениям и, судя по результатам, игнорирует второй GPU Radeon HD 5970. Стоит помнить, что тактовые частоты флагманского ускорителя AMD снижены относительно значений установленных для Radeon HD 5870 - именно это и объясняет проигрыш Radeon HD 5970 более дешёвому решению AMD. Что же касается продуктов NVIDIA, то, в разрешении 1280x720 результаты, судя по всему, ограничиваются мощностью центрального процессора, который не в состоянии “прокачать” данными не только GeForce GTX 480, но уж тем более GeForce GTX 580. В результате, в низком разрешении лидирует Radeon HD 5870, а в разрешении 1920x1080 победа достаётся GTX 580, который после разгона прибавил очень мало баллов. Возможно, это вновь связано с недостаточной производительностью центрального процессора.

В игре Metro 2033 разработчики уделили много внимания проработке деталей виртуального мира. Даже кабели на стенах выполнены в виде полноценных 3D-моделей, а не текстур, как это было раньше. Движок Metro 2033 очень требователен к ресурсам GPU, особенно по части скорости обработки геометрии и тесселляции. В лёгких режимах Radeon HD 5970 совсем незначительно опережает GeForce GTX 580, зато с переходом к супертяжёлым режимам, новинка от NVIDIA выглядит более предпочтительно, чем HD 5970. Более того, даже GTX 480 проявляет себя, показывая лучший результат, чем Radeon HD 5970.

Движок Lost Planet 2 показывает аналогичную картину. Ускоритель Radeon HD 5970 оказывается несколько быстрее, чем GeForce GTX 480 или выступает с ним на равных. А вот главный герой нашего обзора - GeForce GTX 580, в этом тесте опережает всех представителей красного лагеря.

Тестовый пакет Unigine Heaven 2.0 – одно из немногих приложений, способных передать всю красоту сложного режима тесселляции. Чтобы понять, о чём идёт речь, ознакомьтесь с отдельным материалом, посвящённом тесселляции. Итак, уже давно было отмечено, что одним из слабых мест в архитектуре GPU Cypress является недостаточно мощный блок тесселляции. Это наглядно демонстрируют графики, из которых видно, что даже Radeon HD 5970 оказывается слабее GeForce GTX 480, причём разница в результатах весьма существенная. Для современных флагманских GPU Cypress от AMD ситуация уже вряд ли изменится, а вот будущие GPU с кодовым именем Cayman должны получить куда более мощные блоки тесселляции и верится в это охотно, судя по тому, как прибавила в скорости средняя по стоимости видеокарта AMD Radeon HD 6870.

Не успел аркадный симулятор HAWX 2 попасть на прилавки магазинов, как бенчмарк из этой игры, вышедший как раз в день анонса Radeon HD 6850/6870, успел наделать много шума. Причиной волнений послужил выход недоработанной бета-версии тестового пакета HAWX 2. В этом многие тут же увидели попытки NVIDIA ослабить интерес публики к Radeon HD 6850/6870. Мы не будем судить за это компанию NVIDIA, тем более что на данный момент вышла полная версия бенчмарка HAWX 2, где режим DirectX 11, как и тесселляция, работает - самое время пройти тестирование. К сожалению, даже самый быстрый ускоритель AMD уступает пальму первенства GTX 580, причём разница почти двукратная. Насколько нам известно, AMD готовит ряд поправок для своих драйверов, с целью минимизировать отставание в этом тесте от GPU NVIDIA.

В качестве небольшого дополнения отметим, что результаты работы тесселляции в этой игре заметны невооружённым глазом. Ниже мы приведём скриншотов, взятых из официальной презентации NVIDIA. На них чётко видны отличия в качестве прорисовки рельефа.

Первое, что бросается в глаза при просмотре результатов тестирования в игре Mafia II, так это мизерный отрыв Radeon HD 5970 от Radeon HD 5870. Безусловно, двукратного и даже близкого к двукратному отрыва Radeon HD 5970 от младшего собрата не будет, тем не менее, 10% разницы – это слишком мало. Переустановка драйверов, к сожалению, не принесла результата, остаётся надеяться на будущие версии драйверов. Ну, а пока ускорители Radeon HD 5870 и Radeon HD 5970 в игре Mafia II способны тягаться лишь с GeForce GTX 480, где-то выигрывая, где-то уступая бывшему королю среди решений NVIDIA. Особнячком, если так можно выразиться, стоит GeForce GTX 580, которому, по большому счёту, для победы над конкурентами разгон не нужен.

Нетрудно заметить, что перед выходом GeForce GTX 580 компания NVIDIA провела серьёзную и кропотливую работу по устранению очевидных недостатков GeForce GTX 480. По нашему мнению, у неё это получилось. Посудите сами, пониженный относительно предшественника уровень энергопотребления, меньший нагрев GPU и достаточно тихая система охлаждения - всё это при том, что новинка оказалась ощутимо быстрее GTX 480, более того, во многих приложениях GTX 580 оказывается производительней Radeon HD 5970.

C другой стороны, с момента выхода Cypress и видеокарт на его основе прошло уже больше года, за это время NVIDIA не смогла представить со всех сторон законченный продукт, а сделала это только сейчас, когда на подходе очередные топ-модели от конкурента. Так что делать выводы ещё рано, впереди нас ждёт нешуточная битва, в которой возможны “потери” и с той и с другой стороны. Оставайтесь с нами!