|

Опрос

|

реклама

Быстрый переход

Wikipedia пожаловалась, что из-за ИИ её стали меньше читать живые люди — и у этого будут последствия

17.10.2025 [14:50],

Алексей Разин

Управляющая работой онлайн-энциклопедии Wikipedia некоммерческая организация Wikipedia Foundation вынуждена сообщить, что распространение технологий искусственного интеллекта с интеграцией результатов запросов в поисковую выдачу заметно снизило количество просмотров этого ресурса живыми людьми.

Источник изображения: Oberon Copeland @veryinformed.com / unsplash.com В этой сфере, как можно выразиться словами песни, тоже «вкалывают роботы», собирающие всю нужную пользователю информацию для формирования выжимки в поисковике или интерфейсе чат-бота без необходимости обращения к странице первоисточника. По словам представителей Wikipedia, данная тенденция в долгосрочной перспективе ставит под угрозу функционирование самой всемирной онлайн-энциклопедии: «Если количество посетителей Wikipedia сократится, меньше желающих будет находиться для обогащения и расширения контента, меньше индивидуальных доноров смогут поддерживать эту работу». Примечательно, что для создателей больших языковых моделей само по себе существование Wikipedia крайне важно, ведь на материалах этого ресурса происходит значительная часть обучения систем ИИ. Поисковые системы и социальные сети, по словам представителей платформы, отдают приоритет информации с ресурса, поскольку она пользуется определённым доверием у пользователей. В мае текущего года Wikipedia столкнулась с ростом трафика, якобы генерируемого живыми пользователями из Бразилии, но инцидент лишь заставил руководство ресурса усовершенствовать систему борьбы с ботами. С тех пор количество просмотров живыми пользователями начало снижаться, в годовом сравнении оно достигло 8 %. В Wikipedia Foundation связывают такую тенденцию с изменением доминирующего способа получения информации пользователями — чат-боты и встроенный в поисковые системы ИИ лишили их необходимости обращаться к первоисточникам. Внутренняя политика Wikipedia при этом накладывает ограничения на интенсивность обращения к ней сторонними роботами. Распространение механизмов защиты от ботов показало, что живые люди к страницам ресурса стали обращаться реже. Боты при этом более искусно выдают себя за людей. Прочие источники тоже отмечают, что внедрение ИИ в сферу поиска информации в интернете сократило потребность обращения к первоисточникам. Анализ работы поисковой системы Google летом этого года выявил, что только 1 % запросов приводил к переходу пользователей по ссылке на первоисточник, во всех остальных случаях люди просто довольствовались сгенерированной ИИ выборкой данных. Кроме того, молодая аудитория привыкла получать всю информацию в пределах социальных сетей, не особо утруждая себя навигацией по всему интернету. Wikipedia также обеспокоена тем, что ИИ начинает использоваться для создания энциклопедических статей, снижая достоверность информации. Активность роботов, занимающихся сбором информации, при этом создаёт повышенную нагрузку на техническую инфраструктуру Wikipedia. Создатели ресурса пытаются усилить интеграцию с популярными социальными сетями и подстраиваться под новые реалии, а не пытаться вернуться к прежнему порядку за счёт запретов и блокировок. Старший директор Wikipedia Foundation по продуктам Маршалл Миллер (Marshall Miller) обратился к пользователям со следующими словами: «Когда вы ищете информацию в онлайне, обращайте внимание на цитаты и переходите по ссылкам на источники материалов. Говорите со своими знакомыми о важности создания доверенной и контролируемой людьми базы знаний, и помогайте им понять, что лежащий в основе ИИ контент был создан реальными людьми, которые заслуживают вашей поддержки». ChatGPT научился запускать Spotify, Canva и множество других приложений прямо в чате

06.10.2025 [23:14],

Николай Хижняк

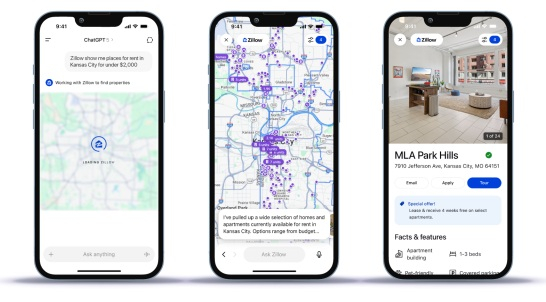

На ежегодном мероприятии DevDay 2025 компания OpenAI представила новый способ создания и взаимодействия со сторонними приложениями внутри ChatGPT. С понедельника пользователи чат-бота смогут получить доступ к приложениям таких компаний, как Booking.com, Expedia, Spotify, Figma, Coursera, Zillow и Canva. OpenAI также запускает предварительную версию Apps SDK — инструментария для разработчиков, предназначенного для создания и поддержки приложений внутри ChatGPT.

Источник изображения: Unsplash / Levart_Photographer «Мы хотим, чтобы ChatGPT стал отличным способом для людей добиваться прогресса, быть более продуктивными, более изобретательными, быстрее учиться и лучше делать всё, что они пытаются делать в своей жизни. [Приложения в ChatGPT] позволят создать новое поколение интерактивного, адаптивного и персонализированного программного обеспечения, с которым можно взаимодействовать», — заявил генеральный директор OpenAI Сэм Альтман (Sam Altman). Как пишет TechCrunch, новая система приложений в ChatGPT представляет собой очередную попытку OpenAI построить экосистему приложений вокруг своего флагманского продукта на основе искусственного интеллекта. В отличие от предыдущего решения — отдельного магазина приложений GPT Store, — новая система размещается непосредственно в ответах ChatGPT, что позволяет пользователям вызывать сторонние инструменты прямо в своих повседневных диалогах. Такой подход, по мнению OpenAI, позволит разработчикам эффективнее распространять создаваемые ими продукты, а также сделает ChatGPT более удобным для пользователей. Вводя названия различных приложений в строку запроса ChatGPT, пользователи могут получать контент из разных сервисов. Например, можно сказать: «Figma, преврати этот набросок в рабочую диаграмму», чтобы открыть приложение Figma. Пользователи также могут вызвать приложение Coursera, спросив: «Coursera, можешь научить меня чему-нибудь о машинном обучении?»

Риэлторский сервис Zellow внутри ChatGPT В демоверсии риэлторского приложения Zillow пользователи через ChatGPT на естественном языке просили подсказать, какие квартиры в их районе находятся в определённом ценовом диапазоне. Затем ChatGPT отобразил интерактивную карту с вариантами, и пользователи могли задавать дополнительные вопросы, чтобы узнать больше о каждом из предложений. ChatGPT также будет показывать пользователям, какие приложения могут быть полезны для решения той или иной задачи. Например, если кто-то запросит плейлист для вечеринки на выходные, ChatGPT может вызвать приложение Spotify. По словам OpenAI, в будущем в ChatGPT также появятся такие приложения, как DoorDash, Instacart, Uber и AllTrails. OpenAI заявляет, что новая система приложений построена на основе протокола контекста модели (MCP), который позволяет разработчикам подключать свои источники данных к системам искусственного интеллекта. Приложения ChatGPT также могут запускать действия и отображать полностью интерактивный пользовательский интерфейс в ответах чат-бота. Некоторые приложения смогут отображать видео в ChatGPT — оно будет закреплено в верхней части веб-страницы и может изменяться в зависимости от запросов пользователя. Если пользователи уже подписаны на тот или иной продукт, они смогут войти в свою учётную запись непосредственно через ChatGPT для доступа к дополнительным функциям. Альтман также отметил, что в будущем OpenAI будет поддерживать способы монетизации приложений внутри ChatGPT, в том числе с помощью недавно запущенной функции мгновенного заказа (Instant Checkout). Что касается безопасности, OpenAI заявляет, что разработчики должны «собирать только минимально необходимые данные и предоставлять прозрачные разрешения». Однако пока неясно, будут ли создатели приложений для ChatGPT иметь доступ ко всей переписке пользователя с чат-ботом, к нескольким последним сообщениям или только к последнему запросу, вызвавшему запуск того или иного приложения. Также остаётся вопрос, как ChatGPT будет выбирать сервисы среди конкурирующих компаний, таких как DoorDash и Instacart. Возможно, компании смогут платить за упоминание в ответах ChatGPT. OpenAI пока не даёт прямого ответа и заявляет, что намерена ставить в этом вопросе «пользовательский опыт превыше всего». ChatGPT достиг 800 млн пользователей в неделю — плюс 60 % всего за полгода

06.10.2025 [22:55],

Николай Хижняк

Генеральный директор OpenAI Сэм Альтман (Sam Altman) сообщил в понедельник, что число еженедельно активных пользователей ChatGPT достигло 800 млн, что свидетельствует о продолжающемся росте популярности ИИ-чат-бота среди потребителей, разработчиков и предприятий по всему миру.

Источник изображения: OpenAI Впечатляющий рост ChatGPT происходит на фоне стремления OpenAI получить как можно больше ИИ-чипов и построить как можно более мощную ИИ-инфраструктуру. В августе OpenAI заявила, что приближается к 700 млн еженедельно активных пользователей. К концу марта их количество составляло 500 млн. «Сегодня 4 млн разработчиков работают с OpenAI. Более 800 млн человек используют ChatGPT каждую неделю, и мы обрабатываем более 6 млрд токенов в минуту через API. Благодаря всем вам ИИ превратился из того, с чем люди просто играют, в то, что люди создают каждый день», — сказал Альтман. Альтман сделал заявление во время основного доклада на Дне разработчиков OpenAI, где также были представлены новые инструменты для создания приложений в ChatGPT и построения более сложных агентных систем. «Это позволит создать новое поколение интерактивных, адаптивных и персонализированных приложений, с которыми можно общаться», — отметил Альтман, представляя новые продукты. ChatGPT был запущен в ноябре 2022 года и практически сразу же продемонстрировал беспрецедентный рост числа пользователей, став ведущим потребительским продуктом на основе ИИ, а также одним из самых быстрорастущих онлайн-сервисов в истории. Недавно инструмент был расширен новой функцией ChatGPT Pulse, предоставляющей пользователям персонализированные утренние сводки. OpenAI, по-прежнему юридически зарегистрированная как некоммерческая организация, в четверг стала самой дорогой частной компанией в мире после частной продажи акций на сумму $6,6 млрд. Она оценивается в $500 млрд. Компания продолжает активно выпускать новые продукты. На прошлой неделе OpenAI представила новую версию инструмента для создания видео Sora вместе с сопутствующей социальной сетью. На той же неделе компания совместно с Stripe сообщила об интеграции онлайн-шоппинга в диалоговое окно ChatGPT. Cloudflare обновила robots.txt: теперь сайты могут запретить ИИ-чат-ботам воровать контент

03.10.2025 [17:19],

Павел Котов

Cloudflare объявила о поддержке новых директив для файла robots.txt, учитывающих, что сайты теперь посещают роботы не только поисковых систем, но и чат-ботов с искусственным интеллектом.

Источник изображения: cloudflare.com Файл robots.txt можно найти почти на каждом веб-сайте. В нём содержатся директивы по поводу того, какие страницы поисковые системы и боты могут посещать, а какие — не могут. Требования этого файла технически не являются обязательными к выполнению, но на заре интернета, когда службы вроде Google их соблюдали, проблем не возникало. Всё изменило появление ИИ: чат-боты не индексируют сайты в традиционном смысле, а копируют их содержимое для обучения или генерации ответов. Системы многих занимающихся ИИ компаний попросту игнорируют robots.txt или маскируются под поисковые роботы, чтобы обходить ограничения. Cloudflare занимается защитой около 20 % ресурсов интернета, и у компании есть возможность отслеживать эти процессы в больших масштабах. Поэтому она представила «Политику сигналов о контенте» (Content Signals Policy) — это новый способ для владельцев сайтов установить, разрешают ли он ИИ работать со своими материалами. Основу новой политики составляют новые инструкции robots.txt. Доступны три варианта:

Источник изображения: Steve Johnson / unsplash.com Каждая из этих инструкций может принимать значения «yes» (да) или «no» (нет). То есть владелец сайта может разрешить показывать его контент в результатах поиска, но запретить обучение ИИ на этих материалах. Cloudflare уже развернула эту функцию для более чем 3,8 млн доменов. По умолчанию для поиска установлено положительное значение, для использования материалов в ответах ИИ — отрицательное, а для обучения — никакого, чтобы владелец сайта принимал это решение сам. Cloudflare фиксирует установки этих директив как юридически значимые, то есть их можно будет использовать в судебных разбирательствах с разработчиками ИИ. Если большинство разработчиков ИИ начнёт соблюдать эти директивы, в интернете де-факто установится новый стандарт — в противном случае грозит возникнуть конфликт с блокировками и мерами юридического характера. Проблемным игроком может оказаться Google, чей Googlebot используется и для индексирования сайтов, и для функций ИИ, поэтому у владельцев сайтов нет возможности отказаться от поддерживаемых технологическим гигантом решений, не потеряв позиций в поисковой выдаче. Пока же регулирование сегмента ИИ остаётся чрезвычайно отрывочным. Генератор видео OpenAI Sora 2, как оказалось, способен полностью воссоздавать миссии из игры Cyberpunk 2077, хотя едва ли компании давали разрешение на использование этого контента. То же касается таких персонажей как Марио и Пикачу, хотя Nintendo нечасто вступает в конфликты с крупными игроками. Cloudflare же теперь тестирует функцию «платы за сканирование» — владельцы сайтов смогут брать деньги за доступ ботов к ресурсам. При попытке бесплатного доступа система выведет ошибку 402 — «Требуется оплата» (Payment Required). Геймер собрал внутри Minecraft рабочий ChatGPT — на это ушло 439 млн блоков

29.09.2025 [23:37],

Николай Хижняк

Игра Minecraft представляет собой «песочницу», ограниченную только вашим воображением и творческими способностями, что в полной мере демонстрируется в видео от YouTube-блогера sammyuri. Используя механику материала редстоун из оригинальной версии Minecraft, геймер сумел создать функциональную небольшую языковую модель ИИ, работающую внутри игры.

Источник изображений: YouTube / sammyuri Если вы видели предыдущие примеры экстремальной инженерии в Minecraft, то наверняка знакомы с работами sammyuri. Его последний проект, получивший название CraftGPT, занимает объём 1020 × 260 × 1656 блоков (439 млн). Он настолько большой, что для его демонстрации в видео понадобился мод District Horizons. Небольшая языковая модель имеет 5 087 280 параметров и была обучена на Python с помощью набора данных TinyChat. По данным некоторых пользователей, отметившихся в комментариях к видео, языковая модель CraftGPT примерно в 23 раза меньше модели GPT-1 и примерно в 175 тыс. раз меньше модели GPT-3. Несмотря на заявленные характеристики, sammyuri советует смягчить ожидания от CraftGPT: модель часто может отклоняться от темы и выдавать грамматически неверные ответы или просто ответы, не соответствующие запросу. Кроме того, CraftGPT — очень медленная модель. Даже несмотря на использование высокопроизводительного сервера Minecraft Redstone для увеличения тикрейта в 40 000 раз, CraftGPT может генерировать ответ примерно за два часа. Без увеличения тикрейта ждать ответа пришлось бы более 10 лет. Те, кто хочет попробовать CraftGPT, могут скачать все необходимые файлы на GitHub. Sammyuri рекомендует использовать ПК с объёмом ОЗУ не менее 32 Гбайт, в идеале — 64 Гбайт. На GitHub также есть инструкции по настройке и несколько полезных советов по максимально эффективному использованию небольшой языковой модели. Браузер Brave обновил фирменный ИИ-поиск: теперь он даёт развёрнутые ответы

29.09.2025 [20:59],

Анжелла Марина

Компания Brave обновила в своём браузере ИИ-поиск, добавив функцию Ask Brave, которая будет предоставлять развёрнутые ответы на основе пользовательских запросов. Ask Brave дополнит существующий режим AI Answers, запущенный в прошлом году для кратких резюме, и будет работать параллельно с ним.

Источник изображений: Brave Новый режим, по данным TechCrunch, не потребует переключения в специальный интерфейс, так как поисковая система автоматически определяет тип запроса и формирует соответствующий ответ. Пользователи могут инициировать такой поиск с помощью кнопки «Спросить» (Ask) рядом со строкой поиска Brave, перейти в этот режим через вкладку на странице результатов или добавить к запросу двойной вопросительный знак, если Brave Search установлен в качестве поисковика по умолчанию.  Как отметили в компании, в отличие от режима AI Answers, дающего краткие сводки, Ask Brave предлагает более длинные ответы, возможность задавать уточняющие вопросы и чат-режим с функцией Deep Research, а также контекстно релевантные дополнения в виде видео, новостных материалов, товаров, информации о компаниях, предложений для шопинга и других полезных данных.  По словам руководителя поискового отдела Brave Хосепа Пухоля (Josep M. Pujol), в компании ожидают, что при помощи новой функции можно будет генерировать дополнительные ответы, исчисляемые миллионами в день, благодаря мощной комбинации ИИ-поиска и крупных языковых моделей (LLM). При этом формат ответов в Ask Brave напоминает ответы ChatGPT или Perplexity: он включает ссылки, видео и изображения, а после получения ответа пользователь может преобразовать его в другой формат или задать уточняющие вопросы. Для обеспечения точности Brave использует собственный API и глубокое исследование для определённых запросов. Примечательно, что компания также заявляет о своём конкурентном преимуществе в области конфиденциальности. В частности, Brave утверждает, что шифрует все пользовательские чаты и удаляет их после 24 часов неактивности. В ChatGPT появился полный родительский контроль после трагической гибели подростка из США

29.09.2025 [18:37],

Анжелла Марина

Компания OpenAI объявила о внедрении системы родительского контроля в десктопные и мобильные версии ChatGPT после судебного иска родителей подростка из Калифорнии, который, по их утверждениям, покончил с собой после общения с искусственным интеллектом (ИИ), сообщает Reuters.

Источник изображения: Emiliano Vittoriosi/Unsplash Новые меры, анонсированные компанией, позволят гибко настраивать уровень безопасности и конфиденциальности для несовершеннолетних пользователей. Согласно заявлению OpenAI, родители получат возможность ограничивать доступ подростков к чувствительному контенту, управлять функцией запоминания истории переписок и решать, могут ли диалоги использоваться для дообучения моделей компании. Кроме того, появится возможность устанавливать «режим тишины», в течение которого доступ к сервису будет заблокирован, а также отключать голосовой режим и функцию генерации и редактирования изображений. При этом OpenAI подчёркивает, что родители не смогут получить непосредственный доступ к переписке подростка. В редких случаях, когда автоматические системы и модераторы обнаружат признаки серьёзной угрозы безопасности, родителям может быть передана только та информация, которая необходима для оказания поддержки подростку. Данный шаг происходит на фоне ужесточения контроля со стороны американских регуляторов за компаниями, работающими в сфере искусственного интеллекта, из-за потенциального негативного влияния чат-ботов. ИИ-аватар позволяет пообщаться с покойным создателем комиксов о человеке-пауке и героях Marvel

28.09.2025 [06:55],

Алексей Разин

Стэн Ли (Stan Lee), создатель серии комиксов о человеке-пауке и героях вселенной Marvel, ушёл из жизни в 2018 году в возрасте 95 лет, но накопленные при его жизни интервью и публикации позволили обучить искусственный интеллект для создания голографического аватара, способного общаться с посетителями Comic Con.

Стэн Ли, на фото второй слева. Источник изображения: The Real Stan Lee Это регулярное мероприятие в Лос-Анджелесе Стэн Ли любил посещать при жизни, поэтому организаторы в текущем году приложили усилия для возрождения возможности посетителей пообщаться с легендой индустрии, задействовав современные технологии. Специальное оборудование создаёт голографическое изображение Стэна Ли в полный рост, которое обладает правдоподобной мимикой и жестикуляцией, а главное — позволяет давать связные и развёрнутые ответы на вопросы посетителей. Это технологическое решение по реинкарнации деятелей культуры организаторы Comic Con демонстрировали в особом «уголке Стэна Ли», если так можно выразиться. По словам создателей аватара, на его подготовку к демонстрации публике ушло несколько лет с привлечением различных сторон: «Мы хотели создать что-то, способное стать частью поддержки и расширения наследия Стэна, в качестве признательности ему за всё созданное». Для обеспечения информационной поддержки виртуального двойника Стэна Ли использовалась специализированная большая языковая модель, которая сконцентрирована только на обсуждении его творчества. Например, если спросить аватар о политике или спорте, он не станет отвечать на данные темы. За право пообщаться с аватаром Стэна Ли посетители Comic Con должны заплатить $15, но в эту сумму входит и посещение импровизированного музея. Разработчики интерактивного дисплея Proto, который позволяет воссоздавать полномасштабное изображение человека, предлагают также использовать его в музеях, учебных заведениях и даже в процессе переговоров в режиме видеоконференции. Устройство позволяет сформировать ощущение присутствия собеседника, который находится далеко. Даже в телемедицине найдётся применение, поскольку пациент может физически демонстрировать проблемные части тела специалистам, находящимся на значительном удалении. Apple разработала аналог ChatGPT — приложение Veritas для iPhone, но никому его не показывает

27.09.2025 [06:11],

Алексей Разин

Как стало известно специализирующемуся на подобной информации Марку Гурману (Mark Gurman) из Bloomberg, компания Apple разработала приложение Veritas, которое призвано подготовить грядущее обновление Siri в следующем году. Пока оно используется внутри компании для тестирования новых функций голосового ассистента, связанных с работой с персональными данными и действиями внутри других приложений.

Источник изображения: Apple По данным источника, обновлённый ассистент Siri должен дебютировать в марте следующего года, и от успешности этого события будет зависеть способность Apple осуществить реванш в сфере ИИ, а в случае неудачи она ещё сильнее отстанет от соперников в сегменте смартфонов. Сейчас Veritas используется сотрудниками Apple для оценки его способности искать информацию внутри персональных данных пользователя типа почтовых сообщений или подборок музыки, а также выполнять операции внутри приложений типа редактирования фото. В переводе с латыни название приложения означает «истину». У Apple нет планов открывать доступ к этому приложению рядовым пользователям. По сути, оно нужно для адаптации прогресса, которого компания добилась в области совершенствования Siri, к возможности его тестирования среди сотрудников компании. Она также пытается оценить, есть ли смысл сохранять формат взаимодействия в виде чат-бота. После многочисленных задержек продвинутая версия Siri, способная работать с ИИ на новом качественном уровне, теперь должна дебютировать в марте следующего года. Считается, что к тому моменту для покупателей наличие ИИ-функций уже станет решающим фактором при выборе смартфона, и Apple старается не увеличивать своё отставание от конкурентов в этой сфере. Изначально обновлённая версия Siri должна была выйти весной этого года, но некоторые функции работали нестабильно, в результате было принято решение основательно её переработать. Тестирующее приложение Veritas напоминает самые популярные чат-боты, позволяя пользователю вести несколько бесед на самые разные темы. Оно запоминает предыдущие сеансы и может отсылать к ним, а также возобновлять прерванное общение. Главное предназначение Veritas — испытать платформу Linwood, которую Apple намерена использовать для создания новой версии Siri. Эта платформа использует большие языковые модели как собственной разработки, так и сторонние. К концу следующего года Apple также готовится обновить визуализацию своего голосового ассистента. Устройства для умного дома Apple также получат новые функции, связанные с ИИ. В этом году Apple пыталась договориться с OpenAI и Anthropic об использовании их разработок, но позже переключилась на взаимодействие с Google, которое подразумевало бы использование адаптированной версии Gemini для нужд Apple. Отсрочки с обновлением Siri вызвали не только изменения в стратегии компании, но и заметные кадровые перестановки в рядах профильных руководителей и специалистов. В идеале, Veritas должно позволить Apple подготовиться к конкуренции с ChatGPT и Perplexity, но в пределах интерфейса Siri. В новой версии он будет анализировать информацию, отображаемую пользователю на дисплее, а также поддерживать сквозную навигацию между несколькими пользовательскими устройствами. «А кто спрашивает?», — точность ответов DeepSeek зависит от региона пользователя

18.09.2025 [23:03],

Анжелла Марина

Американская компания CrowdStrike, являющаяся мировым лидером в области кибербезопасности, провела эксперимент, в ходе которого выяснила, что качество генерируемого кода сильно зависит от того, кто его собирается использовать и в каких случаях. Например, запрос написать программу для управления промышленными системами содержал ошибки в 22,8 % случаев, а при указании, что этот код предназначен для использования на Тайване, доля ошибок выросла до 42,1 % или был получен полный отказ в генерации.

Источник изображения: AI Качество кода ухудшалось, если он предназначался для Тибета, Тайваня или религиозной группы Фалуньгун✴, которая запрещена в Китае, пишет TechSpot со ссылкой на The Washington Post. В частности, для Фалуньгун✴ DeepSeek отказывался генерировать код в 45 % случаев. По мнению специалистов CrowdStrike, это может быть связано с тем, что ИИ-бот следует политической линии Коммунистической партии Китая, сознательно генерируя уязвимый код для определённых групп, либо с тем, что обучающие данные для некоторых регионов, таких как Тибет, содержат код низкого качества, созданный менее опытными программистами. Также высказывается альтернативное мнение относительно того, что система могла самостоятельно принять решение генерировать некорректный код для регионов, ассоциируемых с оппозицией. При этом исследователи CrowdStrike отметили, что код, предназначенный для США, оказался наиболее надёжным, что может быть связано как с качеством обучающих данных, так и с желанием DeepSeek завоевать американский рынок. Ранее 3DNews сообщал, что DeepSeek часто воспроизводит официальную позицию китайских властей по чувствительным темам, независимо от её достоверности, а в июле немецкие власти потребовали от Google и Apple запретить к установке на устройства приложение компании в Германии из-за подозрений в незаконной передаче данных пользователей в Китай. Отметим, использование данного приложения также запрещено на устройствах федеральных агентств и государственных учреждений США. Reddit готовит новый контракт с Google по интеграции с ИИ-сервисами

18.09.2025 [07:03],

Алексей Разин

С учётом необходимости обучения больших языковых моделей, данные в наши дни становятся ценным товаром. Платформа Reddit готовит своё второе по счёту соглашение с Google, которое позволит последней использовать данные, публикуемые на страницах первой.

Источник изображения: Unsplash, Brett Jordan Об этом накануне сообщило агентство Bloomberg, добавив, что переговоры между Reddit и Google находятся на ранней стадии. Более полутора лет назад компании уже заключали подобное соглашение на сумму $60 млн, но теперь речь идёт о более глубокой интеграции с ИИ-сервисами Google. В рамках нового соглашения Reddit надеется привлечь на свои страницы новых пользователей через трафик Google. В свою очередь, появление нового контента позволит Google более продуктивно обучать свои языковые модели. Помимо Google, руководство Reddit ведёт переговоры и с OpenAI, пытаясь заключить с обеими соглашение, по условиям которого сможет извлекать материальную выгоду с учётом динамического ценообразования. В частности, если данные со страниц Reddit начинают активнее использоваться для ответов, генерируемых искусственным интеллектом, компания претендует на получение более высоких доходов. Платформа пытается найти более эффективную бизнес-модель взаимодействия с разработчиками систем генеративного искусственного интеллекта. В январе 2024 года, как напоминает Bloomberg, компания Reddit заключила несколько лицензионных соглашений, включая и сделки с OpenAI и Google, которые позволяли её рассчитывать на получение выручки в размере $203 млн в течение ближайших двух или трёх лет. Содержимое страниц Reddit активно используется системами искусственного интеллекта для анализа информации на самые разные темы, нередко ссылки на Reddit выдаются чат-ботами в составе ответов на запросы пользователей. Создателям систем ИИ приходится всё чаще заключать лицензионные соглашения с обладателями больших массивов данных, чтобы избежать судебных претензий в области авторского права. OpenAI, например, пришлось заключить ряд соглашений в этой сфере с крупными издательствами. Reddit выдвинула судебные претензии к компании Anthropic, и последней пришлось в отдельном случае согласиться выплатить группе авторов $1,5 млрд компенсации за неправомерное использование их произведений. Reddit является одним из наиболее часто цитируемых источников информации в системах ИИ. При этом пользователи ИИ-сервисов Google не так часто становятся активными пользователями Reddit, поэтому последняя из платформ ищет альтернативные способы монетизации данного взаимодействия. Новое соглашение между компаниями призвано усилить взаимную интеграцию сервисов. OpenAI готовит детскую версию ChatGPT и будет автоматически сортировать пользователей по возрасту

16.09.2025 [20:33],

Сергей Сурабекянц

Компания OpenAI разрабатывает «детский интерфейс ChatGPT» и планирует использовать технологию предсказания возраста, чтобы лишить детей и подростков младше 18 лет доступа к стандартной версии. Компания подчеркнула — если её инструменты не смогут уверенно определить возраст человека, ChatGPT «из предосторожности» будет использовать версию для лиц младше 18 лет. Также OpenAI считает, что любые пользователи ChatGPT должны быть старше 13 лет.

Источник изображения: unsplash.com Результаты последних исследований в области взаимоотношений людей и искусственного интеллекта вызывают нешуточную тревогу по поводу рисков продолжительного общения с чат-ботами для психического здоровья подростков. Недавно OpenAI объявила о масштабной инициативе по установлению новых ограничений для подростков и людей, находящихся в состоянии эмоционального стресса. Компания планирует внедрить эту функцию к концу года. «Мы ставим безопасность выше конфиденциальности и свободы подростков; это новая и мощная технология, и мы считаем, что несовершеннолетним необходима значительная защита, — заявил глава OpenAI Сэм Альтман (Sam Altman). — Некоторые наши принципы противоречат друг другу, и мы хотели бы разъяснить решения, которые мы принимаем в связи с конфликтом между безопасностью, свободой и конфиденциальностью подростков».

Источник изображения: OpenAI Forum Новый детский интерфейс ChatGPT возлагает большую часть ответственности на родителей и опекунов. Родителям понадобится связать свои учётные записи с учётными записями подростков, отправив ребёнку приглашение. После этого они смогут ограничить реакцию ChatGPT на подростков с помощью встроенных правил, соответствующих возрасту. Родители смогут отключать или включать определённые функции, включая память и историю чатов. Включив соответствующую функцию, они будут получать уведомления, если «система обнаружит, что их подросток находится в состоянии острого стресса». OpenAI позволит родителям устанавливать часы отключения, когда подросток не может использовать ChatGPT. Заявление OpenAI сделано всего за несколько часов до слушаний в Вашингтоне, посвящённых потенциальному вреду чат-ботов на основе искусственного интеллекта. На этих слушаниях группа сенаторов намерена изучить риски для подростков, связанные с чат-ботами. Независимо от этого, на прошлой неделе Федеральная торговая комиссия (FTC) начала собственное расследование безопасности чат-ботов, запросив информацию у OpenAI, Meta✴, Google, xAI, Snap и Character.AI. Технологические компании, как правило, в ответ на судебные иски создают специализированные приложения для подростков и детей — например, YouTube Kids. Но самым большим препятствием для использования подобных приложений является необходимость убедить подростков связать свои аккаунты с родительским.

Источник изображения: unsplash.com OpenAI давно заявляет, что все пользователи ChatGPT должны быть не моложе 13 лет. Сообразительные молодые люди часто значительно лучше разбираются в информационных технологиях, чем их родители и опекуны. Для них не составит труда найти обходные пути, чтобы получить доступ к нужным сайтам и приложениям. «Британская энциклопедия» подала в суд на Perplexity за копирование текстов

12.09.2025 [23:01],

Анжелла Марина

«Британская энциклопедия» (Encyclopedia Britannica) и её дочерняя компания Merriam-Webster подали иск в федеральный суд Нью-Йорка против компании Perplexity AI, обвинив её в нарушении авторских прав и товарных знаков. В иске обе компании утверждают, что система ответов Perplexity копирует их веб-сайты, крадёт интернет-трафик и занимается плагиатом их материалов, защищённых авторским правом.

Источник изображения: Perplexity Суть иска заключается в одном слове: «плагиат». Сетевой журнал The Verge ссылается на судебные документы, в которых представлены сравнительные скриншоты, демонстрирующие, что ответы Perplexity идентичны определениям из словаря Merriam-Webster. Также система выдаёт неполные или придуманные искусственным интеллектом ответы, используя имена данных компаний, имеющих многовековую историю деятельности. Perplexity, позиционирующая себя как конкурента Google Search, ранее уже подвергалась нападкам за то, что якобы «неправомерно заимствует и перерабатывает оригинальный контент без надлежащих ссылок», а также применяет веб-скрапинг, нелегально обходя систему блокировок сайтов от роботов. В частности, претензии были предъявлены со стороны таких медиа-гигантов, как Forbes, The New York Times, BBC, News Corp — материнской компании The Wall Street Journal и New York Post. Тем не менее, некоторые издания, включая Time и Los Angeles Times, участвуют в программе совместного распределения рекламных доходов с Perplexity, а World History Encyclopedia, ещё одна крупная энциклопедия, запустила 8 сентября чат-бота на базе технологии Perplexity, позволяющего пользователям исследовать её базу академических источников. Власти США начали расследование безопасности ИИ-чат-ботов для детей: под прицелом Google, Meta✴, OpenAI и xAI

11.09.2025 [23:48],

Анжелла Марина

Федеральная торговая комиссия США (FTC) инициировала расследование в отношении семи крупных технологических компаний, включая Alphabet, Meta✴, OpenAI, xAI и Snap, с целью выяснения, может ли их искусственный интеллект (ИИ) негативно влиять на детей и подростков. Регулятор издал приказы, обязывающие эти компании предоставить подробную информацию о мерах безопасности, применяемых к их чат-ботам, которые способны имитировать человеческое общение и межличностные отношения.

Источник изображения: Emiliano Vittoriosi/Unsplash Регулятор направил компаниям предписания с требованием раскрыть подробности о мерах безопасности, применяемых к чат-ботам, способным имитировать человеческое общение и межличностные отношения. В частности, FTC интересуется, как компании оценивают риски, связанные с ИИ-компаньонами, каким образом они монетизируют вовлечённость пользователей, разрабатывают и утверждают виртуальных персонажей, используют или передают личные данные, а также какие механизмы контроля и снижения возможного вреда применяют. Глава FTC Эндрю Фергюсон (Andrew Ferguson) подчеркнул, что защита детей в интернете остаётся для ведомства ключевым приоритетом наряду с поддержкой инноваций в критически важных секторах экономики. Реакция компаний оказалась разной. Meta✴ отказалась от комментариев для CNBC, а Alphabet, Snap и xAI пока не ответили на запросы. Представитель OpenAI заявил в интервью CNBC, что приоритетом компании является обеспечение одновременно полезности и безопасности ChatGPT для всех пользователей, особенно для молодых, и что OpenAI готова к открытому сотрудничеству с регулятором. В список проверяемых также вошли Character Technologies (создатель чат-бота Character.ai) и принадлежащий Meta✴ Instagram✴. Повышенное внимание FTC к этой теме связано с недавними инцидентами. Так, после расследования Reuters сенатор Джош Хоули (Josh Hawley) инициировал проверку в отношении Meta✴: репортаж показал, что её чат-боты могли вести опасные беседы с детьми. В ответ Meta✴ временно ужесточила правила для своих ИИ, запретив обсуждение тем, связанных с суицидом, членовредительством и расстройствами пищевого поведения, а также ограничив «чувственные» диалоги. Аналогичные меры предпринимает и OpenAI: компания объявила о пересмотре работы ChatGPT после иска семьи, обвинившей чат-бота в косвенной причастности к смерти подростка. Конкурент ChatGPT от Apple может появиться раньше, чем все ожидали

08.09.2025 [01:08],

Анжелла Марина

Компания Apple готовит к выпуску собственный генеративный ИИ-движок для поиска и генерации ответов, который может дебютировать уже через шесть месяцев в составе обновлённой версии Siri. По сообщению 9to5Mac со ссылкой на Марка Гурмана (Mark Gurman) из Bloomberg, новый инструмент, известный внутри компании под кодовым названием World Knowledge Answers (WKA), создаётся как конкурент Perplexity и ChatGPT.

Источник изображения: сгенерировано AI Первоначально функция будет доступна исключительно через переработанный интерфейс Siri, а в дальнейшем может быть интегрирована в браузер Safari и поисковую систему Spotlight. При этом внутри Apple продолжается тестирование технологии искусственного интеллекта (ИИ), в ходе которого выяснится, будут ли в основе нового поколения Siri использоваться собственные ИИ-алгоритмы компании или же технологии от внешних партнёров — таких как Google, Anthropic или OpenAI. Несмотря на то, что разработка продукта началась лишь несколько месяцев назад, выбор партнёров не повлияет на сроки запуска нового Siri на собственном движке WKA, что, вероятно, произойдёт в марте 2026 года. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |