|

Опрос

|

реклама

Быстрый переход

Голливудские студии перенаправили монетизацию фейковых трейлеров на YouTube себе в карман

31.03.2025 [16:59],

Дмитрий Федоров

Крупные голливудские студии, включая Warner Bros. Discovery, Paramount и Sony Pictures, приняли решение не пресекать распространение видеороликов, созданных с помощью генеративного ИИ и опубликованных на YouTube, несмотря на наличие признаков нарушения авторских прав. Вместо подачи жалоб на удаление такого контента студии потребовали от видеохостинга перенаправить рекламную выручку с этих видео в свою пользу, фактически узаконив присутствие несанкционированного контента на площадке.

Источник изображения: Allison Saeng / Unsplash Гильдия киноактеров и Американская федерация артистов телевидения и радио (SAG-AFTRA) осудила действия студий, подчеркнув, что видео используют цифровые образы актёров без их согласия. Это происходит на фоне усилий гильдии, добивающейся включения положений об использовании ИИ в договоры. Видео представляют собой пример эксплуатации внешности и голоса актёров без правового основания, что нарушает как этические нормы, так и интересы членов объединения. Контент YouTube-каналов Screen Culture и KH Studio включает фальшивые трейлеры, которые имитируют анонсы новых фильмов или продолжений популярных франшиз. Screen Culture насчитывает 1,4 млн подписчиков и около 1,4 млрд просмотров. KH Studio имеет 683 тысячи подписчиков и более 560 млн просмотров. Видеоролики строятся по типовой схеме: монтаж реальных фрагментов из существующих фильмов и сериалов дополняется кадрами, сгенерированными ИИ. Некоторые видео создаются на основе реальных фильмов, чьи официальные трейлеры уже доступны, например «Супермен» (Superman) и «Мир Юрского периода: Возрождение» (Jurassic World: Rebirth), тогда как другие полностью вымышлены.

Источник изображения: YouTube / Screen Culture Через два дня после публикации расследования изданием Deadline, YouTube прекратил монетизацию обоих каналов. Согласно официальной позиции платформы, упомянутые YouTube-каналы были удалены из партнёрской программы за нарушение политики монетизации. Правила YouTube запрещают создавать дублирующий или повторяющийся контент, а также видео, сделанные исключительно ради получения просмотров. Авторы обязаны вносить значительные изменения в заимствованные материалы и избегать публикации контента, способного ввести зрителя в заблуждение. Согласно политике YouTube в отношении дезинформации, авторам запрещено публиковать видео, которые могут быть восприняты как официальные, если они таковыми не являются. В случае с этими YouTube-каналами, поддельные трейлеры были оформлены таким образом, что зрители могли принять их за реальную продукцию киностудий. Оба канала могут обжаловать приостановку рекламных отчислений. После блокировки партнёрской программы KH Studio изменил заголовки последних трёх видео, указав в них термин «concept trailer» вместо ранее использовавшегося «first trailer». В своём заявлении SAG-AFTRA сообщила, что рассчитывает на активные действия со стороны студий по защите прав своих участников. Организация подчеркнула, что монетизация несанкционированного, нежелательного и низкокачественного использования интеллектуальной собственности подрывает индустрию. По мнению гильдии, подобная практика стимулирует краткосрочные интересы технологических компаний в ущерб системной защите результатов человеческого труда. Платным пользователям YouTube разрешили делиться видео без рекламы с другими, но не всем

28.03.2025 [11:32],

Владимир Мироненко

Google запустила в порядке ограниченного эксперимента новую функцию для подписчиков платного сервиса YouTube Premium, которая позволяет им делиться с другими пользователями до 10 видеороликов без рекламы в месяц, при условии, что те живут в регионе, где доступен YouTube Premium.

Источник изображения: Sara Kurfeß Их друзья, не являющиеся подписчиками Premium, смогут использовать эти ссылки для просмотра контента без рекламы, как и платные пользователи. При нажатии кнопки «Поделиться» на YouTube для участников эксперимента будет доступна опция «Поделиться без рекламы». Каждый месяц они могут генерировать ссылку для 10 видео, которые их друзья смогут просматривать без рекламы до 10 раз. При этом, если пользователь случайно поделится одной из этих ссылок с кем-то, у которого уже есть подписка Premium, просмотр видео не будет засчитан в лимит. Также неважно, делитесь ли вы видео с одним или несколькими людьми, так как эти 10 просмотров без рекламы делятся между всеми получателями. Следует отметить, что участники эксперимента смогут делиться почти всеми видео, за исключением музыкального контента, YouTube Originals, Shorts, прямых трансляций и фильмов, а также шоу. В настоящее время Google тестирует новую функцию в Аргентине, Бразилии, Канаде, Мексике, Турции и Великобритании, причём она доступна лишь для небольшого количества подписчиков Premium. МТС объявила о закрытии своего заменителя YouTube и TikTok

20.03.2025 [11:25],

Дмитрий Федоров

МТС объявила о закрытии видеохостинга Nuum, запущенного в декабре 2023 года в качестве альтернативы YouTube и TikTok. Проект прекратит работу 1 июня 2025 года. Инвестиции в платформу составили 6 млрд рублей, однако аудитория, достигнув 5,2 млн пользователей в апреле 2024 года, к февралю 2025 года сократилась до 901,5 тыс. Пользователям сервиса предложено выгрузить свои материалы до указанной даты.

Источник изображения: nuum.ru Вся технологическая инфраструктура Nuum будет передана подразделению МТС AdTech, которое занимается разработкой рекламных решений для цифровых платформ. Согласно заявлению компании, технологии видеохостинга будут адаптированы для создания рекламной сети видеобаннеров, ориентированной на маркетплейсы и классифайды. Видеоформаты, используемые в Nuum, планируется интегрировать в рекламные механики, схожие с форматами «сторис» и «рилзов», что позволит брендам использовать интерактивные видеоролики для продвижения товаров и услуг. Компания МТС уточнила, что часть команды разработчиков Nuum, насчитывающая несколько десятков специалистов, будет переведена в медиабизнес мобильного оператора. Разработанные технологии видеостриминга, изначально внедренные в Nuum, будут использованы для расширения функциональности онлайн-кинотеатра Kion. Интеграция наработок Nuum позволит улучшить систему видеопотоков и повысить эффективность дистрибуции медиаконтента на платформе. Nuum позиционировался как экспериментальный проект МТС, ориентированный на молодежную аудиторию. К апрелю 2024 года месячная аудитория платформы составила 5,2 млн уникальных пользователей, а число авторов контента достигло 40 тыс. Основной целевой аудиторией стали мужчины в возрасте 18–24 лет. Однако в феврале 2025 года, по данным Mediascope, активная месячная аудитория пользователей старше 12 лет сократилась до 901,5 тыс. человек, а ежедневная — до 71 тыс. В сравнении с TikTok, который в тот же период имел 68,7 млн месячных пользователей и 35,1 млн активных пользователей в день, видеохостинг МТС не смог закрепиться на рынке. С начала 2025 года в Nuum начался процесс реструктуризации. В первые месяцы года команду покинули до 80 % сотрудников. Вскоре после этого свой пост оставила генеральный директор проекта Наталья Братчикова, а руководство площадкой передали Алексею Куликову, ранее отвечавшему за финансовое управление развлекательными сервисами в компании МТС. Источники на медиарынке сообщали, что Куликов был назначен с целью организованного закрытия платформы. В середине марта 2025 года Nuum прекратил работу партнёрской программы, отключил функции подписок и донатов и приостановил сотрудничество с рекламодателями. После 2022 года российский рынок цифровых платформ претерпел значительные изменения. Ограничения, наложенные на TikTok, блокировка Facebook✴ и Instagram✴ и снижение скорости работы YouTube привели к увеличению популярности отечественных соцсетей и видеохостингов. В декабре 2024 года, по данным Mediascope, «ВКонтакте» впервые обогнала YouTube по месячному охвату, достигнув 92 млн пользователей. Однако не все платформы смогли адаптироваться к изменениям. Запущенные ранее «ЯRUS »и «Панч» объявили о закрытии в 2023 и 2024 годах соответственно, что подтверждает высокую сложность создания новых успешных видеоплатформ в России. Эксперты медиарынка отмечают, что ключевыми факторами закрытия Nuum стали низкая вовлеченность аудитории, ограниченное количество контента и отсутствие конкурентных механизмов монетизации. По мнению главы агентства TelecomDaily Дениса Кускова, российские альтернативы глобальным видеосервисам сталкиваются с серьёзными барьерами роста. Чтобы выйти на самоокупаемость, платформа должна привлекать массовую аудиторию, что требует значительных затрат на маркетинг. По оценкам аналитиков, затраты МТС на поддержание инфраструктуры Nuum не превышали 500 млн рублей в год, но маркетинговые расходы могли достигать 1 млрд рублей и более. Однако даже таких вложений оказалось недостаточно для удержания аудитории. YouTube резко замедлился по всему миру

20.03.2025 [10:53],

Владимир Мироненко

Уже несколько дней подряд поступают жалобы от пользователей YouTube на значительное снижение качества изображения во время просмотра видеоконтента, которое по умолчанию имеет низкое разрешение — 144p или 360p — даже при высокой скорости интернета. При попытке вручную переключить показатель разрешения на 1080p или выше запускается постоянная буферизация видео, что не способствует комфортному просмотру.

Источник изображения: Alexander Shatov/unsplash.com Судя по публикациям жалоб на таких платформах, как Reddit, проблема сильнее всего затронула пользователей iOS-устройств, десктопов и смарт-телевизоров. На смартфонах и планшетах под управлением Android никаких проблем с работой YouTube не наблюдается. «Даже когда я вручную выбираю разрешение 720p, на что моё соединение полностью способно и всегда поддерживалось, показатель не поднимается выше 144p. Это невозможно смотреть», — написал в своём сообщении один из пользователей сообщества Reddit. Впрочем, YouTube не отрицает существование проблемы и работает над её устранением. «Мы знаем, что некоторые из вас сталкиваются с более низким, чем обычно, качеством видео при попытке просмотра медиаконтента на площадке. Будьте уверены, мы активно изучаем это! Мы поделимся с вами новой информацией, как только она станет доступна. Спасибо за ваше терпение!» — сообщается на странице поддержки видеосервиса. Grok научится создавать видео: xAI поглотила разработчика ИИ-генератора видео Hotshot

17.03.2025 [22:57],

Владимир Фетисов

Принадлежащая американскому бизнесмену Илону Маску (Elon Musk) компания xAI стала владельцем стартапа Hotshot, который работает над созданием инструментов на базе искусственного интеллекта, предназначенных для генерации видео. О завершении сделки в своём аккаунте в соцсети X заявил Аакаш Састри (Aakash Sastry), соучредитель и генеральный директор Hotshot.

Источник изображений: xAI «За последние два года мы небольшой командой создали три модели для генерации видео — Hotshot-XL, Hotshot Act One и Hotshot. Процесс обучения этих моделей помог нам понять, как в ближайшие годы будут меняться глобальные сферы образования, развлечения, общения и производительности. Мы рады продолжить масштабирование усилий в крупнейшем в мире кластере Colossus, как часть xAI», — сказано в сообщении Састри. Компания Hotshot была основана несколько лет назад в Сан-Франциско. Изначально стартап занимался разработкой ИИ-инструментов для генерации и редактирования изображений, но со временем переориентировался на модели искусственного интеллекта, позволяющие генерировать видео на основе текстовых подсказок. Ранее Hotshot удалось привлечь внимание инвесторов, но размер вложенных в стартап средств никогда не озвучивался публично. Переход Hotshot под контроль xAI может помочь стартапу в создании ИИ-моделей для генерации видео, которые станут конкурентами аналогов, таких как Sora от OpenAI или Veo 2 от Google. Ранее Маск намекал, что xAI работает над созданием инструментов генерации видео, которые в будущем планируется интегрировать с чат-ботом Grok. В начале этого года бизнесмен заявлял, что ожидает появление модели «Grok Video через несколько месяцев». Rutube похвастался 5 млрд просмотров видео в месяц — до YouTube ещё далеко

26.02.2025 [18:40],

Сергей Сурабекянц

Генеральный продюсер видеохостинга Rutube Давид Кочаров сообщил, что количество ежемесячных просмотров видео на платформе превысило 5 млрд. По его данным, 71 % всех просмотров приходится на пользовательский контент, причём за 2024 год число создателей контента выросло в 2,4 раза.

Источник изображения: Rutube По словам Кочарова, самыми популярными категориями на видеосервисе оказались «мультфильмы и блоги, ориентированные на детей, далее — видеоигры и аниме, затем — путешествия». После начала замедления YouTube в России площадка Rutube продемонстрировал впечатляющий рост аудитории — уже к сентябрю 2024 года количество ежедневных посетителей сервиса достигло 10 млн человек. Согласно информации аналитической компании WhoIsBlogger, аудитория «VK Видео» на первое место поставила категорию «Юмор», за которым следуют «Искусство», «Кино», «Еда» и «Семья». В то же время доля юмористических роликов в общем количестве просмотров коротких видео от российских блогеров на платформе «VK Клипы» в 2024 году сократилась до 24,1 %. Отметим, что, по представленным сегодня данным YouTube, только подкасты на сервисе ежемесячно слушают 1 миллиард человек. На начало января 2025 года ежемесячная мировая аудитория YouTube составляла 2,5 млрд человек, в число которых вошли 93 млн россиян. Что касается просмотров, то по состоянию на январь прошлого года пользователи просматривали на YouTube 1 млрд часов видео каждый день. Alibaba снова ударила по OpenAI — вышел бесплатный ИИ-генератор реалистичных видео Wan 2.1

26.02.2025 [13:25],

Павел Котов

Китайский гигант в области электронной коммерции Alibaba сделал общедоступной разработанную им модель искусственного интеллекта для создания видео и статических изображений Wan 2.1. Этим шагом компания создала условия для её массового развёртывания и способствовала усилению конкуренции в области ИИ.

Источник изображения: Alibaba Публикация ИИ-моделей с открытым исходным кодом — распространённый шаг в отрасли ИИ; одним из наиболее заметных игроков здесь стал стартап DeepSeek. Alibaba выпустила четыре варианта Wan 2.1: T2V-1.3B, T2V-14B, I2V-14B-720P и I2V-14B-480P — эти модели генерируют видео и статические картинки по текстовому запросу или по образцу, которым может служить изображение. Обозначения «1.3B» и «14B» указывают, что эти варианты содержат соответственно 1,3 млрд и 14 млрд параметров. Младшей модели T2V-1.3B для работы требуется всего 8,19 Гбайт видеопамяти, что делает её совместимой со многими потребительскими видеокартами. Разработчики заявляют, что эта модель может сгенерировать пятисекундный ролик в 480р на GeForce RTX 4090 примерно за 4 минуты (без оптимизаций). Модели доступны для пользователей по всему миру на платформах HuggingFace и ModelScope (входит в Alibaba Cloud) для академических, исследовательских и коммерческих целей. Последнюю версию модели ИИ для генерации видео Alibaba представила в январе — первоначально она называлась Wanx, впоследствии её переименовали в Wan. Проект получил высокую оценку в тестах Vbench, предназначенных для генераторов видео — в частности, она стала лидером по критерию взаимодействия объектов. Накануне Alibaba также выпустила предварительный вариант рассуждающей модели QwQ-Max, которая впоследствии также будет опубликована как проект с открытым кодом. В ближайшие три года компания намеревается вложить не менее 380 млрд юаней ($52 млрд) в поддержку облачных вычислений и инфраструктуры ИИ. Google раскрыла цену генерации видео в Veo 2 — в 64 000 раз дешевле «Мстителей»

24.02.2025 [14:44],

Владимир Фетисов

Компания Google без лишнего шума раскрыла стоимость использования своей новой генеративной нейросети Veo 2, которая предназначена для создания видео и была впервые анонсирована в декабре. Стоимость генерации видео с помощью ИИ-алгоритма составит $0,5 за секунду.

Источник изображения: Google Это означает, что минута сгенерированного с помощью Veo 2 видео будет стоить $30, а за час придётся заплатить $1800. В подразделении Google DeepMind, занимающемся разработками в сфере искусственного интеллекта, эти цифры сравнили с блокбастером Marvel «Мстители: Финал», производственный бюджет которого составил $356 млн, т.е. примерно $32 000 за секунду видео. Конечно, пользователи Veo 2 не обязательно будут использовать каждую секунду сгенерированного алгоритмом видео, за которую они заплатят. Кроме того, в обозримом будущем нейросеть вряд ли сможет создать что-то подобное блокбастерам Marvel. В сообщении Google сказано, что алгоритм может генерировать видео продолжительностью более двух минут. Отметим, что OpenAI недавно сделала доступным свой ИИ-генератор видео Sora для подписчиков ChatGPT Pro, которые платят $200 в месяц. Apple улучшит камеру iPhone 17 Pro с упором на видеосъёмку

23.02.2025 [21:29],

Владимир Фетисов

По сообщениям сетевых источников, компания Apple уделит больше внимания улучшению видеосъёмки в новых смартфонах iPhone 17 Pro и iPhone 17 Pro Max, запуск которых должен состояться осенью этого года. Ранее вендор делал ставку на фотосъёмку, но теперь это должно измениться, считает журналист Bloomberg Марк Гурман (Mark Gurman).

Источник изображения: Apple В течение многих лет Apple добивалась, чтобы iPhone заменил фотоаппарат, для чего в каждом поколении смартфонов компания стремится предложить лучшую в отрасли систему мобильных камер. Следующим шагом станет улучшение возможностей видеосъёмки. Хотя в этом iPhone всегда был достаточно хорош, Apple хочет поднять съёмку видео на новый уровень. По данным Гурмана, одна из целей Apple на текущий год заключается в привлечении к работе с iPhone влогеров и других авторов контента. «Одна из целей линейки iPhone 2025 года — заставить сообщество влогеров и других создателей видео отойти от автономных камер и использоваться iPhone в своих работах ещё больше. Ожидайте, что Apple ещё активнее, чем когда-либо, будет рекламировать возможности видеозаписи, когда в сентябре дебютируют новые iPhone», — говорится в сообщении Гурмана. При этом журналист не уточнил, как именно Apple может улучшить возможности видеозаписи в iPhone 17 Pro. Вероятно, больше информации об этом станет известно по мере приближения запуска новых iPhone. Meta✴ очистит Facebook✴ от записей прямых трансляций — теперь они будут удаляться через 30 дней

19.02.2025 [13:37],

Владимир Мироненко

Meta✴ внесла изменения в порядок хранения на платформе Facebook✴ прямых трансляций пользователей — теперь они будут удаляться через 30 дней после размещения. Начиная с 19 февраля, пользователи, выходящие в прямой эфир, должны будут загрузить видео, чтобы оно не было удалено по истечении 30-дневного срока.

Источник изображения: Christin Hume/unsplash.com Пользователи смогут делиться записями в своём профиле Reels, однако при этом они должны соответствовать 90-секундному лимиту этого раздела соцсети Instagram✴. В Meta✴ объяснили изменения тем, что «большинство просмотров прямых трансляций происходит в течение первых нескольких недель после их проведения», а также желанием «привести политику хранения в соответствие со стандартами отрасли и гарантировать предоставление самых актуальных прямых трансляций для всех пользователей Facebook✴». Сообщается, что все ранее записанные прямые трансляции, размещённые более 30 дней назад, также будут удалены. Перед окончательным удалением архива пользователям будут отправлены уведомления по электронной почте и в приложении. После получения уведомления у них будет 90 дней, чтобы загрузить или перенести видео. Ожидается, что старые записи трансляций будут удаляться «волнами» в течение нескольких месяцев. Facebook✴ также предложила пользователям несколько инструментов для загрузки видео — как по отдельности, так и всех сразу. Получив уведомление, пользователь сможет запросить массовую загрузку всех видео, опубликованных в указанные даты, или перенести их напрямую в облачный сервис, например, Dropbox или «Google Диск». VK похвасталась, что приложение «VK Видео» скачали 60 млн раз

17.02.2025 [16:58],

Владимир Фетисов

С момента официального запуска приложения «VK Видео» для мобильных устройств на базе Android и iOS, а также телевизоров с Android TV в сентябре 2023 года его скачали 60 млн раз. Сообщение об этом появилось на официальном сайте компании.

Источник изображения: «VK Видео» На долю пользователей Android-устройств пришлось 35 млн установок, тогда как доли Android TV и iOS составили 15,4 млн и 9 млн установок соответственно. В пиковый месяц количество загрузок «VK Видео» на устройства разного типа составило 8,4 млн раз. В сообщении VK сказано, что за год суммарное время просмотра в приложении «VK Видео» увеличилось в 23 раза. Наибольшее время просмотра из всех платформа приходится на Smart TV — в январе этот показатель был равен 221 минуте на пользователя, что на 50 % больше аналогичного показателя годом ранее. Суточный рекорд просмотров на платформе достиг отметки в 3,3 млрд минут. В компании одной из главных причин увеличения количества установок «VK Видео» назвали рост объёма оригинального контента, публикуемого на платформе. Кроме того, положительную динамику поддерживают развитие инструментов и программ для авторов контента, а также крупные рекламные кампании, направленные на увеличение узнаваемости сервиса и его особенностей. Однако невозможно не заметить, что бурный рост видеоплатформы VK начался с лета прошлого года после начала замедления YouTube в России. Oppo опубликовала распаковку складного, но лёгкого Find N5 в преддверии анонса

14.02.2025 [13:16],

Павел Котов

Oppo обещает официально представить складной смартфон Find N5 20 февраля, а пока ограничивается тем, что раскрывает некоторые подробности об устройстве. Уже известно, что толщина корпуса оказалась минимальной для габаритов порта USB Type-C, а гибкий дисплей почти лишён складки по центру. Теперь компания сообщила, что телефон ещё и чрезвычайно лёгкий.

Источник изображения: Oppo Ранее Oppo заявила, что Find N5 станет самым тонким складным смартфоном в мире — его толщина в сложенном виде составит всего 8,93 мм. Свои слова компания подтвердила собственным видео с распаковкой устройства, из которого выяснилось, что телефон не только рекордно тонкий, но и очень лёгкий. Масса Oppo Find N5 составляет 229 г. Это значит, что он всего на 2 грамма тяжелее, чем Apple iPhone 16 Pro Max, который не является складным. И при этом он на 3 грамма легче, чем Samsung Galaxy S24 Ultra. В комплекте со складным смартфонов поставляется чехол — по крайней мере, для китайских покупателей. Сам Oppo Find N5 будет доступен в белом, тёмно-сером и сиреневом цветах. По неподтверждённой информации, модель Oppo Find N5 впоследствии выйдет также под названием OnePlus Open 2. Смартфон работает на чипе Qualcomm Snapdragon 8 Elite, а его корпус имеет защиту по стандартам IPX6, IPX8 и IPX9. В YouTube появился ИИ-генератор полноценных роликов по текстовому описанию — их можно будет публиковать в Shorts

13.02.2025 [22:57],

Владимир Фетисов

На платформе YouTube появилась новая функция на основе искусственного интеллекта. Она предназначена для генерации небольших роликов, которые пользователи могут публиковать в Shorts. Речь идёт об инструменте YouTube Dream Screen, который построен на базе Google Veo 2. Эта функция и раньше позволяла генерировать ролики на основе текстового описания, но прежде пользователи могли лишь задействовать их в качестве фона.

Источник изображения: Copilot Теперь же созданные с помощью Dream Screen видео можно публиковать в своём аккаунте в Shorts. Чтобы опробовать новые возможности пользователю нужно активировать камеру в Shorts, запустить функцию Dream Screen, открыть панель выбора медиафайлов и нажать на кнопку «Создать». После этого можно ввести текстовое описание будущего ролика, а также выбрать один из доступных стилей, объективов, кинематографических эффектов и указать продолжительность видео. По словам представителей YouTube, возможность публиковать сгенерированные ИИ ролики в Shorts на этой неделе появится у пользователей платформы из США, Канады, Австралии и Новой Зеландии. Позднее она также станет доступна в других странах, но более точные сроки озвучены не были. Это обновление стало несколько неожиданным, учитывая, что последняя версия нейросети Google Veo всё ещё находится в раннем доступе. По данным YouTube, интеграция нейросети с функцией Dream Screen позволит быстрее генерировать более «детальные и реалистичные» видео с учётом физики реального мира и естественных движений людей. При этом созданные с помощью ИИ видео будут помечаться, как видимыми визуальными метками, так и невидимыми водяными знаками Google SynthID, указывающими на то, что ролик создан или изменён с помощью нейросети. Topaz Labs представила диффузную ИИ-модель, которая автоматически улучшает старые видео

07.02.2025 [18:32],

Владимир Мироненко

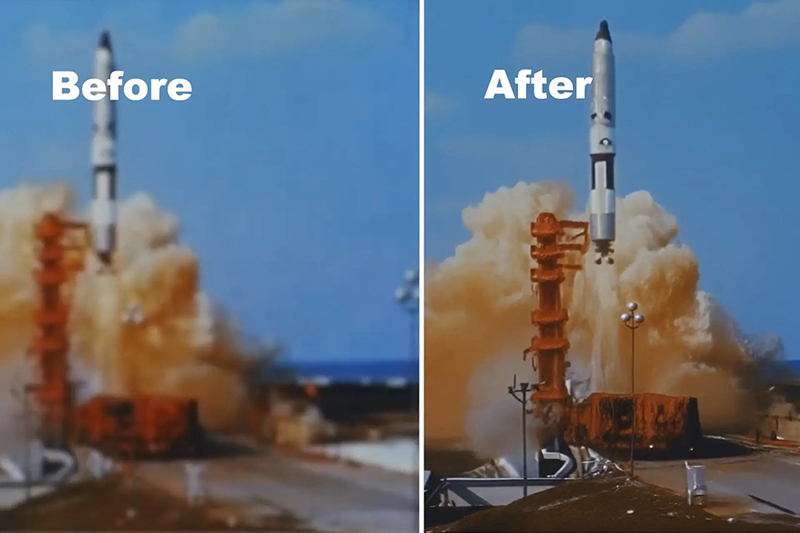

Компания Topaz Labs, специализирующая на разработке программного обеспечения для редактирования фотографий и видео, представила модель ИИ Project Starlight для повышения качества старых кадров из домашней видеоколлекции или архивного контента, качество которого могло со временем ухудшиться в ходе хранения на традиционных носителях.

Источник изображения: Topaz Labs По словам разработчика, это первая в истории диффузионная модель, созданная для этих целей, и ей не требуется ручной ввод данных для исправления видео. Сообщается, что Project Starlight была создана с нуля с использованием новой архитектуры модели с более чем 6 млрд параметров, и её работа поддерживается передовыми ускорителями NVIDIA. Для сравнения, вышедшая в мае 2024 года большая языковая модель GPT-4o от OpenAI с возможностью обработки текста, аудио, изображений и видео в качестве входных данных, изначально имела 8 млрд параметров. Topaz Labs утверждает, что модель «точно восстанавливает детали» и обеспечивает «непревзойдённое восстановление деталей в сочетании с непревзойдённой временной согласованностью». По словам компании, именно в этом и заключается суть её новой модели: улучшение нескольких кадров для достижения высококачественных результатов восстановления без артефактов движения или несоответствий между кадрами и объектами. Project Starlight также автоматически удаляет шумы, устраняет размытость, масштабирует и сглаживает кадры по запросу. Для работы с этой ИИ-моделью вовсе не требуется наличие специальных знаний в области обработки видео. Возвращение старого видео к жизни включает в себя несколько процессов, в том числе масштабирование, цветокоррекцию и сортировку, интерполяцию кадров, устранение повреждений и восстановление звука. Для каждого из этих вариантов восстановления уже созданы инструменты на базе ИИ, но для достижения наилучших результатов всем процессом в настоящее время должны управлять люди. Topaz Labs сообщила, что пользователи могут с помощью её ИИ-модели бесплатно восстанавливать видео длительностью до 10 с, в то время как клипы продолжительностью до 5 минут будут иметь максимальное разрешение 1080p и для этого потребуются кредиты. Версия для корпоративных пользователей поддерживает восстановление более продолжительных видео и с более высоким разрешением. Пока неизвестно, будет ли Project Starlight работать локально или будет интегрирована в другие приложения компании. ByteDance стёрла грань между дипфейком и реальностью — представлена ИИ-модель OmniHuman-1

05.02.2025 [18:52],

Сергей Сурабекянц

Китайский технологический гигант ByteDance, владелец платформы TikTok, сегодня продемонстрировал новую систему искусственного интеллекта OmniHuman-1, которая может создавать фейковые видео, практически неотличимые от реальности. Способность искусственного интеллекта генерировать deepfake-видео вызывает одновременно восторг и мистический ужас.

Источник изображения: techspot.com Видео, созданные OmniHuman-1, выглядят поразительно реалистично. Достаточно взглянуть на ролик ниже, демонстрирующий выступление спикера на популярной ежегодной конференции по распространению уникальных идей TED (technology, entertainment, design — технологии, развлечения, дизайн), которого в реальности не было. Системе OmniHuman-1 достаточно одной фотография и записи голоса, чтобы сгенерировать подобное видео. Пользователь может настраивать такие элементы, как соотношение сторон и кадрирование. Более того, ИИ способен изменять движения тела и жесты в реальных видеоматериалах. Конечно, результаты не всегда на 100 % безупречны. Некоторые позы выглядят немного необычно. Например, на этой лекции Эйнштейна, полностью сгенерированной ИИ, лицо выглядит практически идеально, но движения рук — неестественно. OmniHuman-1 «просмотрела» 18 700 часов видеоданных с использованием нового подхода «omni-conditions», который позволяет модели обучаться на нескольких источниках входных данных, таких как текстовые подсказки, аудио и позы тела одновременно. Исследователи ByteDance говорят, что подобный метод обучения помогает ИИ «значительно сократить потери данных». Возможные применения технологии deepfake вызывают нешуточное беспокойство. За последнее время она уже не раз использовалась для дезинформации, мошенничества и других нечистоплотных целей. Так, в ходе избирательной кампании 2024 года в США было зафиксировано множество случаев распространения аудио- и видеозаписей с дипфейками для введения избирателей в заблуждение. В прошлом году финансовые мошенничества лишали людей миллиардов. Например, мошеннику, использовавшему ИИ, чтобы выдать себя за актёра Брэда Питта (Brad Pitt), удалось обманом убедить женщину развестись с мужем и отправить ему $850 000 якобы на лечение. В настоящее время сотни экспертов по этике ИИ выступают за регулирование дипфейков. Возможно, что ByteDance не стоит давать доступ к OmniHuman-1 широкой публике, так как это может привести к катастрофическим последствиям. Хотя джинна уже выпустили из бутылки и процесс внедрения ИИ во все сферы жизни, в том числе криминальную, уже не остановить. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |