|

Опрос

|

реклама

Быстрый переход

Zotac опровергла информацию о начале производства видеокарты GeForce RTX 5090

21.10.2024 [22:48],

Николай Хижняк

Компания Zotac опубликовала официальное опровержение появившихся в Сети слухов о начале сборки и тестирования видеокарт GeForce RTX 5090. Ранее профильные СМИ, в том числе и наш сайт, со ссылкой на опубликованное в китайской социальной сети Bilibili видео заявили, что Zotac произвела и приступила к тестированию первой видеокарты GeForce RTX 5090 из ожидаемой серии GeForce RTX 5000 от Nvidia.

Zotac Gaming GeForce RTX 4070 Ti Super Solid В официальном заявлении компании Zotac по этому поводу сообщается следующее: «За последние два дня мы заметили неточные предположения, циркулирующие относительно слухов о новой видеокарте, предположительно производимой Zotac. Мы хотели бы воспользоваться возможностью и предоставить разъяснение. Продукт, продемонстрированный в соответствующем видеоисточнике, на самом деле является существующим продуктом, в настоящее время находящимся в производстве, Он известен как Zotac Gaming GeForce RTX 4070 Ti Super Solid. Видео, которое стало вирусным в интернете, представляет собой запись процесса внутреннего обучения во время пробного производственного запуска на нашем предприятии в Индонезии, целью которого было проверить работоспособность недавно установленного производственного оборудования». Добавим, что для начала тестирования видеокарт нового поколения ещё слишком рано — по слухам, видеокарты представят только в январе. Россияне вернулись к просмотру длинных видео на YouTube — охват восстановился до уровня 2023 года

21.10.2024 [20:23],

Дмитрий Федоров

Аналитики WhoIsBlogger зафиксировали восстановление интереса к длинным видеороликам на YouTube в России, несмотря на замедление работы платформы. Охват таких видео практически вернулся к уровню 2023 года.

Источник изображения: Artapixel / Pixabay В рамках исследования, проведённого платформой для аналитики инфлюенс-маркетинга WhoIsBlogger, были проанализированы данные 48 000 YouTube-каналов. Результаты показали, что в период с 30 сентября по 6 октября 2024 года охват длинных видеороликов снизился всего на 0,8 % по сравнению с аналогичным периодом прошлого года. Однако стоит отметить, что с 18 по 24 августа 2024 года было зафиксировано значительное падение охватов длинных видео на 28 % в годовом выражении, что, вероятно, было связано с техническими ограничениями в работе видеохостинга в России. Тем не менее уже через несколько недель аудитория вновь начала возвращаться, что привело к восстановлению показателей. Интересно, что на фоне роста охватов длинных видеороликов короткие видео категории Shorts продолжают терять популярность среди россиян. 8 октября Всероссийский центр изучения общественного мнения (ВЦИОМ) представил данные, согласно которым платформа VK Видео обогнала YouTube по числу просмотров на смартфонах. По результатам исследования, наибольшую популярность у российских пользователей получили фильмы и сериалы — 56 %, за ними следуют новости — 53 %, а также юмористический и развлекательный контент — 51 %. VK выделит видеоблогерам гранты на 100 млн рублей для конкуренции с YouTube

15.10.2024 [11:58],

Владимир Фетисов

Холдинг VK намерен впервые запустить грантовую программу для блогеров, работающих с длинными видеоформатами. Об этом пишет РБК со ссылкой на пресс-службу и собственный источник в компании.

Источник изображения: «VK Видео» В сообщении сказано, что общий объём программы составит 100 млн рублей, а претендовать на получение выплат смогут блогеры со статусом индивидуального предпринимателя и наличием аудитории от 1 тыс. подписчиков. Претенденты должны создавать нерекламные горизонтальные видео продолжительностью от 10 минут. Предпочтение будет отдаваться видео с развлекательно-образовательным контентом в формате «how to» (как что-то сделать). Программа направлена на замещение YouTube, работа которого на территории России замедляется с середины лета. Количество получателей грантов и размер поддержки будет определяться членами координационного совета, в который, в том числе, войдут дизайнер Артемий Лебедев, блогер Влад А4, стилист Александр Рогов, продюсеры Вячеслав Дусмухаметов и Заир Юсупов, топ-менеджеры VK и др. В рамках реализации данного проекта авторы будут должны соблюдать определённые требования, в том числе по количеству публикуемых роликов, заявленному в проекте, и приросту подписчиков после его реализации. Глава агентства TelecomDaily Денис Кусков считает, что 100 млн рублей — это небольшая сумма для блогеров. Он также считает некорректным сопоставление «VK Видео» с YouTube даже в условиях блокировки второго. «YouTube — мировой проект с огромной библиотекой и различными системами рекомендаций, а «VK Видео» — это локальный сервис. Да, в текущих условиях он интересен блогерам из-за замедления западных платформ. Он хорошо развивается и демонстрирует многократный рост как по доле аудитории, так и по количеству контента. Но аудитория YouTube всё ещё недосягаема ни для одного российского сервиса», — отметил Денис Кусков. Adobe интегрировала ИИ-генератор видео Firefly Video Model в редактор Premiere Pro

15.10.2024 [00:37],

Владимир Фетисов

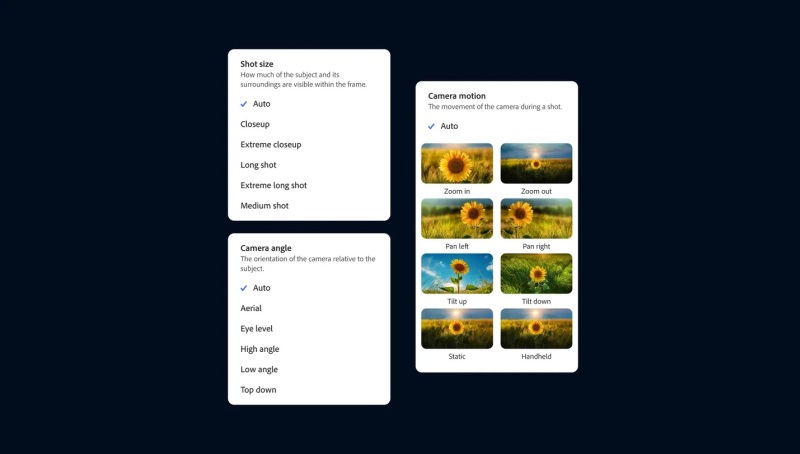

Компания Adobe официально представила новую генеративную нейросеть Firefly Video Model, которая предназначена для работы с видео и стала частью приложения Premiere Pro. С помощью этого инструмента пользователи смогут дополнять отснятый материал, а также создавать ролики на основе статичных изображений и текстовых подсказок.

Источник изображений: Adobe Функция Generative Extend на базе упомянутой нейросети в рамках бета-тестирования становится доступной пользователям Premiere Pro. Она позволит продлить видео на несколько секунд в начале, конце или каком-то другом отрезке ролика. Это может оказаться полезным, если в процессе монтажа нужно скорректировать мелкие недочёты, такие как смещение взгляда человека в кадре или лишние движения.  С помощью Generative Extend можно продлить ролик лишь на две секунды, поэтому он подходит только для внесения небольших изменений. Данный инструмент работает с разрешением 720p или 1080p с частотой 24 кадра в секунду. Функция также подходит для увеличения продолжительности аудио, но есть ограничения. Например, пользователь может продлить какой-либо звуковой эффект или окружающий шум до 10 секунд, но сделать это же с записями разговором или музыкальными композициями не удастся.  В веб-версии Firefly появились два новых инструмента генерации видео. Речь идёт о функциях Text-to-Video и Image-to-Video, которые, как можно понять из названия, позволяют создавать видео на основе текстовых подсказок и статических изображений. На данном этапе обе функции находятся на этапе ограниченного бета-тестирования, поэтому могут быть доступны не всем пользователям веб-версии Firefly. Text-to-Video работает аналогично другим ИИ-генераторам видео, таким как Sora от OpenAI. Пользователю нужно ввести текстовое описание желаемого результата и запустить процесс генерации ролика. Поддерживается имитация разных стилей, а сгенерированные ролики можно доработать с помощью набора «элементов управления камерой», которые позволяют имитировать такие вещи, как угол наклона камеры, движение и менять расстояние съёмки. Image-to-Video позволяет добавить к текстовому описанию статическое изображение, чтобы генерируемые ролики более точно соответствовали требованиям пользователя. Adobe предлагает использовать этот инструмент, в том числе, для пересъёмки отдельных фрагментов, генерируя новые видео на основе отдельных кадров из существующих роликов. Однако опубликованные примеры дают понять, что этот инструмент, по крайней мере на данном этапе, не позволит отказаться от пересъёмки, поскольку он не совсем точно воспроизводит все имеющиеся на изображении объекты. Ниже пример оригинального видео и ролика, сгенерированного на основе кадра из оригинала. Снимать длинные ролики с помощью этих инструментов не получится, по крайней мере на данном этапе. Функции Text-to-Video и Image-to-Video позволяют создавать видео продолжительностью 5 секунд в качестве 720p с частотой 24 кадра в секунду. Для сравнения, OpenAI утверждает, что её ИИ-генератор Sora может создавать видео длиной до минуты «при сохранении визуального качества и соблюдении подсказок пользователя». Однако этот алгоритм всё ещё недоступен широкому кругу пользователей, несмотря на то, что с момента его анонса прошло несколько месяцев. Для создания видео с помощью Text-to-Video, Image-to-Video и Generative Extend требуется около 90 секунд, но в Adobe сообщили о работе над «турборежимом» для сокращения времени генерации. В компании отметили, что созданные на основе Firefly Video Model инструменты «коммерчески безопасны», поскольку нейросеть обучается на контенте, который Adobe разрешено использовать. YouTube активно мешает переносу контента на RuTube и «VK Видео»

08.10.2024 [19:11],

Владимир Фетисов

Блогеры столкнулись с проблемами при переносе контента с YouTube на российские видеоплатформы RuTube и «VK Видео». Принадлежащий Google видеохостинг активно блокирует трафик в процессе переноса роликов на российские площадки. Об этом пишет «Коммерсантъ» со ссылкой на собственные источники в двух IT-компаниях. В целом, тут нет ничего удивительного — YouTube и прежде ограничивал массовое скачивание видео.

Источник изображения: Eyestetix / unsplash.com Из-за противодействия RuTube и «VK Видео» приходится использовать зарубежные VPN-сервисы для скачивания видео с YouTube. Напомним, RuTube запустил функцию переноса контента с YouTube в августе текущего года. Обычно процесс переноса занимал несколько часов, но в некоторых случаях — от двух до пяти дней. В «VK Видео» сервис переноса контента появился ещё в 2023 году. «Сам сервис блокирует этот процесс с российских и даже зарубежных IP-адресов. Обычно бан появляется в течение 12 часов», — подтвердил наличие проблемы представитель RuTube. Там также отметили, что команда сервиса делает всё возможное, чтобы у авторов сохранилась возможность беспрепятственной загрузки контента на платформу. По данным RuTube, блогеры продолжают пользоваться функцией переноса контента, но в некоторых случаях этот процесс занимает больше времени. В «VK Видео» отказались от комментариев по данному вопросу. Глава CDN Video Ярослав Городецкий подтвердил, что компании активно используют функцию переноса контента с YouTube. «Тут ситуация 50 на 50: компании либо уже находятся в процессе переноса, либо пока думают об этом. Никто не хочет видеть на своём сайте пустой видеоплеер», — добавил господин Городецкий. В последнее время YouTube начал блокировать подозрительную активность двумя способами. В случаях, когда просмотр или загрузка контента осуществляется с IP-адреса с плохой репутацией или без аккаунта Google, видеохостинг предлагает авторизоваться. Если же просмотр осуществляет авторизованный пользователь, но YouTube считает, что аккаунт используется для сбора информации, то сервис выдаёт сообщение «видео недоступно». Отмечается, что маловероятен расклад, при котором YouTube целенаправленно ограничивает именно перенос видео на российские сервисы — сервис просто ограничивает подозрительную активность. Отметим, что блокировки осуществляются в том числе для противодействия автоматическому сбору контента для обучения ИИ. Предзаказы PS5 Pro за 130 тысяч рублей «значительно» превзошли ожидания «М.Видео-Эльдорадо»

03.10.2024 [12:15],

Дмитрий Рудь

Открывшийся на прошлой неделе в сети «М.Видео-Эльдорадо» предзаказ PlayStation 5 Pro неприятно удивил российских потребителей ценой, однако значительно превзошёл ожидания торговой группы. Напомним, в магазинах «М.Видео» и «Эльдорадо» предзаказ PS5 Pro обойдётся покупателю в 129 999 рублей. Ретейлер даёт возможность оформить покупку в рассрочку на 24 месяца и предоставляет кешбэк в размере 30 %. Как сообщила «М.Видео-Эльдорадо» в новом пресс-релизе, объём предзаказов PS5 Pro за первую неделю втрое превзошёл внутренние прогнозы компании и составил 25 % от продаж базовой PS5. По словам главы департамента «Развитие игр и игрового сообщества» в «М.Видео-Эльдорадо» Сергея Мезина, с первого дня предзаказов PlayStation 5 Pro «результаты значительно превзошли наши ожидания». Среди основных факторов успеха Мезин выделил готовность ретейлера привезти консоль на склады уже в ноябре, а также упомянутые смягчающие обстоятельства в виде кешбэка и рассрочки на 24 месяца. Высокую стоимость PS5 Pro в своей торговой сети «М.Видео-Эльдорадо» объяснила сложившимися условиями: купить товар официально ретейлер не может. На цену также накладываются разные факторы (дефицит, спрос, курс доллара, пошлина, налоги). PS5 Pro выйдет 7 ноября и будет стоить $700/€800. Новая консоль значительно (на 45 %) превосходит PS5 по скорости рендеринга и в теории может предложить в играх более стабильную кадровую частоту при более высоком разрешении. Скидки не пахнут: провальная The Lord of the Rings: Gollum стала хитом продаж за неделю в «М.Видео», обогнав GTA V

02.10.2024 [21:33],

Дмитрий Рудь

Торговая сеть «М.Видео» поделилась информацией о самых продаваемых видеоиграх в своих магазинах за прошедшую неделю (то есть с 23 по 29 сентября). В лидеры рейтинга выбился неожиданный проект. Как стало известно, самой продаваемой игрой отчётного периода в «М.Видео» оказался приключенческий стелс-экшен The Lord of the Rings: Gollum от Daedalic Entertainment в версии для PlayStation 5. The Lord of the Rings: Gollum вышла в мае 2023 года и была разгромлена как прессой, и так простыми пользователями. Проект получился настолько неудачным, что вынудил Daedalic отказаться от дальнейшей разработки игр в принципе. Взобраться на вершину недельного рейтинга «М.Видео» провальной игре Daedalic помогла «царская» скидка — на момент публикации PS5-версия The Lord of the Rings: Gollum продаётся за 1499 рублей. В шаге от первого места остановился покоривший критиков платформер Astro Bot, а не теряющий популярности в российской рознице криминальный боевик Grand Theft Auto V замкнул лидирующую тройку. Что касается новинок, то на четвёртом месте дебютировал футбольный симулятор EA Sports FC 25 (мировой релиз состоялся 27 сентября). Лидер прошлой недели — боевик Warhammer 40,000: Space Marine 2 — опустился на десятую строчку. Стоит отметить, что в топ-10 доминируют игры для PS5 — они заняли девять из десяти позиций. Полный рейтинг выглядит следующим образом:

В «VK Видео» появился улучшенный видеоредактор — он умеет редактировать ролики после загрузки

01.10.2024 [19:43],

Сергей Сурабекянц

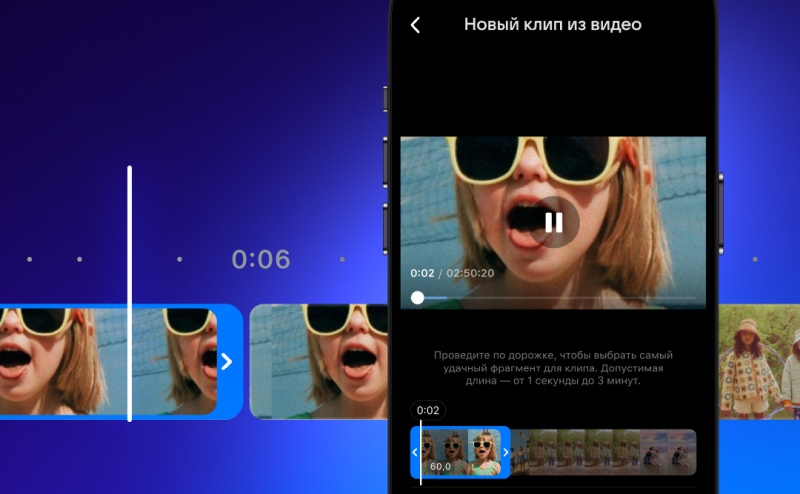

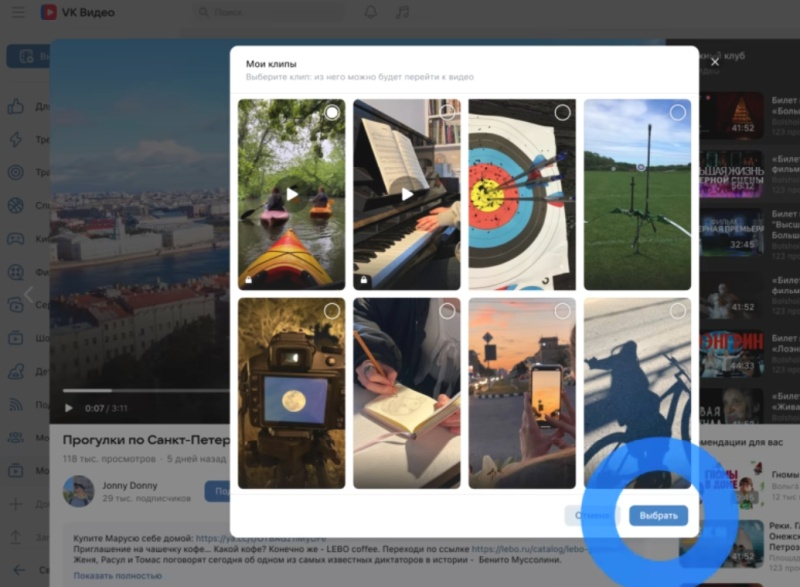

При помощи обновлённой версии видеоредактора в «VK Видео» создатели видеоконтента получили возможность редактировать ролики после загрузки, парой кликов создавать клипы из длинных видео, а также прикреплять клипы к длинным видео для продвижения основного контента. Расширение инструментов редактирования упрощает процесс работы и позволяет авторам поддерживать актуальность контента без дополнительных усилий.

Источник изображений: «VK Видео» В веб-версии «VK Видео» авторы теперь могут редактировать видео после добавления на канал — удаление и повторная загрузка ролика не требуется. Возможна обрезка видео в начале и конце и удаление ненужных фрагментов в любом месте видео. В первую очередь новая функция будет востребована для удаления рекламы после окончания договора. Редактирование видео не окажет влияния на количество просмотров, лайки и комментарии.

В мобильных приложениях «ВКонтакте» на iOS и Android появится кнопка «Создать клип», позволяющая выбрать из длинного видео эпизод для дальнейшего редактирования в специальном редакторе клипов. Клип можно обрезать, добавлять звуковое сопровождение и субтитры, а затем публиковать. Функция «Умная обрезка» умеет преобразовывать горизонтальное видео в вертикальный клип, автоматически выбирая самую интересную часть кадра.

Функция привязки клипов к длинным видео полезна для создания тизеров и продвижения основного контента. К длинному видео в режиме редактирования можно прикрепить до двадцати коротких роликов. Данная функция доступна как для опубликованного контента, так и для нового, что позволяет авторам улучшать взаимодействие с аудиторией.

iPhone 16 уже приехали в Россию — МТС похвасталась, что привезла их первыми, но в «М.Видео-Эльдорадо» не согласны

19.09.2024 [12:29],

Павел Котов

Группа «М.Видео-Эльдорадо» и розничная сеть оператора МТС сегодня практически одновременно представили в России iPhone 16 — за день до официального начала мировых продаж. Приём предварительных заказов на новые смартфоны Apple уже стартовал, а выдача товаров начнётся в ближайшие дни.

Источник изображения: apple.com Предзаказы на iPhone 16 в магазинах «М.Видео» и «Эльдорадо» принимаются с 10 сентября. Телефоны нового поколения оказались более востребованными у российских покупателей, чем прошлогодние модели. Только за первую неделю торговая сеть получила на 109 % больше предзаказов на базовый iPhone 16 со 128 Гбайт памяти, чем на iPhone 15 за тот же срок. Самый популярный цвет у этого варианта — «Ультрамарин»; число предзаказов на iPhone 16 с 256 Гбайт памяти выросло на 75 %. Число заказов на базовый iPhone 16 Pro выросло на 19 % по сравнению с аналогичной моделью прошлого года. А самым популярным iPhone 16 Pro Max стал вариант с 256 Гбайт памяти. Оператор МТС уже провёл презентацию iPhone 16, посетители которой получили возможность протестировать новые телефоны Apple и получить по ним консультации. Для оформления предварительного заказа розничная сеть оператора предлагает внести частичную или полную предоплату — не менее 25 000 руб. за базовый iPhone 16. Оставшуюся сумму необходимо внести при получении товара; в подарок обещан также кешбэк в размере 30 %. Выдача iPhone 16 по оформленным предзаказам в магазинах МТС, как ожидается, стартует уже в предстоящие выходные — до этого момента технические специалисты намереваются протестировать устройства и убедиться, что они корректно работают в сети оператора. В магазинах «М.Видео-Эльдорадо» выдача начнётся лишь на следующей неделе. Отметим, что у «М.Видео-Эльдорадо» телефон обойдётся дешевле, чем в розничной сети МТС: базовая модель iPhone 16 со 128 Гбайт памяти в магазинах электроники будет продаваться за 112 999 руб., тогда как у оператора она будет стоить 114 999 руб. Возглавляющий линейку iPhone 16 Pro Max с 1 Тбайт на встроенном накопителе в магазинах «М.Видео-Эльдорадо» обойдётся в 249 999 руб., а его покупателям в МТС придётся приготовить 254 990 руб. Блогеры на YouTube смогут группировать ролики по сезонам — так их будет удобней смотреть на телевизорах

18.09.2024 [23:47],

Владимир Фетисов

В рамках мероприятия Made on YouTube разработчики анонсировали ряд нововведений, которые в скором времени станут доступны пользователям видеохостинга. Помимо нескольких функций на основе искусственного интеллекта авторы контента на YouTube получат возможность разделения публикуемых видео на сезоны, чтобы пользователям было удобнее просматривать ролики на телевизорах.

Источник изображения: Mohamed Hassan / pixabay.com В компании отметили, что пользователи стали активнее просматривать видео с YouTube на своих телевизорах, поэтому разработчики решили оптимизировать интерфейс платформы, сделав его более похожим на Netflix и другие подобные платформы. В скором времени авторы контента смогут адаптировать свои ролики для зрителей, снабжая каждый эпизод полноценным описанием, а также разделяя общую массу роликов на сезоны для более удобной навигации. Представители YouTube не уточнили, как анонсированные нововведения будут интегрированы в интерфейс десктопного и мобильного приложений YouTube, но было упомянуто, что изменения затронут все платформы. Авторы контента получат и другие инструменты, ориентированные на создание контента для пользователей, которые взаимодействуют с платформой через телевизоры. Один из таких инструментов позволит публиковать и воспроизводить «иммерсивный контент». «VK Видео» запустила интерактивные ролики — пользователь сам решает, что будет дальше

12.09.2024 [10:40],

Павел Котов

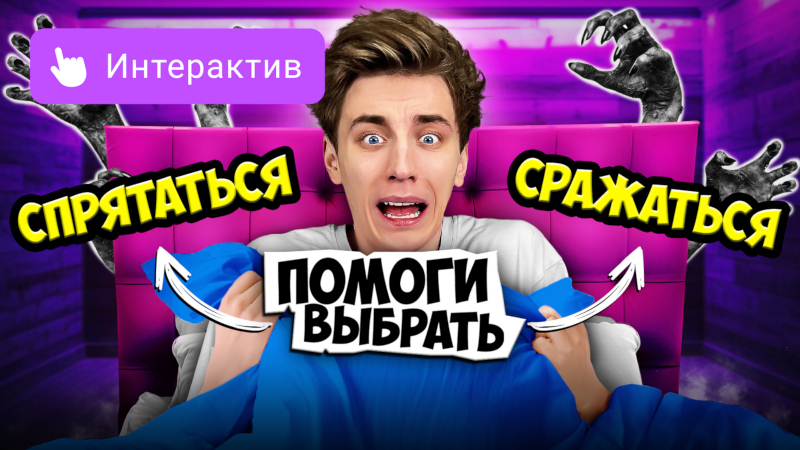

Платформа «VK Видео» сообщила, что первой в России открыла интерактивный контент — зрители получили возможность активно участвовать в развитии сюжета ролика, который теперь зависит от их действий. Создание интерактивных видео доступно для каждого — его ввели известные блогеры и авторы мультфильмов.

Источник изображений: VK На этапе запуска зрители «VK Видео» могут подключиться к 49 единицам интерактивных материалов с участием блогеров. К примеру, они оказываются внутри кошмарного сна одного из популярных авторов, которому помогут скрыться от монстров; в другом шоу зрители помогают блогерше собраться на важное мероприятие, подобрав наряд, макияж и выбрав место, куда она отправится.  Интерактив в «VK Видео» доступен и в мультфильмах — юные зрители сами выбирают повороты сюжета и отвечают на вопросы в историях с любимыми героями. Это «Азбука родного города» со Смешариками, «Доктор Машинкова», «Клуб „Вопросики“» и «Моя звёздочка». Платформа предложила детям не только развлекательный, но и развивающий контент.  Зрители участвуют в сюжете интерактивных видео, исследуют альтернативные сценарные линии и сами оказываются частью истории. Для этого нужно сделать выбор — в нужное время нажать на кнопки или выбрать области на экране. В зависимости от действий зрителя меняется сюжет, формируя новые варианты развития событий и открывая новые исходы. Продолжительность просмотра видео в поиске «Яндекса» выросла на 20 %

06.09.2024 [17:55],

Владимир Мироненко

В минувшем месяце интернет-пользователи затратили на просмотр контента в поиске по видео «Яндекса» на 20 % больше времени, чем в августе прошлого года. Такую статистику приводит информационное агентство ТАСС со ссылкой на пресс-службу компании.

Источник изображения: «Яндекс» Также пользователи стали чаще обращаться к сервису для поиска видео — на 25 % больше год к году увеличилось число поисковых сессий. При этом количество пользователей, воспользовавшихся сервисом как с компьютеров, так и с мобильных устройств, увеличилось на 20 процентов. В пресс-службе также отметили увеличение числа пользователей, которые осуществляют поиск в интернете с помощью виртуального помощника «Алисы» в умных устройствах «Яндекса» и на мультимедийной платформе YaOS. Виртуальный ассистент использует поиск по видео и отражает его результаты на дисплее телевизора или умной колонки. «Общее число пользователей поиска по видео в августе выросло на 12 % относительно такого же периода прошлого года. Аналитики “Яндекса” наблюдают дальнейший рост показателей сервиса, судя по данным за первые дни сентября 2024 года», — рассказали в пресс-службе компании. Компания ранее добавила в поиск по видео несколько инструментов, позволяющих упростить поиск нужного контента. В прошлом месяце в поиске появился детектор медленной загрузки, использующий алгоритмы для определения контента с более продолжительной, чем обычно, загрузкой, и предлагающий альтернативу с других площадок. Также теперь можно включить на сервисе фильтр, чтобы видеть в результатах поиска видео только с тех платформ, где нет проблем с загрузкой контента, или просто исключить из поисковой выдачи YouTube-ролики. При этом в результатах поиска сервис будет показывать выше тот контент, у которого нет проблем со скоростью загрузки. VK перешла на использование видеокодека AV1 в своих сервисах

05.09.2024 [12:59],

Анжелла Марина

VK объявила о внедрении видеокодека AV1 на своих платформах «VK Видео», «ВКонтакте» и «Одноклассники», став первой российской компанией, использующей эту технологию, сообщает Forbes. AV1 позволяет сжимать медиаданные до трёх раз лучше, чем H.264 — самый распространённый на сегодня видеокодек.

Источник изображения: VK AV1, разработанный в 2018 году и используемый такими компаниями, как YouTube, Google, Netflix, Microsoft, обеспечивает значительно более эффективное сжатие видео по сравнению с кодеком H.264, что позволяет существенно уменьшить размер файлов без потери качества. Например, 40-минутное шоу в разрешении 4K, закодированное с помощью AV1, будет занимать на диске всего 2 Гбайт, в то время как при использовании H.264 размер файла составил бы 6-8 Гбайт. AV1 является открытым стандартом, что особенно актуально в условиях санкций и ухода зарубежных IT-гигантов с российского рынка. «Наибольшей поддержкой индустрии сегодня пользуется именно AV1, практически все крупнейшие видеохостинги внедряют его. А по уровню сжатия AV1 превосходит платный HEVC», — комментирует Игорь Бедеров, руководитель департамента расследований T.Hunter и эксперт рынка НТИ SafeNet. По данным источников Forbes, стоимость перехода составила около 100 млн рублей. В VK рассказали, что основные инвестиции ушли в серверы, разработку, а также внедрение нового кодека. Переход на новый формат уже привёл к снижению нагрузки на кеширующие серверы и сети VK на 25-45 % и повышению плотности хранения контента на 30 %. Таким образом, компания оптимизировала свою инфраструктуру и повысила эффективность работы сервисов, что особенно актуально в условиях замедления работы YouTube. Стоит сказать, что внедрение AV1 в VK не является случайным и обусловлено не только текущей ситуацией на рынке, но и общими тенденциями развития отрасли. Отмечается, что с момента запуска приложения «VK Видео» в сентябре 2023 года его установили более 20 млн раз. Видеотрафик ресурсов VK с начала года вырос на 30 %, а просмотры развлекательных шоу в высоком разрешении «увеличились на порядок». По мнению экспертов, улучшение качества и доступности видео на платформах VK может привлечь новых пользователей, которые ищут альтернативу YouTube. MiniMax представила бесплатный ИИ-генератор video-1, который превращает текст в видео за 2 минуты

02.09.2024 [19:03],

Владимир Фетисов

Китайский стартап MiniMax, работающий в сфере искусственного интеллекта, представил алгоритм video-1, который генерирует небольшие видеоклипы на основе текстовых подсказок. Генератор video-1 был представлен широкой публике на прошедшей несколько дней назад в Шанхае первой конференции разработчиков компании, а позднее стал доступен всем желающим на веб-сайте MiniMax.

Источник изображения: scmp.com С помощью video-1 пользователь может на основе текстового описания создавать видеоролики продолжительностью до 6 секунд. Процесс создания такого ролика занимает около 2 минут. Основатель MiniMax Ян Цзюньцзе (Yan Junjie) рассказал на презентации, что video-1 является первой версией алгоритма генерации видео по текстовым подсказкам, отметив, что в будущем нейросеть сможет создавать ролики на основе статических изображений, а также позволит редактировать уже созданные клипы. Появление video-1 отражает стремление китайских технологических компаний продвинуться в зарождающемся сегменте рынка ИИ. Генератор видео был представлен всего через несколько месяцев после анонса нейросети Sora компании OpenAI, которая также позволяет создавать видео по текстовым подсказкам. Что касается MiniMax, то компания была основана в декабре 2021 года и с тех пор она проделала немалую работу. Новый инструмент video-1 предлагается в рамках платформы MiniMax под названием Hailuo AI, которая ориентирована на потребительский рынок и уже предоставляет доступ к функциям генерации текстов и музыки с помощью нейросетей. Помимо MiniMax, разработкой ИИ-алгоритмов для генерации видео из текста занимаются и другие китайские компании. Пекинский стартап Shengshu AI в июле запустил собственный генератор видео из текста на китайском или английском языках под названием Vidu. Стартап Zhipu AI стоимостью более $1 млрд в том же месяце представил свой аналог Sora, который может создавать небольшие видео на основе текстовых подсказок или статических изображений. Владелец TikTok и Douyin, компания ByteDance, в прошлом месяце опубликовала в китайском App Store приложение Jimeng text-to-video для генерации видео из текста, а ещё ранее оно появилось в местных магазинах Android-приложений. Jimeng позволяет создать бесплатно 80 изображений или 26 видео, а для более активного взаимодействия с нейросетью предлагается оформить подписку за 69 юаней (около $10). В прошлом месяце компания Alibaba Group Holding объявила о разработке алгоритма для генерации видео под названием Tora, основанного на модели OpenSora. Отметим, что среди инвесторов MiniMax есть крупные IT-компании, такие как Alibaba, Tencent Holdings и miHoYo (создатель Genshin Impact). Очередной раунд финансирования прошёл весной и после его завершения рыночная стоимость MiniMax оценивалась более чем в $2 млрд. VK собрала видеоконтент всех своих платформ в одном облаке на 1,5 млрд Гбайт

29.08.2024 [13:17],

Павел Котов

VK поместила видеоматериалы своих платформ «VK Видео», «Дзен» и «ОК.Видео» в единое облачное хранилище, говорится в пресс-релизе компании. Суммарный объём ресурса составил 1,5 Эбайт или 1,5 млрд Гбайт — он самый крупный среди всех российских платформ.

Источник изображения: ilgmyzin / unsplash.com Выбранный компанией режим one-cloud помогает защитить данные. При выходе отдельных хранилищ из строя данные, которые находятся в дата-центрах VK, восстанавливаются в автоматическом режиме и копируются на новые носители. При этом дублирование контента сведено к минимуму. «Если пользователи повторно загружают одно и то же видео на одну из платформ, то хранилище автоматически удаляет дубли», — рассказал технический директор «ВКонтакте» и «VK Видео» Сергей Ляджин. Потребность в таком механизме собственной разработки возникла из-за замедления доступа к YouTube в России, которое началось в августе. Этим летом на ресурсах VK пиковый объём загружаемого контента доходил до 1 Пбайт в день — материалы включают видео, опубликованные блогерами, прочий пользовательский контент, а также сериалы, мультфильмы и спортивные трансляции. Наконец, размещение всего видео в едином облачном пространстве способствует более эффективной настройке рекомендательных алгоритмов компании, «помогая авторам повышать охваты, а пользователям находить релевантный и интересный контент». |