|

Опрос

|

реклама

Быстрый переход

Intel XeSS 3 с мультикадровым генератором будет автоматически доступна в играх с поддержкой XeSS 2

10.10.2025 [18:53],

Николай Хижняк

Новый апскейлер Intel XeSS 3 будет поддерживаться всеми играми с поддержкой XeSS 2. Об этом рассказал заслуженный исследователь Intel Том Петерсен (Tom Petersen). Новая технология масштабирования будет включать мультикадровый генератор XeSS-MFG.

Источник изображений: Intel В рамках мероприятия Intel Tech Tour компания подтвердила, что игры с поддержкой XeSS 2 будут полностью совместимы с новой технологией XeSS 3. На данный момент XeSS 2 поддерживают 50 игр, а более 250 имеют поддержку XeSS 1 или 1.3. XeSS 3 будет выступать в качестве готовой замены, используя тот же API и не требуя никаких изменений от разработчиков. Технология XeSS 3 Multi-Frame Generation будет являться частью Intel Graphics Software и предложит несколько режимов генерации кадров (2x, 3x и 4x). Intel не предоставила детали сравнения работы разных режимов, но показала два примера в играх Painkiller (настройки «эпичные», разрешение 1080p) и Dying Light: The Beast (настройки «максимальные», разрешение 1080p), работающих с XeSS 3 MFG 4x и максимальным апскейлом на встроенной графике на базе графических ядер 12 ядер Xe3 в составе процессора Panther Lake с TDP 42 Вт. В первой игре технология обеспечила около 250 кадров в секунду, во второй — около 130. Метод мультикадровой генерации Intel очень похож на то, что делает Nvidia с её MFG в составе DLSS4. Технология создаёт несколько сгенерированных кадров на основе двух настоящих, что призвано повысить плавность игрового процесса. До недавнего времени у Intel не было собственной функции ИИ-генерации кадров, но теперь она может дать Intel преимущество перед AMD, которая до сих пор использует интерполяцию отдельных кадров и отстаёт от Nvidia в этой области. Intel пока не сообщила все детали о XeSS 3. Ожидается, что технология дебютирует в начале 2026, с выпуском процессоров Panther Lake. Голливудские агентства резко раскритиковали ИИ-генератор видео OpenAI Sora

10.10.2025 [11:45],

Владимир Фетисов

Агентство Creative Artist Agency присоединилось к тем, кто выступил с критикой в адрес OpenAI и её приложения для генерации видео Sora из-за нарушения авторских прав. В заявлении организации сказано, что упомянутый сервис представляет значительные риски для клиентов агентства и принадлежащей ему интеллектуальной собственности.

Источник изображения: OpenAI Creative Artist Agency, представляющее интересы большого количества звёздных актёров, таких как Скарлетт Йоханссон (Scarlett Johansson) и Том Хэнкс (Tom Hanks), поставило под сомнение, считает ли OpenAI, что «люди, писатели, художники, актёры, режиссёры, продюсеры, музыканты и спортсмены заслуживают вознаграждения и упоминания за работу, которую они делают». «Или OpenAI считает, что может просто украсть контент, пренебрегая глобальными принципами авторского права и нагло игнорируя права создателей, а также многих людей и компаний, которые финансируют производство, создание и публикацию работы этих людей? На наш взгляд, ответ на этот вопрос очевиден», — говорится в заявлении агентства. Вместе с этим в Creative Artist Agency заявили, что агентство открыто для предложений OpenAI, направленных на решение возникшей проблемы, продолжая взаимодействовать с лидерами в области интеллектуальной собственности, профсоюзами, законодателями и политиками. «Контроль, разрешение на использование и компенсация являются фундаментальными правами этих работников. Всё, что не подразумевает защиту создателей и их прав, неприемлемо», — сказано в заявлении агентства. На прошлой неделе OpenAI выпустила приложение для генерации видео Sora, которое доступно для устройств на базе iOS с некоторыми ограничениями. Несмотря на это, всего за несколько дней ИИ-генератор скачали более 1 млн раз, благодаря чему он возглавил рейтинг App Store. Приложение позволяет генерировать на основе текстового описания короткие ролики, в том числе с участием персонажей, защищённых законодательством об авторском праве, что и стало причиной бурной реакции со стороны компаний, чья интеллектуальная собственность незаконно используется в Sora. United Talent Agency также раскритиковало приложение OpenAI, заявив, что использование сервисом защищённого авторским правом контента является эксплуатацией, а не инновацией. «В нашем бизнесе нет замены человеческому таланту, и мы будем продолжать бороться за наших клиентов, чтобы обеспечить их защиту. Когда речь идёт о Sora от OpenAI или любой другой платформе, которая стремится извлечь выгоду из интеллектуальной собственности и имиджа наших клиентов, мы солидарны с авторами», — сказано в заявлении агентства. Ранее OpenAI заявила, что ввела ряд защитных мер, которые должны предотвратить возможность генерации роликов с защищёнными авторским правом персонажами. В дополнение к этому компания проводит проверку уже созданных в Sora видео на предмет поиска материалов, которые не соответствует обновлённой политике OpenAI. «Мы удаляем сгенерированных персонажей из публичной ленты Sora и готовим обновления, которые предоставят правообладателям больше контроля над их персонажами и тем, как поклонники могут их использовать», — сообщил представитель OpenAI. Другие представители киноиндустрии также выразили недовольство тем, что сервис Sora использует контент, защищённый авторским правом. В их число входят агентство по подбору персонала WME, Disney и др. Приложение OpenAI Sora скачали 1 млн раз менее чем за пять дней

09.10.2025 [20:19],

Владимир Фетисов

Выпушенное недавно приложение OpenAI Sora для ИИ-генерации видео скачали более 1 млн раз менее чем за пять дней. Об этом в своём аккаунте в социальной сети X написал руководитель команды Sora Билл Пиблз (Bill Peebles). Он отметил, что ИИ-генератор добился такого успеха даже быстрее ChatGPT, популярного ИИ-бота OpenAI, которым в настоящее время еженедельно пользуются более 800 млн человек по всему миру.

Источник изображения: OpenAI Ещё более впечатляющим достижение Sora делает то, что приложение доступно только на устройствах с операционной системой Apple iOS и для его загрузки требуется получить приглашение. Это означает, что для скачивания Sora нужно получить специальный код. Несмотря на эти ограничения, ИИ-генератор сумел занять первое место в рейтинге магазина цифрового контента Apple App Store. «Команда усердно работает, чтобы не отстать от стремительного роста», — написал Пиблз в одном из недавних постов в соцсети X. Запуск Sora сопровождался бурной реакцией со стороны общественности, в том числе в плане обсуждения того, что алгоритм может нарушать авторские права. На платформе можно найти множество роликов с защищёнными авторским правом персонажами, например, из мультфильмов «Губка Боб квадратные штаны», «Рик и Морти» и «Южный парк». Более того, пользователи могут сами генерировать подобные ролики. Ассоциация кинокомпаний, представляющая интересы телевизионной, кино- и видеоиндустрии заявила, что «ролики, нарушающие права на фильмы, шоу и персонажей членов ассоциации широко распространены на платформе OpenAI». Гендиректор Ассоциации кинокомпаний Чарльз Ривкин (Charles Rivkin) заявил, что «OpenAI должна предпринять незамедлительные и решительные действия для решения этой проблемы». Он добавил, что действующее законодательство об авторском праве защищает права авторов и вполне применимо в данном случае. Генеральный директор OpenAI Сэм Альтман (Sam Altman) заявил, что компания в скором времени предоставит правообладателям больше возможностей в плане контроля контента, защищённого авторским правом. Об этом он написал в блоге компании в конце прошлой недели. AMD, вероятно, решила одну из самых серьезных проблем с генерацией кадров

03.10.2025 [20:09],

Николай Хижняк

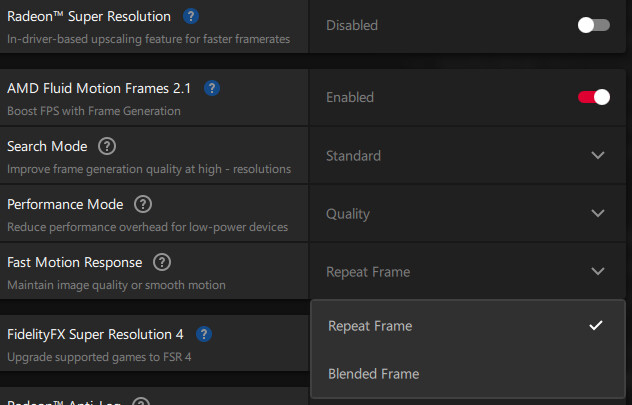

AMD работает над улучшением своей технологии генерации кадров AFMF (AMD Fluid Motion Frames). В предварительной версии драйвера PyTorch Preview Edition 25.120.01.14 для Windows была обнаружена новая функция под названием Fast Motion Response, недоступная в стандартных публичных версиях драйвера Adrenalin.

Источник изображения: Wccftech AMD Fluid Motion Frames — это функция генерации кадров на уровне драйвера, которую можно включить для каждой игры отдельно. Она не требует поддержки разработчиков игр и позволяет интерполировать дополнительные кадры, фактически удваивая частоту кадров в играх, которые в противном случае никогда бы не получили официальную поддержку генерации кадров. У функции есть свои недостатки, но она стала широко используемой, особенно в эмуляторах и на маломощных устройствах, таких как игровые портативные консоли. В стандартном драйвере AMD Adrenalin 25.9.2 функция AFMF 2 предлагает два переключателя: «Поиск» и «Производительность». Переключатель «Поиск» отдаёт приоритет качеству изображения и плавности для дисплеев с высоким разрешением (1440p и выше), а переключатель «Производительность» снижает программную нагрузку AFMF на менее производительном оборудовании — слабых настольных видеокартах и встроенной графике.

Источник изображения: AMD Новая настройка Fast Motion Response в AFMF 2 в составе предварительной версии драйвера PyTorch Preview Edition 25.120.01.14, призвана улучшить обработку динамичных сцен в играх, где технология генерации кадров может создавать артефакты. Функция предлагает два режима работы:

Текущая предварительная версия драйвера PyTorch Preview Edition 25.120.01.14 для Windows поддерживает только видеокарты Radeon RX 7000 и RX 9000. Скачать драйвер можно здесь. Tencent выпустила открытую ИИ-модель, которая создаёт целые 3D-миры по одному изображению

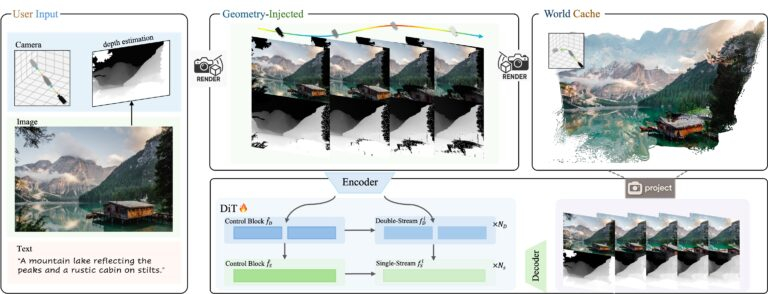

07.09.2025 [12:29],

Владимир Фетисов

На этой неделе китайская компания Tencent представила новую ИИ-модель с открытым исходным кодом HunyuanWorld-Voyager. С её помощью можно генерировать 3D-видеоряд из одного исходного изображения, управляя траекторией камеры для «изучения» виртуальных сцен. Алгоритм одновременно генерирует видео в формате RGB и информацию о глубине (RGB-D), что позволяет осуществлять 3D-реконструкцию без использования традиционных методов моделирования.

Источник изображений: Tencent На самом деле результаты работы HunyuanWorld-Voyager не являются настоящими 3D-моделями, но создаётся аналогичный эффект. ИИ-алгоритм генерирует 2D-видеокадры, которые сохраняют пространственную согласованность, как если бы камера перемещалась в реальном 3D-пространстве. В каждой генерации создаётся всего 49 кадров, т.е. примерно две секунды видео. По данным Tencent, несколько клипов могут быть объединены в последовательности продолжительностью «несколько минут». Объекты сохраняют своё положение, когда камера перемещается вокруг них, перспектива изменяется корректно, как если бы это происходило в реальной 3D-среде. Хотя результатом работы является видео с картами глубины, а не полноценные 3D-модели, эти данные можно преобразовывать в 3D-облака точек для дальнейшей реконструкции. Система работает на основе одного исходного изображения и заданной пользователем траектории камеры. Можно задать движение камеры вперёд, назад, влево, вправо или поворот, для чего предусмотрен интерфейс управления. Система объединяет данные об изображении и глубине с другими данными для формирования видеоряда, отражающего движение камеры, которое задал пользователь. Основным ограничением всех ИИ-моделей на базе архитектуры Transformer является то, что они в основном имитируют паттерны, найденные в данных для обучения, что ограничивает их возможности в плане «обобщения», т.е. применения этих шаблонов в новых ситуациях, которые не встречались при обучении. Для обучения HunyuanWorld-Voyager исследователи задействовали более 100 тыс. видеоклипов, включая компьютерные сцены на движке Unreal Engine. По сути они обучали ИИ-алгоритм имитировать движение 3D-камер в среде видеоигр. Большинство ИИ-генераторов, таких как Sora, создают выглядящие правдоподобно кадры друг за другом, не пытаясь отслеживать или поддерживать пространственную согласованность. В отличие от этого HunyuanWorld-Voyager обучен распознавать и воспроизводить закономерности пространственной согласованности, но с добавлением обратной геометрической связи. Когда он генерирует каждый кадр, осуществляется преобразование выходных данных в точечный 3D-объект, после чего эти точки проецируются обратно в 2D для использования в будущих кадрах. Такой подход заставляет ИИ-модель сопоставлять изученные ранее шаблоны с геометрически согласованными проекциями, полученными в процессе работы. Это обеспечивает гораздо лучшую пространственную согласованность, чем у других ИИ-генераторов видео. Однако в основе подхода всё же лежит сопоставление паттернов, основанное на геометрических ограничениях, а не полноценное «понимание» 3D. Это объясняет, почему ИИ-модель может сохранять согласованность в течение нескольких минут, но с трудом справляется с поворот сцены на 360°. Ошибки при сопоставлении с образцом накапливаются на протяжении многих кадров до тех пор, пока геометрические ограничения уже не могут поддерживать согласованность. По данным Tencent, HunyuanWorld-Voyager использует в работе два основных блока, работающих совместно. Во-первых, система генерирует цветное видео и информацию о глубине одновременно, чтобы убедиться, что они идеально совпадают. Во-вторых, используется то, что Tencent называет «глобальным кэшем» — растущая коллекция точечных 3D-моделей, созданных из ранее сгенерированных кадров. В процессе генерации новых кадров это облако 3D-точек проецируется обратно в 2D с нового ракурса камеры для создания изображений, показывающих то, что должно быть видно на основе предыдущих кадров. Затем модель использует эти проекции для проверки согласованности, обеспечивая соответствие новых кадров уже сгенерированным.  HunyuanWorld-Voyager развивает идеи более ранней ИИ-модели Tencent HunyuanWorld 1.0, которая была выпущена в июле. Алгоритм также является частью более масштабной экосистемы Tencent Hunyuan, которая также включает в себя алгоритмы Hunyuan3D-2 для генерации 3D-объектов по текстовому описанию и HunyuanVideo для генерации видео. Для обеспечения работоспособности HunyuanWorld-Voyager требуются значительные вычислительные мощности. Tencent рекомендует использовать не менее 60 Гбайт видеопамяти для получения 3D-сцен с разрешением 540p или 80 Гбайт видеопамяти для повышения качества картинки. Получить доступ к исходному коду ИИ-модели и сопутствующей документации можно на портале Hugging Face. Как и другие ИИ-модели семейства Hunyuan, новый алгоритм поставляется с существенными лицензионными ограничениями. К примеру, лицензия запрещает использовать HunyuanWorld-Voyager в ЕС, Великобритании и Южной Корее. Отдельного лицензирования требует коммерческое использование, предполагающее обслуживание более 100 млн пользователей в месяц. Google открыла бесплатный доступ к генератору видео Veo 3, но только на эти выходные

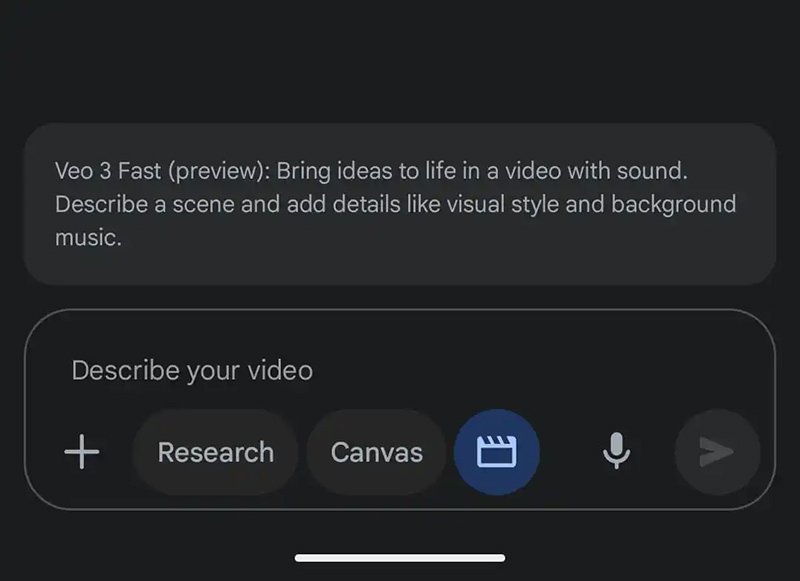

23.08.2025 [16:39],

Владимир Мироненко

В эти выходные чат-бот на основе искусственного интеллекта Google Gemini предоставит пользователям бесплатного приложения возможность опробовать версию новейшей модели генерации видео Google Veo 3, анонсированной в мае. С её помощью можно создавать на основе запросов 8-секундные клипы со звуком. Отметим для россиян, что эта услуга доступна только с зарубежного IP-адреса.

Источник изображения: 9to5google С июля платные подписчики Google AI Pro по всему миру могут создавать три видео в день с помощью более дешёвой, чем Veo 3, модели Veo 3 Fast, которая генерирует видео в два раза быстрее с разрешением 720p. При этом владельцы подписки Google AI Ultra имеют расширенный доступ к полной версии. Им также доступна функция преобразования фото в видео. Однако в рамках акции с текущего момента до 22:00 по тихоокеанскому времени воскресенья (понедельник, 9:00 мск) пользователи бесплатной версии Gemini смогут создать три видео с помощью модели Veo 3 Fast. Глава ИИ-сервиса Gemini Джош Вудворд (Josh Woodward) сообщил в четверг в соцсети X, что Google «настраивает массу TPU» перед пробным периодом, чтобы справиться с ожидаемым ростом запросов. При открытии приложения Gemini можно увидеть сообщение об акции. Если его нет, необходимо нажать на указатель с тремя точками на панели подсказок, чтобы открыть новый элемент «Видео: Генерация с Veo». Запрос пользователя должен «описывать сцену с добавленными деталями, такими как визуальный стиль и фоновая музыка». Можно также указать в описании диалоги и фоновый шум. Создание займёт несколько минут, после чего пользователи смогут скачать клип с водяным знаком (значок Veo в правом нижнем углу) или получить ссылку для общего доступа. Universal Pictures пригрозила ИИ-компаниям судом за незаконное использование фильмов студии для обучения нейросетей

07.08.2025 [07:56],

Владимир Фетисов

Одна из старейших голливудских киностудий Universal Pictures становится всё более агрессивной в защите своих фильмов от компаний, занимающихся разработкой генеративных нейросетей. В стремлении защитить свои фильмы от незаконного их использования для обучения нейросетей компания выбрала новый подход.

Источник изображения: Julien Tromeur / Unsplash В июне этого года киностудия добавила в финальные титры фильма «Как приручить дракона» информацию о том, что незаконное использование этого контента грозит нарушителям судебными разбирательствами. Позднее аналогичные предупреждения появились в титрах фильмов «Мир юрского периода: Возрождение» и «Плохие парни 2». «Этот фильм защищён законами США и других стран. Несанкционированное копирование, распространение или демонстрация повлекут за собой гражданскую ответственность и уголовное преследование», — говорится в сообщении Universal Pictures. В компании считают, что добавление в титры такой формулировки создаст дополнительный уровень защиты от кражи кинофильмов с целью сбора данных для обучения ИИ-моделей. В некоторых странах в предупреждении компании упоминается вступивший в силу в Евросоюзе в 2019 году закон об авторском праве. Этот закон позволяет авторам контента отказаться от использования их материалов в научных целях. Быстрое развитие генеративных нейросетей несёт опасность для киноиндустрии, поскольку легко представить себе будущее, в котором многие зрители откажутся от просмотра традиционных фильмов в пользу того, что генерируют нейросети. При этом такие алгоритмы обычно обучаются на принадлежащей киностудиям интеллектуальной собственности. В настоящее время нейросети преимущественно задействованы для оптимизации отдельных процессов кинопроизводства, но уже сейчас есть игроки, которые верят в то, что будущее киноиндустрии за искусственным интеллектом. Например, в конце прошлого месяца студия Fable Studios Эдварда Саатчи (Edward Saatchi) объявила о получении неназванного объёма инвестиций от Amazon на создание платформы, которая позволит пользователям генерировать эпизоды шоу по простому текстовому описанию. У компании большие амбиции в этом направлении, она планирует выпустить в прокат свой первый сгенерированный ИИ полнометражный фильм в 2026 году. Photoshop получил ИИ-инструмент для быстрого повышения качества старых фотографий

29.07.2025 [19:37],

Сергей Сурабекянц

Adobe представила в последней бета-версии Photoshop серию новых инструментов, которые, по заявлению компании, устранят «утомительные шаги, снизят уровень сложности и сделают точное редактирование более быстрым и интуитивно понятным». Самой востребованной среди пользователей, по словам Adobe, является ИИ-функция Generative Upscale («Генеративное Масштабирование»), позволяющая увеличивать изображения до 8 мегапикселей без потери качества.

Источник изображений: Adobe В последней версии программы также появился обновлённый инструмент Remove («Удаление»), созданный на основе последней ИИ-модели Adobe Firefly. Он выполняет все ожидаемые функции стирания и удаления объектов, но при этом, по утверждению Adobe, обеспечивает более реалистичное изображение — на фотографии остаётся «меньше артефактов от удалённых объектов». Этот инструмент, как и Generative Upscale, доступен в бета-версии для настольных компьютеров и в веб-приложении. Adobe также запускает функцию Harmonize («Гармонизация»), ранее анонсированную под названием Project Perfect Blend на конференции Max в октябре 2024 года. Используя ИИ-модель Adobe Firefly, Harmonize «интеллектуально анализирует окружающий контекст, автоматически корректируя цвет, освещение, тени и визуальный тон для создания бесшовных, цельных композиций». Adobe утверждает, что новая функция существенно сократит необходимость ручной корректировки. Помимо бета-версии на настольном компьютере или в веб-браузере, она также доступна для пользователей мобильных устройств iOS.  Теперь пользователи получили возможность переключаться между различными ИИ-моделями Adobe Firefly. Кроме того, в этой бета-версии Photoshop появилась функция Projects («Проекты»), которая обеспечит сохранение всех файлов пользователя в едином пространстве и позволит отправлять заказчику целые коллекции, а не одну версию за раз. Это шанс для VR: Tencent выпустила открытую ИИ-модель Hunyuan 3D World Model 1.0, которая генерирует интерактивные 3D-миры

28.07.2025 [18:58],

Владимир Фетисов

Китайская компания Tencent представила первую в отрасли открытую модель искусственного интеллекта, способную генерировать интерактивные 3D-миры на основе текстового описания или статического изображения. Речь идёт об алгоритме Hunyuan 3D World Model 1.0, который создаёт 360-градусные сцены, подходящие для использования в приложениях виртуальной реальности, а также при создании цифрового контента и разработке игр.

Источник изображения: habr.com Отмечается, что созданные с помощью Hunyuan 3D-миры можно экспортировать в формате 3D-сетки, а затем импортировать в популярные игровые движки и программное обеспечение для моделирования, чтобы использовать их при разработке игр. Некоторые пользователи соцсети X уже успели опробовать алгоритм в деле и опубликовали свои работы, демонстрирующие различные стили, детализированные текстуры и возможность ограниченного перемещения в центре сцены. Генерируемые пользователями 3D-миры соответствуют тому, что ранее публиковала сама Tencent. Так, один пользователь сгенерировал полностью исследуемую 360-градусную сцену по простой текстовой подсказке: «Лесной пожар угрожает маленькому городку на Аляске в засушливый летний день». Вся сцена выполнена в классическом игровом стиле. Другой пользователь создал трёхмерный мир, словно сошедший со страниц сказки. Учитывая трёхмерную природу объектов, создаваемых с помощью Hunyuan, алгоритм можно использовать для разработки контента, адаптированного под устройства виртуальной реальности — такие как Apple Vision Pro и Meta✴ Quest. Модель доступна для ознакомления на официальном сайте Tencent, а также размещена на платформах Hugging Face и GitHub. YouTube добавил ИИ-инструменты для создания роликов Shorts из фото или текста

23.07.2025 [22:02],

Николай Хижняк

Платформа YouTube начала внедрение инструментов на базе генеративного ИИ для упрощения процесса создания коротких вертикальных видео Shorts. Новые функции позволяют, например, преобразовывать фотографии в видео, а также предлагают целый арсенал видеоэффектов на базе ИИ. Кроме того, платформа представила инструмент генерации видео по подсказкам — AI Playground.

Источник изображения: Christian Wiediger/unsplash.com Google представила три основные функции на базе ИИ для создателей Shorts. Одна из них позволяет превращать фото в видео — для создания клипа достаточно одного статичного изображения. Хотя Google не уточняет ограничения по длине таких роликов, вероятно, они будут довольно короткими. В инструментах редактирования Shorts также появились два новых ИИ-эффекта. Их можно выбрать перед началом записи. Первый — эффект «погружения в воду»: ИИ генерирует промежуточные кадры между реальными, создавая иллюзию, будто объект на видео погружается под воду. С примером этого эффекта можно ознакомиться ниже. Также в разделе эффектов появилась функция, позволяющая сделать грубый набросок прямо на экране смартфона, который затем будет преобразован в более красочное и проработанное изображение. Новые инструменты GenAI включают и платформу AI Playground — полноценную среду для генерации контента, а не просто наложения эффектов на видео и изображения. AI Playground позволяет создавать видео, изображения и музыку на основе текстовых описаний или готовых примеров. Получившийся контент можно публиковать в YouTube Shorts; он будет помечаться как созданный с использованием ИИ. По словам Google, развёртывание новых функций займёт несколько недель. На первом этапе они станут доступны пользователям в США, Канаде, Австралии и Новой Зеландии. В перспективе ожидается расширение географии их поддержки. Инструменты GenAI, представленные YouTube для Shorts, основаны на модели ИИ Veo 2. В будущем они будут переведены на новую модель Veo 3. Правда, сроки запуска пока не определены. Adobe Firefly научился добавлять звуковое сопровождение к генерируемым ИИ видео

17.07.2025 [19:57],

Владимир Фетисов

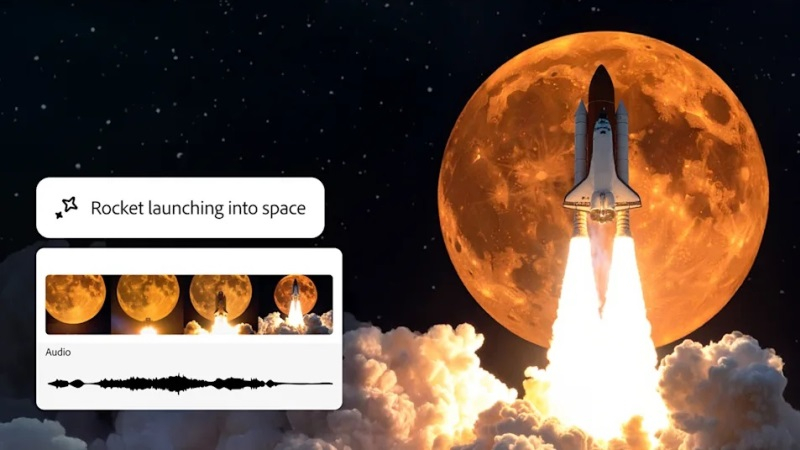

С тех пор как в апреле Adobe выпустила обновлённое приложение Firefly, для платформы генеративных ИИ-сервисов компании почти каждый месяц выходят крупные обновления. Сегодня разработчики представили несколько новых функций, которые будут полезны тем, кто использует сервис для создания видео.

Источник изображения: Adobe Начнём с того, что Adobe упростила процесс добавления звуковых эффектов к клипам, созданным с помощью генеративных нейросетей. В настоящее время многие алгоритмы генерируют видео без звукового сопровождения. Adobe решает эту проблему с помощью новой функции, которая позволяет пользователю сначала описать звуковой эффект, который он хочет создать, а затем попытаться его воспроизвести. Вторая часть необходима не для того, чтобы ИИ-алгоритм имитировал звук, а для того, чтобы система лучше поняла, какую интенсивность и продолжительность звука ожидает пользователь. Во время демонстрации сотрудник Adobe использовал новую функцию, чтобы добавить звук расстёгивающейся молнии. Он произнёс «ззззттт», после чего алгоритм в точности воспроизвёл этот эффект с нужной громкостью. Отмечается, что не всегда генерация звука проходит безупречно, однако функция вполне подходит для создания черновых версий, как и задумывала Adobe. Ещё одной новой функцией стала Composition Reference. Она позволяет загрузить изображение или видео для управления процессом генерации. С помощью Video Presets можно задать стиль создаваемого ролика. Среди прочего на данный момент доступны стили аниме, чёрно-белое видео и видео с использованием векторной графики. Функция Keyframe Cropping позволяет загрузить первый и последний кадры и выбрать соотношение сторон, после чего Firefly сгенерирует видео, соответствующее заданному формату. В июне на платформе Adobe появилась поддержка ИИ-алгоритмов сторонних разработчиков, и в этом месяце их список расширился. Наиболее примечательным стало появление модели Google Veo 3, представленной в мае на конференции Google I/O 2025. В настоящее время Veo 3 — одна из немногих ИИ-моделей, способных генерировать видео со звуком. Каждое видео, созданное на платформе Firefly, имеет цифровую подпись, указывающую на то, что ролик был сгенерирован с помощью ИИ. «Сбер» представил нейросеть Kandinsky 4.1 Video для генерации 10-секундных HD-видео

25.06.2025 [15:40],

Владимир Фетисов

«Сбер» в рамках технологической конференции GigaConf анонсировал генеративную нейросеть Kandinsky 4.1 Video, которая позволяет создавать 10-секундные видео в формате HD по текстовому описанию или изображению. На данный момент опробовать новый алгоритм уже смогли участники конференции и профессиональные дизайнеры.

Источник изображения: Steve Johnson / Unsplash «Kandinsky 4.1 Video обеспечивает качественно новый уровень генеративного видео. Модель стала в разы лучше по всем параметрам: по соответствию промпту, визуальному качеству, качеству генерации движений, а также способности моделировать физику мира. Такие разработки открывают беспрецедентные возможности как для дизайнеров, маркетологов, так и для представителей любых других креативных индустрий, работающих над созданием высококачественного видеоконтента», — рассказал старший вице-президент «Сбербанка» Андрей Белевцев. Согласно имеющимся данным, Kandinsky 4.1 Video генерирует видеоряд продолжительностью до 10 секунд в разрешении SD (720×576 пикселей) или HD (1280×720 пикселей). Разработчики дообучили новую архитектуру диффузионного трансформера на данных, подготовленных более чем 100 профессиональными фотографами и художниками. Особое внимание уделялось оптимизации вычислительных процессов. За счёт применения методов дистилляции и ускорения удалось более чем втрое сократить время генерации по сравнению с моделью предыдущего поколения. Kandinsky 1.4 Video поддерживает создание роликов с произвольным соотношением сторон, за счёт чего генерируемый контент можно адаптировать под разные платформы и маркетинговые задачи. Для всех желающих новая версия алгоритма станет доступна в ближайшее время. «Весёлая, простая и красивая»: Midjourney запустила V1 — свою первую ИИ-модель для генерации видео по изображениям

19.06.2025 [09:45],

Сергей Сурабекянц

Midjourney, один из самых популярных стартапов по генерации изображений на основе ИИ, объявил о запуске модели V1, генерирующей видеоролики из изображений. Как и другие модели компании, на момент запуска V1 доступна только через Discord и только онлайн.

Источник изображения: Midjourney «Представляем нашу модель видео V1. Она весёлая, простая и красивая. Доступная за 10 долларов в месяц, это первая модель видео для всех и прямо сейчас», — говорится в аккаунте Midjourney в социальной сети X. V1 составит конкуренцию таким моделям видеогенерации, как Sora от OpenAI, Gen 4 от Runway, Firefly от Adobe и Veo 3 от Google. Midjourney подчеркнула, что в отличие от большинства компаний, сосредоточенных на разработке коммерческих моделей, она в первую очередь ориентирована на творческую аудиторию. По мнению экспертов, подобно сгенерированным изображениям Midjourney, видеоролики, созданные V1, выглядят «несколько потусторонними, а не гиперреалистичными». Хотя длительность видео, созданного с помощью V1, ограничена пятью секундами, пользователь может продлить его на четыре секунды до четырёх раз подряд, увеличив длительность финального ролика до 21 секунды. На момент запуска самым дешёвым способом опробовать V1 является подписка на базовый тариф Midjourney стоимостью $10 в месяц с ограниченным количеством генераций. Для безлимитного использования V1 придётся выбрать тариф Pro за $60 или Mega за $120 с дополнительным режимом Relax. Midjourney планирует в течение следующего месяца пересмотреть систему тарифных планов. Компания ставит перед собой более масштабные задачи, нежели генерация перебивок для голливудских фильмов или создание рекламных роликов. По словам главы Midjourney Дэвида Хольца (David Holz), конечная цель компании — модели ИИ, «способные к моделированию открытого мира в реальном времени». Также в дальнейших планах Midjourney — разработка ИИ-модели для полноценного 3D-рендеринга. Запуск V1 от Midjourney состоялся всего через неделю после того, как на стартап подали в суд две известные киностудии Голливуда —Disney и Universal. В иске утверждается, что модели Midjourney генерируют изображения персонажей студий, защищённых авторским правом, таких как Гомер Симпсон и Дарт Вейдер.

Источник изображения: theverge.com Google интегрирует в YouTube Shorts свою новую ИИ-модель генерации видео Veo 3

19.06.2025 [08:30],

Сергей Сурабекянц

Генеральный директор YouTube Нил Мохан (Neal Mohan) сообщил, что новейшая модель генерации видео на основе искусственного интеллекта Google Veo 3 будет добавлена в раздел коротких вертикальных роликов Shorts «этим летом». Мохан также сообщил, что в настоящее среднее количество просмотров коротких видео превысило 200 миллиардов в день.

Источник изображений: unsplash.com Создатели Shorts уже сейчас могут воспользоваться моделью Google Veo 2 предыдущего поколения для генерации динамических фоновых изображений с помощью инструмента Dream Screen. Мохан не уточнил, какие именно возможности предоставит развёртывание модели Veo 3 в Shorts, но упомянул об улучшенном качестве видео и возможности создания звуковой дорожки. Пока неясно, придётся ли создателям Shorts платить за использование Veo 3. Сейчас для создания видео при помощи Veo 3 требуется платная подписка на тарифные планы AI Pro или AI Ultra от Google. Далеко не все приветствуют всё более широкое распространение генераторов видео на основе искусственного интеллекта. Журналистка издания The Verge Эллисон Джонсон (Allison Johnson) недавно назвала генератор видео Google Veo 3 «мечтой торговца помоями».  Google расширила доступ к ИИ-генератору Veo 3 через приложение Gemini

26.05.2025 [17:01],

Владимир Фетисов

Всего несколько дней прошло с тех пор, как Google представила свой новый ИИ-генератор видео Veo 3, а он уже стал доступен пользователям из 71 страны. Опробовать новинку в деле смогут подписчики приложения Gemini из десятков стран, но на территории ЕС и в России сервис пока недоступен. Об этом в своём аккаунте в соцсети X сообщил глава Google Labs и Gemini Джош Вудворд (Josh Woodward).

Источник изображения: Veo 3 / Google Согласно имеющимся данным, взаимодействовать с Veo 3 могут подписчики Gemini Pro, которые получат пробный пакет на 10 генераций видео через веб-интерфейс. На данном этапе пакет из десяти генераций является одноразовым, т.е. не будет обновлён после истечения какого-то периода времени. Обладатели подписки Ultra стоимостью $250 в месяц получат максимально разрешённое Google количество генераций, которые будут обновляться ежедневно. В режиме Flow, который ориентирован на создателей видеоконтента с помощью ИИ, подписчики Ultra смогу генерировать до 125 роликов в месяц, а подписчики Pro — до 10 роликов в месяц. На данном этапе не обошлось без некоторых ограничений. ИИ-генератор Veo 3 работает только в веб-версии Gemini Pro и поддерживает генерацию звукового сопровождения только на английском языке, хотя в некоторых случаях может появляться речь на других языках. Несмотря на это и ограниченную доступность, у Veo 3 есть все шансы стать вирусной сенсацией Google в сфере ИИ. Интернет уже наводнили созданные с помощью этого сервиса ролики, показывающие, как сочетание видео и аудио устанавливает новый стандарт качества для контента, генерируемого с помощью ИИ. Также отмечается, что Veo 3 с поразительной точностью следует подсказкам пользователей. Это повышает качество создаваемого контента, но в то же время позволяет генерировать фейковые видео, которые выглядят и звучат как настоящие. В одном из примеров пользователь сгенерировал видео с вымышленного автомобильного шоу, которое выглядит вполне реалистично. Однако злоумышленники могут задействовать сервис для генерации видео с высказываниями политиков, массовыми протестами и какими-то другими ситуациями для манипулирования общественным мнением. Veo 3 подтверждает опасения по поводу значимой роли ИИ в распространении дезинформации и одновременно демонстрирует, насколько далеко продвинулись технологии. Ещё несколько лет назад создание качественного фейкового видео с заменой лица требовало многочасовой работы и наличия серьёзных технических навыков. Сегодня несколько строчек теста позволяют генерировать реалистичные сцены с естественным звуком. Всё это говорит о том, что людям следует тщательнее проверять подлинность просматриваемого контента, не принимая всё увиденное за действительность. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |