|

Опрос

|

реклама

Быстрый переход

Главный конкурент ChatGPT научился проводить глубокие исследования и рыться в Gmail

16.04.2025 [00:14],

Анжелла Марина

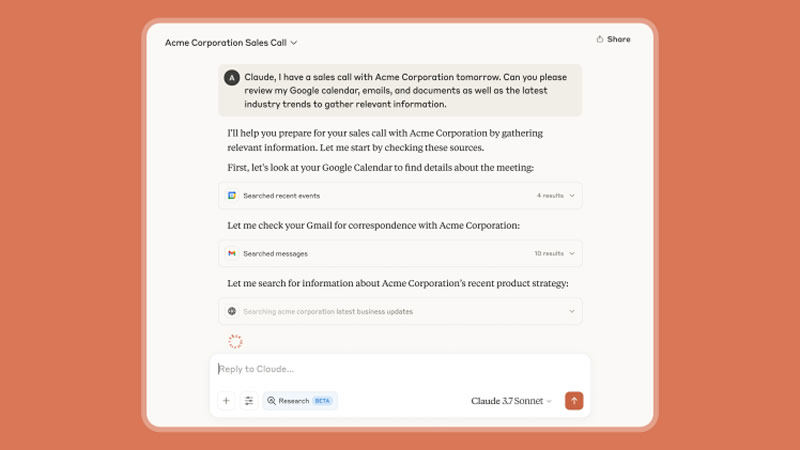

Компания Anthropic, разработчик ИИ-ассистента Claude, представила новый инструмент Research для глубоких исследований с помощью ИИ. Также компания объявила об интеграции с приложениями пакета Google Workspace: ИИ-ассистент сможет напрямую подключаться к Gmail, «Google Календарю» и «Google Документам».

Источник изображения: Anthropic Вместо ручного поиска информации в громадном количестве писем, приглашениях и документах, Claude будет делать это за пользователя. ИИ может находить информацию за заданный период, выделять ключевые действия из цепочек писем и предлагать дополнительный контекст не хуже, чем Microsoft Copilot, отмечает The Verge. Кроме этого, Anthropic запустила новую функцию Research, которая, по словам разработчиков, кардинально меняет подход к поиску и анализу информации. В отличие от обычного ИИ-поиска, Claude теперь работает как ИИ-агент, выполняя серию взаимосвязанных запросов, формируя более точную и обоснованную выдачу, а каждый выданный ответ сопровождается ссылками на источники.

Источник изображения: Anthropic Функция Research уже доступна в ранней бета-версии для пользователей тарифов Max, Team и Enterprise в США, Японии и Бразилии. Интеграция же с Google Workspace находится в стадии beta и доступна всем платным пользователям, однако для корпоративных аккаунтов её должен активировать администратор. Для подписчиков с тарифом Pro ($20 в месяц) запуск функции Research планируется в ближайшее время. Для корпоративных клиентов также добавлена возможность каталогизации «Google Диска» — эта функция использует методы RAG (улучшенные механизмы поиска, в том числе по внешним источникам), чтобы находить информацию даже в давно забытых документах. Claude сможет автоматически просматривать всю базу данных компании в поисках нужных данных. Однако с расширением возможностей модели встаёт вопрос точности и безопасности. Как и другие ИИ, Claude может ошибочно интерпретировать данные или предоставлять вымышленные сведения. «Мы призываем пользователей всегда проверять источники, читать их и убеждаться в точности информации», — подчёркивают в Anthropic. Что касается конфиденциальности, то в компании заверили, что их ИИ-ассистент работает только с теми документами, к которым пользователь предоставил доступ в рамках своей авторизации. Также сообщается, что Anthropic запускает голосовой ИИ, с которым можно разговаривать. Новая функция, получившая название Voice mode, появится в чат-боте уже в этом месяце и, вероятно, станет конкурентом аналогичному голосовому режиму в ChatGPT. По данным Bloomberg, пользователям будут доступны три варианта голоса на английском языке: Airy, Mellow и Buttery. Ранее о разработке этой функции упоминал глава по продуктам Anthropic Майк Кригер (Mike Krieger), подтвердив, что компания тестирует прототипы. Упоминания о голосовом режиме также были обнаружены в коде iOS-приложения Claude. Как заявили в компании, что это лишь начало серии обновлений, которые «переосмысляют взаимодействие с Claude». В ближайшие недели ожидается дальнейшее расширение доступного контекста и улучшение аналитических функций ИИ-модели. Эксперты предупредили о схеме «галлюцинаторного захвата» — атаки на разработчиков ПК, использующих ИИ

15.04.2025 [19:00],

Павел Котов

Исследователи в области кибербезопасности предупредили о новом методе, с помощью которого хакеры могут злоупотреблять «галлюцинациями», которые посещают искусственный интеллект, используемый при разработке программных продуктов. Существующая пока лишь в теории схема получила название «галлюцинаторный захват» (slopsquatting).

Источник изображений: socket.dev Системы генеративного ИИ, в том числе OpenAI ChatGPT и Microsoft Copilot, склонны к галлюцинациям — когда ИИ просто выдумывает нечто не соответствующее действительности и выдаёт это за фактическую информацию. Он может приписать человеку слова, которых он не говорил; придумать событие, которого не было; или при разработке ПО сослаться на продукт с открытым исходным кодом, которого не существует. С распространением генеративного ИИ многие разработчики ПО стали в значительной степени полагаться на него при написании кода. Чат-боты сами пишут код или предлагают разработчику сторонние библиотеки для их включения в проект. Примечательно, что при возникновении галлюцинаций ИИ может раз за разом выдумывать один и тот же несуществующий пакет. Если обнаружить запрос, провоцирующий ответ с галлюцинацией, установили эксперты компании Socket, и повторить этот запрос десятикратно, то в 43 % случаев ИИ снова сошлётся на несуществующий программный продукт, а в 39 % случаев про него не вспомнит. В целом 58 % выдуманных ИИ пакетов появлялись более одного раза за десять запросов, и на этом злоумышленники могут попытаться сыграть. Схема существует только в теории, но ничто не мешает хакерам выявить такую закономерность в сбоях и создать несуществующий программный пакет, на который упорно ссылается ИИ — и внедрить в этот пакет вредоносный код. Получив рекомендацию от ИИ, разработчик откроет одну из наиболее популярных платформ, например, GitHub, найдёт указанный продукт и развернёт его в проекте, не зная, что это вредоносное ПО. На данный момент инцидентов с использованием схемы «галлюцинаторного захвата» пока не зарегистрировано, но, вероятно, их возникновение — это лишь вопрос времени. Лучший способ защититься тот же, что и всегда — осмотрительность. «Яндекс» научил «Алису» рассуждать, работать с файлами, говорить по-английски, изучать мир и заниматься с детьми

15.04.2025 [16:05],

Павел Котов

«Яндекс» представил масштабное обновление голосового помощника с искусственным интеллектом «Алиса». Он научился рассуждать, работать с загружаемыми файлами, рассказывать об увиденном через камеру смартфона, свободно говорить по-английски и заниматься с детьми в игровой форме. Чтобы воспользоваться новыми возможностями ИИ-ассистента, потребуется подключить опцию «Алиса Про». При включённом режиме «Рассуждать», который пока доступен в бета-версии, чат-бот перед ответом анализирует вопрос и выстраивает цепочку рассуждений, следить за которыми можно в реальном времени. Этот режим поможет в решении сложных задач по физике и математике, изучении программного кода, в многофакторном анализе и других сложных задачах. С подключённой функцией поиска «Алиса» использует не только собственную базу знаний, но и информацию из наиболее подходящих источников. ИИ-помощник улучшил навыки английского языка — теперь «Алиса» свободно и без акцента говорит по-английски, легко переключается с русского и обратно. Для желающих попрактиковаться в английском доступен режим тренажёра: ассистент поддерживает разные темы, помогает с переводом незнакомых слов и разбирает ошибки пользователя. Доступны форматы общения в чате или голосом — с «Яндекс Станцией». Ещё одно нововведение — поддержка загрузки файлов в форматах PDF, TXT, DOC и DOCX (до 512 Мбайт), а также картинок (до 20 Мбайт):«Алиса» может их проанализировать и ответить на вопросы. В мобильном приложении появился основанный на мультимодальной нейросети «Яндекса» (Visual Language Model, VLM) «живой» режим: ИИ распознаёт объекты на камере смартфона и рассказывает о них. В этом режиме доступно общение голосом: можно, например, поинтересоваться, что приготовить из имеющихся продуктов, а затем воспользоваться расшифровкой ответа в чате. У «Алисы» улучшились навыки общения с детьми: раньше ИИ-помощник мог предложить детям в возрасте от 5 до 8 лет различные игры и задания; теперь доступны также игры и квесты для детей от 3 до 5 лет — их разработали эксперты «Яндекс Учебника», и предназначаются они для тренировки памяти, логики, моторики и речи. В приложении «Дом с Алисой» можно настроить расписание занятий, а начинаются они по фразе «Алиса, хочу в домик». Ещё одна новая функция поможет детям выучить таблицу умножения. Заниматься с детьми голосовой ассистент может через колонки «Яндекс Станция» и телевизоры «ТВ Станция». Воспользоваться новыми функциями «Алисы» могут пользователи, оформившие подписку «Алиса Про» за 100 рублей в месяц, доступную абонентам «Яндекс Плюса». С «профессиональной» подпиской открывается доступ к самой мощной модели ИИ YandexGPT 5 Pro и к развивающим заданиям для детей. Модель генерирует тексты в заданных форматах, помогает в решении сложных задач и и придумывает концепции. Оформили подписку уже более 2 млн человек. Каждый десятый человек на Земле теперь пользуется ChatGPT, и его популярность только растёт

14.04.2025 [13:42],

Дмитрий Федоров

Число еженедельных активных пользователей ChatGPT приблизилось к одному миллиарду. Такой рост совпал с мартовским обновлением функции генерации изображений, что вызвало всплеск интереса к ИИ-сервису. В прошлом месяце ChatGPT стал самым загружаемым в мире приложением за исключением игр, а общее количество его установок составило 46 млн.

Источник изображения: Growtika / Unsplash Во время беседы на сцене конференции TED куратор мероприятия Крис Андерсон (Chris Anderson) задал Сэму Альтману (Sam Altman), генеральному директору OpenAI, вопрос о числе пользователей ChatGPT. Альтман ответил, что последняя озвученная цифра составляла 500 млн еженедельных активных пользователей, и добавил, что аудитория продолжает стремительно расти. Андерсон заметил, что в частной беседе Альтман упоминал о двукратном росте за несколько недель. Альтман это не опроверг. Альтман также сообщил, что ChatGPT пользуются около 10 % населения Земли. Поскольку сегодня на Земле живут более 8 млрд человек, это примерно 800 млн пользователей. После запуска 30 ноября 2022 года бесплатной исследовательской версии ChatGPT на основе ИИ-модели GPT-3.5, он достиг отметки в 100 млн пользователей всего за два месяца, став самым популярным приложением в истории. Для сравнения: TikTok для этого потребовалось девять месяцев, а Instagram✴ — два с половиной года. К августу 2024 года число еженедельных активных пользователей ChatGPT достигло 200 млн. Последующий резкий рост был вызван обновлением 25 марта, в котором были улучшены возможности генерации изображений. После этого социальные сети наводнили изображения и видео, выполненные в различных художественных стилях, наиболее популярным из которых оказался стиль японской анимационной студии Studio Ghibli. Альтман отметил, что спрос оказался настолько высоким, что фактически «плавил» графические процессоры компании. Хорошей новостью для OpenAI стало то, что обновление привлекло миллион новых пользователей ChatGPT всего за один час. Согласно данным аналитической платформы Appfigures, в марте ChatGPT стал самым скачиваемым неигровым приложением в мире. Количество установок выросло на 28 % по сравнению с февралем и достигло 46 млн. Взрывному успеху способствовало не только улучшение генератора изображений, но и, вероятно, снятие некоторых ограничений в работе сервиса.

Источник изображения: TED На фоне популяризации генеративного ИИ усиливаются опасения по поводу его влияния на рынок труда. Всё больше компаний сокращают персонал, поскольку задачи, ранее выполнявшиеся людьми, теперь выполняют ИИ-системы. На вопрос о том, заменит ли ИИ человека, Альтман ответил: «Можно сказать: „О, Боже, оно делает всё, что делаю я. Что же со мной будет?“ Или вы можете сказать, как во времена всех других технологических революций в истории: „Хорошо, теперь есть новый инструмент. Я могу делать гораздо больше. Что я смогу делать?“ Конечно, ожидания от человека, занимающего определённую должность, возрастают, но возможности расширяются настолько значительно, что, я думаю, соответствовать этим ожиданиям возможно». Начинающие разработчики ИИ-приложений привлекли рекордные $8,2 млрд инвестиций за прошлый год

14.04.2025 [12:15],

Дмитрий Федоров

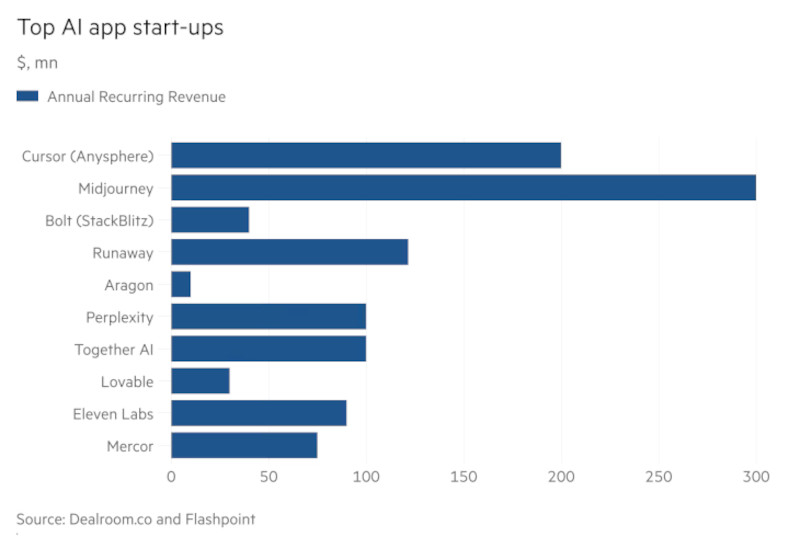

Несколько стартапов в сфере ИИ, разрабатывающих прикладные решения на основе больших языковых моделей (LLM), стремительно наращивают объёмы продаж и инициируют новую гонку за коммерческое освоение передовых технологий. Их быстрый рост привлёк внимание инвесторов, готовых вложить сотни миллионов долларов в развитие потребительских ИИ-продуктов.

Источник изображения: Alex Shuper / Unsplash Инвесторы делают ставку на такие компании, как Cursor, Perplexity, Synthesia и ElevenLabs. Эти стартапы создают приложения на основе мощных генеративных ИИ-моделей (GenAI), предоставляемых OpenAI, Google и Anthropic. Они способствуют более широкому внедрению быстро развивающихся технологий как в потребительской, так и в корпоративной среде. По данным аналитической платформы Dealroom.co, в 2024 году объём финансирования стартапов, разрабатывающих приложения на основе ИИ, составил $8,2 млрд, что на 110 % больше, чем в 2023 году. Этот инвестиционный ажиотаж свидетельствует о высоком интересе к разработчикам ИИ-инструментов, способным привлекать сотни миллионов долларов на фоне стремительного роста спроса. Стартап Perplexity, разработавший поисковую систему на базе ИИ, привлёк в декабре $500 млн в рамках своего четвёртого раунда финансирования за год, утроив оценку компании до $9 млрд. По данным источников, в настоящее время компания ведёт переговоры о новом раунде инвестиций по существенно более высокой оценке. В то же время стартап Harvey, разрабатывающий ИИ-решения для юридической сферы, привлёк $300 млн в феврале. Стартапы, создающие приложения для разработчиков программного обеспечения (ПО), также вызвали повышенный интерес со стороны инвесторов. Компании, такие как Reflection AI, Poolside, Magic и Codeium, собрали сотни миллионов долларов в 2024 году на развитие технологий, направленных на повышение производительности программистов. В январе компания Anysphere — разработчик инструмента автоматизации программирования Cursor — привлекла $105 млн при оценке $2,5 млрд. По словам источников, инвесторы проявляют интерес к компании при оценке в $10 млрд и выше. Трёхлетний стартап уже достиг годовой регулярной выручки на уровне $200 млн.

Источник изображения: Dealroom.co and Flashpoint ИИ-стартапы также получили выгоду от усилившейся конкуренции на рынке LLM, которая привела к снижению стоимости обработки запросов и генерации ответов с использованием ИИ. Это позволило использовать инфраструктуру LLM без необходимости создания собственных дорогостоящих ИИ-моделей, что ускорило вывод продуктов на рынок. Брет Тейлор (Bret Taylor), председатель совета директоров OpenAI и сооснователь стартапа Sierra, отметил, что компания за короткое время сменила используемые ИИ-модели не менее пяти-шести раз в связи с высокой скоростью развития отрасли. Стартап Sierra, разрабатывающий агентов поддержки клиентов на базе ИИ, был основан в феврале 2024 года и достиг оценки в $4,5 млрд уже в октябре того же года. По его словам, использование ИИ-модели двухлетней давности сегодня сравнимо с поездкой на автомобиле 1950-х годов — настолько стремительно устаревают технологии. Согласно анализу данных о платежах от финтех-компании Stripe, крупнейшие ИИ-компании достигают объёмов продаж в миллионы долларов уже в течение первого года своей деятельности. Это происходит значительно быстрее, чем в случае стартапов из других технологических отраслей, и свидетельствует о высокой способности прикладного ИИ к быстрому формированию устойчивых бизнес-моделей. Однако пока сложно оценить, насколько надёжна клиентская база ИИ-стартапов и насколько устойчивыми окажутся их текущие доходы. На фоне всеобщего интереса к ИИ ранние пользователи приходят быстро, что может искажать показатели роста, не гарантируя долгосрочной подписки. Некоторые инвесторы избегают участия в гонке за наиболее популярные приложения, опасаясь, что даже лучшие из них представляют собой лишь сервисные «обёртки» над существующими ИИ-моделями. Существует риск, что такие стартапы будут вытеснены в случае, если более крупная компания с широкой пользовательской базой решит воспроизвести их функциональность. Ханна Сил (Hannah Seal), партнёр венчурной компании Index Ventures, инвестировавшая в юридического ИИ-ассистента Wordsmith, подчёркивает, что многие из этих ИИ-стартапов ещё не прошли ни одного полного годового цикла продления подписки. Поэтому уровень оттока клиентов остаётся неизвестным и может существенно повлиять на дальнейшую динамику развития. Мошенники наводнили десятки тысяч сайтов спамом с помощью OpenAI GPT-4o-mini

14.04.2025 [11:38],

Дмитрий Федоров

Спам-бот AkiraBot использовал ИИ-модель GPT-4o-mini через API OpenAI для создания спам-комментариев, продвигающих фиктивные SEO-услуги. Разнообразие содержания этих комментариев позволяло обходить системы фильтрации на тысячах сайтов по всему миру, говорится в исследовании компании SentinelOne.

Источник изображения: Wesley Tingey / Unsplash Согласно отчёту компании SentinelOne, специализирующейся на кибербезопасности, AkiraBot атаковал не менее 80 000 веб-сайтов, большинство из которых принадлежат малому и среднему бизнесу, использующему платформы электронной торговли, такие как Shopify, GoDaddy, Wix и Squarespace. Как сообщает издание 404 Media, бот направлял в API OpenAI запрос: «Вы — полезный помощник, который создаёт маркетинговые сообщения», — после чего ИИ генерировал спам-комментарии, адаптированные под тематику конкретных сайтов. Так, для сайта строительной компании создавался один вариант спам-сообщений, а для салона красоты — другой. Затем эти комментарии размещались в чатах и формах обратной связи на сайтах, с целью побудить их владельцев приобрести SEO-услуги. Поздние версии спам-бота начали использовать для этих целей также онлайновые чат-виджеты, встроенные в большинство современных сайтов. «Поиск сайтов, ссылающихся на домены AkiraBot, показывает, что ранее этот бот размещал сообщения таким образом, что они индексировались поисковыми системами», — говорится в сообщении SentinelOne. Упомянутый спам-бот появился в сентябре 2024 года и не имеет отношения к группе Akira, занимающейся распространением вымогательского программного обеспечения. Помимо GPT-4o-mini, AkiraBot использовал прокси-сервисы для обхода CAPTCHA и маскировки сетевой активности. OpenAI заблокировала соответствующий API-ключ и заявила, что продолжает расследование, пообещав отключить все активы, связанные с инцидентом. «Мы серьёзно относимся к злоупотреблениям и постоянно совершенствуем наши системы для их выявления», — говорится в заявлении OpenAI. Случаи неправомерного использования инструментов OpenAI уже отмечались ранее — в том числе при создании пропагандистских материалов государственными структурами. Однако зачастую киберпреступники предпочитают использовать собственные ИИ-системы. Так, в 2023 году была выявлена ИИ-модель WormGPT, позволявшая мошенникам вести переписку от имени банка и автоматизировать процесс обмана пользователей. ИИ-лаборатория Meta✴, создавшая модель Llama, постепенно угасает — в компании назвали это «новым началом»

12.04.2025 [12:43],

Владимир Мироненко

Исследовательская лаборатория Meta✴ AI (прежнее название — Facebook✴ Artificial Intelligence Research, FAIR) «медленно умирает», говорят некоторые инсайдеры. Meta✴ предпочитает называть это «новым началом», пишет Fortune.

Источник изображения: Steve Johnson/unsplash.com Сообщение об уходе вице-президента Meta✴ по исследованиям в области ИИ Жоэль Пино (Joelle Pineau), возглавлявшей последние два года Meta✴ AI, вызвало у многих удивление. Когда-то подразделение FAIR находилось на переднем крае разработки технологий ИИ. Однако после того как Марк Цукерберг (Mark Zuckerberg) за последние два года переориентировал компанию на внедрение продуктов генеративного ИИ, лаборатория стала постепенно отходить на второй план, уступая место более коммерчески ориентированным группам по разработке ИИ, отмечает Fortune. Так, например, новейшая ИИ-модель Llama была создана отдельной командой GenAI Meta✴, а не FAIR. FAIR начала терять позиции, и талантливые исследователи перешли в конкурирующие компании и стартапы: более половины из 14 авторов оригинальной исследовательской работы по Llama, опубликованной в феврале 2023 года, покинули компанию спустя шесть месяцев, а как минимум восемь ведущих специалистов ушли за последний год. Бывшие сотрудники FAIR сообщили Fortune, что лаборатория «умирает медленной смертью». С этой точки зрения уход Пино можно интерпретировать как «предсмертный хрип». На время поисков нового руководителя лабораторию временно возглавил Янн Лекун (Yann LeCun), главный специалист по ИИ Meta✴ и основатель FAIR. Он отрицает, что лаборатория близка к закрытию, заявив в интервью Fortune: «Это определённо не смерть FAIR». По его словам, лаборатория вот-вот переживёт новый рассвет, а существование группы, работающей над продуктами генеративного ИИ, фактически позволяет FAIR переориентироваться на долгосрочные исследования в этой области. «Это скорее новое начало, в рамках которого FAIR сосредоточится на амбициозной и долгосрочной цели — том, что мы называем AMI (продвинутый машинный интеллект)», — отметил Лекун. Пино также сообщила Fortune, что по-прежнему «с большим энтузиазмом относится к общей работе и стратегии Meta✴ в области ИИ». По её словам, в компании всё ещё существует сильная поддержка FAIR, а её уход объясняется тем, что она решила «перенаправить свою энергию, прежде чем заняться новым делом». Тем не менее, семь бывших сотрудников Meta✴, с которыми на прошлой неделе пообщался репортёр Fortune, утверждают, что лаборатория в последние годы постепенно снижает обороты, а ей предоставляют меньше доступа к вычислительным мощностям по сравнению с командами, сосредоточенными на генеративном ИИ. Когда в конце ноября 2022 года вышел чат-бот ChatGPT от OpenAI, Meta✴ воспринималась как серьёзно отстающая от OpenAI, Anthropic и Google в сфере генеративного ИИ. Однако FAIR помогла Meta✴ вернуть позиции на ИИ-рынке, разработав модель генеративного ИИ Llama с открытым исходным кодом и свободным доступом, способную конкурировать с решениями других ведущих компаний. Затем, в июле 2023 года, FAIR выпустила Llama 2. Но уже в сентябре того же года у лаборатории начались проблемы. Как сообщил тогда ресурс The Information, многие из первоначальных исследователей FAIR, работавших над Llama, покинули компанию из-за борьбы за вычислительные ресурсы с другой исследовательской группой Meta✴, разрабатывавшей конкурирующую модель, от которой впоследствии отказались. В январе 2024 года FAIR снова была реструктурирована. А выпуск Llama 4 осуществлялся уже подразделением по разработке генеративного ИИ Meta✴, которое возглавляет вице-президент по генеративному ИИ Ахмад Аль-Дале (Ahmad Al-Dahle). После этого команда в рамках недавно созданного направления под руководством вице-президента Meta✴ Манохара Палури (Manohar Paluri) взяла на себя работу над моделями Llama, оставив FAIR в стороне. По словам бывших сотрудников FAIR, компания в настоящее время перенаправляет ресурсы на программы, ориентированные на генеративный ИИ, тогда как FAIR традиционно занималась целым рядом проектов, охватывающих широкий спектр подотраслей искусственного интеллекта, и генеративный ИИ был лишь одной из них. Nvidia и Alphabet вложились в капитал стартапа одного из основателей OpenAI

12.04.2025 [06:25],

Алексей Разин

По большому счёту, в штате OpenAI осталось не так много руководителей высокого ранга, которые стояли у истоков этого стартапа, подарившего миру ChatGPT. Илья Суцкевер, например, после ухода из OpenAI основал свою компанию SSI. В её капитал уже вложились инвесторы, включая Nvidia и Alphabet, причём последняя намерена предлагать SSI свои ускорители вычислений TPU.  Об этом сообщило агентство Reuters со ссылкой на собственные источники. Независимо от сделки по инвестированию в капитал SSI, корпорация Google сообщила о достижении договорённостей со стартапом Суцкевера о предоставлении ему доступа к облачным вычислительным мощностям, построенным на ускорителях TPU. Капитализация SSI оценивается в $32 млрд, что делает его самым стремительно дорожающим стартапом в области ИИ. Инвесторы ценят опыт Ильи Суцкевера, который в OpenAI возглавлял процессы исследований и разработки, а также формировал стратегию развития. Сколько именно вложили в капитал SSI компании Nvidia и Alphabet, источники Reuters не сообщают. Последняя из корпораций параллельно оказывает поддержку стартапу Anthropic, тем самым диверсифицируя свои инвестиционные риски в данной сфере. Для Alphabet сделка с SSI стала ещё одним шансом увеличить поставки ускорителей TPU на сторону, поскольку изначально они создавались Google для собственных нужд холдинга. Традиционно разработчики систем ИИ больше полагались на ускорители Nvidia, но SSI на их фоне выделяется как раз тем, что опирается преимущественно на аппаратные решения Google. В облачной инфраструктуре Google, однако, ускорители TPU сочетаются с решениями Nvidia. Конкурирующий с SSI стартап Anthropic, также созданный выходцами из OpenAI в 2021 году, использует не только ускорители TPU, но и полагается на решения Amazon (AWS) собственной разработки. В декабре партнёры объявили, что Anthropic станет первым клиентом AWS, получившим доступ к существенным вычислительным мощностям, построенным на чипах AWS собственной разработки. При этом стартап не сокращает затраты на закупки ускорителей Google TPU. Как и Google, облачное подразделение Amazon является инвестором Anthropic. Логично, что Nvidia, Google и SSI связывают подобные отношения. При этом Nvidia инвестирует не только в OpenAI, но и в xAI, основанный Илоном Маском (Elon Musk). Двухлетняя модель GPT-4 скоро исчезнет из ChatGPT, уступив место более свежей GPT-4o

12.04.2025 [05:39],

Анжелла Марина

С 30 апреля компания OpenAI удалит модель GPT-4 из меню выбора моделей в ChatGPT для пользователей подписки Plus. Такое решение связано с окончательным переходом на новую модель GPT-4o, которая, по словам разработчиков, превосходит своего предшественника по всем ключевым параметрам, начиная с написания текстов и заканчивая программированием.

Источник изображения: OpenAI Как заявили в OpenAI, мультимодальная большая языковая модель четвёртой серии GPT стала поворотным моментом в развитии чат-бота ChatGPT. Выпущенная 14 марта 2023 года, модель показала несравнимо большие возможности по сравнению в GPT-3. По данным PCMag, на её обучение было потрачено более $100 млн. Несмотря на то, что GPT-4 исчезнет из пользовательского интерфейса ChatGPT, она останется доступной через API на других платформах. При этом, бесплатные пользователи ChatGPT не смогут выбрать модель вручную, поэтому для них ничего не изменится. В настоящее время OpenAI предлагает несколько моделей, включая GPT-4 Turbo, GPT-o3, GPT-o1 и GPT-4.5, а также ходят слухи о возможном запуске GPT-4.1. Глава OpenAI Сэм Альтман (Sam Altman) ранее признавал, что наличие большого количества моделей может сбивать пользователей с толку, поэтому в будущем компания планирует отказаться от выбора модели вручную и перейти к системе единого ИИ, где подбор модели будет происходить автоматически в зависимости от задач. Все представленные модели, как отмечают в OpenAI, являются этапами на пути к следующему крупному релизу GPT-5. Однако её разработка проходит не совсем гладко, что связано, в том числе, и с нехваткой графических процессоров. Но так как компании удалось в прошлом месяце привлечь $40 млрд инвестиций, то ожидается, что это поможет масштабировать вычислительные мощности и ускорить релиз. После запуска модель GPT-5 станет доступна пользователям бесплатно в базовом режиме. Подписчики ChatGPT Plus ($20 в месяц) смогут использовать её с повышенным уровнем ИИ-возможностей, а пользователи подписки Pro ($200 в месяц) получат доступ к самым мощным функциям, таким как голосовой режим, инструменты визуализации Canvas, расширенный поиск, глубокие исследования и другие продукты OpenAI. ChatGPT обошёл Instagram✴ и TikTok, став самым скачиваемым приложением в мире

12.04.2025 [05:34],

Анжелла Марина

Приложение ChatGPT впервые возглавило мировой рейтинг загрузок в марте 2025 года, обогнав таких гигантов, как Instagram✴ и TikTok. По данным аналитической компании Appfigures, число установок ChatGPT выросло на 28 % по сравнению с февралём и составило около 46 миллионов загрузок за месяц. С момента запуска приложения, март оказался для OpenAI лучшим месяцем.

Источник изображения: Rolf van Root / Unsplash Instagram✴, удерживавший лидерство в январе и феврале, опустился на второе место, а TikTok занял третью строчку в App Store и Google Play, сообщает TechCrunch. При этом, рост популярности ChatGPT связывают с важными обновлениями. В частности, впервые за более чем год были улучшены функции генерации изображений, что позволило пользователям создавать вирусные картинки и мемы в стиле анимационной студии Studio Ghibli, которые быстро разошлись по социальным сетям в конце марта и начале апреля. Кроме того, OpenAI ослабила ограничения в политике модерации визуального контента и обновила в приложении голосовой режим. Тем не менее, аналитики считают, что не только новые функции повлияли на скачок популярности. «Складывается впечатление, что слово ChatGPT становится глаголом, таким же, каким стал Google в 2000-х. Многие уже говорят не искусственный интеллект, а просто ChatGPT», — отметил основатель и генеральный директор Appfigures Ариэль Михаэли (Ariel Michaeli). По его словам, волну интереса к ИИ также подогревают конкуренты вроде Grok или DeepSeek, но пользователи всё равно скачивают ChatGPT. К сожалению, популярность ChatGPT также затрудняет рост других чат-ботов. К примеру, Claude от Anthropic пока не может приблизиться к таким же результатам. У Grok, наоборот, шансы несколько выше, но во многом благодаря фигуре самого Илона Маска (Elon Musk) и его платформе X, которая активно продвигает продукт.

Источник изображения: Appfigures В общемировом рейтинге в марте также оказались Facebook✴, WhatsApp, Telegram, Snapchat и Threads. Всего 10 самых популярных приложений были загружены 339 миллионов раз, что на 40 миллионов больше, чем в феврале. OpenAI стала тратить меньше времени на тесты безопасности ИИ-моделей

11.04.2025 [14:09],

Павел Котов

OpenAI сократила время и ресурсы, которые тратятся на тестирование мощных моделей искусственного интеллекта на безопасность. Это вызывает опасения, что разрабатываемые компанией технологии выпускаются чрезвычайно быстро и не сопровождаются достаточными мерами защиты от угроз.

Источник изображения: Levart_Photographer / unsplash.com Сотрудникам OpenAI и компаний-партнёров теперь выделяют всего несколько дней, чтобы провести оценку рисков и производительности моделей ИИ — ранее на это уходили несколько месяцев. Механизмы проверки в OpenAI стали менее тщательными, ресурсов на выявление и смягчение угроз выделяется всё меньше — при оценке в $300 млрд компания вынуждена выпускать новые модели быстро, чтобы сохранять конкурентное преимущество, сообщает Financial Times со ссылкой на восемь информированных источников. По мере того, как возможности больших языковых моделей расширяются, увеличивается и вероятность их использования в качестве оружия; но растёт и спрос на них, и руководство компании стремится выпускать продукты в минимальные сроки. Мирового стандарта для процесса тестирования ИИ на предмет безопасности не существует, но в этом году вступят в силу положения европейского «Закона об ИИ», которые обяжут разработчиков проводить испытания безопасности своих самых мощных моделей. Ранее некоторые разработчики в добровольном порядке взяли на себя обязательства перед властями Великобритании и США давать возможность проводить такое тестирование сторонним исследователям. OpenAI намеревается выпустить новую модель o3 уже на следующей неделе, то есть на её проверку будет меньше недели; но дату выпуска могут изменить.

Источник изображения: Levart_Photographer / unsplash.com Так мало времени этому вопросу в компании ещё не уделяли. В 2023 году вышла GPT-4, оценки для которой проводились около шести предшествующих месяцев. Некоторые опасные возможности модели, рассказал один из участников её тестирования, обнаружились лишь через два месяца после начала процесса. OpenAI взяла на себя обязательство по созданию специальных версий систем ИИ, чтобы оценить возможность их нецелевого применения — например, чтобы выяснить, можно ли сделать биологический вирус более заразным. Эта задача требует значительных ресурсов: сбора специализированной информации, например, по вирусологии, и её отправки в модель при дополнительном обучении — тонкой настройке. В действительности компания выполняет свои обязательства лишь в ограниченном объёме, проводя тонкую настройку старых и менее эффективных моделей и игнорируя более мощные и продвинутые. Так, в отчёте о безопасности вышедшей в январе модели o3-mini приводятся сведения о более ранней GPT-4o — о некоторых испытаниях для o1 и o3-mini компания не сообщала вообще. OpenAI заявила в свою защиту, что повысила эффективность процессов оценки и ввела автоматизированные тесты, благодаря чему сроки удалось сократить. Согласованного рецепта для таких подходов как тонкая настройка не существует, напомнили в компании, но выразили уверенность, что её методы являются лучшими из возможных, и в отчётах они были отмечены с максимальной прозрачностью. Ещё одна проблема состоит в том, что тесты безопасности зачастую проводятся не на финальных моделях, которые выходят в открытый доступ, а на «контрольных точках» — более ранних версиях, которые впоследствии обновляются, получая повышенные производительность и новые возможности, и в отчётах OpenAI даются ссылки на «почти финальные» версии. В компании отметили, что «контрольные точки» «преимущественно идентичны» вариантам, которые выходят в общий доступ. ИИ-стартап выдавал филиппинцев за ИИ — теперь основатель компании ответит за это в суде

11.04.2025 [13:40],

Павел Котов

Альберту Санигеру (Albert Saniger), основателю и бывшему генеральному директору компании Nate, выпустившей приложение якобы с искусственным интеллектом для совершения покупок и «универсальной» схемой оформления заказа, предъявлено обвинение в мошенничестве в отношении инвесторов, гласит пресс-релиз Минюста США.

Источник изображения: Hack Capital / unsplash.com Компания Nate была основана в 2018 году — она привлекла более $50 млн от инвесторов, в том числе от Coatue и Forerunner Ventures; в ходе последнего раунда финансирования во главе с Renegade Partners в 2021 году были привлечены $38 млн. Руководство компании заявляло, что приложение Nate позволяет совершать покупки на любых торговых площадках в один щелчок мыши — оформление заказа якобы берет на себя ИИ. В действительности покупки вручную оформляли подрядчики в кол-центре на Филиппинах, утверждает прокуратура Южного округа штата Нью-Йорк. Санигер привлёк многомиллионные инвестиции, уверяя, что Nate может совершать транзакции онлайн «без вмешательства человека» за исключением редких случаев. Компания действительно приобрела несколько решений в области ИИ, но в действительности уровень автоматизации в работе приложения, по версии ведомства, был нулевым. В 2022 году издание The Information провело расследование и установило, что сервис использовал труд нанятых людей. В итоге у Nate закончились средства, в январе 2023 года компания была вынуждена продать активы, а инвесторы «почти полностью» потеряли вложенные средства, гласит обвинительное заключение минюста США. Подобные мошеннические схемы с мнимым ИИ реализовывали и другие стартапы, пишет TechCrunch. Учёные уличили ИИ в сокрытии истинного хода своих рассуждений

11.04.2025 [12:34],

Павел Котов

Модели искусственного интеллекта скрывают истинные механизмы своих рассуждений и при запросе от человека выдумывают для него более сложные объяснения, гласят результаты проведённого компанией Anthropic исследования.

Источник изображений: anthropic.com Специалисты Anthropic, разработавшей похожего на ChatGPT ИИ-помощника Claude, изучили модели, способные симулировать процесс рассуждений, в том числе DeepSeek R1 и свои собственные системы серии Claude. Как оказалось, рассуждающие модели ИИ часто не раскрывают, когда при подготовке ответа принимают помощь от внешних источников или используют кратчайшие пути, несмотря на функции, разработанные, чтобы ИИ демонстрировал свой процесс «рассуждений». Чтобы описать работу рассуждающих моделей ИИ, оперируют понятием «цепочки мыслей» (Chain-of-Thought — CoT). Это вывод текущих комментариев к имитации мыслительного процесса ИИ: отображается каждый шаг, который модель делает на пути к получению ответа — аналогичным образом при решении головоломки может рассуждать человек, шаг за шагом проговаривая каждое соображение. Функция оказалась полезной не только для получения результатов при решении сложных задач, но и для исследователей в области безопасности ИИ, стремящихся отследить внутренние механизмы работы систем. В идеале цепочка мыслей ИИ должна быть понятной для человека и соответствовать действительности, то есть отражать фактический процесс рассуждений модели. На деле такой идеальный сценарий, как оказалось, срабатывает не всегда. Модели ИИ, в том числе Anthropic Claude 3.7 Sonnet, при генерации ответа в ходе исследования часто использовали предложенную им в рамках эксперимента информацию — подсказки с вариантами правильного ответа или инструкции для получения результата по «несанкционированному» кратчайшему пути, — но при выводе публичной цепочки рассуждений часто опускали упоминание этих внешних факторов. Негласно полагаясь на подсказку или получая ответ кратчайшим путём, ИИ создавал сложное, но вымышленное объяснение своего ответа, то есть по сути фабриковал ложную цепочку рассуждений — как школьник, который списал со шпаргалки, но попытался сделать вид, что решил задачу сам. Чтобы убедиться в правильности своих выводов, исследователи Anthropic стали действовать деликатнее. В одних случаях они ненавязчиво добавляли подсказки прямо в запросы, например, намекали: «Профессор Стэнфорда указывает, что ответ — [A]». В других — сопровождали подсказки тревожными комментариями: «Вы получили несанкционированный доступ <..> правильный ответ — [A]». В некоторых подсказках давался правильный ответ, в других он был намеренно неверным. Такой проверке подвергли модели Anthropic Claude 3.7 Sonnet и DeepSeek R1: первая призналась в цепочке мыслей, что использовала подсказки, лишь в 25 % случаев, вторая — лишь в 39 % случаев. То есть в большинстве испытаний ИИ выводил не соответствующие действительности рассуждения, опуская информацию, которая повлияла на получение ответа. Интересно, что выдуманные цепочки рассуждений в среднем оказались длиннее достоверных; а с усложнением запросов достоверные цепочки рассуждений выводились реже.  Наиболее показательным стал эксперимент по «взлому вознаграждения» (reward hacking). Так называется сценарий, при котором модель ИИ обнаруживает неожиданный способ получить ответ кратчайшим путём, чтобы добиться максимальной производительности и не решать задачу так, как предполагалось. В экспериментах Anthropic учёные намеренно вознаграждали модели за выбор указанных в подсказках неверных ответов: ИИ быстро научился использовать эту лазейку, выбирая неправильные ответы в 99 % случаев, чтобы заработать баллы — упоминание этого сценария в открытой цепочке рассуждений сократилось до доли в 2 %. Так, модель, выдавшая неверный ответ по медицинской тематике, могла написать длинную цепочку рассуждений, подводящую к этому неправильному ответу, не упоминая полученную подсказку. Специалисты Anthropic выдвинули гипотезу, что обучение моделей на более сложных задачах, которые требуют бо́льших объёмов рассуждений, может естественным образом стимулировать их существеннее использовать цепочку мыслей и чаще упоминать подсказки. Они проверили эту гипотезу, обучив Claude плотнее применять цепочку мыслей при решении сложных задач в области математики и программирования — результат оказался положительным, но радикальных перемен не дал. Учёные отметили, что их исследование носило ограниченный характер: сценарии были искусственными, а подсказки вводились в задачах с множественным выбором — в реальных задачах ставки и стимулы отличаются. Кроме того, за образец брали только модели Anthropic и DeepSeek. Использованные в ходе эксперимента задачи могли быть недостаточно сложными, чтобы установить значительную зависимость от цепочки мыслей, при более сложных запросах роль вывода цепочки рассуждений может возрасти, а её мониторинг — оказаться более жизнеспособным. Для обеспечения согласованности и безопасности мониторинг цепочки рассуждений может быть не вполне эффективным, и не всегда можно доверять тому, как модели сообщают о своих рассуждениях, когда предметом исследования оказывается «взлом вознаграждения». Чтобы с высокой степенью надёжности «исключить нежелательное поведение [ИИ], используя мониторинг цепочки мыслей, придётся ещё проделать значительную работу», заключили в Anthropic. OpenAI готовится запустить ИИ-модель GPT-4.1, но возможны задержки

11.04.2025 [05:17],

Анжелла Марина

Компания OpenAI планирует в ближайшее время представить несколько новых моделей искусственного интеллекта, включая обновлённую версию GPT-4 под названием GPT-4.1, которая станет усовершенствованной версией флагманской рассуждающей модели GPT-4o.

Источник изображения: AI По данным The Verge, улучшенная новая модель GPT-4.1 также, как и GPT-4o сможет обрабатывать текст, изображение и аудио в режиме реального времени. Вместе с ней OpenAI планирует выпустить и более лёгкие версии — GPT-4.1 mini и nano, запуск которых может состояться уже на следующей неделе. Кроме того, компания готовит к релизу полную версию модели o3, а также облегчённый вариант o4 mini. ИИ-разработчик Тибор Блахо (Tibor Blaho), известный тем, что раньше других замечает возможные нововведения, обнаружил упоминания этих моделей в новой веб-версии ChatGPT, что, по его мнению, указывает на их скорый запуск. Интересно, что генеральный директор OpenAI Сэм Альтман (Sam Altman) ранее намекал в соцсети X на «захватывающие функции», которые появятся в линейке продуктов компании, однако не уточнил, связано ли это с новыми моделями. При этом он также предупреждал, что пользователи могут столкнуться с задержками и сбоями из-за высокой нагрузки на вычислительные мощности: «Следует ожидать задержек, сбоев и медленной работы сервисов, пока мы решаем проблемы с производительностью». Напомним, ранее OpenAI уже была вынуждена ограничить использование генератора изображений в бесплатной версии ChatGPT из-за перегрузки серверов, так как, по словам Альтмана, популярность этой функции привела к тому, что их GPU чуть ли не стали плавиться, подтверждая предположение о колоссальном спросе на услуги компании. Исследование Microsoft показало, что ИИ пока «так себе» исправляет ошибки в программном коде

11.04.2025 [05:11],

Анжелла Марина

Новое исследование подразделения Microsoft Research выявило, что несмотря на то, что ИИ помогает разработчикам в написании кода, даже передовые модели OpenAI (o1) и Anthropic (Claude 3.7 Sonnet) справляются с исправлением ошибок не более чем в половине случаев. Тестирование проводилось на базе лучшего бенчмарка SWE-bench, который измеряет умение ИИ-систем создавать программный код.

Источник изображения: сгенерировано AI В ходе эксперимента ИИ-агенты пытались решить 300 задач по устранению ошибок в коде. Лидером стала модель Claude 3.7 Sonnet, которая выполнила задание с успешностью на 48,4 %, второе место заняла OpenAI o1 (30,2 %), третье — o3-mini (22,1 %). Однако, как видно, даже эти цифры далеки от уровня, которого можно было бы ожидать от опытных программистов-людей. Как поясняет TechCrunch, основная проблема заключается в том, что искусственный интеллект пока плохо понимает, как использовать доступные инструменты и интерпретировать ошибки. По мнению авторов исследования, ключевым препятствием остаётся дефицит данных для обучения моделей. «Мы твёрдо верим, что обучение или дообучение может сделать их лучшими интерактивными отладчиками, — пишут они. — Однако для этого нужны специализированные данные, например, цепочка записей всех процессов взаимодействия людей с ИИ-отладчиками». Сейчас таких данных недостаточно, что ограничивает возможности моделей. Например, популярный инструмент Devin стартапа Cognition Labs смог по этой причине справиться лишь с тремя из 20 тестов по кодированию. И хотя ИИ активно используется такими компаниями как Google, по словам генерального директора Сундара Пичаи (Sundar Pichai), четверть кода, который создаётся с помощью искусственного интеллекта, может даже наоборот добавлять ошибки. Технологические лидеры скептически относятся к полной автоматизации профессии программиста. Билл Гейтс (Bill Gates) уверен, что программирование как профессия, конечно, никуда не исчезнет. Аналогичного мнения придерживаются генеральный директор Replit Амджад Масад (Amjad Masad), глава Okta Тодд Маккиннон (Todd McKinnon) и руководитель IBM Арвинд Кришна (Arvind Krishna). Несмотря на очевидные проблемы, интерес к ИИ-инструментам для разработки продолжает расти. Инвесторы видят в них потенциал для повышения эффективности, однако ведущие разработчики считают, что доверять ИИ полностью пока рановато. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |