|

Опрос

|

реклама

Быстрый переход

Купить ИИ-ускоритель NVIDIA H100 стало проще — очереди уменьшились, появился вторичный рынок

26.02.2024 [20:04],

Сергей Сурабекянц

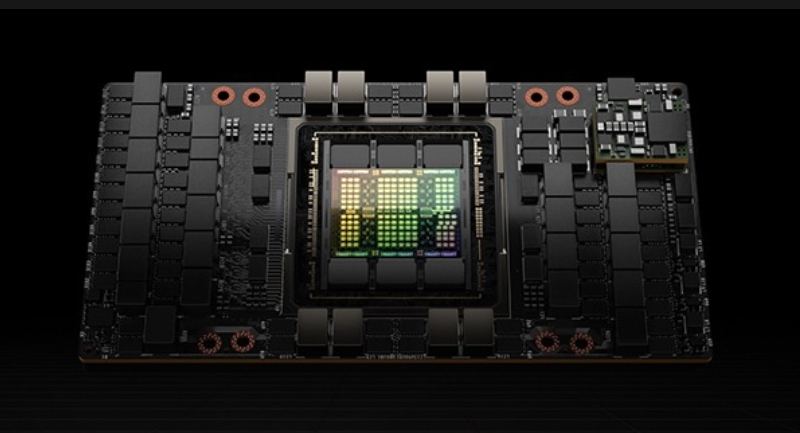

Сроки поставки графических процессоров NVIDIA H100, применяемых в приложениях ИИ и высокопроизводительных вычислениях, заметно сократились — с 8–11 до 3–4 месяцев. Аналитики полагают, что это связано с расширением возможностей аренды ресурсов у крупных компаний, таких как Amazon Web Services, Google Cloud и Microsoft Azure. В результате некоторые компании, ранее закупившие большое количество процессоров H100, теперь пытаются их продать.

Источник изображения: NVIDIA The Information сообщает, что некоторые фирмы перепродают свои графические процессоры H100 или сокращают заказы из-за снижения дефицита и высокой стоимости содержания неиспользуемых запасов. Это знаменует собой значительный сдвиг по сравнению с прошлым годом, когда приобретение графических процессоров NVIDIA Hopper было серьёзной проблемой. Несмотря на повышение доступности чипов и значительное сокращение сроков выполнения заказов, спрос на чипы ИИ всё ещё продолжает превышать предложение, особенно среди компаний, обучающих большие языковые модели (LLM). Ослабление дефицита ускорителей ИИ отчасти связано с тем, что поставщики облачных услуг упростили аренду графических процессоров NVIDIA H100. Например, AWS представила новый сервис, позволяющий клиентам планировать аренду графических процессоров на более короткие периоды, что привело к сокращению спроса и времени ожидания. Увеличение доступности ИИ-процессоров NVIDIA также привело к изменению поведения покупателей. Компании при покупке или аренде становятся более требовательными к ценам, ищут меньшие по размеру кластеры графических процессоров и больше внимания уделяют экономической жизнеспособности своего бизнеса. В результате рост сектора искусственного интеллекта значительно меньше, чем в прошлом году, сдерживается ограничениями из-за дефицита чипов. Появляются альтернативы устройствам NVIDIA, например, процессоры AMD или AWS, которые наряду с повысившейся производительностью получили улучшенную поддержку со стороны программного обеспечения. В совокупности с взвешенным подходом к инвестициям в ИИ, это может привести к более сбалансированной ситуации на рынке. Тем не менее, доступ к большим кластерам графических процессоров, необходимым для обучения LLM, до сих пор остаётся проблематичным. Цены на H100 и другие процессоры NVIDIA не снижаются, компания продолжает получать высокую прибыль и невероятными темпами наращивать свою рыночную стоимость. NVIDIA прогнозирует высокий спрос на ИИ-ускорители следующего поколения Blackwell. В поисках альтернатив Сэм Альтман (Sam Altman) из OpenAI пытается привлечь масштабное финансирование для создания дополнительных заводов по производству процессоров ИИ. Техногиганты собрались положить конец гегемонии NVIDIA на рынке ИИ-ускорителей

02.02.2024 [01:00],

Андрей Созинов

Компания Meta✴ в этом году развернёт в своих центрах обработки данных системы на ИИ-чипах собственной разработки второго поколения, пишет Reuters. Все больше технологических компаний берёт курс на создание вертикально интегрированных систем ИИ на базе собственного оборудования вместо дефицитных и дорогих ускорителей от NVIDIA, AMD и других сторонних производителей. ИИ-чип Meta✴ второго поколения, о разработке которого Meta✴ объявила в прошлом году, может помочь компании снизить зависимость от захвативших более 70 % рынка ИИ-ускорителей NVIDIA, лучше контролировать всё возрастающие расходы на ИИ. Компании необходимо наращивать вычислительные мощности для продуктов на базе генеративного ИИ, которые она внедряет в Facebook✴, Instagram✴ и WhatsApp, а также в аппаратные устройства, такие как смарт-очки Ray-Ban. Сейчас Meta✴ тратит миллиарды долларов на закупку специализированных чипов и модернизацию дата-центров. По мнению Дилана Пателя (Dylan Patel), основателя группы по рынку чипов в аналитической компании SemiAnalysis, при тех масштабах, в которых работает Meta✴, успешное внедрение собственного чипа могло бы сэкономить сотни миллионов долларов ежегодно на расходах на электроэнергию, а также миллиарды на закупке чипов. Чипы, инфраструктура и энергия, необходимые для работы систем ИИ, стали гигантской воронкой инвестиций для технологических компаний, что в некоторой степени нивелирует успехи, достигнутые на волне ажиотажа вокруг этой технологии. Представитель Meta✴ подтвердил Reuters планы по запуску производства обновленного чипа Meta✴ в 2024 году, заявив, что он будет работать в координации с сотнями тысяч уже имеющихся и новых графических процессоров. «Мы считаем, что наши собственные ускорители в значительной степени дополняют коммерчески доступные GPU, обеспечивая оптимальное сочетание производительности и эффективности в специфических для Meta✴ рабочих нагрузках», — говорится в заявлении представителя Meta✴. В прошлом месяце генеральный директор Meta✴ Марк Цукерберг (Mark Zuckerberg) заявил, что к концу 2024 года компания планирует получить около 350 000 флагманских ускорителей NVIDIA H100. По его словам, в сочетании с другими системами Meta✴ сможет накопить вычислительную мощность, эквивалентную 600 000 ускорителей H100.

ИИ-ускоритель NVIDIA H100. Источник изображения: NVIDIA Заметим, что прежде Meta✴ уже создавала собственные ИИ-чипы, но в 2022 году руководство компании приняло решение отказаться от чипа первого поколения. Вместо этого компания решила купить графические процессоры NVIDIA на миллиарды долларов. Новый чип, получивший внутреннее кодовое название Artemis («Артемида»), как и его предшественник, сможет использоваться только для запуска уже обученных нейросетей, но не для их обучения. Чип, на котором будут работать уже обученные нейросети, может быть значительно более эффективным в задачах Meta✴, чем энергоемкие чипы NVIDIA. Для обучения ИИ по-прежнему будут использоваться сторонние чипы, однако в прошлом году появлялась информация, что Meta✴ также работает над более амбициозным чипом, который также сможет выполнять и обучение, и запуск нейросетей.

ИИ-ускоритель Google Cloud TPU v5p. Источник изображения: Google Другие крупные технологические компании — Amazon, Google и Microsoft — тоже разрабатывают собственные чипы для тех или иных задач ИИ. Компании Google и Amazon уже давно выпускают чипы для собственных центров обработки данных. В конце прошлого года Google представила свой самый быстрый ИИ-ускоритель Cloud TPU v5p, а Amazon выпустила ускорители Trainium2 для обучения больших ИИ-моделей. Компания Microsoft старается не отставать и создала ИИ-ускоритель Maia 100, а также Arm-процессор Cobalt 100 — оба чипа предназначены для ускорения задач ИИ.

Система с ИИ-ускорителями Microsoft Maia 100. Источник изображения: Microsoft NVIDIA в прошлом году продала 2,5 миллиона чипов примерно по $15 000 каждый, по оценкам аналитика Пьера Феррагу (Pierre Ferragu) из New Street Research. В то же время Google потратила около $2–3 млрд на создание примерно миллиона собственных ИИ-чипов, говорит эксперт, то есть каждый чип ей обошёлся лишь в $2-3 тыс. В свою очередь, Amazon потратила $200 миллионов на 100 000 собственных чипов в прошлом году. Также недавно появились сообщения, что OpenAI, разработчик ChatGPT, тоже заинтересовалась созданием собственного чипа. Глава компании Сэм Альтман (Sam Altman) уже ведёт переговоры с инвесторами и контрактными производителями чипов. Таким образом, всё больше компаний старается избавиться от зависимости от NVIDIA, ускорители которой хоть и являются лучшими на рынке, но являются крайне дефицитным товаром (заказы на них расписаны на год вперёд), а также стоят отнюдь не мало. Cоздан сверхкомпактный ускоритель частиц с энергией в 10 миллиардов электрон-вольт

01.12.2023 [23:09],

Николай Фрей

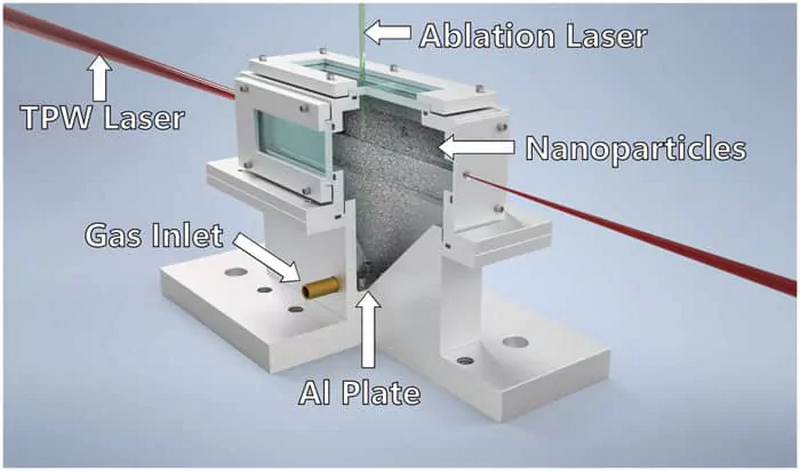

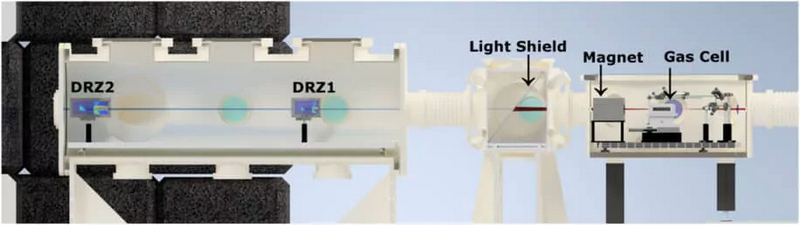

Учёные из Техасского университета в Остине создали «Усовершенствованный лазерный ускоритель кильватерного поля», который имеет очень компактные размеры, но при этом генерирует высокоэнергетический пучок электронов — до 10 ГэВ или 10 миллиардов электрон-вольт. Это настоящий прорыв в области ускорителей частиц.  Источник изображения: Bjorn «Manuel» Hegelich Учёные продолжают изучать возможности применения этой технологии, включая потенциал ускорителей частиц в полупроводниковой технологии, медицинской визуализации и терапии, исследованиях в области материалов, энергетики и медицины. Недавно группа учёных разработала компактный ускоритель частиц, получивший название «усовершенствованный лазерный ускоритель кильватерного поля». Устройство при длине менее 20 метров генерирует электронный пучок с энергией 10 миллиардов электрон-вольт, утверждается в заявлении Техасского университета в Остине. Сам лазер работает в 10-сантиметровой камере, что значительно меньше традиционных ускорителей частиц, которым требуются километры пространства.  Работа ускорителя опирается на инновационный механизм, в котором вспомогательный лазер воздействует на гелий. Газ подвергается нагреву до тех пор, пока не переходит в плазму, которая, в свою очередь, порождает волны. Эти волны обладают способностью перемещать электроны с высокой скоростью и энергией, формируя высокоэнергетический электронный луч. Таким образом получается уместить ускоритель в одном помещении, а не строить огромные системы километрового масштаба. Данный ускоритель был впервые описан ещё в 1979 году исследовательской группой из Техасского университета под руководством Бьорна «Мануэля» Хегелича (Bjorn «Manuel» Hegelich), физика и генерального директора TAU Systems. Однако недавно в конструкцию был внесен ключевой элемент: использование металлических наночастиц. Эти наночастицы вводятся в плазму и играют решающую роль в увеличении энергии электронов в плазменной волне. В результате электронный луч становится не только более мощным, но и более концентрированным и эффективным. Бьорн «Мануэль» Хегелич, ссылаясь на размер камеры, в которой был получен пучок, отметил: «Теперь мы можем достичь таких энергий на расстоянии в 10 сантиметров».  Исследователи использовали в своих экспериментах Техасский петаваттный лазер, самый мощный импульсный лазер в мире, который излучал сверхинтенсивный световой импульс каждый час. Один импульс петаваттного лазера примерно в 1000 раз превышает установленную в США электрическую мощность, но длится всего 150 фемтосекунд — примерно миллиардную долю от продолжительности удара молнии. Учёные намерены использовать эту технологию для оценки устойчивости космической электроники к радиации, получения трёхмерных визуализаций новых полупроводниковых чипов, а также для создания новых методов лечения рака и передовой медицинской визуализации. Кроме того, этот ускоритель может быть использован для работы другого устройства, называемого рентгеновским лазером на свободных электронах, который может снимать замедленные видеоролики процессов в атомном или молекулярном масштабе. Примеры таких процессов включают взаимодействие между лекарствами и клетками, изменения внутри батарей, которые могут привести к воспламенению, а также химические реакции, происходящие в солнечных батареях, и трансформацию вирусных белков при заражении клеток. Команда проекта намерена сделать систему ещё более компактной. Они хотят создать лазер, который помещается на столешнице и способен выдавать импульсы множество раз в секунду. Это значительно повысит компактность всего ускорителя и расширит возможности его применения в гораздо более широком диапазоне по сравнению с обычными ускорителями. NVIDIA продала почти полмиллиона ИИ-ускорителей в третьем квартале, а новые партии расписаны на год вперёд

28.11.2023 [07:13],

Николай Хижняк

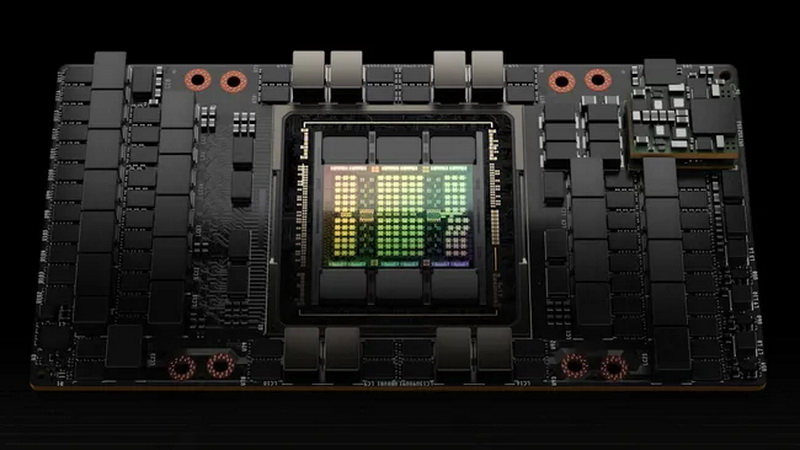

Основная доля выручки NVIDIA в размере $14,5 млрд в сегменте оборудования для центров обработки данных в третьем квартале пришлась на продажи специализированных графических ускорителей H100 для ИИ и высокопроизводительных вычислений (HPC). По мнению аналитической компании Omdia, NVIDIA продала в третьем квартале этого года почти полмиллиона ускорителей A100 и H100, а спрос на эти продукты настолько высок, что срок поставок серверов с ними увеличился с 36 до 52 недель.

Источник изображения: NVIDIA Эксперты Omdia считают, что крупнейшими покупателями графических ускорителей NVIDIA H100 являются компании Meta✴ и Microsoft. По мнению аналитиков, каждая из них закупила по 150 тыс. указанных ускорителей. В свою очередь Google, Amazon, Oracle и Tencent купили по 50 тыс. указанных специализированных ускорителей. Примечательно, что основная часть серверных ускорителей поставляется операторам гипермасштабируемых облачных услуг. В свою очередь, OEM-производители серверов (Dell, Lenovo, HPE) пока не могут забронировать достаточное количество графических процессоров для ИИ и высокопроизводительных вычислений, чтобы выполнить свои заказы на поставки серверов, утверждают специалисты Omdia. Аналитики полагают, что продажи ускорителей NVIDIA H100 и A100 превысят полмиллиона единиц в четвертом квартале 2023 года. Между тем, спрос на H100 и A100 настолько велик, что срок поставки серверов на базе этих GPU достигает 52 недель. В то же время Omdia сообщает, что в целом объём поставок серверов в 2023 году сократится на 17–20 % по сравнению с прошлым годом, но при этом выручка в этом направлении вырастет на 6–8 % в годовом исчислении. Следует также отметить, что многие из крупнейших покупателей специализированных ускорителей NVIDIA H100 и A100 сами разрабатывают собственные специализированные GPU для задач ИИ, высокопроизводительных вычислений и графики. Поэтому в перспективе объёмы закупок оборудования у NVIDIA этими компаниями снизятся по мере перехода на собственные решения. В Omdia также прогнозируют, что рынок серверов в целом вырастет до $195,6 млрд к 2027 году. Одним из драйверов этого роста послужит переход к специализированным серверным системам, в которых будут применяться наборы разнообразных сопроцессоров, предназначенных под конкретные виды задач. Примером уже могут служить серверы компании Amazon для ИИ, в которых применяются 16 специализированных сопроцессоров Inferentia 2, а также серверы кодирования видео компании Google, оснащающиеся 20 специальными VCU или чипами видеокодирования. Компания Meta✴ также последовала этому примеру и выпустила серверы, оснащённые 12 специальными процессорами для обработки видео. Отмечается, что интерес к использованию специализированных сопроцессоров, оптимизированных для выполнения определённых задач, будет расти по мере внедрения технологий, которые позволят снизить стоимость производства данных чипов. Ключевыми областями применения таких чипов сейчас являются ИИ и медиа, однако в дальнейшем, как ожидается, они также найдут своё применение в сегментах управления базами данных и веб-сервисах. NVIDIA намерена перейти на ежегодное обновление архитектуры GPU — как минимум, для ИИ

10.10.2023 [21:49],

Сергей Сурабекянц

Стремясь сохранить своё лидерство в области ускорителей ИИ и высокопроизводительных вычислений (HPC), NVIDIA планирует ускорить разработку новых архитектур графических процессоров и, по сути, вернуться к годовому графику внедрения новых продуктов. Судя по планам, представленным инвесторам, графические процессоры поколения Blackwell должны увидеть свет в 2024 году, а уже в 2025 году на смену ему придёт новая архитектура, пока не имеющая названия и обозначенная как X.

Источник изображения: NVIDIA До выпуска Blackwell, который ожидается во второй половине следующего года, NVIDIA представит несколько новых продуктов на базе своей актуальной архитектуры Hopper. Ожидается ускоритель H200, созданный на базе H100, а также GH200NVL, предназначенный для работы с большими языковыми моделями (LLM) совместно с процессорами Arm. В семействе Blackwell в 2024 году NVIDIA, похоже, представит ускоритель вычислений B100 для платформ x86, который придёт на смену H100. Компания также готовит GB200, который предположительно представляет собой преемника для вычислительной системы Grace Hopper, которая объединяет процессор Arm и графический процессор Hopper. И ещё выйдет GB200NVL — решение на базе Arm для обучения и работы c LLM. В планах также представлен продукт B40, предположительно клиентское решение на базе графического процессора для вывода ИИ. В 2025 году на смену Blackwell придёт архитектура, пока обозначенная буквой X. Аналогично поколению Blackwell будут представлены продукты X100, GX200 и GX200NVL. В потребительском сегменте X40 придёт на смену B40. На данный момент NVIDIA лидирует на рынке графических процессоров для искусственного интеллекта, но AWS, Google, Microsoft, AMD и другие игроки в области искусственного интеллекта и высокопроизводительных вычислений готовят собственные решения для работы с ИИ, поэтому NVIDIA вынуждена реагировать и вносить корректировки в свои планы. Сообщается, что для дальнейшего укрепления своих позиций NVIDIA заранее зарезервировала мощности TSMC и приобрела память HBM у всех трёх мировых производителей. Параллельно компания продвигает свои серверы HGX и MGX, стремясь коммерциализировать эти машины и сделать их популярными среди конечных пользователей, особенно в сегменте корпоративного искусственного интеллекта. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |