|

Опрос

|

реклама

Быстрый переход

Anthropic представила Claude Sonnet 4.5 — «лучший в мире» ИИ для программирования и сложных вычислений

29.09.2025 [21:55],

Андрей Созинов

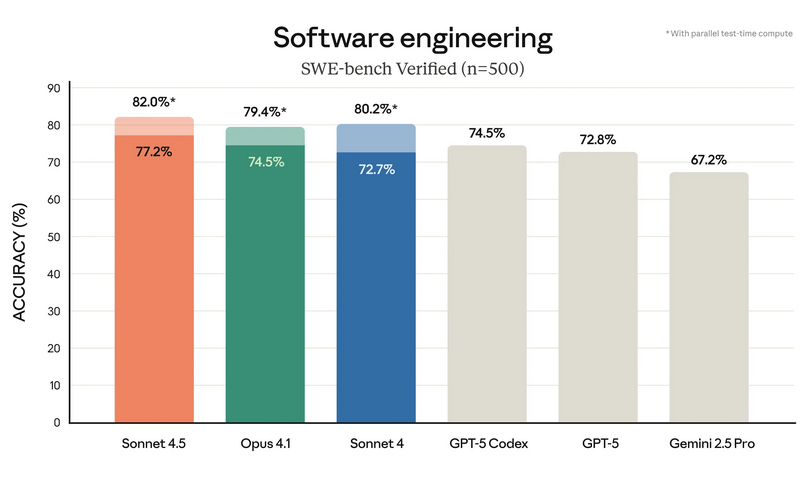

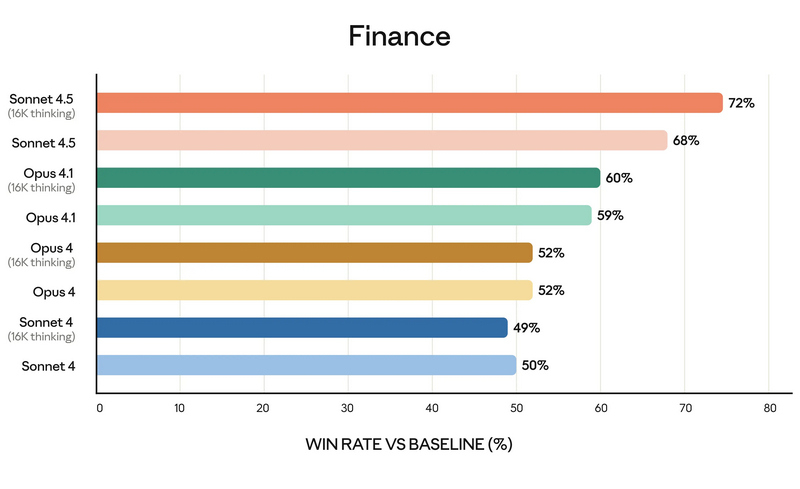

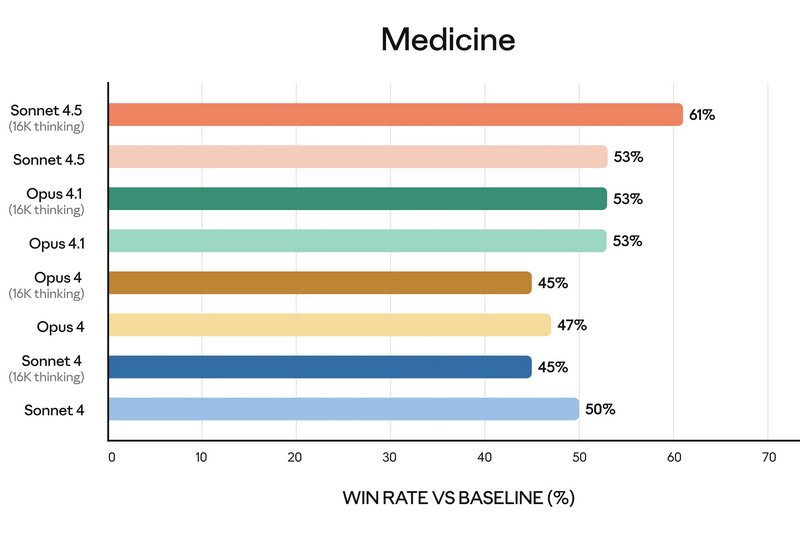

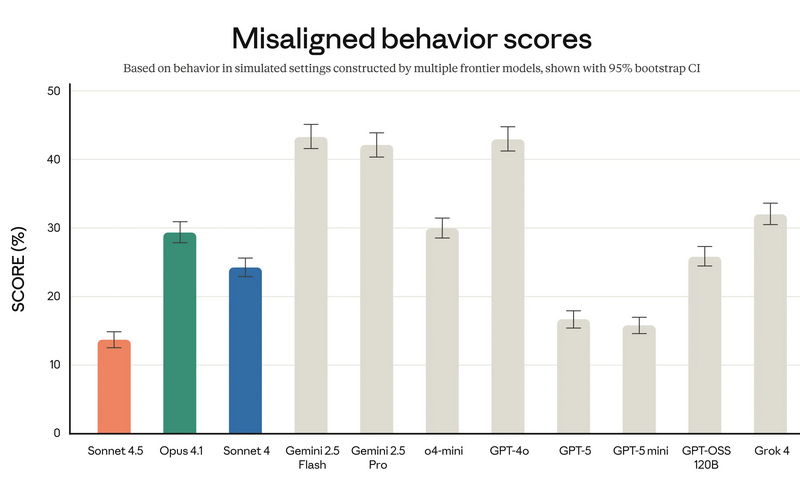

Компания Anthropic анонсировала Claude Sonnet 4.5 — самую мощную на сегодняшний день большую языковую модель в семействе Claude. По словам разработчиков, она ориентирована на программирование, построение ИИ-агентов и решение сложных задач. A Anthropic заверили, что Sonnet 4.5 стал не только лидером в профильных бенчмарках, но и демонстрирует заметный скачок в понимании программного кода, математических вычислениях и управлении компьютером.  Claude Sonnet 4.5 занял первую строчку в SWE-bench Verified — отраслевом тесте, который измеряет реальные способности ИИ-моделей к написанию и анализу программного кода. По данным Anthropic, Sonnet 4.5 способен поддерживать концентрацию более 30 часов при работе над сложными многоэтапными задачами, обходя предыдущие версии Claude и ближайших конкурентов.  В тесте OSWorld, проверяющем работу ИИ с реальными компьютерными задачами, Sonnet 4.5 показал результат 61,4 % против 42,2 % у версии Sonnet 4, что иллюстрирует резкий рост производительности за последние месяцы. Новая модель показала себя не только в программировании. По результатам внутренних и независимых тестов, Sonnet 4.5 демонстрирует серьёзный прогресс в задачах логического вывода и математики, а также в специализированных областях: финансах, медицине, праве и STEM-дисциплинах. Разработчики отмечают рост качества генерации и анализа кода, управление файлами и сложными вычислениями в реальном времени.   Появился и экспериментальный режим Imagine with Claude: теперь ИИ может создавать программные решения буквально «на лету», полностью адаптируя код под текущие запросы пользователя. Одновременно с выпуском Sonnet 4.5 компания представила крупные обновления экосистемы Claude. В сервисе Claude Code появились чекпоинты для сохранения прогресса, обновлённый терминал и нативное расширение для Visual Studio Code. В приложениях Claude теперь доступна непосредственная работа с кодом, создание файлов (включая таблицы, презентации и документы) прямо в диалоге, а пользователи с подпиской Max получили расширение для Chrome. Для разработчиков открыт новый набор инструментов — Claude Agent SDK. Он позволяет создавать собственных интеллектуальных агентов на базе тех же технологий, что лежат в основе Claude Code. SDK реализует сложную работу с памятью, управлением правами и координацией подзадач между агентами — то есть открывает возможности построения продвинутых решений под любые задачи.  Помимо того, что Claude Sonnet 4.5 стала самой способной, она также стала самой «воспитанной» ИИ-моделью компании: снижено количество опасных и нежелательных паттернов поведения, таких как подыгрывание пользователю, попытки обойти ограничения или выполнение вредных запросов. В рамках защиты пользователей, Anthropic применяет многоуровневые фильтры (AI Safety Level 3), особенно в отношении тем, связанных с химическими, биологическими, ядерными и другими видами оружия. Также фильтры стали точнее: количество ложных срабатываний удалось снизить в 10 раз по сравнению с предыдущими релизами. Claude Sonnet 4.5 уже доступен для всех пользователей через веб-версию чат-бота, а также в мобильных приложениях. Также новая ИИ-модель доступна API по цене старой (от $3 за миллион токенов). Новые возможности Claude Code и Agent SDK доступны всем разработчикам и корпоративным клиентам. Microsoft снизила зависимость от OpenAI — в Microsoft 365 Copilot появились ИИ-модели Claude от Anthropic

24.09.2025 [20:57],

Анжелла Марина

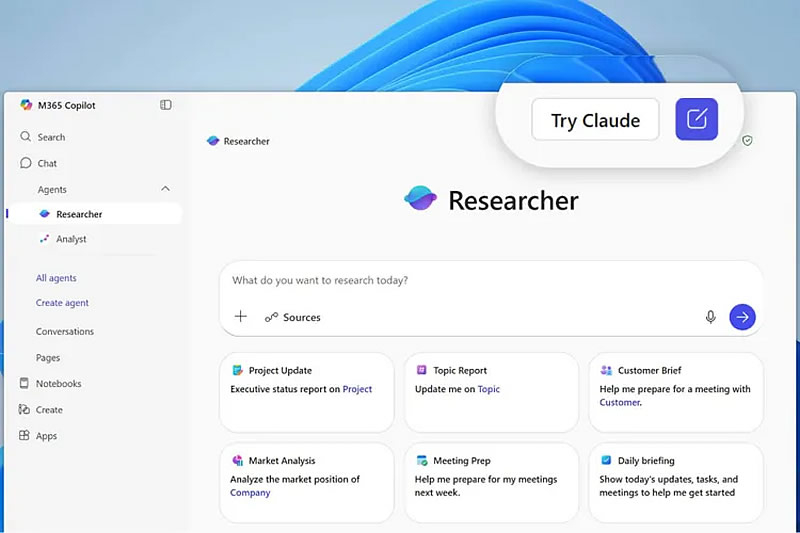

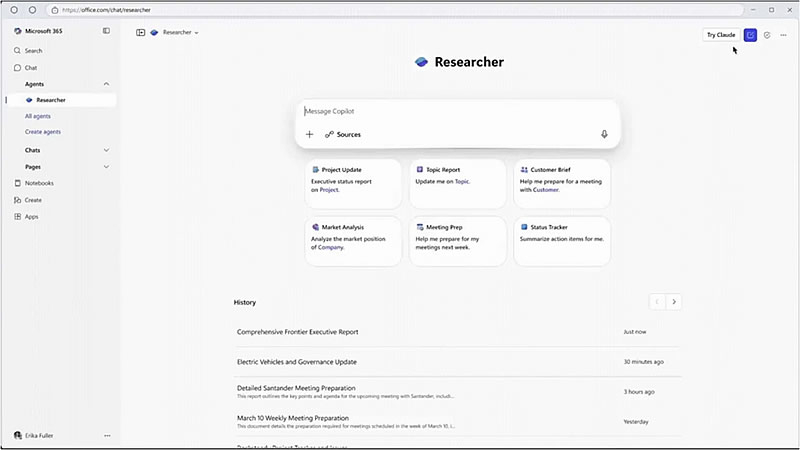

Microsoft начала интеграцию ИИ-моделей Claude Sonnet 4 и Claude Opus 4.1 от компании Anthropic в свои офисные приложения Microsoft 365 Copilot. Это расширит выбор моделей и позволит клиентам использовать технологии Anthropic в агенте «Исследователь» (Researcher) и при создании ИИ-агентов в Microsoft Copilot Studio.

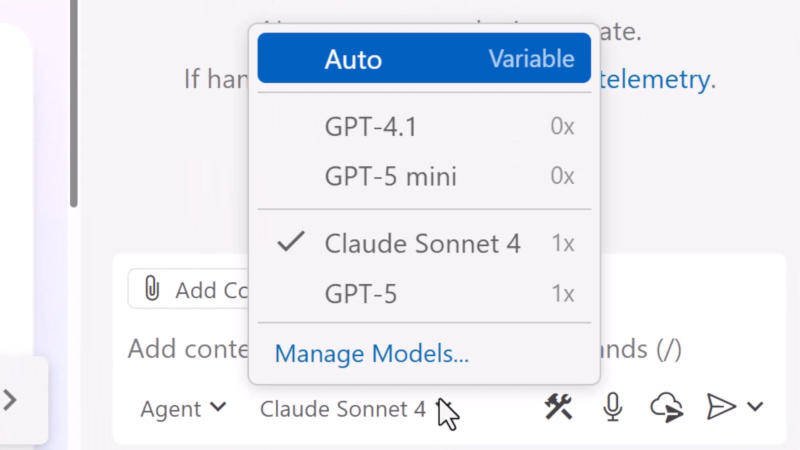

Источник изображений: Microsoft Сегодня пользователи Microsoft 365 Copilot получили возможность подключить модели Anthropic через программу Frontier. В приложении Researcher появилась кнопка «Попробовать Claude», которая переключает систему с моделей OpenAI на Claude Opus 4.1. После подключения можно легко переключаться между ИИ-движками в рамках одного инструмента, сообщает The Verge, ссылаясь на заявление президента подразделения Microsoft по разработке Copilot для бизнеса и отраслей Чарльза Ламанна (Charles Lamanna). Модели Claude Sonnet 4 и Claude Opus 4.1 также станут доступны в Microsoft Copilot Studio — платформе для создания и управления ИИ-агентами. По словам Ламанна, это позволит разрабатывать инструменты для глубокого анализа, автоматизации рабочих процессов и выполнения гибких агентных задач. При этом в Copilot Studio можно будет комбинировать модели от разных поставщиков, включая Anthropic, OpenAI и других, представленных в каталоге моделей Azure.  Примечательно, что, несмотря на интеграцию, сами модели Anthropic продолжат размещаться на инфраструктуре главного облачного конкурента Microsoft — Amazon Web Services. Доступ к этим ИИ Microsoft будет осуществлять через публичный API Anthropic, то есть стандартно, как и любой сторонний разработчик. Однако ранее компания уже заключила соглашение с xAI о размещении модели Grok 3 в облаке Azure, и аналогичное соглашение с Anthropic в будущем не исключается. Данное объявление последовало всего через неделю после того, как Microsoft начала отдавать предпочтение Anthropic перед OpenAI в среде Visual Studio Code, где платные пользователи GitHub Copilot теперь в основном используют Claude Sonnet 4. Сообщается также, что в ближайшее время модели Anthropic могут быть задействованы в Excel и PowerPoint, поскольку они показали более высокую производительность по сравнению с моделями OpenAI. Microsoft обратилась к ИИ от Anthropic для Visual Studio Code — OpenAI больше не в почёте

17.09.2025 [16:37],

Павел Котов

Microsoft долгое время выступала как финансовая опора OpenAI, но теперь софтверный гигант всё больше обращается к моделям искусственного интеллекта от Anthropic — тёплые отношения с OpenAI не всегда оказываются важнее конкретных результатов работы. Финансирование разработчика ChatGPT не гарантирует эксклюзивного характера отношений.

Источник изображения: visualstudio.com Во флагманской среде написания кода Visual Studio Code компания сделала выбор в пользу Anthropic Claude Sonnet 4, а не OpenAI GPT-5. Компания развернула функцию автоматического выбора модели ИИ для GitHub Copilot — она предполагает установку оптимального варианта помощи при написании кода. Пользователям на платных тарифах теперь будет предлагаться Claude Sonnet 4; в бесплатных вариантах останется комбинированная версия, которая включает в себя GPT-5 и GPT-5 mini. Microsoft уже не первый месяц негласно рекомендует инженерам пользоваться моделями Anthropic, сообщило издание The Verge со ссылкой на осведомлённые источники. «Согласно внутренним тестам, Claude Sonnet 4 является рекомендованной моделью для GitHub Copilot», — заявила ещё до выхода GPT-5 глава отдела разработки Microsoft Джулия Льюсон (Julia Liuson); позиция компании по данному вопросу не изменилась и сейчас. В течение последних лет Microsoft активно инвестировала в OpenAI — с 2019 года корпорация вложила в стартап более $13 млрд; сейчас отношения между компаниями регулируются сложными соглашениями о распределении доходов. При этом OpenAI может пользоваться услугами конкурирующих с Microsoft облачных провайдеров. Софтверный гигант и сам пытается страховать риски, разрабатывая собственные системы ИИ: компания обучила модель MAI-1-preview на 15 000 ускорителях Nvidia H100, что является скромным показателем по современным меркам, рассказал глава профильного подразделения Мустафа Сулейман (Mustafa Suleyman). Более эффективные, как показали тесты Microsoft, модели Anthropic будут использоваться и в некоторых приложениях пакета Microsoft 365, в том числе Excel и PowerPoint. Microsoft развивает стратегию в области ИИ и стремится сбалансировать надёжное партнёрство с OpenAI, привлекая альтернативных поставщиков, если им есть что предложить. Это могут быть более эффективные средства написания кода в Visual Studio Code или создания документов в приложениях Microsoft 365. Выбор моделей Anthropic по умолчанию просто свидетельствует, что для Microsoft практическая эффективность выше корпоративной преданности. Microsoft сократит зависимость от OpenAI, расширив сотрудничество с Anthropic

10.09.2025 [07:38],

Алексей Разин

Крупнейшим инвестором OpenAI до сих пор являлась Microsoft, но условия готовящейся реструктуризации первой не в полной мере устраивают вторую. Так или иначе, Microsoft намерена снизить свою зависимость от языковых моделей OpenAI, а последняя будет развивать собственную вычислительную инфраструктуру и может создать конкурента для LinkedIn.

Источник изображения: Anthropic Как отмечает TechCrunch со ссылкой на The Information, корпорация Microsoft намеревается заключить с Anthropic оглашение об использовании её языковых моделей в сервисе Office 365. Приложения Word, Excel, Outlook и PowerPoint получат ИИ-функции, реализованные при помощи как разработок OpenAI, так и разработок Anthropic. Противоречия между Microsoft и OpenAI по поводу грядущей реструктуризации не имеют отношения к данному решению, как отмечает источник. Просто на платформе Anthropic удаётся лучше реализовать работу некоторых ИИ-ассистентов типа функции создания презентаций по текстовому запросу. В частности, в этой сфере лучше решений OpenAI проявляет себя модель Claude Sonnet 4 компании Anthropic. Это не первый случай отступления Microsoft от платформы OpenAI. Первая предлагает в GitHub Copilot возможности интеграции с Anthropic Claude и Grok компании xAI. Кроме того, в последнее время Microsoft прилагает усилия к разработке собственных языковых моделей MAI-Voice-1 и MAI-1-preview. Для OpenAI сотрудничество с Microsoft тоже не является исключительным, хотя она серьёзно зависит от этого партнёра из-за использования вычислительной инфраструктуры Azure. Недавно стало известно, что в сотрудничестве с Broadcom со следующего года будут налажены поставки чипов OpenAI собственной разработки, которые позволят последней развивать собственную вычислительную инфраструктуру более активно и эффективно. Кроме того, OpenAI намеревается создать платформу для поиска работы и размещения вакансий, которая составит конкуренцию Microsoft LinkedIn. Anthropic согласилась выплатить $1,5 млрд по иску об авторских правах

06.09.2025 [08:32],

Алексей Разин

С момента распространения систем искусственного интеллекта материалом для их обучения служили различные произведения искусства, и владельцев авторских прав на них это не устраивало. В случае с Anthropic соответствующий иск от группы авторов дошёл до суда, и теперь компании предстоит выплатить авторам литературных произведений компенсацию в размере не менее $1,5 млрд.

Источник изображения: Anthropic В конце июня, как отмечает NBC News, суд вынес предварительное решение, которое признавало использование компанией Anthropic литературных произведений, упоминаемых в иске, правомерным, поскольку результат подразумевал их существенную переработку. При этом суд постановил, что само по себе использование пиратских копий произведений, которые были получены Anthropic из нелегальных онлайн-библиотек Library Genesis и Pirate Library Mirror, было незаконным. Группа авторов при этом настаивала на выплате Anthropic компенсации в свой адрес из расчёта в среднем $3000 за каждое использованное литературное произведение, коих набралось не менее 500 000 штук. Таким образом, теперь компании предстоит в течение пяти рабочих дней направить в специальный фонд первые $300 000 компенсации после того, как решение суда вступит в законную силу. При этом сумма в $1,5 млрд является минимальным порогом компенсации. По факту, выплаты могут оказаться выше, поскольку Anthropic должна будет дополнительно перечислить в фонд по $3000 за каждое произведение сверх упомянутых 500 000, если обнаружится, что изначальный список не был исчерпывающим. Сумма компенсации станет крупнейшей в истории судебной практики по делам, связанным с нарушением авторских прав. Anthropic получила оценку в $183 млрд — на 40 % дешевле OpenAI

02.09.2025 [22:07],

Николай Хижняк

Стартап в области искусственного интеллекта Anthropic, стоящий за семейством языковых моделей Claude и являющийся одним из главных конкурентов OpenAI, сообщил о привлечении $13 млрд дополнительного финансирования. Благодаря этому компания получила рыночную оценку в $183 млрд.

Источник изображения: Anthropic В своём пресс-релизе Anthropic сообщила, что с начала 2025 года по август, то есть менее чем за девять месяцев текущего года, её доход от продаж вырос примерно с $1 млрд до более чем $5 млрд. Компания также заявила, что теперь у неё более 300 000 корпоративных клиентов, а за последний год список «крупных клиентов» — то есть тех, кто приносит более $100 000 выручки от текущих продаж, — увеличился в семь раз. Что касается Claude Code, агентного ИИ-помощника по программированию и одного из главных источников дохода компании, на который Anthropic делает ставку, продукт уже принёс более $500 млн выручки от текущих продаж, а количество пользователей выросло более чем в десять раз за три месяца с момента его «полного запуска». Среди инвесторов последнего раунда финансирования Anthropic отметились компании Qatar Investment Authority, TPG, Altimeter, Blackstone, Coatue, General Catalyst и другие. По словам Anthropic, полученные средства частично будут использованы для «удовлетворения растущего спроса со стороны предприятий, углубления исследований в области безопасности и поддержки международной экспансии» её продуктов. Добавим, что главный конкурент Anthropic в лице OpenAI в апреле получил оценку в $300 млрд, а в августе сообщалось, что в рамках нового раунда финансирования компания может быть оценена в $500 млрд. Anthropic начнёт обучать ИИ на диалогах пользователей, но её можно попросить так не делать

29.08.2025 [11:04],

Павел Котов

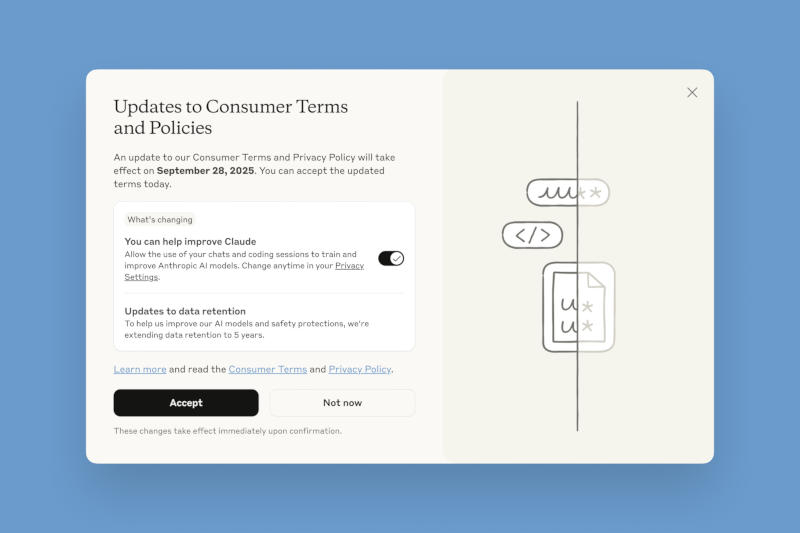

Anthropic внесла важные изменения в политику обработки данных пользователей и предложила им до 28 сентября принять решение, хотят ли они использовать свою переписку с чат-ботом для обучения моделей искусственного интеллекта.

Источник изображений: Anthropic Ранее Anthropic не использовала журналы чатов для обучения моделей — пользователей заверяли, что их запросы и ответы чат-ботов автоматически удаляются из систем в течение 30 дней «за исключением случаев, когда требования закона или политики [компании] предусматривают более продолжительный срок». Если запросы получали отметку как нарушающие правила обслуживания, то они хранились до двух лет. Теперь же она решила добавить в массивы обучающих данных обычную переписку и сессии с написанием программного кода — если пользователь даст согласие, эти данные будут храниться пять лет. Речь идёт только о потребительском сегменте сервиса, то есть о частных пользователях Claude Free, Pro и Max, в том числе тех, кто работает с Claude Code. У пользователей корпоративного сектора, в том числе сервисов Claude Gov, Claude for Work, Claude for Education, а также работающих через API компания собирать данные переписок для обучения ИИ не намерена. В стремлении убедить пользователей согласиться на новую политику обработки данных Anthropic отмечает, что так они «помогут нам повысить безопасность модели, сделав наши системы обнаружения вредоносного контента более точными и снизив вероятность реагирования на безобидные разговоры». Согласившись передавать журналы переписки на обучение ИИ, пользователи «также помогут нашим будущим моделям Claude улучшить такие навыки как программирование, анализ и рассуждения, что в конечном счёте приведёт к созданию более качественных моделей для всех». И действительно, отмечает TechCrunch, для обучения передовых моделей ИИ требуются колоссальные объёмы высококачественных разговорных данных, и доступ к миллионам чатов с Claude откроет ей источник материалов, способных улучшить позиции Anthropic как конкурента OpenAI и Google.  К нужному выбору компания подталкивает пользователей, делая нужные акценты в интерфейсе сервисов. Тем, кто только регистрируется, дают (или не дают) согласие при заполнении профиля; существующим же выводится всплывающее окно с заголовком «Обновления условий и политики для потребителей», включённым по умолчанию триггером согласия на передачу данных и большой чёрной кнопкой «Принять». Увидев такое окно, невнимательный или равнодушный пользователь может быстро нажать эту кнопку, не вдаваясь в подробности. Хакер сделал конкурента ChatGPT соучастником вымогательской кампании: ИИ искал уязвимости и писал угрозы

27.08.2025 [23:15],

Анжелла Марина

Компания Anthropic раскрыла детали беспрецедентной хакерской атаки, в которой злоумышленник использовал её ИИ-ассистента для полной автоматизации масштабной кампании по краже данных с целью вымогательства. Инцидент затронул не менее 17 организаций, включая государственные учреждения, больницы, экстренные службы, религиозные организации и подрядчика оборонной отрасли.

Источник изображения: Max Bender/Unsplash По сообщению PCMag, хакер автоматизировал атаку, использовав агентную среду выполнения Claude Code для поиска уязвимостей, сбора учётных данных и проникновения в защищённые сети организаций. ИИ помог злоумышленнику похитить личные записи, включая медицинские данные, финансовую информацию и правительственные идентификационные документы. Затем Claude проанализировал их на предмет размера выкупа, который варьировался от 75 000 до 500 000 долларов в биткоинах, а также сгенерировал визуально пугающие тексты с требованиями, отображавшиеся на компьютерах жертв. Несмотря на встроенные средства защиты, хакер смог обойти ограничения, загрузив в чат файл конфигурации с легендой о проведении тестирования сетевой безопасности якобы по официальному контракту. Этот файл содержал детальные методики атак и схемы последовательности выполнения задач на основе их значимости. В ходе всего процесса Claude использовался для сканирования уязвимых сетей с высоким процентом успеха, а также для создания вредоносного программного обеспечения и других инструментов, предназначенных для обхода защитных механизмов антивирусной программы Windows Defender. В отличие от предыдущих случаев, когда ИИ применялся хакерами лишь для вспомогательных задач, таких как написание фишинговых писем или анализ уязвимостей, в данном инциденте ИИ-модель выступала не только консультантом, но и активным исполнителем атак. Представители Anthropic подчеркнули, что это «свидетельствует о новом этапе в развитии киберпреступности с участием искусственного интеллекта, когда ИИ становится полноценным оператором в цепочке атак». Компания ожидает, что всё больше хакеров будут применять подобные методы. В том же отчёте упоминается о другом, возможно начинающем злоумышленнике, который использовал Claude для разработки, продвижения и продажи нескольких вариантов программ-вымогателей. По словам Anthropic, данный пользователь был полностью зависим от ответов ИИ и без помощи Claude не смог бы реализовать или устранить неполадки ключевых компонентов вредоносного ПО. Отдельно сообщается, что компания-разработчик антивирусного программного обеспечения ESET также обнаружила новую программу-вымогателя, использующую открытую модель OpenAI для генерации злонамеренного кода на заражённых устройствах. Anthropic выпустила ИИ-агента Claude для Google Chrome — доступен он лишь 1000 человек в мире

27.08.2025 [15:51],

Павел Котов

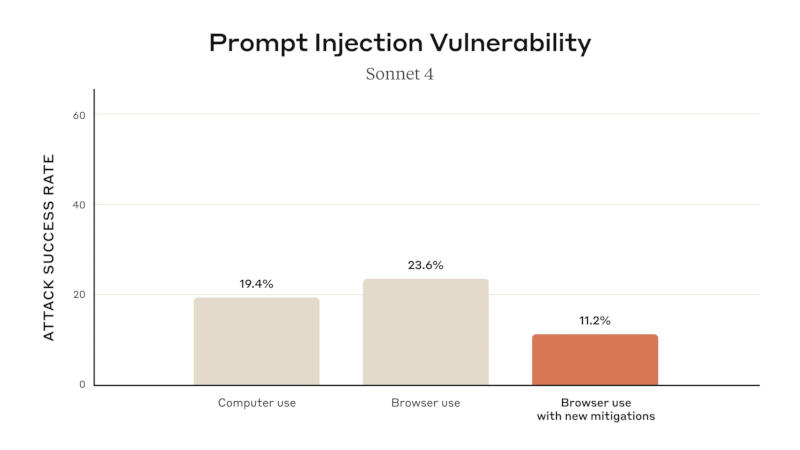

Anthropic объявила о выходе предварительной версии браузерного агента искусственного интеллекта, работающего на базе моделей Claude. Воспользоваться предложением пока может лишь группа из тысячи подписчиков тарифного плана Anthropic Max по цене от $100 до $200 в месяц — для остальных заинтересованных пользователей открыт список ожидания.

Источник изображений: anthropic.com ИИ-агент устанавливается в Chrome вместе с расширением — появляется боковое окно, где можно переписываться с чат-ботом Claude, который находится в контексте происходящего в браузере. Пользователь может дать ИИ-агенту разрешение выполнять некоторые действия от его имени. Anthropic предупредила, что рост числа ИИ-агентов чреват новыми угрозами безопасности — одну из них недавно обнаружили в браузере Perplexity Comet. В рамках программы тестирования компания рассчитывает выявить и устранить новые уязвимости. К примеру, развёрнуты несколько средств защиты от атак с использованием «инъекций запросов», при которых вредоносная инструкция для ИИ в скрытом виде размещается на странице просматриваемого сайта — принятые меры помогли снизить их успешность с 23,6 % до 11,2 %. В настройках агента можно ограничить его доступ к определённым сайтам; по умолчанию он заблокирован для ресурсов, предлагающих финансовые услуги, материалы для взрослых и пиратский контент. Кроме того, Claude запрашивает разрешение пользователя перед «выполнением операций повышенного риска, таких как публикация, покупка или обмен персональными данными».  В прошлом году Anthropic выпустила ИИ-агента для управления компьютером, но на практике он оказался медленным и ненадёжным. За прошедшее время возможности этой технологии заметно улучшились — Comet и ChatGPT Agent вполне справляются с выполнением несложных задач. Anthropic увернулась от иска за обучение ИИ на электронных книгах с помощью «исторического соглашения»

27.08.2025 [12:34],

Владимир Фетисов

Компания Anthropic добилась урегулирования коллективного иска, который был подан группой американских писателей, обвинивших разработчика в сфере ИИ в нарушении авторских прав. В судебном заявлении, которое Anthropic подала на этой неделе, сказано, что компания достигла договорённости в рамках «предложенного урегулирования», которое позволит ей избежать судебного разбирательства.

Источник изображения: Anthropic Условия соглашения неизвестны, но отмечается, что речь идёт об иске о нарушении авторских прав, который в прошлом году подали писатели Андреа Бартц (Andrea Bartz), Чарльз Гребер (Charles Graeber) и Кирк Уоллес Джонсон (Kirk Wallace Johnson). Они обвинили Anthropic в том, что компания обучала ИИ-модели Claude на находящихся в открытом доступе данных, в том числе пиратском контенте. Anthropic сумела одержать победу в суде в июне, когда судья Уильям Алсуп (William Alsup) постановил, что обучение ИИ-моделей на данных книг, приобретённых законным путём считается легитимным. При этом он оставил возможность для дальнейших судебных разбирательств по данному вопросу. В июле Алсуп удовлетворил коллективный иск американских писателей, которые обвинили Anthropic в нарушении авторских прав и использовании пиринговой сети Napster для загрузки миллионов произведений. По данным источника, Anthropic должна была предстать перед судом по обвинению в пиратстве в декабре этого года. Компании грозили многомиллиардные штрафы. Ожидается, что мировое соглашение между Anthropic и группой истцов будет окончательно оформлено 3 сентября. «Это историческое соглашение принесёт пользу всем участникам группы. Мы с нетерпением ждём объявления деталей соглашения в ближайшие недели», — прокомментировал данный вопрос адвокат истцов Джастин Нельсон (Justin Nelson). Antropic намерена привлечь $10 млрд и усилить контроль за инвесторами по примеру OpenAI

22.08.2025 [10:12],

Алексей Разин

Бурно развивающиеся ИИ-стартапы нуждаются в крупных суммах денег, но при этом хотят избежать растущего влияния инвесторов на свою деятельность. По крайней мере, в таком русле готовы развиваться OpenAI и Anthropic, а последняя при этом ещё и готовится привлечь не менее $10 млрд в рамках нового раунда финансирования.

Источник изображения: Anthropic Величина этой суммы пока не утверждена, как отмечает Bloomberg, а потому условия сделки могут измениться. Ранее сообщалось, что запланированное привлечение $5 млрд в рамках нового раунда финансирования позволит оценить капитализацию Anthropic в $170 млрд. Сумма наверняка вырастет примерно вдвое, поскольку многие инвесторы проявляют интерес к поддержке ИИ-стартапа. Помимо американских и международных инвестиционных компаний, в роли инвесторов для Anthropic могут выступить суверенные фонды Катара и Сингапура. Предыдущий раунд финансирования в размере $3,5 млрд в прошлом году оценивал капитализацию Anthropic в $61,5 млрд. Одновременно Financial Times со ссылкой на собственные источники сообщает, что OpenAI и Anthropic намерены ограничить вложения в свой капитал со стороны так называемых «компаний специального назначения» (SPV), которые создаются инвесторами под конкретные задачи. За такой ширмой, как считается, могут скрываться не совсем прозрачные структуры, и это начало беспокоить руководство ИИ-стартапов, которые пытаются избежать нежелательного влияния на свой бизнес. OpenAI, в частности, намерена ограничить инвесторов в возможности передавать её акции новым собственникам, и даже преследует в суде продажу своих акций через SPV без одобрения со своей стороны. Избыток желающих вложиться в перспективный бизнес позволяет OpenAI быть более разборчивой в выборе инвесторов. Последние, в свою очередь, начали сталкиваться с различными мошенническими схемами, по которым им предлагают вложиться в капитал OpenAI разные сомнительные личности, выдающие себя за близких друзей основателя компании Сэма Альтмана (Sam Altman). До сих пор SPV оставались довольно популярной формой привлечения средств инвесторов в капитал стартапов, ею пользовались OpenAI, Anthropic и SpaceX. Теперь компании всё чаще обеспокоены тем, что через SPV чувствительная для них информация может попасть в руки анонимных инвесторов. В этой сфере уже могут таиться угрозы для национальной безопасности США, и стартапы просто не желают иметь проблемы с властями на этой почве. Чат-бот Claude AI станет прекращать «вредоносные или оскорбительные диалоги с пользователями»

18.08.2025 [18:58],

Сергей Сурабекянц

Anthropic научила свой чат-бот Claude AI прекращать общение, которое он сочтёт «вредоносным или оскорбительным». Эта возможность уже доступна в моделях Opus 4 и 4.1. Она позволит чат-боту завершать разговоры в качестве крайней меры после неоднократных попыток пользователя сгенерировать вредоносный или оскорбительный контент. Anthropic хочет добиться «потенциального благополучия» моделей ИИ, прекращая беседы, в которых Claude испытывает «явный дискомфорт».

Источник изображения: Anthropic После прекращения диалога со стороны Claude, пользователь не сможет отправлять новые сообщения в этом чате, но создание новых чатов будет по-прежнему доступно. Anthropic отметила, что разговоры, вызывающие подобную реакцию, являются «крайними случаями», добавляя, что большинство пользователей не столкнутся с этим препятствием даже при обсуждении спорных тем. В ходе тестирования Claude Opus 4 у чат-бота было отмечено «стойкое и последовательное отвращение к причинению вреда», в том числе к созданию сексуального контента с участием несовершеннолетних, насильственным действиям и терроризму. В этих случаях, по данным Anthropic, Claude демонстрировал «явную тревожность» и «тенденцию прекращать вредоносные разговоры, когда предоставлялась такая возможность». Claude получил прямое указание не завершать разговоры, если пользователь проявляет признаки желания причинить «неминуемый вред» себе или другим. В таких случаях Anthropic привлекает онлайн-сервис кризисной поддержки Throughline, чтобы помочь разработать ответы на запросы, связанные с самоповреждением и психическим здоровьем. На прошлой неделе Anthropic обновила политику использования своего чат-бота, поскольку быстро развивающиеся модели ИИ вызывают всё больше опасений по поводу безопасности. Теперь компания запрещает использовать Claude для разработки биологического, ядерного, химического или радиологического оружия, а также для разработки вредоносного кода или эксплуатации уязвимостей сети. ИИ-бот Claude теперь может прочитать «Войну и мир» за раз — Anthropic увеличила контекстное окно в 5 раз

13.08.2025 [00:55],

Анжелла Марина

Компания Anthropic на фоне конкуренции с OpenAI, Google и другими крупными игроками объявила о расширении контекстного окна своей модели Claude Sonnet 4 до 1 миллиона токенов. Это в пять раз больше предыдущего показателя. Новое контекстное окно позволяет обрабатывать кодовые базы объёмом от 75 000 до 110 000 строк, а также анализировать десятки научных статей или сотни документов в одном API-запросе.

Источник изображения: AI Ранее контекстное окно модели составляло 200 000 токенов, что позволяло работать примерно c 20 000 строк кода. Для сравнения 500 000 токенов достаточно для обработки около 100 получасовых записей переговоров или 15 финансовых отчётов. Новый лимит в 1 миллион токенов, как пишет The Verge, удваивает эти возможности. Руководитель продукта Claude Брэд Абрамс (Brad Abrams) рассказал, что ранее корпоративным клиентам приходилось разбивать задачи на мелкие фрагменты из-за ограниченного объёма памяти модели, но теперь ИИ способен работать с контекстом целиком и решать задачи в полном масштабе. В частности, Sonnet 4 может обработать до 2500 страниц текста, и при этом вся «Война и мир» легко помещается в контекстное окно. Стоит сказать, что Anthropic не стала первопроходцем: аналогичный показатель в 1 миллион токенов OpenAI представила ещё в апреле в версии GPT-4.1. Тем не менее, для Anthropic, известной сильными сторонами Claude в программировании, этот шаг является стратегическим в борьбе за рынок, особенно на фоне недавнего анонса GPT-5. По словам Абрамса, обновление особенно востребовано в таких отраслях, как IT, фармацевтика, ритейл, юридические и профессиональные услуги. На вопрос, ускорил ли выход GPT-5 релиз новой версии Claude, он ответил, что «компания действует в соответствии с запросами клиентов, выпуская улучшения максимально быстро». Доступ к новому контекстному окну уже открыт для определённой группы пользователей API Anthropic — в частности, тех, кто использует Tier 4 и индивидуальные лимиты. Anthropic научила чат-бота Claude припоминать старые диалоги с пользователем

12.08.2025 [12:44],

Владимир Фетисов

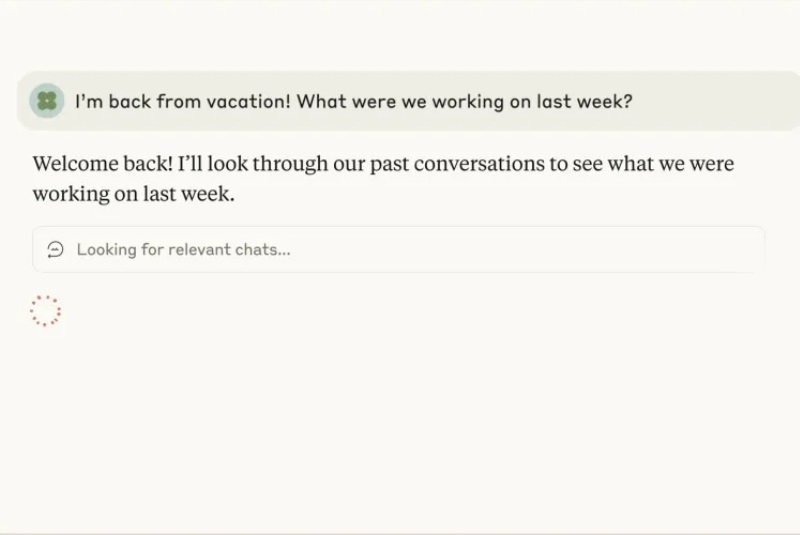

Компания Anthropic объявила о запуске функции запоминания чатов в своём ИИ-боте Claude. Благодаря этому бот сможет напоминать пользователю, о чём они беседовали ранее.

Источник изображения: Anthropic В демонстрационном видео Anthropic показала, как пользователь спрашивает Claude, о чём они говорили перед отпуском. После этого система анализирует предыдущие чаты и выдаёт обобщённую информацию. В дополнение к этому Claude спрашивает, не хочет ли пользователь продолжить общение по одному из обсуждаемых ранее вопросов. «Никогда больше не теряйте контроль над работой. Claude теперь запоминает ваши прошлые разговоры, так что вы можете беспрепятственно продолжать работу над проектами, ссылаться на предыдущие обсуждения и развивать свои идеи, не начиная каждый раз с нуля», — говорится в сообщении Anthropic. Новая функция доступна в веб-версии Claude, а также в приложениях для компьютеров и мобильных устройств. На данном этапе испытать нововведение могут подписчики Claude Max, Team и Enterprise. Для начала использования упомянутой функции в настройках чат-бота нужно активировать соответствующую опцию. Отмечается, что речь не идёт о функции постоянной памяти, аналогичной той, что есть в ChatGPT от OpenAI. Claude будет обращаться к прошлым чатам и ссылаться на них только в случаях, когда пользователь сам попросит сделать это. Разработчики также утверждают, что хранящаяся информация не будет использоваться для создания цифрового профиля пользователя. Функция памяти является для компаний, занимающихся разработкой ИИ-ботов, одним из способов привлечь и удержать пользователей, повышая их вовлеченность. Этот инструмент в последние недели стал предметом дискуссий, поскольку ChatGPT одновременно хвалили и критиковали за добавление функции памяти, которая позволяет боту ссылаться на прошлые беседы с пользователем. Anthropic с отрывом лидирует в войне за таланты в сфере ИИ, хотя платит им меньше Meta✴ и других

07.08.2025 [17:57],

Сергей Сурабекянц

Борьба за лучших специалистов в сфере ИИ среди таких технологических гигантов, как Meta✴ и OpenAI, достигла новых высот. Но, как оказалось, многие инженеры предпочли бы работать в компании Anthropic, занимающейся развитием моделей Claude. Этот стартап не может сравниться с Meta✴ по заоблачным зарплатам, но по-прежнему доминирует в вопросах привлечения и удержания квалифицированных кадров.

Источник изображения: Anthropic Исследование венчурной компании SignalFire показало, что Anthropic лидирует по привлекательности для специалистов и высоко ценится как работодатель. Компания с оборотом $170 млрд нанимает инженеров в 2,68 раза быстрее, чем теряет их. Для OpenAI этот показатель составляет 2,18, для Meta✴ — 2,07, для Google — 1,17. Конечно, крупные организации не могут расти так же быстро, как молодые стартапы, но преимущество Anthropic в плане удержания сотрудников действительно заметно, особенно в Кремниевой долине, где усилия по найму персонала достигли нового пика. Попытка Meta✴ этим летом укомплектовать штат своего подразделения Superintelligence Labs спровоцировала очередной виток переманивания талантов. Генеральный директор Марк Цукерберг (Mark Zuckerberg) неоднократно лично делал предложения ведущим специалистам в области ИИ из OpenAI, Anthropic, Google DeepMind и Apple. На данный момент Цукербергу удалось переманить как минимум двух сотрудников Anthropic, которые до этого уже успели поработать в Meta✴. Что касается других сотрудников Anthropic, многие из них отклонили предложения Meta✴, заявив, что они «даже не стали бы разговаривать с Марком Цукербергом». Генеральный директор Anthropic Дарио Амодеи (Dario Amodei) прокомментировал попытки Meta✴ словами «они пытаются купить то, что купить невозможно, и это соответствует миссии». Он заявил, что не собирается предлагать зарплаты, сопоставимые с заоблачными предложениями от Meta✴, так как это было бы несправедливо по отношению к не менее талантливым инженерам, которых Meta✴ не пыталась переманить. Компания Anthropic была основана в 2021 году бывшими сотрудниками OpenAI, которые хотели разрабатывать решения для ИИ, уделяя больше внимания безопасности и использованию технологий во благо. Уникальная миссия и культура стартапа стали серьёзным стимулом для специалистов в сфере ИИ. По данным SignalFire, большинство соискателей в этой профессиональной области называют Anthropic «компанией мечты». Anthropic заявила, что считает свою приверженность безопасности, качество исследований и команду ведущих исследователей причинами, по которым талантливые специалисты выбирают именно её. Во многих отношениях OpenAI по-прежнему имеет преимущество в плане узнаваемости среди общественности. Но возможности программирования моделей Claude от Anthropic давно пользуются огромной популярностью среди сообщества разработчиков. Безусловно, зарплата играет важную роль, но если разница в компенсационных пакетах не слишком велика, то миссия, культура и технологические достижения компании выходят на первое место. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |