|

Опрос

|

реклама

Быстрый переход

OpenAI избавляется от зависимости от Microsoft: часть инфраструктуры ChatGPT переедет в Google Cloud

17.07.2025 [12:41],

Павел Котов

Компания OpenAI сообщила накануне, что намеревается использовать для своего популярного помощника с искусственным интеллектом ChatGPT облачную инфраструктуру Google. Разработчик уже пользуется облачными услугами Microsoft, Oracle и CoreWeave.

Источник изображения: Dima Solomin / unsplash.com OpenAI наращивает вычислительные мощности для удовлетворения высокого спроса на свои сервисы, чтобы было затруднительно, когда компания зависела исключительно от ресурсов Microsoft. Отношения двух компаний меняли формат, и в прошлом году Microsoft признала в OpenAI конкурента: обе предлагают инструменты ИИ для разработчиков и продают подписки для компаний. Теперь OpenAI добавила в список своих поставщиков и Google Cloud — сервис ChatGPT и интерфейс прикладного программирования будут также работать на платформах Microsoft, CoreWeave и Oracle. Для Google это достижение, потому что её облачное подразделение моложе и меньше, чем у Amazon и Microsoft. Google Cloud обозначит присутствие в США, Японии, Нидерландах, Норвегии и Великобритании. Первым облачным партнёром OpenAI после Microsoft ещё в прошлом году стала Oracle, которая обеспечила разработчику ИИ дополнительные вычислительные мощности; в марте этого года был заключено пятилетний контракт с CoreWeave на сумму почти $12 млрд — Microsoft ещё в январе разрешила OpenAI пользоваться облачными ресурсами конкурентов и перестала претендовать на статус эксклюзивного поставщика услуг. О намерении компании обратиться в Google Cloud стало известно в июне. «Мы глубоко сожалеем»: Google выпустила мини-отчёт об инциденте, сломавшем половину интернета

13.06.2025 [17:00],

Павел Котов

Google опубликовала «мини-отчёт об инциденте» в работе своей облачной платформы, который привёл к сбою в работе нескольких крупных сервисов, включая Spotify, Discord, Snapchat, OpenAI, а также службы самого поискового гиганта.

Источник изображения: BoliviaInteligente / unsplash.com «Мы глубоко сожалеем о последствиях, которые вызвало это нарушение/сбой в работе сервиса для всех наших пользователей и их клиентов. Google Cloud доверяют свои рабочие нагрузки крупные и мелкие компании, и мы будем работать лучше. В ближайшие дни мы опубликуем полный отчёт об инциденте с указанием причины, подробных временных рамок и надёжных мер по устранению неполадок, которые мы предпримем. Учитывая масштаб и последствия этого инцидента, мы хотели бы предоставить некоторую информацию ниже», — гласит заявление компании. Инцидент, гласят официальные данные, произошёл 12 июня в 10:49 по Тихоокеанскому времени (21:49 мск), а работоспособность всех систем удалось восстановить ровно через три часа, в 13:39 (13 июня 0:49 мск); сбой затронул системы Google по всему миру. Основным симптомом проблемы стал резкий рост ответа «ошибка 503» в нескольких продуктах Google Cloud и Google Workspace при внешних запросах API. «Согласно нашему первоначальному анализу, проблема возникла из-за недопустимого автоматического обновления квоты в нашей системе управления API, которая распространилась по всему миру и привела к отказу при выполнении внешних запросов API. Для восстановления работы мы включили обход проверки квоты, что позволило вернуть работу в большинстве регионов в течение двух часов. Однако база данных политики квот в [регионе] us-central1 оказалась перегружена, что привело к гораздо более длительному восстановлению в этом регионе. У нескольких продуктов были умеренные остаточные последствия (например, невыполненные задания) в течение часа после устранения основной проблемы, и после этого произошло частичное восстановление», — говорится в кратком отчёте. Чтобы не допускать возникновения подобных сбоев в будущем, компания пообещала принять следующие меры:

Alphabet потратит $75 млрд «на ускорение прогресса» в 2025 году — больше Meta✴, но меньше Microsoft

05.02.2025 [07:37],

Алексей Разин

Корпорация Alphabet, в состав которой входит компания Google, отчиталась на этой неделе о финансовых итогах четвёртого квартала прошлого года. Совокупная выручка выросла на 12 % до $96,47 млрд, но оказалась ниже прогнозов аналитиков. Рост выручки в облачном сегменте на 30 % до $11,96 млрд тоже не оправдал ожиданий инвесторов, но в этом году компания собирается выделить $75 млрд на капитальные затраты с целью расширения вычислительных мощностей.

Источник изображения: Alphabet Квартальные отчёты американских корпораций, являющихся крупнейшими игроками мирового рынка облачных вычислений, выходят на фоне интереса к успехам китайского стартапа DeepSeek, который создаёт вполне конкурентоспособные большие языковые модели в условиях ограниченности материальных и технических ресурсов. Как известно, Meta✴ Platforms в этом году выделит от $60 до $65 млрд в качестве капитальных затрат, Microsoft на подобные нужды готова выделить $80 млрд. На этом фоне Google как раз укладывается между ними со своей суммой $75 млрд, причём она оказывается существенно выше ожиданий рынка, соответствующих значению $58,84 млрд. Капитальные затраты Google в этом году будет направлять «преимущественно на развитие технической инфраструктуры, в первую очередь — серверов, и уже потом центров обработки данных и сетевых решений». Только в этом квартале капитальные затраты Google составят от $16 до $18 млрд, что также выше прогноза аналитиков ($14,3 млрд). В прошлом квартале капитальные затраты Alphabet составили $14 млрд, превысив заложенную аналитиками в прогноз величину ($13,26 млрд). В текущем году Alphabet также намеревается увеличить численность персонала на облачном направлении и в сегменте систем искусственного интеллекта. Квартальный отчёт Alphabet в целом разочаровал инвесторов. Прежде всего, темпы роста выручки холдинга снизились до 12 %, хотя год назад они достигали 13 %. Выручка Google медленнее росла и в сегменте YouTube, и в поисковом, и на направлении услуг. Правда, известный видеохостинг по итогам квартала выручил $10,47 млрд, что выше ожиданий рынка. В облачном сегменте выручка Google ограничилась $11,96 млрд против заложенных инвесторами в прогноз $12,19 млрд, но она всё равно увеличилась на 30 %. По мнению руководства компании, спрос на этом направлении превышал возможности Google по оказанию профильных услуг. Рекламная выручка Google выросла по итогам квартала на 10,6 % против 11 % годом ранее. В поисковом бизнесе выручка выросла на 12,5 % против 12,7 % годом ранее. YouTube рекламную выручку увеличил на 13,8 % против 15,5 % годом ранее, в сегменте услуг выручка выросла на 10,2 % против 12,4 % годом ранее. Всё это способствовало падению курса акций холдинга более чем на 9 % после завершения торгов накануне. Чистая прибыль Alphabet увеличилась на 28 % до $26,54 млрд по итогам прошлого квартала. На направлении Other Bets, которое включает и разработчика систем автопилота на транспорте Waymo, выручка по итогам квартала сократилась на 39 % до $400 млн, и также оказалась заметно ниже ожиданий аналитиков. Тем не менее, та же Waymo начала расширять территорию эксплуатации своих беспилотных такси, и это потенциально позволяет рассчитывать на увеличение профильной выручки. Google представила Axion — свой первый Arm-процессор

09.04.2024 [16:52],

Николай Хижняк

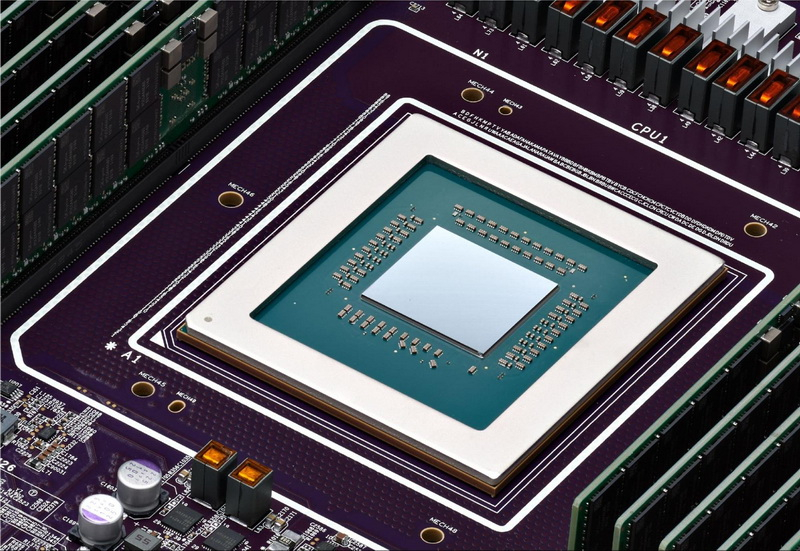

Компания Google анонсировала свой первый Arm-процессор — он получил название Axion и предназначается для использования в серверных системах для ЦОД. В своём пресс-релизе Google заявляет, что Axion обеспечивает лидирующие в отрасли показатели производительности и энергоэффективности.

Источник изображения: Google Cloud Подробного описания процессора компания не приводит. Известно, что в основе Axion используются ядра Arm Neoverse V2 с архитектурой ArmV9 и привычным для неё набором инструкций. Также в составе чипа применяются специализированные микроконтроллеры Titanium, на которые возлагаются задачи, связанные с сетевыми подключениями и безопасностью. Кроме того, Titanium перекладывает операции обработки ввода-вывода хранилища на Hyperdisk, службы сетевого блочного хранения данных в Google Cloud. По словам Google, Axion обеспечивает на 30 % более высокую производительность по сравнению с самыми быстрыми инструментами общего назначения на базе Arm в облаке, а также до 50 % больше производительности и до 60 % больше энергоэффективности по сравнению с сопоставимыми решениями на базе x86-совместимых процессоров. Наглядные примеры сравнений Google не приводит. В компании отмечают, что уже начали переводить свои сервисы BigTable, Spanner, BigQuery, Blobstore, Pub/Sub, Google Earth Engine и YouTube Ads на системы с процессорами Axion. В пресс-релизе Google Cloud также указано, что Axion построен на открытой основе, поэтому клиенты смогут переносить свои существующие рабочие нагрузки Arm в Google Cloud на новую платформу без каких-либо существенных изменений, используя программу SystemReady Virtual Environment (VE). Axion можно будет использовать во многих облачных сервисах Google, включая Google Compute Engine, Google Kubernetes Engine, Dataproc, Dataflow, Cloud Batch и других. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |