|

Опрос

|

реклама

Быстрый переход

«Мы глубоко сожалеем»: Google выпустила мини-отчёт об инциденте, сломавшем половину интернета

13.06.2025 [17:00],

Павел Котов

Google опубликовала «мини-отчёт об инциденте» в работе своей облачной платформы, который привёл к сбою в работе нескольких крупных сервисов, включая Spotify, Discord, Snapchat, OpenAI, а также службы самого поискового гиганта.

Источник изображения: BoliviaInteligente / unsplash.com «Мы глубоко сожалеем о последствиях, которые вызвало это нарушение/сбой в работе сервиса для всех наших пользователей и их клиентов. Google Cloud доверяют свои рабочие нагрузки крупные и мелкие компании, и мы будем работать лучше. В ближайшие дни мы опубликуем полный отчёт об инциденте с указанием причины, подробных временных рамок и надёжных мер по устранению неполадок, которые мы предпримем. Учитывая масштаб и последствия этого инцидента, мы хотели бы предоставить некоторую информацию ниже», — гласит заявление компании. Инцидент, гласят официальные данные, произошёл 12 июня в 10:49 по Тихоокеанскому времени (21:49 мск), а работоспособность всех систем удалось восстановить ровно через три часа, в 13:39 (13 июня 0:49 мск); сбой затронул системы Google по всему миру. Основным симптомом проблемы стал резкий рост ответа «ошибка 503» в нескольких продуктах Google Cloud и Google Workspace при внешних запросах API. «Согласно нашему первоначальному анализу, проблема возникла из-за недопустимого автоматического обновления квоты в нашей системе управления API, которая распространилась по всему миру и привела к отказу при выполнении внешних запросов API. Для восстановления работы мы включили обход проверки квоты, что позволило вернуть работу в большинстве регионов в течение двух часов. Однако база данных политики квот в [регионе] us-central1 оказалась перегружена, что привело к гораздо более длительному восстановлению в этом регионе. У нескольких продуктов были умеренные остаточные последствия (например, невыполненные задания) в течение часа после устранения основной проблемы, и после этого произошло частичное восстановление», — говорится в кратком отчёте. Чтобы не допускать возникновения подобных сбоев в будущем, компания пообещала принять следующие меры:

Alphabet потратит $75 млрд «на ускорение прогресса» в 2025 году — больше Meta✴, но меньше Microsoft

05.02.2025 [07:37],

Алексей Разин

Корпорация Alphabet, в состав которой входит компания Google, отчиталась на этой неделе о финансовых итогах четвёртого квартала прошлого года. Совокупная выручка выросла на 12 % до $96,47 млрд, но оказалась ниже прогнозов аналитиков. Рост выручки в облачном сегменте на 30 % до $11,96 млрд тоже не оправдал ожиданий инвесторов, но в этом году компания собирается выделить $75 млрд на капитальные затраты с целью расширения вычислительных мощностей.

Источник изображения: Alphabet Квартальные отчёты американских корпораций, являющихся крупнейшими игроками мирового рынка облачных вычислений, выходят на фоне интереса к успехам китайского стартапа DeepSeek, который создаёт вполне конкурентоспособные большие языковые модели в условиях ограниченности материальных и технических ресурсов. Как известно, Meta✴ Platforms в этом году выделит от $60 до $65 млрд в качестве капитальных затрат, Microsoft на подобные нужды готова выделить $80 млрд. На этом фоне Google как раз укладывается между ними со своей суммой $75 млрд, причём она оказывается существенно выше ожиданий рынка, соответствующих значению $58,84 млрд. Капитальные затраты Google в этом году будет направлять «преимущественно на развитие технической инфраструктуры, в первую очередь — серверов, и уже потом центров обработки данных и сетевых решений». Только в этом квартале капитальные затраты Google составят от $16 до $18 млрд, что также выше прогноза аналитиков ($14,3 млрд). В прошлом квартале капитальные затраты Alphabet составили $14 млрд, превысив заложенную аналитиками в прогноз величину ($13,26 млрд). В текущем году Alphabet также намеревается увеличить численность персонала на облачном направлении и в сегменте систем искусственного интеллекта. Квартальный отчёт Alphabet в целом разочаровал инвесторов. Прежде всего, темпы роста выручки холдинга снизились до 12 %, хотя год назад они достигали 13 %. Выручка Google медленнее росла и в сегменте YouTube, и в поисковом, и на направлении услуг. Правда, известный видеохостинг по итогам квартала выручил $10,47 млрд, что выше ожиданий рынка. В облачном сегменте выручка Google ограничилась $11,96 млрд против заложенных инвесторами в прогноз $12,19 млрд, но она всё равно увеличилась на 30 %. По мнению руководства компании, спрос на этом направлении превышал возможности Google по оказанию профильных услуг. Рекламная выручка Google выросла по итогам квартала на 10,6 % против 11 % годом ранее. В поисковом бизнесе выручка выросла на 12,5 % против 12,7 % годом ранее. YouTube рекламную выручку увеличил на 13,8 % против 15,5 % годом ранее, в сегменте услуг выручка выросла на 10,2 % против 12,4 % годом ранее. Всё это способствовало падению курса акций холдинга более чем на 9 % после завершения торгов накануне. Чистая прибыль Alphabet увеличилась на 28 % до $26,54 млрд по итогам прошлого квартала. На направлении Other Bets, которое включает и разработчика систем автопилота на транспорте Waymo, выручка по итогам квартала сократилась на 39 % до $400 млн, и также оказалась заметно ниже ожиданий аналитиков. Тем не менее, та же Waymo начала расширять территорию эксплуатации своих беспилотных такси, и это потенциально позволяет рассчитывать на увеличение профильной выручки. Google представила Axion — свой первый Arm-процессор

09.04.2024 [16:52],

Николай Хижняк

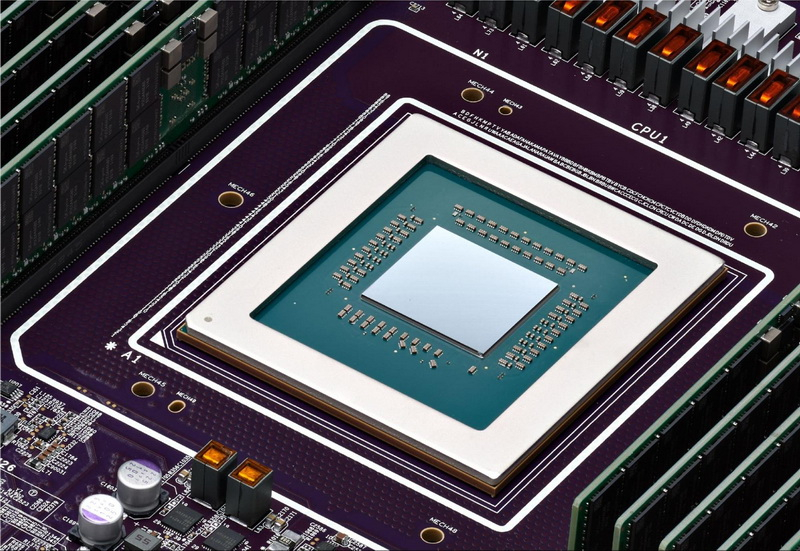

Компания Google анонсировала свой первый Arm-процессор — он получил название Axion и предназначается для использования в серверных системах для ЦОД. В своём пресс-релизе Google заявляет, что Axion обеспечивает лидирующие в отрасли показатели производительности и энергоэффективности.

Источник изображения: Google Cloud Подробного описания процессора компания не приводит. Известно, что в основе Axion используются ядра Arm Neoverse V2 с архитектурой ArmV9 и привычным для неё набором инструкций. Также в составе чипа применяются специализированные микроконтроллеры Titanium, на которые возлагаются задачи, связанные с сетевыми подключениями и безопасностью. Кроме того, Titanium перекладывает операции обработки ввода-вывода хранилища на Hyperdisk, службы сетевого блочного хранения данных в Google Cloud. По словам Google, Axion обеспечивает на 30 % более высокую производительность по сравнению с самыми быстрыми инструментами общего назначения на базе Arm в облаке, а также до 50 % больше производительности и до 60 % больше энергоэффективности по сравнению с сопоставимыми решениями на базе x86-совместимых процессоров. Наглядные примеры сравнений Google не приводит. В компании отмечают, что уже начали переводить свои сервисы BigTable, Spanner, BigQuery, Blobstore, Pub/Sub, Google Earth Engine и YouTube Ads на системы с процессорами Axion. В пресс-релизе Google Cloud также указано, что Axion построен на открытой основе, поэтому клиенты смогут переносить свои существующие рабочие нагрузки Arm в Google Cloud на новую платформу без каких-либо существенных изменений, используя программу SystemReady Virtual Environment (VE). Axion можно будет использовать во многих облачных сервисах Google, включая Google Compute Engine, Google Kubernetes Engine, Dataproc, Dataflow, Cloud Batch и других. Google отразила самую мощную DDoS-атаку в истории — почти 400 млн запросов в секунду

10.10.2023 [17:58],

Павел Котов

Google отчиталась об успешно отражённой в минувшем августе самой мощной DDoS-атаке в истории — её интенсивность составила 398 млн запросов в секунду, что в 7,5 раза мощнее антирекорда, установленного в прошлом году. В рамках вредоносной кампании были также отмечены новые методы взлома сайтов и сервисов.

Источник изображений: cloud.google.com В новой серии DDoS-атак использовалась новая техника Rapid Reset, основанная на мультиплексировании потоков — важнейшей функции протокола HTTP/2. Интенсивность атаки достигала значения в 398 млн запросов в секунду, тогда как прошлогодний рекорд составлял «всего» 46 млн запросов в секунду. Для сравнения, в течение этой двухминутной атаки генерировалось больше запросов, чем было прочитано статей «Википедии» за весь сентябрь 2023 года.  Последняя волна атак началась в конце августа и продолжается по сей день — она нацелена на крупнейших поставщиков инфраструктурных ресурсов, включая сервисы Google, сеть Google Cloud и клиентов Google. Компании удалось сохранить работоспособность сервисов за счёт глобальной инфраструктуры распределения нагрузки. Google скоординировала усилия с отраслевыми партнёрами, что помогло установить механизмы атак и совместными усилиями разработать меры по смягчению последствий. В ходе отражения атаки была выявлена уязвимость протокола HTTP/2, которой присвоили номер CVE-2023-44487 с рейтингом 7,5 балла из 10 — эта уязвимость помогла злоумышленникам реализовать технику Rapid Reset. Чтобы ограничить влияние этого вектора атаки, Google рекомендует администраторам серверов с поддержкой протокола HTTP/2 убедиться, что были установлены патчи, закрывающие уязвимость CVE-2023-44487. Google Cloud представила пятое поколение тензорных процессоров для обучения ИИ

30.08.2023 [18:04],

Николай Хижняк

На очередной ежегодной конференции Cloud Next компания Google Cloud объявила о выпуске пятого поколения своих тензорных процессоров (TPU) для обучения нейросетей — TPU v5e. Google анонсировала предыдущую, четвертую версию этих процессоров в 2021 году, но разработчикам они стали доступны только в 2022 году.

Источник изображения: Frederic Lardinois / TechCrunch Компания отмечает, что при создании новой версии чипа особое внимание уделялось его эффективности. По сравнению с предыдущим поколением, новый процессор обещает двукратное улучшение производительности в пересчёте на доллар для обучения больших языковых моделей (LLM) и генеративных нейросетей, а также 2,5-кратное улучшение производительности по тому же критерию для инференс-систем. «Это самый экономичный и доступный облачный TPU на сегодняшний день», — заявил на пресс-конференции перед сегодняшним анонсом Марк Ломейер (Mark Lohmeyer), вице-президент и генеральный директор по вычислительной и ML-инфраструктуре Google Cloud.

Источник изображения: Google В то же время он подчеркнул, что компания не экономила на технических характеристиках TPU v5e в угоду рентабельности. Кластеры могут включать до 256 чипов TPU v5e, объединённых высокоскоростным интерконнектом с совокупной пропускной способностью более 400 Тбит/с. Производительность такой платформы составляет 100 Попс (Петаопс) в INT8-вычислениях. «Мы предоставляем нашим клиентам возможность легко масштабировать свои модели искусственного интеллекта за пределы физических границ одного модуля TPU или одного кластера TPU. Другими словами, одна большая рабочая нагрузка искусственного интеллекта теперь может распределяться на несколько физических кластеров TPU, масштабируясь буквально до десятков тысяч чипов. При этом работа будет выполняться экономически эффективно. В результате, используя облачные графические процессоры и облачные TPU, мы действительно предоставляем нашим клиентам большой выбор, гибкость и дополнительные возможности для удовлетворения потребностей широкого набора рабочих задач, связанных с ИИ, которые, как мы видим, продолжают множиться», — добавил он. В дополнение к анонсу нового поколения TPU компания Google также объявила, что в следующем месяце сделает общедоступными для разработчиков виртуальные кластеры A3, оснащённые специализированными графическими процессорами Nvidia H100. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |