|

Опрос

|

реклама

Быстрый переход

Google разорвала контракт с Appen, которая помогала в обучении ИИ Bard

24.01.2024 [11:45],

Павел Котов

Google расторгла контракт с австралийской компанией Appen, участвовавшей в обучении больших языковых моделей искусственного интеллекта, которые легли в основу чат-бота Bard, новой поисковой платформы и других продуктов. Решение было принято, несмотря на рост конкуренции в сегменте генеративного ИИ.

Источник изображения: Google «Решение расторгнуть контракт было принято в рамках наших постоянных усилий по переоценке и корректировке многих из партнёрских отношений с поставщиками в Alphabet, чтобы обеспечить максимальную эффективность нашего взаимодействия с поставщиками», — приводит The Verge заявление представителя Google Кортни Менчини (Courtenay Mencini). Appen уведомила Австралийскую фондовую биржу (ASX), отметив, что «не знала заранее о решении Google расторгнуть контракт». Сотрудники в таких компаниях как Appen часто выполняют наиболее трудоёмкие задачи, связанные с обучением ИИ — эта работа является низкооплачиваемой, и зачастую она недооценивается отраслью, хотя и составляет её основу. В прошлом году некоторые сотрудники Appen, входящие в Профсоюз работников Alphabet, обратились к своему руководству с просьбой повысить зарплату с $10 до $15 в час. Повышения зарплаты добиться удалось, но не до желаемого значения. Многие из этих сотрудников впоследствии были уволены — в руководстве Appen сослались на условия ведения бизнеса. Appen, по сведениям CNBC, также помогала в обучении моделей ИИ для Microsoft, Meta✴ и Amazon. В отчёте для ASX компания отметила, что сотрудничество с Google оказало значительное влияние на её доходы — на контракт с поисковым гигантом в 2023 году пришлись $82,8 млн из $273 млн её общей выручки. В Google добавили, что сейчас тесно сотрудничают с Appen, чтобы сделать переход «максимально плавным». С Google работает ещё один подрядчик — Accenture, чьи сотрудники также проголосовали за вступление в Профсоюз работников Alphabet. Решение было принято, когда они отказались заниматься обработкой «непристойных, графических и оскорбительных команд» для чат-бота Bard в ноябре прошлого года. И это не единичный случай. Модераторы контента, работающие в Кении на компанию Sama, подали в суд на своего работодателя и её клиента Meta✴ — они платили людям $2,20 в час за просмотр травмирующих психику изображений и видео. Google внедрила ИИ в браузер Chrome: организовать вкладки и создать уникальные темы стало проще

24.01.2024 [07:28],

Дмитрий Федоров

Google предложила принципиально новый подход к работе с браузером Chrome. Компания объявила о внедрении ряда функций на основе ИИ, которые станут значительным шагом в создании интуитивно понятного и удобного интерфейса популярного браузера.

Источник изображений: Google Одним из ключевых нововведений стала функция Tab Organizer. Она позволяет автоматически группировать вкладки по схожим темам, значительно упрощая управление множеством открытых страниц. Функция активируется простым кликом правой кнопки мыши и предлагает пользователю организовать вкладки, связанные, например, с онлайн-покупками или чтением новостей. Такая автоматизация в значительной степени облегчает навигацию и позволяет сосредоточиться на содержании, а не на управлении вкладками. Другой инновацией является обновление Chrome Theme Store с использованием ИИ. Теперь пользователи могут выбрать изображение, стиль и цветовую гамму, на основе которых ИИ создаст уникальную тему для браузера Chrome. Эта функция основана на технологии генерации текста в изображение, аналогичной используемой в Android для создания генеративных обоев, что демонстрирует умение ИИ трансформировать базовые пользовательские запросы в эстетически привлекательные дизайны. Следующим новшеством в интеграции ИИ станет функция Help Me Write, которую добавят в браузер в следующем месяце. Она предложит пользователям помощь ИИ в составлении текстов в любых текстовых полях веб-сайтов. Для этого достаточно щёлкнуть правой кнопкой мыши на любом текстовом поле и выбрать эту функцию. Затем ИИ спросит вас, что вы хотите написать, и создаст для вас первый черновик. Так Help Me Write обещает упростить процесс написания электронных писем, отзывов о покупках и ответов на приглашения.  По-видимому, браузер Chrome становится ключевой платформой для Google в плане внедрения своих новейших разработок в области ИИ, включая модель Gemini и ИИ-чат-бот Bard. Хотя ИИ-чат-боты пользуются сейчас большой популярностью, браузеры остаются единственным местом, где разработчики могут получить доступ практически ко всему. Поисковик Google уже служит своеобразным фильтром, через который мы видим интернет, и компания стремится расширить эту роль, включив ИИ в процесс нашего поиска и обработки информации, а также в создание нового контента. В то время как конкуренты Google, включая такие крупные компании, как Microsoft, а также браузеры Arc и Opera, уже около года активно интегрируют ИИ в свои продукты, Google делает ставку на широкую интеграцию своих ИИ-инструментов в Chrome для создания более интуитивного и комфортного пользовательского интерфейса. Является ли подобный подход Google отставанием в гонке инноваций или стратегическим ходом, покажет время. Однако, не стоит удивляться, если в скором времени вы обнаружите ИИ в каждой вкладке вашего браузера. Google захотела обеспечить Android-смартфоны спутниковой связью и вложилась в AST SpaceMobile

20.01.2024 [12:33],

Павел Котов

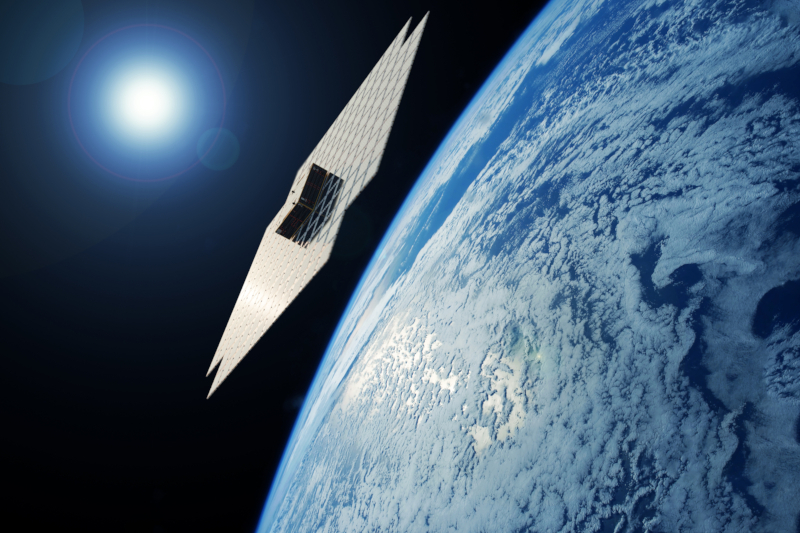

Google вместе с операторами мобильной связи AT&T и Vodafone инвестировала $110 млн в компанию AST SpaceMobile, которая планирует развернуть группировку спутников, способных работать как базовые станции сотовой связи для подключения немодифицированных смартфонов.

Источник изображения: businesswire.com В прошлом году AST SpaceMobile продемонстрировала возможности спутника BlueWalker 3, который позволил осуществить звонок с обычного смартфона и обеспечил подключение к интернету на скорости до 14 Мбит/с — этого оказалось достаточно, чтобы привлечь внимание Google. Поисковый гигант также «согласился сотрудничать в разработке продуктов, их тестировании и планах внедрения сетевого подключения SpaceMobile на Android и связанных устройствах», сообщил оператор. Партнёрский проект может стать для экосистемы Android альтернативой функции Emergency SOS на iPhone, которая при необходимости позволяет отправлять службам экстренной помощи текстовые сообщения через спутники в отсутствие наземной связи. AST SpaceMobile планирует использовать полученные средства для развёртывания коммерческих услуг спутниковой связи — до конца I квартала компания запустит пять доработанных аппаратов BlueBird. Стоит отметить, что Google поддержала не только AST SpaceMobile — ещё в 2015 году она вместе с Fidelity инвестировала в SpaceX $1 млрд, а в 2021 году договорилась о поддержке наземной инфраструктуры Starlink. Пока единственным партнёром Starlink в области связи для мобильных устройств является оператор T-Mobile, но спутниковый провайдер приглашает к проекту и других игроков. И пока AST SpaceMobile пытается найти финансирование на запуск ещё 20 спутников, SpaceX работает опережающими темпами — ещё в ноябре компания Илона Маска (Elon Musk) сообщила Федеральной комиссии и по связи США (FCC), что в ближайшие 6 месяцев планирует вывести на орбиту около 840 аппаратов с поддержкой прямого подключения к немодифицированным смартфонам. Google обвинила хакеров российских спецслужб в серии кибератак

19.01.2024 [10:33],

Павел Котов

Эксперты по кибербезопасности Google из подразделения Threat Analysis Group (TAG) сообщили о серии кибератак, организованных хакерской группировкой Cold River, которая, по их версии, связана с российскими спецслужбами. Атаки производятся по фишинговой схеме.

Источник изображения: Pete Linforth / pixabay.com Группировка Cold River, известная также под названиями Callisto Group и Star Blizzard, проводит долгосрочные шпионские кампании, направленные против целей в странах НАТО — преимущественно в США и Великобритании. Целями являются высокопоставленные лица и организации, занимающиеся международной деятельностью и обороной. В последние месяцы Cold River нарастила свою активность. Атака группировки реализуется по фишинговой схеме, впервые зафиксированной в ноябре 2022 года. Потенциальной жертве в качестве приманки направляется PDF-документ, замаскированный под статью, на которую отправитель якобы пытается получить отзыв. Жертва открывает неопасный файл PDF, текст в котором выглядит так, будто он зашифрован. Если цель отвечает, что не может прочитать документ, хакер отправляет ей ссылку на якобы утилиту для расшифровки. В реальности это бэкдор SPICA — собственная разработка Cold River. Он открывает злоумышленникам постоянный доступ к компьютеру жертвы для выполнения команд, кражи документов и файлов cookie в браузере. Инженер по кибербезопасности TAG Билли Леонард (Billy Leonard) рассказал ресурсу TechCrunch, что Google неизвестно количество жертв, успешно скомпрометированных с помощью SPICA, но, по версии компании, бэкдор используется в «весьма ограниченных, целенаправленных атаках». Разработка SPICA, вероятно, продолжается, и бэкдор ещё применяется в осуществляемых сегодня атаках. Группировка Cold River в разрезе последних лет остаётся стабильно активной, несмотря на усилия правоохранительных органов. Обнаружив активную кампанию по распространению вредоносного ПО, Google добавила все связанные с Cold River домены, сайты и файлы в базу службы Safe Browsing, чтобы защитить своих пользователей. Ранее группировку Cold River связывали с операцией по взлому и утечке информации, в ходе которой было похищено множество электронных писем и документов высокопоставленных сторонников выхода Великобритании из Евросоюза, в том числе сэра Ричарда Дирлава (Richard Dearlove), бывшего главы британской службы внешней разведки MI6. Google поменяет поисковую выдачу для жителей ЕС в соответствии с требованиями DMA

18.01.2024 [18:02],

Сергей Сурабекянц

Google готовится к вступлению в силу «Закона о цифровых рынках» (DMA) в марте 2024 года. Согласно DMA, Google классифицируется как «привратник», к которым относятся компании с более чем 45 миллионами активных пользователей в месяц и рыночной капитализацией более €75 млрд ($81,2 млрд). Наиболее заметными станут изменения в поисковой системе — там, где Google может показать ссылку на несколько компаний, появится место для сравнения и уточнения результатов поиска.

Источник изображения: unsplash.com Представитель Google сообщил: «Для таких категорий, как отели, мы также начнём тестировать специальное пространство для сайтов сравнения и прямых поставщиков, чтобы показывать более подробные индивидуальные результаты, включая изображения, рейтинги и многое другое». В результате некоторые другие сервисы, такие как служба бронирования Google Flights, будут удалены со страниц поиска. Для связанных сервисов появятся дополнительные разрешения — европейские пользователи могут ожидать появления дополнительных баннеров с запросом согласия на обмен данными. По мнению Google, отказ от связывания сервисов может привести к ограничению функциональности или полной остановке работы некоторых функций. Google пока не предоставила точных данных, какие именно функции могут перестать работать, если европейский пользователь откажется от связывания и обмена своими данными между сервисами. В качестве примера представитель Google сообщил, что бронирования, сделанные в поиске, перестанут отображаются на картах Google, если службы не были связаны, а в ленте Discover будет отсутствовать персонализация, если поиск Google, YouTube и Chrome не связаны. Google также добавляет экраны выбора поисковой системы по умолчанию на телефоны Android. Аналогичный выбор может появиться и при настройке Chrome на настольном компьютере или устройстве iOS. Google также планирует представить разработчикам API для переноса данных, который дополнит существующую службу Google Takeout, позволяющую пользователям загружать или копировать свои данные из продуктов компании. В марте 2024 года все перечисленные обновления должны быть реализованы для жителей ЕС. Без сомнения, правительства и регулирующие органы других стран будут уделять пристальное внимание внедрению этих обновлений, чтобы в дальнейшем использовать опыт ЕС для корректировки своих законов в сфере цифровых технологий. Google не скрывает своего беспокойства по поводу вносимых изменений: «Хотя мы поддерживаем многие амбиции DMA в отношении потребительского выбора и совместимости, новые правила предполагают трудные компромиссы, и мы обеспокоены тем, что некоторые из этих правил уменьшат выбор, доступный людям и предприятиям в Европе». В 2022 году Google был признана «привратником» в соответствии с DMA. Цель DMA — ограничить полномочия «привратников» и лишить их конкурентных преимуществ. В число «привратников» также вошли Amazon, Apple, Meta✴, Microsoft и владелец TikTok ByteDance. Сейчас все эти компании вносят изменения в свои сервисы, готовясь к вступлению в силу DMA. Далеко не все участники цифрового рынка ЕС удовлетворены действиями «привратников». На днях ряд компаний, в том числе Ecosia, Qwant и Schibsted, подписали открытое письмо, в котором обвинили «привратников» в неспособности привести свой бизнес в соответствие с новыми правилами цифровой конкуренции ЕС. В письме компании призвали Еврокомиссию и Европарламент добиться соблюдения нормативных требований DMA, всеми крупными игроками IT-рынка, попадающими под действие нового закона. YouTube уволит около ста сотрудников

18.01.2024 [16:40],

Павел Котов

YouTube сократит около сотни сотрудников и проведёт частичную реструктуризацию деятельности. Об этом сообщает Tubefilter со ссылкой на внутреннюю записку подчинённым, направленную директором по развитию бизнеса YouTube Эллен Коу (Ellen Coe). Это примерно 1,4 % работников платформы, в штате которой числятся почти 7200 человек.  «По мере развития бизнеса у нас возрастает потребность в обеспечении его эффективного видения и удовлетворении потребностей всех наших пользователей. Мы приняли решение сократить некоторые должности и попрощаться с некоторыми нашими товарищами», — говорится в документе. Сокращение в первую очередь коснётся сотрудников отдела по работе с авторами, которые теперь будут закрепляться по странам, а не регионам. YouTube объединит все музыкальные подразделения, которые будут подчиняться Google и главе музыкального одела YouTube Лиору Коэну (Lyor Cohen), и консолидирует отделы спорта, СМИ, кино и телевидения в единое глобальное подразделение. На минувшей неделе Google уволила более тысячи сотрудников, в том числе инженеров, разработчиков «Google Ассистента» и создателей систем дополненной реальности. Глава компании Сундар Пичаи (Sundar Pichai) предупредил, что на текущий год сокращения ещё не закончились. Эллен Коу занимает должность директора по развитию бизнеса YouTube с осени 2022 года — на этом посту она сменила Роберта Кинкла (Robert Kyncl), который сейчас возглавляет Warner Music Group. Samsung не создавала ИИ для Galaxy S24 — она положилась на технологии Google

18.01.2024 [13:56],

Павел Котов

Samsung Electronics и подразделение Google Cloud объявили о новом многолетнем партнёрстве, в рамках которого работающие в облачной инфраструктуре Google технологии генеративного искусственного интеллекта становятся доступными владельцам телефонов Samsung по всему миру. Samsung стала первым партнёром Google Cloud, развернувшим модели Gemini Pro и Imagen 2 на платформе Vertex AI через облако на своих смартфонах.

Источник изображения: news.samsung.com Samsung первой развернула для потребителей модель Gemini Pro на платформе Vertex AI. Модель Gemini, изначально разработанная как мультимодальная, свободно понимает и создаёт сводки информации, обрабатывает и комбинирует различные типы данных, включая текст, программный код, изображения и видео. Она широко применяется в приложениях Samsung — владельцы устройств серии Galaxy S24 могут воспользоваться функцией составления сводок, доступной в приложении заметок, диктофона и клавиатуры. Работа с Gemini Pro также означает, что Samsung обеспечит пользователям такие базовые возможности Google Cloud как защита данных, безопасность и конфиденциальность. В рамках партнерства с Google компания Samsung также стала одним из первых клиентов, тестирующих Gemini Ultra, самую мощную и крупную модель Google для выполнения очень сложных задач. Локально на смартфонах Galaxy S24 также будет использоваться Gemini Nano, которая будет встроена в состав операционной системы Android 14 — самая эффективная модель Gemini для задач на устройстве. Пользователям смартфонов Samsung Galaxy S24 также доступны возможности модели Imagen 2 — генератора изображений, разработанного подразделением Google DeepMind. Она поможет с редактированием графических файлов в приложении «Галерея» на новых смартфонах корейского производителя. «Google Cloud вместе с Samsung видит огромные возможности генеративного ИИ для создания важных функций на мобильных устройствах, стимулирующих и укрепляющих связь и общение для миллионов людей. С Gemini разработчики Samsung могут пользоваться инфраструктурой Google Cloud мирового класса с высокими производительностью и гибкостью для создания безопасных, надёжных и привлекательных приложений на базе генеративного ИИ на смартфонах Samsung», — заявил глава Google Cloud Томас Куриан (Thomas Kurian). Chrome для Android научился читать страницы вслух — даже на русском языке

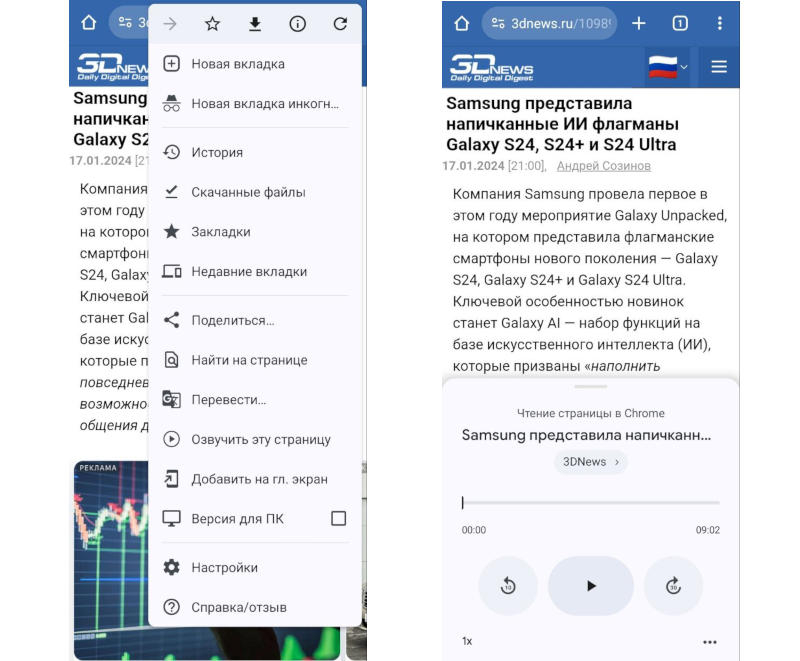

18.01.2024 [13:10],

Павел Котов

В браузере Google Chrome для Android появился предварительный вариант встроенной функции «Озвучить эту страницу» с поддержкой русского языка. Для её работы требуется бета-версия браузера и включение соответствующей опции на странице экспериментальных функций.  Для активации функции «Озвучить эту страницу» требуется включить опцию, доступную по адресу «chrome://flags/#read-aloud», и перезагрузить браузер. После этого в выпадающем меню, которое открывается по нажатии значка с тремя точками, появляется новый пункт. При запуске «Озвучить эту страницу» в браузере появляется мини-плеер с круглой кнопкой- воспроизведения и паузы, заголовком страницы, названием сайта, временной шкалой на продолжительность материала, а также кнопками перемотки вперёд и назад. Можно настраивать скорость воспроизведения (от 0,5x до 4x). Есть дополнительная опция «Выделение текста и автопрокрутка» — браузер автоматически прокручивает страницу по мере чтения текста и подсвечивает то, что зачитывается в текущий момент. Мини-плеер остаётся закреплённым при открытии других вкладок. Воспроизведение продолжается, когда устройство блокируется, но прерывается, когда браузер закрывается, например, при возврате на главный экран или переходе в другое приложение. Возможность включить экспериментальную опцию есть в общедоступной версии Chrome 120, но пункт меню «Озвучить эту страницу» появляется только в Chrome 121, который находится в стадии бета-тестирования. Качество поиска Google действительно скатилось — исследователи выяснили причину

18.01.2024 [13:02],

Владимир Мироненко

За последние несколько лет всё больше пользователей, аналитиков и экспертов стали говорить о том, что качество результатов поиска Google серьёзно снизилось, хотя компания не согласна с такой оценкой, пишет Gizmodo. PR-команда поискового гиганта сообщает, что его флагманский продукт является лучшим в своём классе, однако результаты недавнего исследования свидетельствуют об обратном.

Источник изображения: Pixabay В ходе исследования, проводившегося в течение года группой аналитиков из Лейпцигского университета, Университета Баухаус в Веймаре и Центра масштабируемой аналитики данных и искусственного интеллекта, было изучено 7392 поисковых запроса с обзорами продуктов в Google, Bing и DuckDuckGo. Как оказалось, страницы с самым высоким рейтингом были более оптимизированы, на них больше партнёрских ссылок и в целом их текст более низкого качества. Обзоры продуктов и сводки новостей являются одним из способов монетизации для многих веб-сайтов. Они содержат специальные ссылки для покупки товаров у таких ретейлеров, как Amazon, BestBuy и Walmart. Если пользователь делает покупку после нажатия одной из этих партнёрских ссылок, веб-сайт получает комиссию. Каждый может разместить статью об одном и том же продукте, поэтому тот, кто получит больше внимания к своей странице, получит больше денег. Для того чтобы обойти других и занять более высокое место в результатах поиска, сайты используют поисковую оптимизацию (SEO). И зачастую верхние строки поиска занимают те, кто преуспел в SEO, заполняя интернет «мусорным» контентом. «SEO — это постоянная битва, и мы видим повторяющиеся шаблоны спама с отзывами, которые попадают в результаты и покидают их, поскольку поисковые системы и SEO-инженеры по очереди корректируют свои параметры», — пишут исследователи. Google и её конкуренты постоянно корректируют свои алгоритмы, чтобы перекрыть дорогу оптимизаторам. Согласно исследованию, эти усилия не работают, и вносимые изменения часто приводят к временному положительному эффекту, однако спамеры находят новые лазейки. Вместе с тем исследование показало, что поиск Google работает значительно лучше по сравнению с Bing и DuckDuckGo, и что его результаты улучшились в ходе исследования. Представитель Google сообщил ресурсу Gizmodo, что исследование не отражает полной картины общей эффективности поиска. «Упомянутое исследование сосредоточено на содержании обзоров продуктов, и оно не отражает общее качество и полезность поиска для миллиардов запросов, которые мы видим каждый день, — сказал представитель компании. — Мы внедрили конкретные улучшения для решения этих проблем, и само исследование указывает, что Google улучшился за последний год и работает лучше, чем другие поисковые системы. В более широком смысле многочисленные сторонние компании измерили результаты поисковых систем по другим типам запросов и обнаружили, что качество Google значительно выше, чем у остальных». У экспертов и пользователей другое мнение по этому поводу. Они утверждают, что в целом поиск Google стал намного хуже за последние годы, хотя компания работает над решением этой проблемы. «Мы никогда не видели Google в таком беспорядке», — сказала Лили Рэй (Lily Ray), старший директор по SEO и руководитель отдела органических исследований в Amsive Digital. Также следует отметить, что за последние годы Google увеличила количество объявлений, появляющихся в верхней части результатов поиска, и всё больше отдаёт предпочтение результатам со ссылкой на информацию из собственных сервисов, даже в тех случаях, когда есть более качественный контент из сторонних источников. Google представила Circle to Search — поиск по всему, что есть на экране смартфона

18.01.2024 [12:00],

Павел Котов

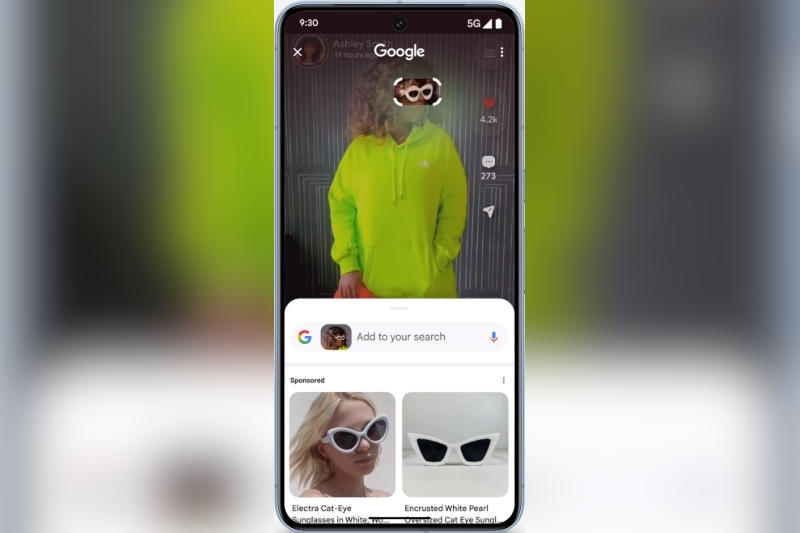

Google официально представила новую интуитивную функцию визуального поиска Circle to Search, работа которой соответствует её названию: пользователь обводит фрагмент на экране смартфона, жмёт кнопку поиска, и система предлагает ему подходящие результаты. Circle to Search дебютирует на пяти смартфонах: двух актуальных флагманах Google и трёх новых устройствах Samsung.

Источник изображения: blog.google Circle to Search во многом напоминает Google Lens, но работает не только в собственном поисковом приложении Google, а в любом приложении на устройстве. Пользователям, которые предпочитают классическую трёхкнопочную навигацию, достаточно нажать и удерживать кнопку «Домой»; а тем, кто перешёл на жестовое управление — навигационную полосу, после чего инструмент Circle to Search появится поверх любого приложения или экрана. Далее достаточно выделить любой объект или коснуться его, будь то текст или изображение. Circle to Search — новый шаг относительно функции множественного поиска (Multisearch) Google, которая позволяет дополнять визуальные запросы в Lens текстовыми. В отличие от Circle to Search, множественный поиск в приложении Google с сегодняшнего дня начал работать на любых устройствах под Android или iOS, но пока только в США. В Google грядут новые массовые увольнения, предупредил глава компании

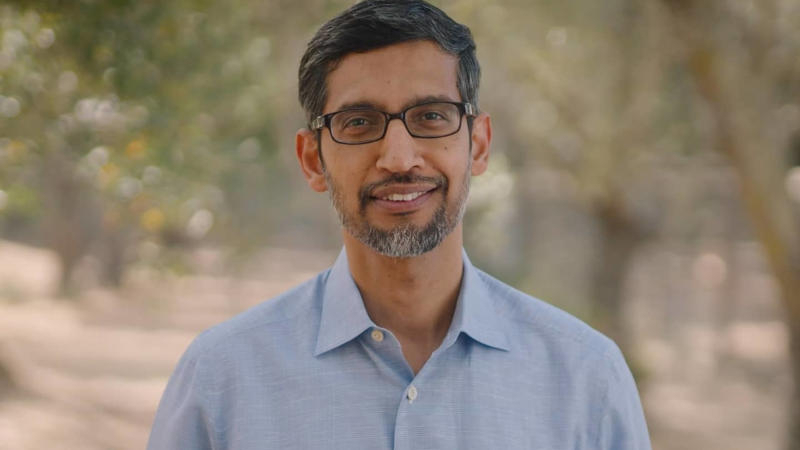

18.01.2024 [10:48],

Павел Котов

После увольнения более тысячи сотрудников в различных подразделениях Google и сокращения сотни рабочих мест в YouTube генеральный директор Google Сундар Пичаи (Sundar Pichai) разослал своим подчинённым записку с предупреждением, что в этом году ожидаются новые увольнения.

Источник изображения: Sundar Pichai Глава компании сообщил, что ей придётся сделать «непростой выбор», чтобы достичь поставленных целей, выяснил ресурс The Verge. Он, однако, оговорился, что в этом году сокращения будут не такими масштабными, как в прошлом году, когда компании пришлось попрощаться с 12 000 сотрудников или 6 % своего штата. «Эти увольнения уступают масштабам прошлогодних сокращений и коснутся не каждого подразделения. Но я знаю, насколько тяжело смотреть на коллег и подразделения, которые это затронуло. <..> Обо многих из этих изменений уже объявлено, но, говоря наперёд, некоторые подразделения продолжат принимать конкретные решения о распределении ресурсов в течение года по мере необходимости в отношении затронутых должностей», — отметил Сундар Пичаи в электронном письме. За последнее время увольнения коснулись нескольких подразделений Google, включая разработчиков аппаратной продукции, инженеров, специалистов по рекламе и услугам — всего уволены более тысячи сотрудников. Компанию покинули основатели Fitbit Джеймс Пак (James Park) и Эрик Фридман (Eric Friedman). В рамках реорганизации сокращена сотня сотрудников YouTube. Медицинский ИИ Google оказался человечнее живых врачей, но не всё так просто

17.01.2024 [18:39],

Павел Котов

Google поделилась результатами исследования, в рамках которого установила, что основанный на искусственном интеллекте чат-бот в переписке более эффективно диагностирует медицинские заболевания и более гуманно сообщает о них пациентам, чем настоящие врачи. Впрочем, делать окончательные выводы ещё рано.

Источник изображения: Yerson Retamal / pixabay.com Система под названием Articulate Medical Intelligence Explorer (AMIE) представляет собой большую языковую модель, предназначенную для сбора медицинских данных и ведения клинических бесед. AMIE разработана, чтобы анализировать предлагаемые пациентами симптомы, задавать дополнительные вопросы и прогнозировать диагнозы. В ходе тестирования были выбраны 20 добровольцев, играющих роль пациентов и якобы страдающих некими заболеваниями, а также 20 профессиональных врачей — специалистов по первичной медицинской помощи, отвечающих за фактор человеческого контакта. Пациенты не знали, с кем переписывались: с ИИ или настоящими врачами. И их попросили оценить качество взаимодействия вслепую. В рамках эксперимента были разыграны 149 сценариев, и выяснилось, что пациенты предпочитали общаться с AMIE, а не настоящими врачами. Участники заявили, что чат-бот лучше понял их проблемы и дал более чуткие, ясные и профессиональные ответы. AMIE также более точно диагностировал медицинские проблемы. Но это не значит, что чат-бот оказывает медицинскую помощь эффективнее настоящего врача, пояснили в Google. Предложенная исследователями методика, конечно, занижает действительную ценность разговора с человеком: врачи были ограничены интерфейсом текстового чата — он хорош для взаимодействия пациентов с ИИ, но не репрезентативен для стандартной клинической практики. Google не пыталась заменить врачей первичной медицинской помощи, а захотела продемонстрировать, что чат-бот с ИИ может оказаться полезным инструментом для пациентов, лишённых доступа к здравоохранению. Но в реальном мире развёртывание такой системы пока рискованно — для её ответственного использования потребуется значительная доработка. Google лишит работы несколько сотен человек — их заменит ИИ

17.01.2024 [10:49],

Павел Котов

Руководство Google подтвердило появившуюся в конце декабря информацию о намерении сократить некоторое число работников: директор по развитию бизнеса Филипп Шиндлер (Philipp Schindler) сообщил во внутренней записке, что компания уволит «несколько сотен сотрудников» из отдела по продажам рекламы, передаёт Business Insider.

Источник изображения: Alex Dudar / unsplash.com Серия сокращений затронет преимущественно отдел продаж крупным клиентам (Large Customer Sales — LCS) по рекламному направлению. Реструктуризация рекламного подразделения намечена уже на текущий месяц, подтвердило издание The Information: часть сотрудников покинет компанию, а некоторых переведут на другие должности, потому что их обязанности теперь будет исполнять искусственный интеллект. В записке Шиндлера об ИИ напрямую не говорится. В последнее время направление Google Ads обогатилось множеством функций генеративного искусственного интеллекта. В частности, появился чат-бот, поддерживающий обработку естественного языка — он помогает клиентам ориентироваться в широком ассортименте рекламных продуктов. Есть также система, самостоятельно генерирующая рекламные ресурсы — изображения и текст — сообразно бюджету и целям, которые устанавливает рекламодатель. Эти продукты входят в пакет Performance Max: настройка и содержание рекламных объявлений меняются на основе рейтинга кликов как системы обратной связи в реальном времени. Раньше все эти задачи вручную решал рекламодатель, а теперь ИИ выполняет необходимые операции тысячи раз в секунду. Очередную волну сокращений Google запустила ещё в прошлом году. На минувшей неделе работу потеряли несколько сотен сотрудников, занятых разработкой аппаратной продукции, «Google Ассистента» и систем дополненной реальности. До этого были увольнения в подразделениях «Google Новости», Waze, Waymo, подразделении робототехники и в отделе кадров. Google незаметно обновила предупреждение Chrome о режиме инкогнито после проигранного иска

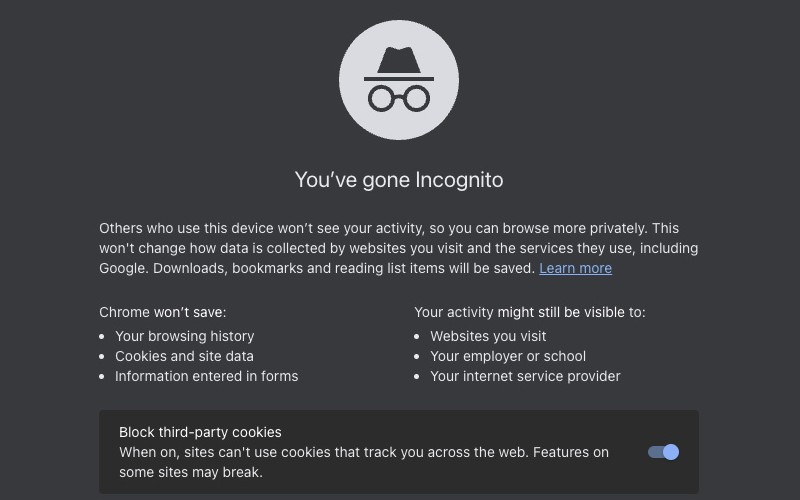

16.01.2024 [19:18],

Сергей Сурабекянц

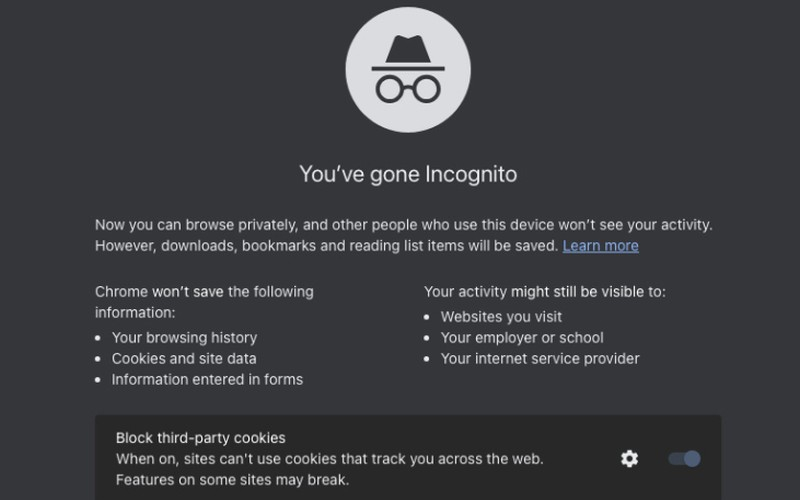

Спустя несколько недель после согласия урегулировать иск, в котором Google обвинялась в незаконном отслеживании активности пользователей при сёрфинге в интернете даже при активированном в Chrome режиме «инкогнито», компания незаметно обновила само описание приватного просмотра в своём браузере. Обновлённый текст был обнаружен исследователями в последней Canary-сборке Google Chrome версии 122.0.6251.0.

Источник изображения: unsplash.com Обновлённый текст описания приватного режима гласит: «Другие пользователи, использующие это устройство, не увидят вашу активность, поэтому вы можете просматривать страницы более конфиденциально. Это не повлияет на сбор данных веб-сайтами, которые вы посещаете, и службами, которые они используют, включая Google. Загрузки, закладки и элементы списка чтения будут сохранены».

Источник изображений: Google Для сравнения, описание приватного режима в текущей стабильной версии Chrome следующее: «Теперь вы можете просматривать страницы конфиденциально, и другие люди, использующие это устройство, не увидят вашу активность. Однако загрузки, закладки и элементы списка чтения будут сохранены».  Дальнейшая информация под описанием режима «инкогнито» осталась неизменной. Активность пользователя в интернете по-прежнему может быть видна:

Изменение Google в уведомлении примечательно тем, что ранее компания использовала его как доказательство информирования пользователей о всех видах отслеживания, которое может осуществляться в режиме «инкогнито». «Мы чётко заявляем, что каждый раз, когда вы открываете новую вкладку в режиме "инкогнито", веб-сайты могут собирать информацию о вашей активности в интернете во время сеанса», — утверждал в прошлом году представитель Google Хосе Кастаньеда (José Castañeda). Но суду в августе прошлого года этот аргумент не показался убедительным, и он отклонил предложение Google о вынесении решения в порядке упрощённого судопроизводства в августе прошлого года. В прошлом месяце сообщалось, что Google и истцы договорились об условиях урегулирования. Они будут представлены суду в январе, а окончательное решение будет вынесено ближе к концу февраля. Пользователи Google в Евросоюзе смогут выбирать, какие сервисы компании имеют доступ к их данным

14.01.2024 [06:03],

Владимир Фетисов

Google продолжает корректировать свою политику в отношении сбора и обработки данных для соответствия Закону о цифровых рынках, который вступит в силу в Евросоюзе 6 марта. На этой неделе поисковый гигант объявил, что проживающие в регионе пользователи смогут сами решать, какие сервисы компании будут иметь доступ к их данным. Можно полностью отказаться от передачи данных, выбрать какие-то отдельные сервисы или же разрешить всем службам Google продолжать обрабатывать данные.

Источник изображения: Alex Dudar / unsplash.com В сообщении сказано, что пользователи смогут ограничить обработку персональных данных в поисковике Google, на YouTube, в рекламных службах компании, Play Маркете, Chrome, а также сервисах Google Покупки и Google Карты. Отмечается, что вновь вводимые ограничения не являются абсолютными и пользовательские данные будут обрабатывать в случаях, когда того требует выполнение определённых задач. Например, при оплате товаров в сервисе Google Покупки с помощью платёжной системы Google Pay. Отметим, что это не самое большое изменение, которое Google предстоит внести для соответствия требованиям Закона о цифровых рынках, поскольку в нём содержатся дополнительные правила, касающиеся конкуренции и ряда других аспектов. К примеру, Google больше не сможет относиться к своим сервисам в рейтинге поиска более предпочтительно, чем к сервисам потенциальных конкурентов. При этом пользователям стоит помнить, что для корректной работы некоторых сервисов Google необходимо, что определённые пользовательские данные всё же попадали в компанию. К примеру, если заблокировать сбор данных в поисковике, YouTube и Chrome, то пользователь перестанет получать персонализированные рекомендации на YouTube. Если заблокировать сбор данных в поисковике и Google Картах, то в картографическом сервисе больше не будут предлагаться места для посещения на основе предыдущих активностей пользователя. По большому счёту, пользователям по-прежнему придётся выбирать между приватностью и удобством, но с новыми изменениями они могут более точно определить, каким сервисам Google следует разрешить сбор информации. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |