|

Опрос

|

реклама

Быстрый переход

Samsung рассчитывает обеспечить скорость передачи информации с помощью HBM4E до 13 Гбит/с

19.10.2025 [07:19],

Алексей Разин

Память типа HBM4E считается седьмым поколением соответствующей технологии, подразумевающей формирование стека из нескольких ярусов DRAM. В 2027 году Samsung Electronics намеревается наладить массовое производство HBM4E, обеспечив с её помощью увеличение скорости передачи информации в два с половиной раза относительно нынешней HBM3E.

Источник изображения: Samsung Electronics Как поясняет Business Korea со ссылкой на выступление представителей Samsung на OCP Global Summit 2025 в Калифорнии, компания рассчитывает поднять скорость передачи информации с помощью HBM4E до 13 Гбит/с на контакт. Если учесть, что HBM4E будет оснащаться 2048 контактами, результирующее быстродействие может достичь 3,25 Тбайт/с. При этом энергетическая эффективность HBM4E окажется в два с лишним раза выше, чем у HBM3E. В январе текущего года Samsung рассчитывала увеличить пропускную способность HBM4E до 10 Гбит/с на контакт, поэтому прирост до 13 Гбит/с можно считать довольно серьёзным. Во многом такое изменение было спровоцировано Nvidia, которая запросила у своих потенциальных поставщиков памяти для ускорителей семейства Rubin увеличить пропускную способность HBM4 с 8 до 10 Гбит/с. Samsung и SK hynix решили поднять планку до 11 Гбит/с, Micron была вынуждена поступить аналогичным образом. Соответственно, из-за такого роста пропускной способности HBM4 производителям придётся пересмотреть и характеристики потенциально более быстрой HBM4E, что Samsung формально и сделала. Важно, что результирующая пропускная способность такой памяти впервые в истории превысит 3 Тбайт/с. Попутно Samsung рассказала о характеристиках LPDDR6, которая была стандартизована JEDEC в июле текущего года. Компания планирует улучшить энергетическую эффективность на 20 % по сравнению с LPDDR5X, а пропускную способность поднять до 114,1 Гбайт/с. В сфере контрактного производства Samsung намеревается освоить массовый выпуск 2-нм продукции до конца этого года. Клиентом Samsung на этом направлении стал южнокорейский разработчик ускорителей ИИ — компания Rebellions. Соответствующие 2-нм процессоры смогут достигать частот от 3,5 до 4,0 ГГц. Это несколько выше, чем у выпускаемых TSMC по 4-нм технологии процессоров Nvidia Grace с архитектурой Arm, которые работают на частоте 3,44 ГГц. Память HBM4 окажется дороже, чем ожидалось, но производители не останутся внакладе

18.10.2025 [08:02],

Алексей Разин

Ведущие производители уже готовы начать массовые поставки микросхем типа HBM4, чтобы в следующем году их клиенты смогли наладить выпуск ускорителей вычислений, наделённых памятью нового поколения. При этом некоторые источники высказывают опасения, что HBM4 окажется дороже, чем ожидалось ранее.

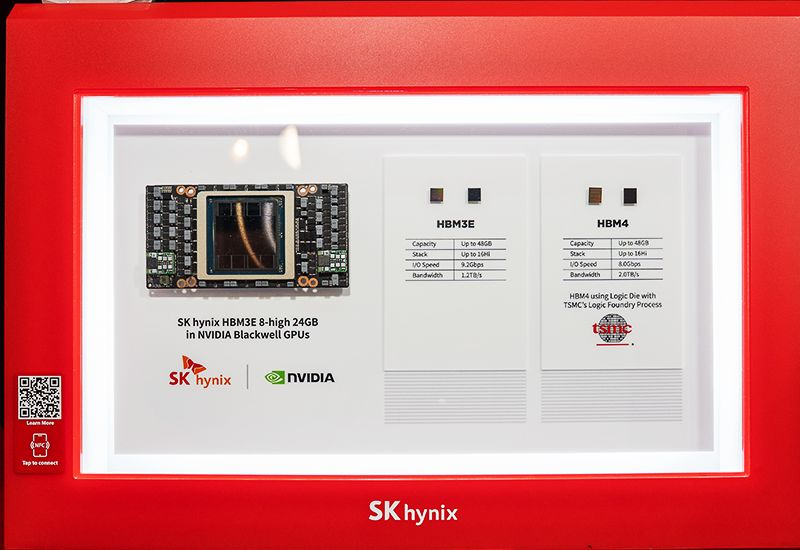

Источник изображения: SK hynix Как отмечает ComputerBase со ссылкой на южнокорейские СМИ, по сравнению с HBM3E память типа HBM4 может быть дороже на величину до 60 %. В этой ситуации важно учитывать, что сама по себе HBM3E с начала этого года тоже успела подорожать на 20 %. По некоторым прогнозам, за стек HBM4 объёмом 36 Гбайт поставщики будут просить до $600. В пользу дороговизны такой памяти играют сразу несколько факторов. Это и сложность производства базовых кристаллов, которые могут адаптироваться под нужды конкретных заказчиков, а также возросшие затраты на компоновку кристаллов памяти в стеке с вертикальными межсоединениями. Наконец, объёмы производства HBM4 на первых порах будут ограничены, что само по себе вызовет рост цен. В любом случае, производители памяти не останутся в проигрыше при выпуске HBM4 даже в таких условиях. Как поясняют представители Micron, при производстве HBM3E потребляется в три раза больше кремниевых кристаллов, чем при выпуске обычной DDR5. В случае с HBM4 эта пропорция увеличится ещё сильнее, а к моменту выхода HBM4E превысит «4:1». Это само по себе ограничит объёмы выпуска памяти, сделает её дороже, причём тенденция коснётся и прочих видов памяти, а не только HBM. Опять же, если потребности в кремнии превышают DDR5 в четыре раза, то цена HBM4 будет выше в восемь раз, и это должно с запасом покрывать все издержки производителей памяти. Первыми ускорителями вычислений, оснащаемыми памятью типа HBM4, во второй половине следующего года должны стать Nvidia Rubin и AMD Instinct MI400. Micron наладит выпуск кастомизируемой HBM4E в 2027 году при участии TSMC

26.09.2025 [07:50],

Алексей Разин

Американская компания Micron Technology старается не отставать от конкурентов в сфере освоения производства новых типов памяти, и ещё в конце прошлого года заявила, что будет сотрудничать с TSMC при производстве HBM4E, в основе которой будет лежать кастомизируемый кристалл. Недавно руководство Micron пояснило, что выпуск такой памяти будет налажен не ранее 2027 года.

Источник изображения: Micron Technology Как можно судить по стенограмме выступления представителей Micron Technology на минувшей квартальной отчётной конференции, компания очень гордится тем, что в основе HBM4, которая будет выпускаться в 2026 году, будет лежать базовый кристалл собственного производства, изготавливаемый по технологии КМОП (CMOS). По мнению генерального директора Санджея Мехротры (Sanjay Mehrotra), такое сочетание обеспечит HBM4 производства Micron передовым быстродействием. «HBM4E в масштабах всей отрасли не является продуктом 2026 года, это будет продукт 2027 года, мы поделимся подробностями о нём позже, и у нас будет как стандартный вариант HBM4E, так и кастомизируемый», — пояснил глава Micron на этой неделе. Ранее он отметил, что при производстве базового кристалла для HBM4E компания будет полагаться на технологические возможности TSMC. Кроме того, появление HBM4E в ассортименте продукции Micron позволит компании поднять норму прибыли, особенно в случае кастомизированной версии. В ходе своего выступления на квартальной конференции глава Micron пояснил, что TSMC будет выпускать для компании базовые кристаллы не только стандартной, но и кастомизированной версии HBM4E. В последнем случае подразумевается, что функциональность базового кристалла будет определяться конкретным заказчиком, для которого потом Micron и TSMC будут сообща изготавливать HBM4E. Создавать конкурентоспособный продукт данного поколения Micron поможет не только участие TSMC, но и использование собственного техпроцесса класса 1β для выпуска кристаллов DRAM, а также усовершенствованные технологии упаковки памяти. Micron похвалилась, что её HBM4 — самая быстрая память на рынке

24.09.2025 [11:00],

Алексей Разин

Квартальная отчётная конференция Micron Technology оказалась богата на заявления представителей компании, которые позволяли оценить текущие тенденции в развитии сегмента искусственного интеллекта. Этот производитель, например, убеждён, что сможет предлагать самую быструю память типа HBM4 на рынке.

Источник изображения: Micron Technology Сумит Садана (Sumit Sadana), исполнительный вице-президент и директор по развитию бизнеса Micron Technology, в ходе своего выступления отметил, что по занимаемой доле рынка в сегменте HBM компания по итогам третьего календарного квартала выйдет примерно на уровень своей доли на рынке DRAM в целом, а по итогам следующего календарного года увеличит свою долю в сегменте HBM по сравнению с текущим годом. Во многом такая уверенность, как он пояснил далее, основана на способности Micron Technology предложить клиентам самую быструю память типа HBM4 на рынке. Вот что заявил представитель компании: «Мы верим, что наша HBM4 обеспечивает самое высокое быстродействие на рынке по сравнению с любым из конкурирующих продуктов. Мы уверены, что сможем полностью распродать всю производственную программу на 2026 год». По данным компании, она снабжает своих клиентов образцами HBM4 со скоростью передачи информации 11 Гбит/с. Поскольку в последние месяцы много говорится о принятом крупными производителями DRAM свернуть производство микросхем DDR4, Сумиту Садане не удалось избежать обсуждения этой темы при общении с аналитиками. Он пояснил, что без учёта LPDDR4, сама по себе DDR4 отвечает лишь за несколько процентов всего бизнеса компании. По сути, это указывает на взятый Micron курс на поэтапное прекращение выпуска DDR4. Глава Micron Санджей Мехротра (Sanjay Mehrotra) пояснил, что HBM4 в исполнении этой компании будет оснащаться базовым кристаллом собственной разработки, она станет основным продуктом в этом сегменте рынка, производство которого будет наращиваться в 2026 году. Зато в 2027 году будет налажен выпуск HBM4E, которая будет предлагаться как в стандартизированной, так и в кастомизированной под запросы клиентов форме. В целом, Micron поставляет свою память HBM различных поколений шести крупным клиентам. Nvidia испугалась ускорителей AMD и просит поставщиков сделать для неё HBM4 побыстрее

18.09.2025 [14:58],

Алексей Разин

В следующем году Nvidia рассчитывает вывести на рынок ускорители вычислений семейства Rubin с поддержкой передовой памяти HBM4, но поскольку на горизонте замаячила конкурентная угроза в виде AMD Instinct MI450, она уже сейчас пытается обеспечить себе преимущество в быстродействии. Nvidia попросила поставщиков HBM4 подтянуть спецификации предназначающихся ей микросхем, увеличив скорость передачи информации до 10 Гбит/с.

Источник изображения: SK hynix Как отмечает TrendForce, пока нет уверенности в том, что производители HBM4 смогут исполнить пожелания Nvidia, но SK hynix наверняка сохранит за собой статус крупнейшего поставщика памяти для ускорителей указанной американской марки в самом начале перехода на HBM4. Нюанс заключается в том, как поясняет источник, что Samsung Electronics изначально рассчитывала выпускать базовый кристалл HBM4 по 4-нм техпроцессу с использованием FinFET, а также предложить скорости передачи информации до 10 Гбит/с. Всё это позволит Samsung предпринять попытку выйти в лидеры по поставкам HBM4 для нужд Nvidia в среднесрочной перспективе. Скорость экспансии ускорителей Nvidia Rubin, по мнению TrendForce, будет зависеть от доступности памяти HBM4 с необходимыми характеристиками в достаточных количествах. Если чипов HBM4 со скоростью передачи информации 10 Гбит/с окажется мало, Nvidia либо откажется от идеи поднять характеристики памяти Rubin, либо будет более тонко сегментировать свою продукцию и в каждой нише сотрудничать с оптимальным поставщиком памяти. Кроме того, Nvidia может провести сертификацию HBM4 в два этапа, предоставив тем самым «отстающим» поставщикам больше времени на подготовку. В следующем году, как считают эксперты TrendForce, крупнейшим поставщиком HBM4 для Nvidia останется SK hynix, а вот успех Samsung и Micron в этой сфере будет во многом зависеть от скорости прохождения сертификации и улучшения характеристик продукции. SK hynix первой завершила разработку HBM4 и готова начинать её выпуск — Samsung и Micron снова отстали

12.09.2025 [17:10],

Павел Котов

Южнокорейский производитель компонентов памяти SK hynix объявил, что завершил разработку чипов стандарта HBM4 и подготовил их к запуску в массовое производство. Компания опередила конкурентов и обеспечила своим акциям резкий рост.

Источник изображений: skhynix.com HBM (High Bandwidth Memory) — тип памяти, который используется в ускорителях искусственного интеллекта, в том числе в продукции Nvidia, лидера рынка. SK hynix раньше своих основных конкурентов в лице Samsung и Micron направила основным клиентам образцы чипов HBM нового поколения; теперь же она завершила их внутреннюю валидацию и процессы контроля качества, что означает готовность к серийному производству. Это достижение глава отдела разработки HBM в SK hynix Чжу Хан Чо (Joohwan Cho) назвал «новым этапом для отрасли». HBM4 представляет собой шестое поколение технологии HBM — разновидности динамической памяти с произвольным доступом (DRAM). По сравнению с памятью предыдущего поколения новая HBM4 предлагает удвоенную пропускную способность за счёт выросшего вдвое до 2048 количества терминалов ввода-вывода, а также рост энергоэффективности более чем на 40 %. Развёртывание оборудования на базе HBM4 позволит повысить производительность ускорителей искусственного интеллекта на величину до 69 %, подсчитали в SK hynix — память нового поколения устранит узкие места в области передачи информации и поможет значительно снизить затраты на электроэнергию для центров обработки данных. Утверждённый JEDEC3 стандарт предусматривает для HBM4 стандартную рабочую скорость 8 Гбит/с, но в реализации SK hynix этот показатель удалось увеличить до 10 Гбит/с. При производстве будут использоваться зарекомендовавший себя технологический процесс MR-MUF4, а также техпроцесс 1bnm — пятое поколение технологии 10 нм, чтобы свести к минимуму риски при массовом производстве.  Как ожидается, память HBM будет использоваться в ИИ-ускорителях нового поколения Nvidia Rubin, которые начнут работать в ЦОД почти по всему миру. Samsung и Micron становится всё труднее угнаться за SK hynix, которая является основным поставщиком для Nvidia и располагает ресурсами, чтобы укреплять своё лидерство в сегменте HBM. Micron, тем не менее, уже отправила свои чипы HBM4 на квалификацию Nvidia; Samsung пока продолжает разработку. После анонса акции SK hynix выросли на более чем 7 % и достигли максимальной цены с 2000 года; с начала текущего года они подорожали на 90 %. Акции Samsung и Micron с начала года демонстрируют рост более чем на 40 % и почти на 80 % соответственно. По итогам последнего квартала на сегменте HBM пришлись 77 % общей выручки SK hynix. С начала года рыночная капитализация корейского производителя увеличилась более чем на $80 млрд. По итогам 2025 года компания намеревается удвоить продажи в сравнении с 2024 годом; в 2026 году, по её прогнозам, спрос на продукцию для систем ИИ продолжит расти. Samsung расширяет производственные мощности в надежде на будущие заказы на HBM4

12.09.2025 [11:52],

Алексей Разин

Известно, что лидером рынка HBM остаётся формально более мелкая компания SK hynix, которая на этой неделе объявила о завершении разработки HBM4, но Samsung Electronics всё ещё тешит себя надеждами наверстать упущенное на этапе производства HBM4. Для этого она уже сейчас приступила к строительству нового предприятия в Южной Корее, которое в случае необходимости позволит ей быстро нарастить объёмы выпуска HBM4.  Как отмечает Business Korea, в конце прошлой недели на площадке P5 производственного кластера в Пхёнтхэке была замечена повышенная активность строительных рабочих. Они перемещали стальные конструкции и проходили инструктаж по промышленной безопасности, что может говорить о подготовке к началу полномасштабного строительства нового производственного корпуса. Изначально он должен был появиться здесь ещё в прошлом году, но Samsung притормозила строительство, сославшись на неблагоприятные условия на рынке полупроводниковой продукции. Ожидается, что фундамент корпуса P5 будет заложен в следующем месяце. Давно известно, что Samsung пытается пройти сертификацию Nvidia со своей HBM3E, но до сих пор смогла добиться только разрешения на поставки такой памяти для ускорителей ограниченного ассортимента, предназначающихся для китайского рынка. Новая попытка получить сертификат соответствия на HBM3E компания Samsung должна предпринять в этом месяце. Кроме того, пусть и с отставанием от SK hynix примерно на три месяца, Samsung надеется наладить поставки HBM4 для своих клиентов, среди которых жаждет увидеть Nvidia. Последняя намеревается завершить сертификационные тесты HBM4 к концу первого квартала следующего года, чтобы во второй половине того же года представить ускорители вычислений Rubin, использующие память данного типа. SK hynix наверняка окажется первым поставщиком HBM4 для нужд Nvidia, но Samsung надеется получить сертификат соответствия следующей и быстро наладить поставки HBM4 в требуемых количествах. Выпуск памяти нового поколения Samsung рассчитывает запустить до конца этого года. С этой точки зрения возведение нового предприятия в Южной Корее является манёвром на упреждение. Samsung рассчитывает, что сможет загрузить его мощности заказами на выпуск HBM4. Кроме того, одна из пустующих линий на соседнем P4 будет переоборудована под выпуск кристаллов DRAM для стеков HBM4 по передовому техпроцессу 10-нм класса. Скоро Samsung приступит к поставкам образцов HBM4 своим клиентам, чтобы те смогли оценить качество такой памяти. К первому кварталу следующего года расширение производственного кластера Samsung в Пхёнтхэке как раз должно завершиться. Заявление SK hynix о завершении разработки HBM4 вызвало рост курса акций компании до рекордных высот

12.09.2025 [06:03],

Алексей Разин

Южнокорейская SK hynix остаётся крупнейшим поставщиком чипов класса HBM для ускорителей вычислений Nvidia, а последняя контролирует значительную часть рынка компонентов для ИИ. По этой причине заявление SK hynix о завершении разработки HBM4 вызвало рост курса акций компании на 7,3 % до исторических максимумов.

Источник изображения: SK hynix Теперь капитализация SK hynix достигает $170 млрд, как поясняет Bloomberg, на протяжении восьми предыдущих торговых сессий её акции продолжали рост. Рабочую неделю SK hynix подытожила заявлением о завершении разработки HBM4 и готовности к началу массового производства, сроки которого предпочла не уточнять. Поставки образцов 12-ярусных стеков HBM4 своим клиентам компания уже начала ранее, в марте пообещав наладить массовый выпуск данного типа памяти до конца текущего года. HBM4 может предложить интерфейс с удвоенной до 2048 бит шиной по сравнению с предшественницей, а также улучшенную на 40 % по сравнению с HBM3E энергетическую эффективность. Быстродействие подсистемы памяти в инфраструктуре ИИ после перехода на HBM4 компания надеется увеличить на 69 %. Спецификации JEDEC на уровне 8 Гбит/с память HBM4 производства SK hynix превзошла с запасом, достигнув показателя в 10 Гбит/с. При производстве HBM4 компания будет использовать технологию MR-MUF с заполнением пространства между кристаллами памяти в стеке жидким компаундом, которая обеспечивает более эффективный отвод тепла по сравнению с традиционными методами, подразумевающими использование плёночных материалов. Кроме того, при изготовлении кристаллов памяти SK hynix будет применять 10-нм технологию пятого поколения, именуемую «1β нм». Акции компании в прошлом году выросли в цене почти на 90 %, поскольку она неплохо зарабатывает на буме ИИ, поставляя свою память для ускорителей вычислений Nvidia, которые очень востребованы на рынке. Готовность к серийному выпуску HBM4 повышает доверие инвесторов к этому производителю памяти. Samsung готова сбить цены, чтобы перехватить у SK hynix заказы Nvidia на память HBM

21.08.2025 [12:41],

Алексей Разин

Проблемы Samsung с сертификацией своей памяти HBM3E под нужды Nvidia давно известны, но компания не оставляет попыток получить заказы этого клиента даже на фоне скорого начала выпуска HBM4. Предполагается, что Samsung попытается привлечь Nvidia за счёт скидок, достигающих 30 % по сравнению с предложениями SK hynix.

Источник изображения: Samsung Electronics Во-первых, как отмечает Sedaily, ещё в прошлом месяце Samsung удалось пройти квалификационные тесты Nvidia для ранних прототипов памяти HBM4, и в конце текущего месяца начнётся выпуск их предсерийных версий. Если и они удовлетворят требованиям Nvidia, то к производству серийных чипов HBM4 компания Samsung рассчитывает приступить уже в ноябре, сократив своё технологическое отставание от SK hynix. Американская Micron ещё в июне сообщила о начале поставок образцов HBM4 своим клиентам. Во-вторых, к концу месяца Samsung может получить долгожданное одобрение на поставку HBM3E для нужд Nvidia, и это событие также способно повлиять на взаимоотношения заказчика с SK hynix. По крайней мере, свои чипы HBM3E компания Samsung готова предлагать по цене на 20–30 % ниже, чем у SK hynix. В этой ситуации Nvidia намерена дождаться результатов сертификационных испытаний микросхем HBM3E и HBM4 производства Samsung, прежде чем заключать контракт с SK hynix на определённых ценовых условиях. Аналитики TrendForce предполагают, что маркетинговая политика Samsung в этом смысле приведёт к снижению цен на память класса HBM в следующем году. Ходят слухи, что Nvidia участвует в разработке собственных базовых кристаллов для HBM4, которые будут адаптированы под нужды крупнейших покупателей ускорителей вычислений. Вероятно, образцы базовых кристаллов для Nvidia кто-то из её подрядчиков начнёт выпускать по 3-нм технологии во второй половине 2027 года. После успеха с Tesla компания Samsung намерена привлечь других крупных заказчиков

31.07.2025 [11:05],

Алексей Разин

Попытки Samsung Electronics сохранить в секрете имя крупного заказчика, сделка с которым позволит выручить $16,5 млрд, разбилась об импульсивность Илона Маска (Elon Musk), который заявил, что корейский подрядчик будет выпускать чипы AI6 для Tesla. Представители Samsung на этой неделе добавили, что надеются привлечь и других крупных клиентов к своему контрактному бизнесу по выпуску чипов.

Источник изображения: Samsung Electronics Как отмечает Reuters, вице-президент Samsung Electronics Но Ми Чжун (Noh Mi-jung) после оглашения квартальной отчётности лишь отметила, что упоминаемая выше сделка с безымянным заказчиком должна позволить компании привлечь дополнительных клиентов. Она также добавила, что новое предприятие Samsung в Техасе начнёт выпускать продукцию в следующем году. Напомним, контракт с Tesla подразумевает поставки чипов AI6 с этого предприятия до 2033 года включительно. При производстве чипов AI6 будет использоваться 2-нм техпроцесс, однако нельзя однозначно утверждать, что именно этот вид продукции предприятие в Тейлоре начнёт выдавать уже в следующем году. Ситуация с поставками HBM3E для нужд Nvidia комментариев со стороны руководства Samsung после публикации квартальной отчётности не удостоилась, но вице-президент компании хотя бы отметила, что объёмы поставок HBM3E растут быстрее, чем спрос, а потому это формирует условия для предстоящего снижения цен. Samsung уже начала предоставлять своим клиентам образцы памяти HBM следующего поколения, в котором угадывается HBM4, но массовые поставки будут развёрнуты только в следующем году. Ситуация в полупроводниковой отрасли во втором полугодии в целом улучшится, как ожидает Samsung, хотя бы в силу достижения властями США и Южной Кореи о сохранении таможенных пошлин на уровне 15 % вместо обещанных ранее 25 %. При этом на рынке смартфонов будет наблюдаться некоторое охлаждение, поскольку многие покупатели просто спешили закупиться в первом полугодии до вступления в силу повышенных тарифов в США. На рынке телевизионной техники геополитические факторы также сулят снижение спроса во втором полугодии. HBM скоро утратит статус «золотой жилы»: передовой памяти спрогнозировали падение цен

18.07.2025 [11:21],

Алексей Разин

Первые попытки найти применение памяти HBM в сегменте игровых видеокарт быстро уступили активному её использованию в ускорителях вычислений, и на фоне бума искусственного интеллекта цены на эту память только росли. Теперь же аналитики Goldman Sachs высказывают опасение, что в следующем году цены на HBM снизятся более чем на 10 процентов.

Источник изображения: SK hynix Именно в следующем году, по мнению аналитиков, предложение на рынке HBM в мировых масштабах наконец-то начнёт превышать спрос. Это будет способствовать тому, что средние цены реализации памяти данного семейства начнут снижаться. В ближайшее время рынок HBM снизит темпы роста с прежних 45 % в год до 25 %. В частности, по итогам текущего года его ёмкость ограничится $36 млрд, а в следующем вырастет только до $45 млрд вместо заложенных в прежний прогноз $51 млрд. По мнению аналитиков TrendForce, в следующем году средние цены реализации HBM всё же вырастут, поскольку на рынок выйдет более современная и дорогая HBM4. Снижение цен если и будет наблюдаться, то только в сегменте более дешёвых типов памяти. Специалисты Goldman Sachs добавляют, что два последовательных поколения ускорителей вычислений Nvidia будут использовать идентичный объём памяти, по 288 Гбайт HBM3E в случае с B300 и HBM4 в случае с Rubin соответственно. По этой причине общая потребность в микросхемах памяти подобного типа не будет заметно увеличиваться. Не исключено, что доля SK hynix на рынке HBM в следующем году начнёт сокращаться, поскольку по мере насыщения сегмента на него выйдут и конкурирующие компании, включая китайские. Последние уже к концу следующего года начнут выпускать HBM3. По крайней мере, позиции SK hynix на внутреннем рынке КНР из-за этого пошатнутся. Samsung со следующего года также сможет ежегодно увеличивать поставки HBM на 20 %. Прибыль Samsung должна упасть впервые с 2023 года, причём сразу на 56 %

08.07.2025 [08:49],

Алексей Разин

Аналитики традиционно предвосхищают официальные заявления Samsung Electronics по поводу предварительных итогов минувшего фискального квартала, сама компания накануне призналась, что её операционная прибыль по итогам прошлого периода не превысит $3,3 млрд. Это соответствует снижению на 56 % в годовом сравнении, отрицательная динамика показателя будет в целом наблюдаться впервые с 2023 года.

Источник изображения: Samsung Electronics Эксперты в среднем рассчитывали на снижение операционной прибыли на 39–41 % до $4,57 млрд, поэтому собственные ожидания Samsung оказались даже более пессимистичными. Выручка компании, как она ожидает, по итогам прошлого квартала не превысила $54,1 млрд, тогда как аналитики рассчитывали на сумму в районе $55,2 млрд. Подробную отчётность за минувший квартал компания должна опубликовать ближе к концу текущего месяца. Принято считать, что неспособность Samsung сертифицировать свою память типа HBM3E для использования в составе ускорителей вычислений Nvidia серьёзным образом подрывает её финансовые показатели. Опрошенные Bloomberg аналитики считают, что полупроводниковый бизнес Samsung по итогам прошлого квартала получил операционную прибыль в размере $1,98 млрд. Это более чем в два раза превышает операционную прибыль подразделения в первом квартале, но в те же два с лишним раза меньше показателя годичной давности. Что характерно, представители Samsung такую динамику объяснили влиянием американских санкций, которые мешают ей поставлять передовые чипы памяти в Китай. В апреле руководство Samsung выражало надежду, что «ключевые клиенты» смогут приступить к массовым закупкам обновлённых чипов HBM3E со второго квартала, а к серийному производству HBM4 компания рассчитывала приступить в текущем полугодии. Даже в этой сфере Samsung приходится выступать в роли догоняющего, поскольку SK hynix уже начала отгружать клиентам образцы 12-ярусных стеков HBM4 ещё в прошлом полугодии, и к июню к ней присоединилась американская Micron Technology. Формально, Samsung снабжает своими чипами типа HBM3E компанию AMD, но доля последней на рынке ускорителей вычислений несопоставима с Nvidia, поэтому рассчитывать на серьёзный объём выручки в данной сфере деятельности корейский производитель памяти пока не может. Эксперты Bernstein ухудшили прогноз по занимаемой Samsung доле рынка памяти типа HBM, поскольку теперь ожидают, что сертификация HBM3E этой марки для нужд Nvidia состоится в текущем квартале, а не предыдущем. Как минимум до 2027 года включительно лидером будет оставаться SK hynix, но Samsung будет пытаться укреплять свои позиции. Текущий год SK hynix завершит с долей в 57 %, на втором месте уже окажется Samsung с 27 %, а Micron будет довольствоваться 16 % рынка HBM в целом. Во вторник утром акции Samsung упали в цене на 1,13 % после публикации неутешительного прогноза по операционной прибыли за прошлый квартал. SK hynix поможет Intel интегрировать передовую память HBM4 в ускорители Jaguar Shores

02.07.2025 [12:43],

Алексей Разин

Компании SK hynix и Nvidia могут похвастать впечатляющими итогами сотрудничества при разработке ускорителей второй из них, оснащаемых памятью класса HBM первой. Благодаря такому сотрудничеству SK hynix сейчас занимает половину мирового рынка HBM и стремительно наращивает выручку. Intel решила заручиться поддержкой SK hynix на этапе внедрения HBM4 в свои ускорители вычислений.

Источник изображения: SK hynix Как отмечает TrendForce со ссылкой на корейское издание Newsis, на мероприятии Intel AI Summit вице-президент SK hynix Чжон У Сок (Jung Woo-seok) заявил, что эта южнокорейская компания будет сотрудничать с Intel в сфере интеграции некоей памяти типа HBM в ускорители Gaudi. Представленные в 2024 году ускорители Gaudi 3 используют память типа HBM2E, поэтому в случае с их преемниками с условным обозначением Jaguar Shores речь может идти уже о микросхемах памяти типа HBM4. При этом представители SK hynix отказались напрямую комментировать, будет ли компания сотрудничать с Intel именно в сфере интеграции HBM4, поскольку детали взаимодействия ещё не определены окончательно. Кроме того, у SK hynix может иметься встречный интерес, поскольку Intel могла бы выпускать для неё базовые кристаллы для стеков памяти HBM4 на своих контрактных мощностях. Ранее корейские СМИ сообщали, что для производства базовых кристаллов для HBM4 компания SK hynix может обратиться к услугам TSMC, которая будет использовать для этого 3-нм технологию. В 2026 году у конкурентов Intel в сфере ускорителей вычислений, компаний AMD и Nvidia, также появятся ускорители (Instinct MI400 и Rubin соответственно), оснащённые памятью типа HBM4. Если Intel к тому времени интегрирует такую память в свои ускорители Gaudi, это позволит ей хотя бы в чём-то поравняться с конкурентами. SK Hynix первой предложит память HBM4E и уже заключила контракт с Nvidia и Microsoft

21.06.2025 [05:52],

Анжелла Марина

SK Hynix закрепила за собой лидерство на рынке памяти для искусственного интеллекта (ИИ) и первой начнёт выпуск седьмого поколения высокопроизводительной памяти HBM. Контракты на поставку специализированной, адаптированной под индивидуальные запросы HBM4E уже заключены с крупнейшими технологическими компаниями — Nvidia, Microsoft и Broadcom.

Источник изображения: SK Hynix Однако в первую очередь SK Hynix будет ориентироваться на сроки поставок для своего самого крупного партнёра — Nvidia. Как пишет южнокорейское издание KED Global, ссылаясь на слова представителя полупроводниковой отрасли, учитывая текущие мощности SK Hynix и графики запуска новых ИИ-сервисов крупных компаний, невозможно удовлетворить все запросы американских IT-гигантов, таких как Apple, Microsoft, Google, Amazon, Nvidia, Meta✴ и Tesla. Однако, по мере изменения ситуации на рынке, список клиентов может расшириться. Ранее, около 10 месяцев назад, SK Hynix сообщала об интересе к своей специализированной памяти HBM со стороны этих компаний. Седьмое поколение (HBM4E) ожидается во второй половине следующего года. Сейчас же самой передовой массово выпускаемой моделью остаётся HBM3E, а переход на шестое поколение (HBM4) намечен в ближайшее время. Тем временем Samsung, основной конкурент SK Hynix, пока отстаёт в этой гонке. По данным инсайдеров, компания ведёт переговоры с Broadcom и AMD о поставках HBM4, но это решение на поколение отстаёт от HBM4E. В апреле Samsung заявила, что начнёт поставки HBM4 не раньше первой половины 2026 года. При этом ей до сих пор не удалось заключить контракт с Nvidia на поставку передовых чипов памяти. Согласно прогнозам TrendForce и Bloomberg Intelligence, рынок кастомизированной HBM-памяти будет расти стремительными темпами, и к 2033 году достигнет $130 млрд против $18,2 млрд в 2024-м. Такая память позволит крупным технологическим компаниям отказаться от универсальных решений и за счёт кастомизации оптимизировать производительность своих ИИ-кластеров, поэтому интерес к этому растёт. При этом SK Hynix, благодаря заказам от Nvidia, Microsoft и Broadcom, имеет все шансы сохранить доминирующие позиции. Отмечается, что производство логических кристаллов (logic dies), которые выполняют роль «мозга» в HBM, для SK Hynix теперь будет осуществлять тайваньская компания TSMC. Ранее SK Hynix делала их сама, но начиная с HBM4 перешла на аутсорсинг из-за необходимости применения сверхточных технологий. Память HBM будущего потребует сквозного охлаждения и других прорывных технологий

12.06.2025 [13:13],

Алексей Разин

Производство многоярусной памяти HBM3E уже требует использование передовых технологий, оборудования и материалов, что подтверждается неспособностью Samsung наладить выпуск подобных чипов, удовлетворяющих высоким требованиям Nvidia. В дальнейшем HBM примерит не только погружное и сквозное охлаждение, но и перейдёт на более сложные методы упаковки, включая интеграцию на GPU.

Источник изображения: SK hynix Профессор Корейского института науки и передовых технологий (KAIST) Ким Чжон Хо (Kim Joungho), как отмечает The Elec, во время своего недавнего доклада описал возможные пути развития технологий производства памяти класса HBM. Уже в рамках HBM5 может быть предложен вариант охлаждения стека памяти методом погружения в диэлектрическую жидкость, поскольку сейчас «посредник» в виде металлического теплораспределителя не демонстрирует хорошего запаса по эффективности на будущее. Производители серверных систем погружное охлаждение невольно начали практиковать после того, как плотность теплового потока современных ускорителей вычислений заметно выросла. В целом, профессором Кимом предварительно разработана дорожная карта развития HBM на срок до 2040 года, когда на рынке уже будет предлагаться HBM8, хотя эти этапы всё равно являются приблизительными. Например, память поколения HBM7 уже будет предусматривать сквозное охлаждения стека памяти, когда охлаждающая жидкость будет циркулировать по микроканалам внутри самих микросхем и базового кристалла. Твердотельная память NAND со временем тоже станет многоярусной, как HBM. На определённом этапе базовый кристалл переедет из основания стека на его верхушку, а HBM8 наверняка позволит интегрировать стек памяти прямо на кристалл графического процессора. Технологии и материалы для производства стеков HBM также будут совершенствоваться. Например, HBM6 предложит использование стекла и кремния одновременно для создания подложки. Гибридные методы межслойного соединения будут внедрены уже в ближайшее время, а HBM5 предложит до 20 слоёв памяти в одном стеке. На рынок память типа HBM5 выйдет примерно к 2029 году. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |