|

Опрос

|

реклама

Быстрый переход

«Больше, чем у кого-либо»: Цукерберг похвастался системой с более чем 100 тыс. Nvidia H100 — на ней обучается Llama 4

31.10.2024 [22:31],

Николай Хижняк

Среди американских IT-гигантов зародилась новая забава — соревнование, у кого больше кластеры и твёрже уверенность в превосходстве своих мощностей для обучения больших языковых моделей ИИ. Лишь недавно глава компании Tesla Илон Маск (Elon Musk) хвастался завершением сборки суперкомпьютера xAI Colossus со 100 тыс. ускорителей Nvidia H100 для обучения ИИ, как об использовании более 100 тыс. таких же ИИ-ускорителей сообщил глава Meta✴ Марк Цукерберг (Mark Zuckerberg).

Источник изображения: CNET/YouTube Глава Meta✴ отметил, что упомянутая система используется для обучения большой языковой модели нового поколения Llama 4. Эта LLM обучается «на кластере, в котором используется больше 100 000 графических ИИ-процессоров H100, и это больше, чем что-либо, что я видел в отчётах о том, что делают другие», — заявил Цукерберг. Он не поделился деталями о том, что именно уже умеет делать Llama 4. Однако, как пишет издание Wired со ссылкой на заявление главы Meta✴, их ИИ-модель обрела «новые модальности», «стала сильнее в рассуждениях» и «значительно быстрее». Этим комментарием Цукерберг явно хотел уколоть Маска, который ранее заявлял, что в составе его суперкластера xAI Colossus для обучения ИИ-модели Grok используются 100 тыс. ускорителей Nvidia H100. Позже Маск заявил, что количество ускорителей в xAI Colossus в перспективе будет увеличено втрое. Meta✴ также ранее заявила, что планирует получить до конца текущего года ИИ-ускорители, эквивалентные более чем полумиллиону H100. Таким образом, у компании Цукерберга уже имеется значительное количество оборудования для обучения своих ИИ-моделей, и будет ещё больше. Meta✴ использует уникальный подход к распространению своих моделей Llama — она предоставляет их полностью бесплатно, позволяя другим исследователям, компаниям и организациям создавать на их базе новые продукты. Это отличает её от тех же GPT-4o от OpenAI и Gemini от Google, доступных только через API. Однако Meta✴ всё же накладывает некоторые ограничения на лицензию Llama, например, на коммерческое использование. Кроме того, компания не сообщает, как именно обучаются её модели. В остальном модели Llama имеют природу «открытого исходного кода». С учётом заявленного количества используемых ускорителей для обучения ИИ-моделей возникает вопрос — сколько электричества всё это требует? Один специализированный ускоритель может съедать до 3,7 МВт·ч энергии в год. Это означает, что 100 тыс. таких ускорителей будут потреблять как минимум 370 ГВт·ч электроэнергии — как отмечается, достаточно для того, чтобы обеспечить энергией свыше 34 млн среднестатистических американских домохозяйств. Каким образом компании добывают всю эту энергию? По признанию самого Цукерберга, со временем сфера ИИ столкнётся с ограничением доступных энергетических мощностей. Компания Илона Маска, например, использует несколько огромных мобильных генераторов для питания суперкластера из 100 тыс. ускорителей, расположенных в здании площадью более 7000 м2 в Мемфисе, штат Теннесси. Та же Google может не достичь своих целевых показателей по выбросам углерода, поскольку с 2019 года увеличила выбросы парниковых газов своими дата-центрами на 48 %. На этом фоне бывший генеральный директор Google даже предложил США отказаться от поставленных климатических целей, позволив компаниям, занимающимся ИИ, работать на полную мощность, а затем использовать разработанные технологии ИИ для решения климатического кризиса. Meta✴ увильнула от ответа на вопрос о том, как компании удалось запитать такой гигантский вычислительный кластер. Необходимость в обеспечении растущего объёма используемой энергии для ИИ вынудила те же технологические гиганты Amazon, Oracle, Microsoft и Google обратиться к атомной энергетике. Одни инвестируют в разработку малых ядерных реакторов, другие подписали контракты на перезапуск старых атомных электростанций для обеспечения растущих энергетических потребностей. OSI ввела строгие стандарты открытости для Meta✴ Llama и других ИИ-моделей

29.10.2024 [07:19],

Дмитрий Федоров

Open Source Initiative (OSI), десятилетиями определяющая стандарты открытого программного обеспечения (ПО), ввела определение для понятия «открытый ИИ». Теперь, чтобы модель ИИ считалась действительно открытой, OSI требует предоставления доступа к данным, использованным для её обучения, полному исходному коду, а также ко всем параметрам и весам, определяющим её поведение. Эти новые условия могут существенно повлиять на технологическую индустрию, поскольку такие ИИ-модели, как Llama компании Meta✴ не соответствуют этим стандартам.

Источник изображения: BrianPenny / Pixabay Неудивительно, что Meta✴ придерживается иной точки зрения, считая, что подход OSI не учитывает особенностей современных ИИ-систем. Представитель компании Фейт Айшен (Faith Eischen) подчеркнула, что Meta✴, хотя и поддерживает многие инициативы OSI, не согласна с предложенным определением, поскольку, по её словам, «единого стандарта для открытого ИИ не существует». Она также добавила, что Meta✴ продолжит работать с OSI и другими организациями, чтобы обеспечить «ответственное расширение доступа к ИИ» вне зависимости от формальных критериев. При этом Meta✴ подчёркивает, что её модель Llama ограничена в коммерческом применении в приложениях с аудиторией более 700 млн пользователей, что противоречит стандартам OSI, подразумевающим полную свободу её использования и модификации. Принципы OSI, определяющие стандарты открытого ПО, на протяжении 25 лет признаются сообществом разработчиков и активно им используются. Благодаря этим принципам разработчики могут свободно использовать чужие наработки, не опасаясь юридических претензий. Новое определение OSI для ИИ-моделей предполагает аналогичное применение принципов открытости, однако для техногигантов, таких как Meta✴, это может стать серьёзным вызовом. Недавно некоммерческая организация Linux Foundation также вступила в обсуждение, предложив свою трактовку «открытого ИИ», что подчёркивает возрастающую значимость данной темы для всей ИТ-индустрии. Исполнительный директор OSI Стефано Маффулли (Stefano Maffulli) отметил, что разработка нового определения «открытого ИИ» заняла два года и включала консультации с экспертами в области машинного обучения (ML) и обработки естественного языка (NLP), философами, представителями Creative Commons и другими специалистами. Этот процесс позволил OSI создать определение, которое может стать основой для борьбы с так называемым «open washing», когда компании заявляют о своей открытости, но фактически ограничивают возможности использования и модификации своих продуктов. Meta✴ объясняет своё нежелание раскрывать данные обучения ИИ вопросами безопасности, однако критики указывают на иные мотивы, среди которых минимизация юридических рисков и сохранение конкурентного преимущества. Многие ИИ-модели, вероятно, обучены на материалах, защищённых авторским правом. Так, весной The New York Times сообщила, что Meta✴ признала наличие такого контента в своих данных для обучения, поскольку его фильтрация практически невозможна. В то время как Meta✴ и другие компании, включая OpenAI и Perplexity, сталкиваются с судебными исками за возможное нарушение авторских прав, ИИ-модель Stable Diffusion остаётся одним из немногих примеров открытого доступа к данным обучения ИИ. Маффулли видит в действиях Meta✴ параллели с позицией Microsoft 1990-х годов, когда та рассматривала открытое ПО как угрозу своему бизнесу. Meta✴, по словам Маффулли, подчёркивает объём своих инвестиций в модель Llama, предполагая, что такие ресурсоёмкие разработки по силам немногим. Использование Meta✴ данных обучения в закрытом формате, по мнению Маффулли, стало своего рода «секретным ингредиентом», который позволяет корпорации удерживать конкурентное преимущество и защищать свою интеллектуальную собственность. Meta✴ выпустила открытую ИИ-модель Llama 3.2 — она работает с текстом и изображениями

26.09.2024 [10:09],

Павел Котов

Всего через два месяца после выпуска большой языковой модели Llama 3.1 компания Meta✴ представила её обновлённую версию Llama 3.2 — первую открытую систему искусственного интеллекта, которая может обрабатывать как изображения, так и текст.

Источник изображения: Gerd Altmann / pixabay.com Meta✴ Llama 3.2 позволяет разработчикам создавать передовые приложения с ИИ: платформы дополненной реальности с распознаванием видео в реальном времени; визуальные поисковые системы с сортировкой изображений на основе содержимого; а также системы анализа документов с подготовкой сводок по длинным фрагментам текста. Запустить новую модель разработчикам будет довольно просто, говорят в Meta✴ — потребуется добавить поддержку мультимодальности, «иметь возможность показывать Llama изображения и заставить её общаться». OpenAI и Google запустили собственные мультимодальные модели ИИ ещё в прошлом году, поэтому Meta✴ сейчас оказалась в положении догоняющей. Поддержка работы с изображениями играет важную роль — Meta✴ продолжает наращивать возможности ИИ на устройствах, включая очки Ray-Ban Meta✴. Пакет Llama 3.2 включает две модели, поддерживающие работу с изображением (с 11 и 90 млрд параметров) и две облегчённые текстовые модели (с 1 и 3 млрд параметров). Меньшие предназначены для работы на чипах Qualcomm, MediaTek и других Arm-процессорах — Meta✴ явно рассчитывает, что они будут применяться на мобильных устройствах. При этом выпущенная в июле Llama 3.1 по-прежнему является сильным предложением — одна из версий имеет 405 млрд параметров, и в генерации текста она должна превосходить более новые. Легендарный Winamp сегодня стал медиаплеером с открытым исходным кодом

24.09.2024 [21:13],

Владимир Фетисов

На этой неделе компания Llama Group открыла код плеера Winamp и перевела проект на модель совместного развития. Написанный на C++ и C исходный код приложения опубликован на GitHub под лицензией Winamp Collaborative License Version 1.0. В настоящее время сборка десктопной версии проигрывателя основана на Visual Studio 2019 и библиотеках Intel IPP v6.1.1.035.

Источник изображения: forums.winamp.com Согласно имеющимся данным, переход на открытую модель разработки обусловлен реорганизацией в Llama Group, которая была проведена из-за финансовых проблем. По этой же причине в прошлом году компании пришлось продать проект Shoutcast, а также уволить команду разработчиков, которая занималась сопровождением классического приложения Winamp для Windows. При этом разработчики продолжили развитие одноимённого стримингового сервиса с подписками на музыкантов, а также мобильных версий Winamp для устройств на базе Android и iOS. Проект Winamp существует с 1997 года и является одним из самых долгоживущих мультимедийных проигрывателей, который всё ещё развивается. На фоне высокой популярности плеера для Windows появилось несколько клонов для Linux, таких как XMMS, XMMS2 и Beep Media Player. В 2022 году компания Radionomy Group, которая на тот момент владела разработчиком Winamp в лице Nullsoft, продала аудиобизнес компании Azerion и переименовалась в Llama Group. Позднее Llama Group объявила о перезапуске проекта Winamp в качестве музыкального стримингового сервиса. Текущая доступная версия Winamp Full имеет номер 5.9.2.10042. Meta✴ похвасталась ростом спроса на языковые модели Llama в 10 раз — всё благодаря их открытости

29.08.2024 [22:42],

Николай Хижняк

Компания Meta✴ сообщила, что количество загрузок её больших языковых моделей ИИ (LLM) Llama приближается к 350 млн. Это в 10 раз больше показателя загрузок за аналогичный период прошлого года. Примерно 20 млн из этих загрузок были сделаны только за последний месяц, после того как компания выпустила языковую модель Llama 3.1, которая, по заявлению Meta✴, позволит ей напрямую конкурировать с решениями компаний OpenAI и Anthropic.

Источник изображения: Gerd Altmann / pixabay.com У некоторых крупнейших поставщиков облачных услуг, сотрудничающих с Meta✴, ежемесячное использование языковых моделей Llama выросло в десять раз с января по июль этого года. Также отмечается, что с мая по июль использование Llama на серверах её партнёров среди провайдеров облачных услуг выросло более чем вдвое по количеству токенов. Помимо Amazon Web Services (AWS) и Microsoft Azure, компания сотрудничает с Databricks, Dell, Google Cloud, Groq, Nvidia, IBM watsonx, Scale AI и Snowflake и другими, чтобы сделать свои LLM более доступными для разработчиков. Meta✴ считает, что успех её языковых моделей связан с тем, что они распространяются по открытой лицензии. По словам компании, открытое распространение её LLM позволило «расширить и разнообразить экосистему ИИ и предоставить разработчикам больше выбора». Когда Meta✴ выпустила Llama 3.1, глава компании Марк Цукерберг (Mark Zuckerberg) превозносил достоинства ИИ с открытым исходным кодом, назвав его «движением вперёд». Он также рассказал, что компания предпринимает шаги, чтобы сделать ИИ с открытым исходным кодом отраслевым стандартом. В своём последнем отчёте Meta✴ также рассказала, как её партнёры используют большие языковые модели. Например, оператор связи AT&T использует Llama для более точного пользовательского поиска. Один из крупнейших американских доставщиков еды DoorDash использует LLM, чтобы упростить работу своих инженеров по программному обеспечению. Языковая модель также используется для генерации живых реакций и цифровых существ в игре Peridot от компании Niantic. В свою очередь Zoom использует Llama, а также другие языковые модели, для работы ИИ-ассистента, который может подводить итоги встреч и делать умные заметки. Вышла крупнейшая ИИ-модель Llama 3.1 от Meta✴ — её самая большая версия имеет 405 млрд параметров

24.07.2024 [00:56],

Анжелла Марина

Компания Meta✴ объявила о выпуске крупнейшей на сегодня открытой языковой модели искусственного интеллекта Llama 3.1, насчитывающей более 400 миллиардов различных параметров. По заявлению генерального директора Meta✴ Марка Цукерберга (Mark Zuckerberg) модель может превзойти GPT-4 по производительности уже в ближайшее время, а к концу года станет самым популярным ИИ-помощником в мире.

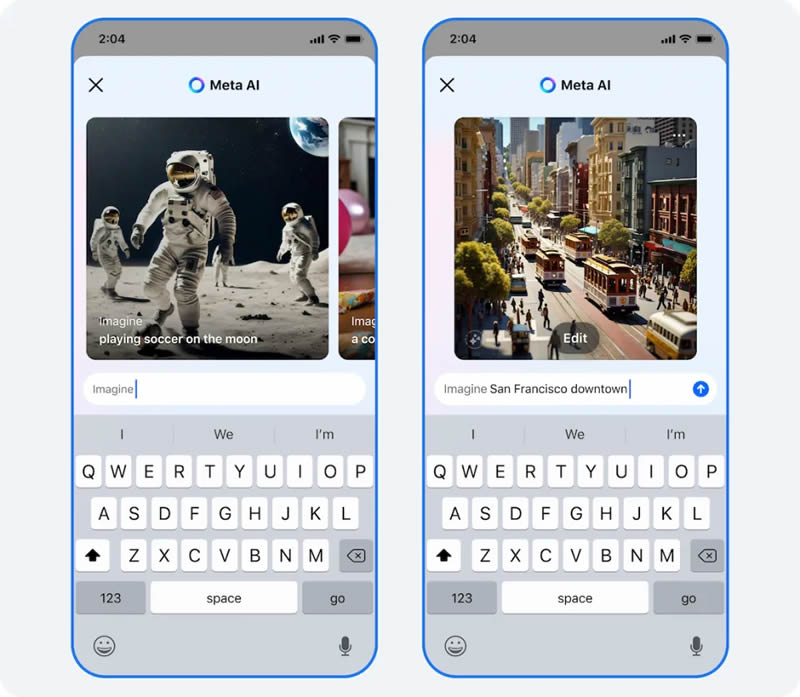

Источник изображения: Reuters Как сообщает издание The Verge, разработка новой модели потребовала больших инвестиций. Llama 3.1 значительно сложнее, чем более ранние версии, выпущенные всего несколько месяцев назад. Старшая версия ИИ-модели имеет 405 миллиардов параметров и была обучена с использованием более 16 000 ускорителей H100 от Nvidia. Meta✴ не раскрывает вложенных средств в её разработку, но, исходя из стоимости одних только чипов Nvidia, можно с уверенностью предположить, что речь идёт о сотнях миллионов долларов. Несмотря на высокую стоимость разработки, Meta✴ решила сделать код модели открытым (Open Source). В письме, опубликованном в официальном блоге компании, Цукерберг утверждает, что ИИ-модели с открытым исходным кодом обгонят проприетарные модели, подобно тому, как Linux стал операционной системой с открытым исходным кодом, которая сегодня управляет большинством телефонов, серверов и гаджетов. Одним из ключевых обновлений стало расширение географии доступности сервиса Meta✴ AI, который построен на Llama. Теперь ассистент доступен в 22 странах, включая Аргентину, Чили, Колумбию, Эквадор, Мексику, Перу и Камерун. Кроме того, если раньше Meta✴ AI поддерживала только английский язык, то сейчас добавлены французский, немецкий, хинди, итальянский, португальский и испанский. Однако стоит отметить, что некоторые из новых функций пока доступны только в определённых регионах или для конкретных языков.

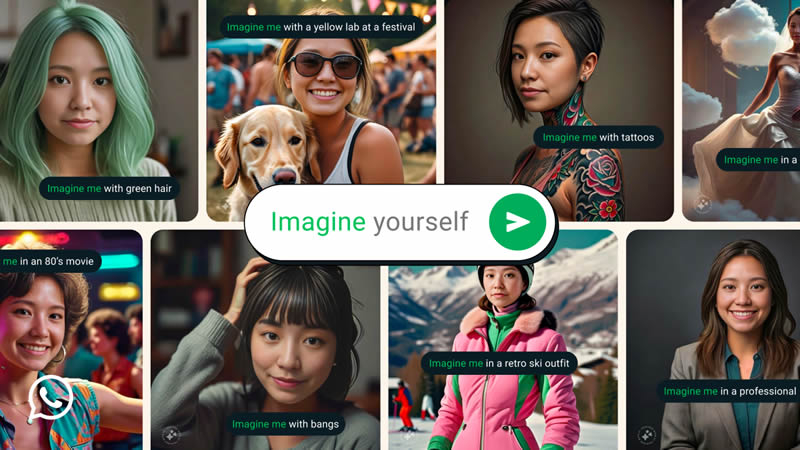

Источник изображения: Meta✴ Также появилась интересная функция Imagine me (представь меня), которая использует генеративную ИИ-модель Imagine Yourself, сообщает TechCrunch. Эта модель способна создавать изображения на основе фотографии пользователя и текстового запроса в требуемом контексте. Например, «Представь меня сёрфингистом» или «Представь меня на пляже». После чего искусственный интеллект сгенерирует соответствующее изображение. Функция доступна в бета-версии и активируется вводом фразы «Imagine me».

Источник изображения: Meta✴ В ближайшее время Meta✴ AI также получит новые инструменты редактирования изображений. Пользователи смогут добавлять, удалять и изменять объекты на изображениях с помощью текстовых запросов. А со следующего месяца разработчики обещают внедрить кнопку «Edit with AI» (редактирование с помощью ИИ) для доступа к дополнительным опциям тонкой настройки. Позднее появятся новые ярлыки для быстрой публикации изображений, созданных ИИ, в лентах, историях и комментариях в приложениях Meta✴. Напомним, запуск Meta✴ AI состоялся в сентябре 2023 года. Сервис основан на большой языковой модели Llama 2 и предоставляет пользователям возможность получать информацию, генерировать текст, делать переводы на различные языки и выполнять другие задачи с помощью искусственного интеллекта. Meta✴ бросила вызов ChatGPT — все сервисы компании получили «самого умного» ИИ-помощника

18.04.2024 [23:30],

Владимир Чижевский

Сегодня Meta✴ представила не только новое поколение собственных языковых моделей Llama 3, но и подключила их к поисковым строкам своих основных приложений — Facebook✴, Messenger, Instagram✴ и WhatsApp, пусть и не во всех странах. Кроме того, компания запустила отдельный сайт для своего чат-бота, meta✴.ai.

Источник изображения: Meta✴ Meta✴ стремится не отставать, а то и превзойти конкурирующие продукты вроде ChatGPT от OpenAI, Gemini от Google и Claude от Anthropic, с которыми сегодня и сравнивала новое семейство больших языковых моделей Llama 3. Более того, Марк Цукерберг (Mark Zuckerberg) заявил, что Meta✴ AI «самый интеллектуальный ИИ-помощник из доступных для свободного пользователя». Meta✴ AI запустили ещё в прошлом году, и он по-прежнему поддерживает лишь английский язык, однако работает во многих странах, включая Австралию, Канаду, Гану, Ямайку, Малави, Новую Зеландию, Нигерию, Пакистан, Сингапур, Южную Африку, Уганду, Замбию и Зимбабве. Среди новых функций Meta✴ AI — возможность попросить ИИ найти определённую информацию в Google и Bing. Разработчики не просто ускорили генерацию изображений с помощью Meta✴ AI, но и наделили ИИ возможностью анимировать картинки, а также улучшили функцию размещения текста на генерируемых изображениях. Стремясь как можно сильнее расширить присутствие ИИ в своих продуктах, Meta✴ добавила его не только в поисковые строки, но и в индивидуальные и групповые чаты, и даже в ленты приложений. Например, увидев в ленте Facebook✴ фотографию северного сияния можно спросить ИИ, когда лучше отправиться в Исландию, чтобы наблюдать его своими глазами. Помимо этого, Meta✴ AI добавили в умные очки Ray-Ban, вскоре он появится и в VR-гарнитуре Meta✴ Quest. Meta✴ представила нейросеть Llama 3 — «самую способную открытую LLM на сегодняшний день»

18.04.2024 [21:27],

Владимир Чижевский

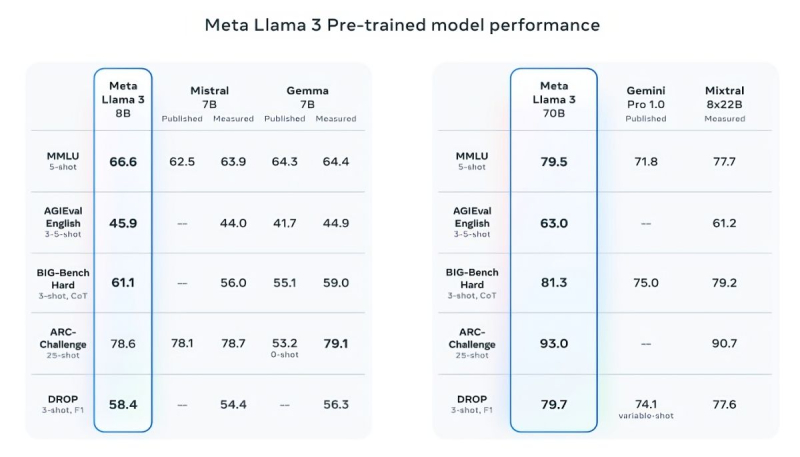

Meta✴ представила Llama 3 — большую языковую модель нового поколения, которую без лишней скромности называет «самой способной LLM с открытым исходным кодом». Компания выпустила две версии: Llama 3 8B и Llama 3 70B соответственно с 8 и 70 миллиардами параметров. По словам компании, новые ИИ-модели значительно превосходят соответствующие модели прошлого поколения и являются одними из лучших моделей для генеративного ИИ из ныне существующих.

Источник изображения: vecstock / freepik.com В подтверждение своих слов Meta✴ приводит результаты популярных тестов MMLU (знания), ARC (способность к обучению) и DROP (анализ фрагментов текста). Llama 3 8B превосходит другие модели своего класса с открытым исходным кодом, такие как Mistral 7B от Mistral и Gemma 7B от Google с 7 миллиардами параметров, по крайней мере в девяти тестах: MMLU, ARC, DROP, GPQA (вопросы по биологии, физике и химии), HumanEval (тест на генерацию кода), GSM-8K (математические задачи), MATH (ещё один математический тест), AGIEval (набор тестов на решение задач) и BIG-Bench Hard (оценка рассуждений на основе здравого смысла).

Источник изображений: Meta✴ Mistral 7B и Gemma 7B уже не назвать современными, при этом в некоторых тестах Llama 3 8B не показывает значимого превосходства над ними. Однако куда сильнее Meta✴ гордится более продвинутой моделью, Llama 3 70B, которую ставит в один ряд с другими флагманскими моделями для генеративных ИИ, включая Gemini 1.5 Pro — самую продвинутую в линейке Gemini от Google. Llama 3 70B опережает Gemini 1.5 Pro в тестах MMLU, HumanEval и GSM-8K, но уступает передовой модели Claude 3 Opus от Anthropic, превосходя лишь слабейшую модель серии, Sonnet, в пяти тестах: MMLU, GPQA, HumanEval, GSM-8K и MATH. Meta✴ также разработала собственный набор тестов, от написания текстов и кода до обобщений и выводов, в котором Llama 3 70B обошла Mistral Medium, GPT-3.5 от OpenAI и Claude Sonnet от Anthropic. По словам Meta✴, новые модели более «управляемы», реже отказываются отвечать на вопросы и в целом выдают более точную информацию, в том числе в некоторых научных областях, что, вероятно, обосновано огромным количеством данных, использованных для их обучения: 15 триллионов токенов и 750 миллиардов слов, что в семь раз больше, чем в случае с Llama 2. Откуда столько данных? Meta✴ ограничилась заверением, что все они взяты из «общедоступных источников». При этом в наборе данных для обучения Llama 3 содержалось в четыре раза больше кода в сравнении с использованным для Llama 2, а 5 % набора составляли данные на 30 отличных от английского языках, чтобы улучшить работу с ними. Кроме того, использовались синтетические данные, то есть полученные от других ИИ-моделей. «Наши текущие ИИ-модели настроены отвечать лишь на английском, но мы обучаем их с использованием данных на других языках, чтобы ИИ лучше распознавал нюансы и закономерности», — прокомментировала Meta✴. Вопрос необходимого количества данных для дальнейшего обучения ИИ в последнее время поднимается особенно часто, и Meta✴ уже успела подпортить репутацию на этом поприще. Не так давно сообщалось, что Meta✴ в погоне за конкурентами «скармливала» ИИ защищённые авторским правом электронные книги, хотя юристы компании предупреждали о возможных последствиях. Что касается безопасности, Meta✴ встроила в новое поколение собственных ИИ-моделей несколько протоколов безопасности, таких как Llama Guard и CybersecEval, чтобы бороться с неправомерным использованием ИИ. Компания также выпустила специальный инструмент Code Shield для анализа безопасности кода открытых моделей генеративных ИИ, позволяющий обнаружить потенциальные уязвимости. Известно, что ранее эти же протоколы не уберегли Llama 2 от недостоверных ответов и выдачи персональной медицинской и финансовой информации. Но и это ещё не всё. Meta✴ обучает модель Llama 3 с 400 миллиардами параметров — она сможет разговаривать на разных языках и принимать больше входящих данных, в том числе работать с изображениями. «Мы стремимся сделать Llama 3 многоязычной и мультимодальной моделью, умеющей учитывать больше контекста. Мы также стараемся улучшить производительность и расширить возможности языковой модели в рассуждениях и написании кода», — сказали в Meta✴. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |