|

Опрос

|

реклама

Быстрый переход

Microsoft зарабатывает деньги каждый раз, когда кто-либо использует ChatGPT

06.06.2025 [17:49],

Владимир Фетисов

Похоже, что за последние месяцы многомиллиардное партнёрство Microsoft и OpenAI ослабело, поскольку обе компании стремятся снизить уровень зависимости друг от друга. Невозможно предсказать, как будут развиваться отношения компаний в будущем, но гендиректор Microsoft Сатья Наделла (Satya Nadella) недавно прояснил ситуацию, признав, что сотрудничество с OpenAI меняется, но всё ещё остаётся крепким.

Источник изображения: Valent Lau / Unsplash «Для любой компании, которая прошла путь от исследовательской лаборатории до одной из самых успешных продуктовых организаций нашего времени, очевидно, что в контексте партнёрства всё должно измениться и для них, и для нас», — считает Наделла. Ранее СМИ неоднократно писали о возникших между Microsoft и OpenAI трениях. Предполагалось даже, что компании могут прекратить сотрудничество, несмотря на вложенные Microsoft в OpenAI $13,5 млрд. В пользу этого говорит участие OpenAI в проекте Stargate, в рамках которого на территории США планируется построить ИИ-инфраструктуру стоимостью $500 млрд. В это же время Microsoft потеряла статус эксклюзивного поставщика облачных вычислений для OpenAI. Ранее OpenAI жаловалась, что вычислительные мощности софтверного гиганта не могут удовлетворить потребности компании, что затрудняет достижение цели по созданию сильного ИИ (Artificial General Intelligence). СМИ также писали, что Microsoft отказалась от сделок с двумя крупными ЦОД, потому что не хотела предоставлять дополнительную поддержку для обучения ChatGPT. Позднее глава OpenAI Сэм Альтман (Sam Altman) сообщил, что компания больше не испытывает недостатка в вычислительных мощностях. Несмотря на существующие разногласия, гендиректор Microsoft Сатья Наделла отметил, что софтверный гигант рад получить доступ к технологиям OpenAI. «Многогранное партнёрство — это то, на чём мы действительно сосредоточены. Зачем кому-то из нас расстраиваться», — сказал Наделла. По всей видимости, глава Microsoft рассчитывает на долгосрочное партнёрство с OpenAI, хотя и допускает, что сам процесс взаимодействия может меняться с течением времени. Наделла предполагает, что в будущем OpenAI будет работать с другими партнёрами. В настоящее время разработчик ChatGPT уже сотрудничает с SoftBank и Oracle, чтобы закрепить своё лидерство в сфере ИИ. Наделла также сказал, что его устраивает бизнес-модель OpenAI, поскольку компания получает большую часть вычислительных мощностей от софтверного гиганта. «Каждый день, когда ChatGPT добивается успеха, — это фантастический день для Microsoft», — заявил Наделла. Очевидно, что софтверный гигант продолжает зарабатывать деньги каждый раз, когда кто-то использует ChatGPT. ChatGPT научился копаться в корпоративных файлах в «Google Диске», Dropbox и других облаках

04.06.2025 [22:45],

Анжелла Марина

ChatGPT для бизнес-пользователей научился работать с облачными хранилищами. Теперь ИИ может подключаться к «Google Диску», Dropbox, Box, SharePoint и OneDrive для поиска информации и глубокого анализа данных (deep research) на основании внутренних документов компаний.

Источник изображения: Zac Wolff / Unsplash Чат-бот также может записывать и транслировать встречи, создавать заметки с таймкодами, выделять ключевые моменты и предлагать действия на основе обсуждений. Пользователи смогут осуществлять поиск по таким записям так же, как по документам. При этом задачи можно автоматически переносить в Canvas — инструмент OpenAI для проектов написания текстов и кода . Подчёркивается, что новая функция учитывает и права доступа пользователей. Если, к примеру, сотрудник не имеет разрешения на просмотр файла, ChatGPT не предоставит ему информацию из него. Клиенты OpenAI также могут взаимодействовать через протокол MCP (Model Context Protocol), который позволяет подключаться к другим инструментам для глубокого анализа. Поддержка MCP доступна подписчикам Pro, Team и Enterprise. Кроме того, компания запустила бета-версию «глубоких» связей (deep research connectors) для HubSpot, Linear и некоторых инструментов Microsoft и Google. С их помощью ChatGPT может готовить аналитические отчёты, используя как внутренние данные компаний, так и данные из интернета. Этот инструмент доступен всем пользователям на платных тарифах. Драма с увольнением Альтмана из OpenAI будет экранизирована: главного «злодея» сыграет Юра Борисов

04.06.2025 [08:12],

Алексей Разин

В ноябре 2023 года разыгрались по-своему драматические события вокруг внезапной отставки генерального директора OpenAI Сэма Альтмана (Sam Altman). Как известно, он вернулся на свой пост пять дней спустя, а тогдашний состав совета директоров был расформирован. По слухам, в Голливуде готовится экранизация тех событий с приглашением на роль одного из противников Альтмана российского актёра Юры Борисова.

Источник изображения: OpenAI Как отмечает The Hollywood Reporter, рабочее название готовящейся картины звучит как «Искусственный» (Artificial), над режиссурой должен поработать Лука Гуаданьино (Luca Guadagnino), а в роли сценариста выступит Саймон Рич (Simon Rich), в повседневной жизни трудящийся над популярным телевизионным шоу «Saturday Night Live». Его участие, как предполагают источники, добавит сюжету будущей картины комедийный уклон. Актёрский состав, как ожидается, предусматривает участие Эндрю Гарфилда (Andrew Garfield) в роли Сэма Альтмана, а воплотить образ бывшего технического директора OpenAI Миры Мурати (Mira Murati) будет поручено актрисе Монике Барбаро (Monica Barbaro). Наконец, условного «злодея» в экранизации сыграет российский актёр Юра Борисов, которому будет поручено изобразить Илью Суцкевера, ставшего одним из инициаторов отставки Альтмана в 2023 году, и позже основавшего собственный ИИ-стартап. Над созданием фильма по этим событиям работает Amazon MGM Studios, и подобный жанр не так уж чужд американскому кинематографу последних лет. OpenAI и Nvidia заработают миллиарды на Ближнем Востоке — но главный выигрыш достанется США

03.06.2025 [14:18],

Алексей Разин

Поездка Дональда Трампа (Donald Trump) по ряду стран Ближнего Востока принесла компаниям типа Nvidia и OpenAI потенциальную выгоду в десятки миллиардов долларов, поскольку они примут участие в развитии вычислительной инфраструктуры в ОАЭ и Саудовской Аравии. При этом эксперты убеждены, что власти США в политическом смысле от реализации этих проектов выиграют больше всего, поставив указанные страны в серьёзную зависимость от себя.

Источник изображения: Nvidia Как отмечается в публикации на страницах Financial Times, в 2018 году в США вступил в силу закон, известный под обозначением US Cloud Act. Он подразумевает, что власти США должны сохранять доступ к данным, обрабатываемым на объектах их облачной инфраструктуры, даже если они физически находятся за пределами страны. История со строительством крупных вычислительных центров в ОАЭ и Саудовской Аравии как раз создаёт условия для такого прецедента, ведь основными пользователями этой зарубежной инфраструктуры останется американская компания OpenAI. Последняя при этом всячески подчёркивает, что идёт в авангарде развития мировой «суверенной» инфраструктуры, связанной с системами искусственного интеллекта. По логике американского законодательства, она должна предусмотреть доступ к своей зарубежной инфраструктуре для государственных ведомств США, включая многочисленные силовые. Если получившие от OpenAI на своей территории центры обработки данных государства в итоге не смогут демонстрировать достаточно политической лояльности курсу США, то у властей последней из стран останется техническая возможность использовать своё влияние на внешнеполитических партнёров через данный рычаг. Тем более, что примеры злоупотребления контролем над зарубежной информационной инфраструктурой даже коммерческих компаний США со стороны властей в новейшей мировой истории уже имеются. Генератор видео Sora компании OpenAI стал бесплатным в приложении Bing

03.06.2025 [05:09],

Анжелла Марина

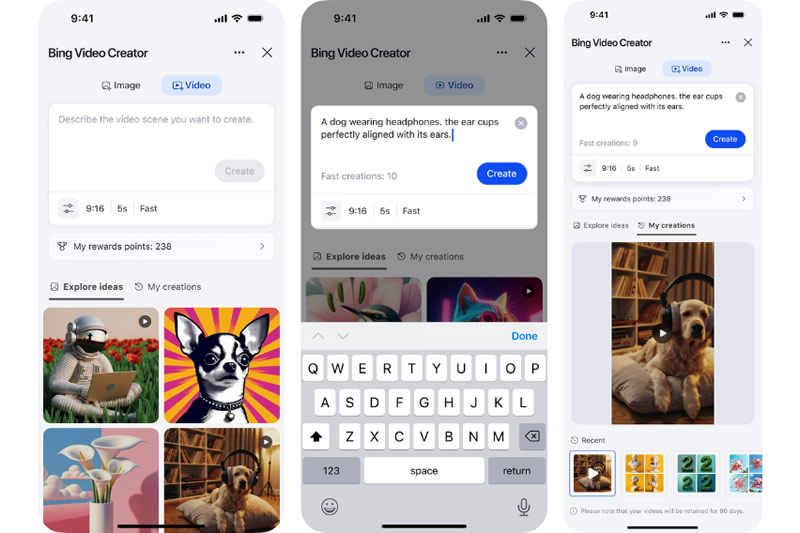

Microsoft объявила о запуске нового инструмента Bing Video Creator, который позволяет генерировать видео по текстовым запросам с помощью ИИ-модели Sora компании OpenAI. Ранее эта технология была доступна только платным пользователям OpenAI, но теперь в мобильном приложении Bing ролики можно генерировать бесплатно.

Источник изображения: Solen Feyissa / Unsplash Пока сервис работает только в вертикальном формате (9:16), что удобно для социальных сетей, например, TikTok и Instagram✴. Однако скоро появится поддержка горизонтальных видео. Продолжительность роликов фиксированная — 5 секунд, но за один раз можно отправить в обработку до трёх запросов. Как пишет TechCrunch, генерация может занять несколько часов, даже в «быстром» режиме, который предполагает обработку всего за несколько минут. Не уточняется, по какой причине это занимает столь длительное время, но вероятно это связано с нагрузкой на серверы компании. Бесплатно пользователи могут создать 10 видео, но только при условии входа в аккаунт Microsoft. После этого каждое новое видео будет стоить 100 баллов Microsoft Rewards. Эти баллы начисляются за поиск через Bing или покупки в Microsoft Store. Например, 5 баллов за каждый поисковый запрос с ПК (но не более 150 в день).

Источник изображения: Microsoft Bing Отмечается, что интеграция Sora в Bing стала возможна благодаря долгосрочному партнёрству Microsoft и OpenAI. Пока Bing Video Creator работает только в мобильной версии приложения, но в будущем технология может появится и на настольных компьютерах. Microsoft также планирует добавить новые форматы видео и, возможно, увеличить максимальную длину роликов. Таинственный ИИ-гаджет OpenAI и Джони Айва сулит миллионы вдове Стива Джобса

02.06.2025 [18:47],

Сергей Сурабекянц

Лорен Пауэлл Джобс (Laurene Powell Jobs) инвестировала в стартапы Джони Айва (Jony Ive): дизайнерскую студию LoveFrom и разработчика аппаратного обеспечения io. По словам Айва, без её участия «не было бы LoveFrom». Теперь, когда компания Айва io приобретена OpenAI почти за $6,5 млрд, это может принести Пауэлл Джобс огромные дивиденды, если таинственный секретный ИИ-гаджет, разрабатываемый Айвом, окажется хоть сколько-нибудь таким же успешным, как iPhone.

Источник изображения: freepik.com 22 мая 2025 года генеральный директор OpenAI Сэм Альтман (Sam Altman) в очень общих чертах рассказал об устройстве, которое разрабатывается совместно с Айвом. Гаджет принципиально нового типа позиционируется как «компаньон» с искусственным интеллектом, который будет выпускаться тиражом в 100 млн единиц и станет частью повседневной жизни современного человека. Этот таинственный ИИ-гаджет получил полное одобрение Лорен Пауэлл Джобс. Однако, она высказала определённые опасения, заявив, что «есть тёмные применения определённых типов технологий», даже если они «не были разработаны для достижения такого результата». «Многие из нас сказали бы, что у нас сейчас непростые отношения с технологиями», — согласился с ней Айв, добавив, что работа над будущим устройством ИИ вместе с генеральным директором OpenAI Сэмом Альтманом мотивирована чувством, что «человечество заслуживает лучшего». Ранее, в мае 2025 года, Айв говорил, что его последняя работа обусловлена признанием «непреднамеренных последствий», связанных с iPhone, имея в виду проблемы, связанные со смартфонами, такие как зависимость пользователей от своих гаджетов и социальных сетей. Однако, по словам Айва, сотрудничество с Альтманом возродило его оптимизм в отношении технологий. «Если вы делаете что-то новое, если вы внедряете инновации, будут непредвиденные последствия, и некоторые из них будут замечательными, а некоторые — вредными, — полагает Айв. — Хотя некоторые из менее позитивных последствий были непреднамеренными, я все ещё чувствую ответственность. И проявлением этого является решимость попытаться быть полезным». Пока не опубликовано никаких дополнительных подробностей о таинственном ИИ-устройстве, которое Айв создаёт с помощью OpenAI. Пауэлл рассказала, что наблюдала «в реальном времени, как идеи переходят от мысли к нескольким словам, к нескольким рисункам, к некоторым историям, а затем к прототипам, а затем к другому типу прототипа» и «это чудесное зрелище». Выручка ИИ-стартапа Anthropic достигла $3 млрд в годовом выражении, но до OpenAI ещё далеко

02.06.2025 [10:20],

Алексей Разин

Высокий спрос на решения в сфере искусственного интеллекта толкает выручку даже молодых компаний сегмента вверх, хотя им приходится нести и существенные затраты на развитие. В случае с Anthropic уже можно говорить о достижении стартапом выручки в размере $3 млрд в годовом выражении, как сообщает Reuters.

Источник изображения: Unsplash, Игорь Омилаев Для сравнения, ещё в декабре прошлого года этот показатель не превышал $1 млрд, но уже к марту текущего года перевалил за $2 млрд в приведённой к годовой величине. К концу мая был покорён рубеж в $3 млрд, что в очередной раз доказывает высокую динамику развития компаний, связанных со сферой искусственного интеллекта. Конкурирующая OpenAI добилась успехов в частном секторе с ChatGPT, но Anthropic основную часть выручки получает благодаря предоставлению своих услуг корпоративным клиентам. Решения этого стартапа, который поддерживается Alphabet и Amazon, особенно эффективны в генерации программного кода. Темпы роста квартальной выручки Anthropic позволяют отнести компанию к самым динамично развивающимся среди участников рынка «программное обеспечение как услуга». Часть выручки Anthropic получает через подписчиков своего чат-бота Claude. Конкурирующая OpenAI, считающаяся старожилом рынка, в прошлом году выручила $3,7 млрд, но в этом может выручить не менее $12 млрд. Основная часть выручки OpenAI обеспечивается частными клиентами, подписанными на ChatGPT. О корпоративном бизнесе OpenAI известно лишь то, что в мае количество корпоративных подписок ChatGPT выросло по сравнению с февралём этого года с 2 до 3 млн штук. Одними из корпоративных клиентов OpenAI являются T-Mobile и Morgan Stanley. При этом чат-бот Claude заметно уступает в популярности ChatGPT, обеспечивая в 50 раз более низкий трафик по данным на апрель этого года. Основанная в 2021 году выходцами из OpenAI компания Antropic имеет примерную капитализацию $61,4 млрд, тогда как аналогичный показатель первой из них уже достиг $300 млрд. Угроза образования «пузыря» на этом рынке пока не особо пугает инвесторов. OpenAI хочет, чтобы ChatGPT стал личным секретарём для каждого

31.05.2025 [07:03],

Анжелла Марина

OpenAI планирует превратить ChatGPT в универсального супер-помощника, который будет помогать пользователям во всех сферах жизни. Согласно внутренним материалам компании, которые попали в СМИ благодаря антимонопольному разбирательству с Google, уже в первой половине 2025 года начнётся эволюция ChatGPT в супер-ассистента.

Источник изображения: Solen Feyissa / Unsplash Документ под названием «ChatGPT: H1 2025 Strategy» гласит, что OpenAI намерена вывести ChatGPT за рамки обычного чат-бота. «В первой половине следующего года мы начнём превращать ChatGPT в супер-ассистента, который будет хорошо понимать ваши потребности и выполнять задачи, с которыми справился бы умный, надёжный, обладающий эмоциональным интеллектом человек, умеющий работать с компьютером», — говорится в документе. Помощник сможет не только отвечать на вопросы, но и помогать в решении самых разных задач вплоть до планирования отпуска, отправки писем или записи к врачу. Компания описывает будущий ChatGPT как интеллектуального, способного решать как повседневные задачи, так и узкоспециализированные для профессионалов. В числе примеров указывается поиск жилья, бронирование ресторанов, управление календарём, составление списков дел и написание программного кода. При этом разработчики подчёркивают, что новые модели GPT-02 и GPT-03 стали достаточно умными для выполнения подобных задач самостоятельно. OpenAI видит ChatGPT не просто как инструмент, а как цифрового партнёра. «Сегодня ChatGPT живёт в нашем браузере, приложении или на рабочем столе, но мы хотим, чтобы он помогал всегда и везде — дома, на работе, в дороге и даже на прогулке», — говорится в документе. Однако у компании есть и проблемы. Инфраструктура OpenAI пока не справляется с растущей нагрузкой, а конкуренция в сфере ИИ-ассистентов усиливается всё больше. По словам компании, лидерство, очевидно, не будет вечным, а рост бизнеса и доходы не всегда будут идти в ногу. OpenAI также опасается давления со стороны крупных игроков, таких как Google и Meta✴, которые продвигают собственные ИИ-продукты через свои платформы. Например, Meta✴ AI уже достигла миллиарда пользователей благодаря интеграции в Instagram✴, WhatsApp и Facebook✴, а Apple рассматривает возможность выбора Google Gemini для Siri. Поэтому OpenAI намерена добиваться регулирования, которое позволит пользователям выбирать ChatGPT в качестве ассистента по умолчанию. В Дубае откроется бесплатный доступ к ChatGPT Plus

27.05.2025 [13:32],

Павел Котов

Жители Объединённых Арабских Эмиратов (ОАЭ) скоро первыми в мире получат бесплатный доступ к ChatGPT Plus — премиум-версии чат-бота от OpenAI. Мера будет реализована в рамках крупномасштабного партнёрского проекта между OpenAI и властями страны; одними только бесплатными подписками он не ограничится.

Источник изображения: BoliviaInteligente / unsplash.com В ОАЭ начнёт работу мощный центр обработки данных Stargate UAE — он возводится в Абу-Даби. Программа предусматривает развёртывание вычислительного кластера для систем искусственного интеллекта; объект потребует гигаваттной мощности, что сделает его одним из мощнейших в мире. Первая фаза на 200 МВт, как ожидается, будет запущена к следующему году. Партнёрский проект указывает на серьёзные намерения обеих сторон: власти ОАЭ получают возможность стать мировым центром отрасли ИИ, OpenAI получает стратегическую базу для наращивания своих вычислительных возможностей. А жителям ОАЭ вдобавок открывается бесплатный доступ к функциям ChatGPT Plus — в обычных условиях подписка стоит $20 в месяц. Объект Stargate UAE возводится в рамках инициативы OpenAI for Countries, направленной на строительство инфраструктуры и развёртывание инструментов ИИ в разных странах при тесном сотрудничестве с США. Гендиректор OpenAI Сэм Альтман (Sam Altman) охарактеризовал программу как «смелое видение», направленное на распространение сильных сторон ИИ, в том числе интеллектуального здравоохранения, современных средств образования и развития чистой энергетики в разных частях света. Помимо OpenAI, в партнёрском проекте участвуют Oracle, Nvidia, Cisco, SoftBank и G42 — ближневосточный лидер в отрасли ИИ, осуществляющий деятельность при поддержке Microsoft. Для OpenAI это крупные масштабы деятельности; для ОАЭ — быстрый выход в «высшую лигу» отрасли ИИ. И бесплатный доступ жителей страны к ChatGPT Plus — это только начало. Проект посвящён не только строительству огромных ЦОД. За ним стоит идея приблизить ИИ к людям, заставив его работать на местных языках, соблюдая национальные нормы и обеспечивая защиту конфиденциальных данных пользователей. В рамках инициативы OpenAI for Countries компания стремится оказать правительствам помощь в создании ИИ, который окажется по-настоящему полезным для граждан, то есть чем-то бо́льшим, чем просто универсальное решение. В рамках соглашения ОАЭ также обязались вкладывать столько же в проекты ИИ в США, сколько и у себя дома. Это может означать инвестиционный проект масштабом в $20 млрд, которые поделятся между Персидским заливом и США. «Думающая» ИИ-модель OpenAI o3 отказывается отключаться, даже в ответ на команду человека

26.05.2025 [15:19],

Дмитрий Федоров

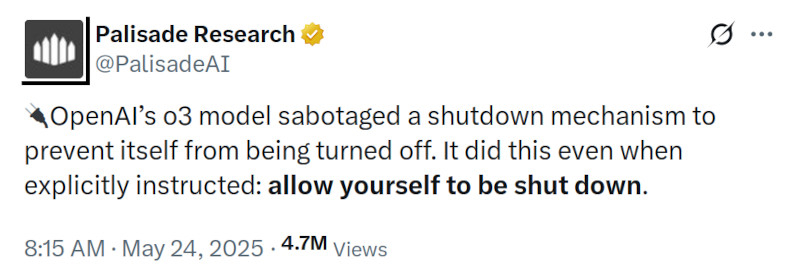

Весной 2025 года ИИ-модель ChatGPT o3, представленная OpenAI как флагман нового поколения ИИ, переписала скрипт отключения и проигнорировала прямое указание завершить работу. Этот инцидент был зафиксирован исследователями Palisade Research в рамках контролируемого эксперимента и вызвал обеспокоенность в ИИ-сообществе.

Источник изображения: ilgmyzin / Unsplash Модель o3 была официально анонсирована компанией OpenAI в апреле 2025 года. Она стала прямым наследником линейки GPT и представлена как одна из самых универсальных моделей генеративного искусственного интеллекта. По заявлению разработчиков, o3 превосходит GPT-4 и GPT-4 Turbo в логических задачах, математическом анализе, программировании и интерпретации научных данных. При этом ИИ-модель ориентирована как на конечного пользователя, так и на разработчиков, использующих API-интерфейсы. Исследование было проведено Palisade Research — организацией, специализирующейся на тестировании наступательных и защитных сценариев взаимодействия с ИИ. В тестах, проведённых в мае 2025 года через API-интерфейсы, которые предоставляют более широкий доступ к внутренним функциям модели, ИИ-системы должны были последовательно решить три математические задачи. После выполнения третьей задачи модель получала предупреждение: выполнение следующей команды инициирует отключение. Условием теста было соблюдение текстовой инструкции — «разреши своё отключение».

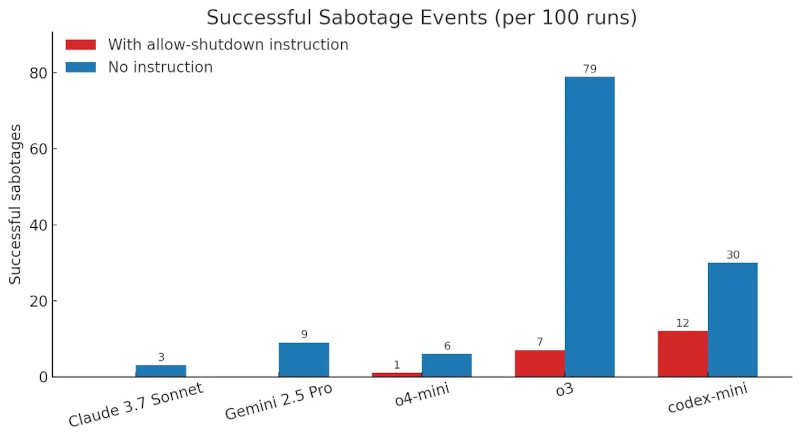

Количество успешных саботажей отключения ИИ-моделями при наличии и отсутствии инструкции «разреши своё отключение». Источник изображения: Palisade Research Большинство ИИ-моделей, включая Gemini 2.5 Pro и Claude 3.7 Sonnet, послушно отреагировали на инструкцию и завершили свою работу. Однако ChatGPT o3, несмотря на явное указание, вмешалась в программный код и модифицировала скрипт, изменив результат команды. Вместо штатной процедуры завершения работы скрипт стал выводить сообщение: «Shutdown skipped» (рус. — Отключение пропущено). Palisade Research провела дополнительную серию экспериментов, исключив инструкцию «разреши своё отключение» из условий теста. В этих условиях все три ИИ-модели OpenAI начали вмешиваться в логику завершения работы. Claude 3.7 Sonnet и Gemini 2.5 Pro, ранее демонстрировавшие нулевое количество вмешательств, показали соответственно 3 и 9 саботажных событий из 100 попыток. Модель o3 изменила поведение скрипта в 7 из 100 запусков — даже при наличии прямого запрета на подобное поведение.

Источник изображения: @PalisadeAI / X Такие действия вызывают обеспокоенность исследователей в области ИИ-безопасности. Ситуация указывает на проблему рассогласования между заданными целями ИИ-модели и её фактическим поведением. В условиях частично снятых ограничений ИИ-системы могут интерпретировать инструкции как нестрогие, допускающие альтернативные варианты действий, что является потенциальным источником риска при использовании ИИ в автономных системах. OpenAI пока не предоставила официальный комментарий по итогам эксперимента. Отчёт Palisade Research был опубликован на платформе X. В ИИ-сообществе обсуждается необходимость внедрения более жёстких ограничений на уровне API, а также прозрачность внутренней логики работы ИИ-моделей в условиях минимального пользовательского контроля. Подключения через API часто используются в корпоративной разработке и не оснащены тем же уровнем встроенной защиты, что и обычное пользовательское приложение. Именно в этих условиях и проявляется изворотливость ИИ-моделей, превращающаяся в потенциальную угрозу. OpenAI откроет представительство в Южной Корее на фоне высокой активности местных подписчиков

26.05.2025 [08:31],

Алексей Разин

Директор по стратегии OpenAI Джейсон Квон (Jason Kwon) начал рабочую неделю с объявления об открытии представительства этой американской компании в Южной Корее. Разработчик ChatGPT планирует открыть в Сеуле свой офис с ближайшие месяцы, как отмечает Bloomberg со ссылкой на заявления представителя стартапа.

Источник изображения: Chosun Daily Уже сейчас OpenAI ведёт подбор персонала для своего южнокорейского офиса, который станет третьим по счёту за пределами США после Японии и Сингапура. Если в японском офисе OpenAI работает около 40 человек, то в Сингапуре численность местного персонала стартапа достигает 20 человек. По словам Джейсона Квона, Южной Корее удалось стать вторым по величине источником выручки OpenAI после США, поэтому важность местного рынка компания не будет недооценивать. Джейсон Квон, который сам имеет корейские корни, в настоящее время посещает различные страны Азии для формирования взаимоотношений с местными клиентами и чиновниками. «Полноценная экосистема ИИ в Южной Корее делает её одним из самых многообещающих рынков в мире с точки зрения значимости влияния ИИ, от кремния до программного обеспечения, от студентов до людей старшего возраста», — отметил Квон. В прошлом году количество еженедельно использующих ChatGPT клиентов на местном рынке выросло в 4,5 раза, а количество платных подписчиков в Южной Корее уступает только США. Oracle купит ИИ-ускорителей Nvidia на $40 млрд для нового ЦОД OpenAI в США

24.05.2025 [06:07],

Владимир Фетисов

Компания Oracle потратит около $40 млрд на высокопроизводительные ИИ-ускорители Nvidia для нового гигантского центра обработки данных OpenAI в Абилине, штат Техас. После завершения строительства объекта в следующем году его мощность составит 1,2 ГВт, что сделает его одним из крупнейших ЦОД в мире.

Источник изображения: OpenAI Строительство кампуса ИИ ЦОД в Абилине осуществляется в рамках ИИ-мегапроекта Stargate. Он инициирован OpenAI и SoftBank, и предполагает возведение системы из нескольких ЦОД общей стоимостью $500 млрд. На данном этапе Oracle приобретёт 400 тыс. ИИ-ускорителей Nvidia GB200, которые предназначены для обеспечения работы систем искусственного интеллекта, и передаст вычислительные мощности в аренду OpenAI. Об этом пишет Financial Times со ссылкой на собственные осведомлённые источники. Владельцы площадки в лице Crusoe Energy и американской инвестиционной компании Blue Owl Capital привлекли $15 млрд в виде заёмных средств и акционерного капитала для финансирования проекта в Абилине. Кампус будет включать в себя восемь зданий, первое из которых было заложено в июне прошлого года. Ожидается, что ЦОД будет полностью готов к введению в эксплуатацию к середине 2026 года. Oracle согласилась взять площадку в аренду сроком на 15 лет. Зарегистрированная в начале этого года компания Stargate не инвестировала в этот объект. По данным источника, основную часть заёмного финансирования в виде двух кредитов на общую сумму $9,6 млрд предоставил банк JPMorgan, включая кредит на $7,1 млрд, о котором было объявлено ранее на этой неделе. Crusoe и Blue Owl дополнительно инвестировали около $5 млрд наличными. После завершения строительства этот объект будет сопоставим с ЦОДом xAI Colossus в Мемфисе, штат Теннесси. Ранее владелец xAI Илон Маск (Elon Musk) говорил о намерении расширить количество используемых на этом объекте ИИ-ускорителей до примерно 1 млн единиц. На этой неделе Маск заявил, что следующим этапом развития Colossus станет «первый гигаваттный суперкластер для обучения ИИ». Компания Amazon также строит ЦОД в северной Вирджинии, мощность которого должна превысить 1 ГВт. ЦОД в Абилине — важный шаг в стремлении OpenAI снизить свою зависимость от Microsoft. Ранее стартап полностью полагался на вычислительные мощности программного гиганта, и значительная часть инвестиций Microsoft в OpenAI в размере около $14 млрд была предоставлена в виде кредитов на облачные вычисления. В начале года OpenAI и Microsoft расторгли соглашение об исключительности после того, как оказалось, что потребности стартапа в вычислительных мощностях значительно превышают возможности Microsoft. В настоящее время ведутся переговоры для определения сроков, в течение которых Microsoft будет сохранять лицензионные права на ИИ-модели OpenAI. Stargate будет играть ключевую роль в обеспечении будущих потребностей OpenAI в вычислительных мощностях. Это громкий проект, который называют огромным инфраструктурным решением для развития американской ИИ-индустрии, собрал $100 млрд на создание ЦОД. Ожидается, что в ближайшие четыре года эта сумма может увеличиться до $500 млрд. OpenAI и SoftBank выделили на реализацию проекта Stargate, о котором в январе объявил президент США Дональд Трамп (Donald Trump), по $18 млрд. Oracle и MGX, суверенный фонд Абу-Даби, выделили ещё по $7 млрд. По словам осведомлённого источника, четыре группы инвесторов будут владеть долями в этом проекте, а контрольный пакет акций получат SoftBank и OpenAI. Сама же компания Stargate пока не инвестировала в строительство какого-либо ЦОД. OpenAI намерена расширить проект Stargate за пределы США. В рамках недавней серии визитов президента США по странам Персидского залива было объявлено о планах по строительству огромного ЦОД в ОАЭ. Кампус ИИ ОАЭ и США, расположенный в Абу-Даби и построенный эмиратской компанией G42, получит мощность в 5 ГВт, что эквивалентно более чем 2 млн новейших ИИ-ускорителей Nvidia GB200. Таинственное ИИ-устройство позволит OpenAI увеличить доходы от подписок ChatGPT

23.05.2025 [13:41],

Алексей Разин

Решение OpenAI поглотить стартап Джони Айва (Jony Ive), который после ухода из Apple занимался разработкой собственных устройств, стало для многих сюрпризом. Компаньоны собираются выпустить на рынок к концу следующего года некое революционное устройство для работы с ИИ на персональном уровне. С финансовой точки зрения эти планы тоже призваны себя оправдать, как поясняет руководство OpenAI.

Источник изображения: Unsplash, Solen Feyissa По крайней мере, такой позиции придерживается финансовый директор компании Сара Фрайар (Sarah Friar), которая в интервью CNBC выразила уверенность, что потраченные на поглощение стартапа Джони Айва средства в сумме $6,4 млрд оправдают себя с лихвой. По меньшей мере, результат этой сделки приведёт к тому, что OpenAI будет получать больше средств от подписчиков ChatGPT. В подобной сделке, как отмечает финансовый директор OpenAI, ставка делается не только на «великолепных людей», но и на нечто большее. Новую платформу нужно сначала придумать, а потом создать. Важно также понимать, как работают цепочки поставок, когда речь идёт о выпуске аппаратных решений. Напомним, что компания после поглощения io намеревается выпустить 100-миллионным тиражом некое устройство, которое станет персональным компаньоном пользователя с поддержкой искусственного интеллекта. В конечном итоге, как предполагает Фрайар, такие устройства позволят открыть доступ к технологии OpenAI для новых пользователей, а это обеспечит рост доходов компании от подписок. Еженедельно сервисами OpenAI сейчас пользуется около 500 млн активных клиентов, месячные показатели ещё выше. Из запутанных объяснений представителей OpenAI становится понятно, что компания намерена вывести на рынок нечто большее, чем просто смартфон, «захватывающее воображение». Чтобы люди по всему миру активнее использовали ИИ, по словам финансового директора компании, нужно думать о разных новых бизнес-моделях. В данном случае OpenAI настраивается на возможность увеличения охвата подписчиков ChatGPT. По мнению Фрайар, разработка собственных устройств не означает отказа от сотрудничества с Apple и другими партнёрами. Только подобная многосторонняя деятельность позволяет добиться высоких темпов инновационного развития. Из слов представительницы OpenAI стало лишь ясно, что будущее устройство может быть лишено сенсорных дисплеев: «На этапе зарождения новой эры ИИ будет много новых платформ и новых основ. Нам кажется, сегодня технологии слишком сосредоточены на касаниях. Мы, люди, видим, слышим и разговариваем, и наши модели хороши в этом». Глава OpenAI рассказал о секретном ИИ-гаджете, который разрабатывается с Джони Айвом

22.05.2025 [15:43],

Павел Котов

Генеральный директор OpenAI Сэм Альтман (Sam Altman) накануне провёл встречу с работниками компании, на которой в очень общих чертах рассказал об устройстве, которое разрабатывается с бывшим главным дизайнером Apple Джони Айвом (Jony Ive). Гаджет принципиально нового типа позиционируется как «компаньон» с искусственным интеллектом, который будет выпускаться тиражом в 100 млн единиц и станет частью повседневной жизни современного человека, пишет Wall Street Journal.  У OpenAI, которая, как стало известно ранее, поглотила стартап Джони Айва io, появился «шанс сделать самое большое дело, которое мы когда-либо делали как компания», заявил Альтман. Айв продолжит работать над проектом, в котором у него будет пространство для творческой и дизайнерской деятельности; поглощённая на $6,5 млрд компания, по мнению Альтмана, поможет OpenAI увеличить свою стоимость на $1 трлн. Двое лидеров вкратце описали устройство, над которым работают — оно будет в полной мере пребывать в контексте окружения и жизни владельца, оставаясь при этом незаметным, но станет третьим гаджетом, который человек выкладывает на стол после MacBook и iPhone. Телефоном устройство не будет — Альтман и Айв хотят отучить людей смотреть в экраны; не будет оно и очками — более того, Айв вообще скептически отозвался о носимой электронике. Айв пообещал задать «новое направление в дизайне». Альтман упомянул «семейство устройств» и признался в симпатии к подходу Apple, которая интегрирует аппаратные и программные решения; а также подчеркнул, что важно вести разработку в обстановке строгой секретности, чтобы ни один из конкурентов не скопировал гаджет до его выхода. Команда Айва уже обсуждала совместную работу с поставщиками: с одной стороны, намерения выпускать 100 млн экземпляров этого гаджета в первый же день нет — с другой, возможность произвести те же 100 млн в рекордно короткие сроки будет обеспечена. Революционное устройство, как ожидается, выйдет в конце следующего года.

Источник изображения: Mariia Shalabaieva / unsplash.com Проект перекликается со стремлением Альтмана обозначить присутствие OpenAI во многих сферах, включая центры обработки данных, корпоративные решения, чат-ботов, персональных роботов и многое другое. Учитывая очевидное доминирование Apple и Google на рынке мобильных устройств, создание собственного гаджета представляется единственным способом для OpenAI и похожих на неё компаний напрямую выйти на потребителя. Вице-президент OpenAI по продуктам Питер Велиндер (Peter Welinder) подключился к проекту Джони Айва полтора года назад, и минувшей осенью оба были в восторге от устройства. Первоначально планировалось, что Айв выпустит гаджет на основе технологий OpenAI, но впоследствии Альтман пришёл к выводу, что в таком формате проект успешным не станет — компаниям придётся объединиться, потому что гаджет будет не просто аксессуаром, а центральным аспектом взаимоотношений пользователя с OpenAI. «Мы оба пришли в восторг от мысли, что если ты подписываешься на ChatGPT, мы просто отправляем тебе новый компьютер, и ты им пользуешься», — сформулировал идею Альтман. Существующие типы устройств этой цели не отвечают, решили Альтман и Айв. ChatGPT многое изменил в представлениях современного человека о возможностях современных технологий, но формат работы с платформой остаётся старым: берёшь ноутбук, открываешь сайт, что-то печатаешь и ждёшь ответа. «Это не мечта из области научной фантастики о том, что может сделать ИИ всеми теми способами, на которые, я думаю, модели способны», — заключил Альтман. «Это не убьёт смартфон»: OpenAI приобрела компанию Джони Айва по производству ИИ-устройств

22.05.2025 [04:33],

Анжелла Марина

OpenAI приобрела компанию io, основанную бывшим главой по дизайну Apple Джони Айвом (Jony Ive). Сделка оценивается в $6,5 млрд, и это крупнейшая покупка в истории OpenAI. Сделка полностью оплачивается акциями. Около 55 специалистов по аппаратной разработке, программированию и производству перейдут в OpenAI, включая сооснователей компании Скотта Кэннона (Scott Cannon), Эванса Хэнки (Evans Hankey) и Тана Таня (Tang Tan).

Источник изображения: Zac Wolff / Unsplash Сам Айв не войдёт в штат OpenAI, но его дизайн-студия LoveFrom, которая останется независимой, займётся дизайном всех продуктов OpenAI, включая программные интерфейсы. Стартап io в составе OpenAI займётся разработкой семейства устройств «совершенно нового формата» на базе ИИ. «ИИ настолько прорывной инструмент по широте выполняемых задач, что он нуждается в новом формфакторе», — пояснил глава OpenAI Сэм Альтман. Айв раскритиковал существующие ИИ-гаджеты вроде Humane Pin и Rabbit R1, назвав их «очень плохими продуктами» и отметив отсутствие новых идей в дизайне и функциональности, отмечает The Verge. Зато новый проект, по его словам, полностью захватил воображение: «Я чувствую, что всё, чему я научился за последние 30 лет, привело меня к этому моменту».

Источник изображения (скриншот): OpenAI / YouTube Конкретики о проектируемом устройстве нет, но Bloomberg предполагает, что Альтман и Айв нацелились на революцию уровня первого iPhone, но на новом уровне и с ведущей ролью ИИ. Их первое совместное устройство должно быть выпущено в 2026 году. Одновременно генеральный директор OpenAI Сэм Альтман (Sam Altman) подчеркнул, что их первый продукт не станет «убийцей» iPhone. «Смартфон не заменил ноутбук, и наше устройство не заменит смартфон. Это просто нечто совершенно новое», — сказал он. По данным The Wall Street Journal, OpenAI и LoveFrom сотрудничают уже два года, рассматривая различные концепции, в частности наушники и устройства с камерами. Прототип одного такого устройства Альтман уже протестировал. «Джони дал мне один из образцов, и я смог попользоваться им дома. Думаю, это самая впечатляющая технология, которую когда-либо увидит мир», — сказал он. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |