|

Опрос

|

реклама

Быстрый переход

OpenAI пока не готова активно использовать ускорители Google в своей инфраструктуре

01.07.2025 [07:01],

Алексей Разин

В минувшую субботу стало известно об экспериментах OpenAI по использованию ускорителей Google серии TPU для вычислений, связанных с формированием логических выводов, тогда как исторически для этого применялись в основном изделия Nvidia. Представители OpenAI поспешили заверить Reuters, что планов по масштабному внедрению TPU у этого стартапа пока нет.

Источник изображения: Google Cloud При этом, как отмечает Reuters, представители OpenAI не отрицают, что начали экспериментировать с ускорителями Google, но тестирование находится на ранней стадии и не подразумевает скорого и активного масштабирования. На этом пути способны возникнуть серьёзные барьеры в виде длительной адаптации программного обеспечения под особенности архитектуры конкретных вычислительных компонентов. Основная часть вычислений и далее будет производиться OpenAI с использованием ускорителей AMD и Nvidia. Более того, ранее сообщалось, что OpenAI занимается разработкой собственных чипов для ускорителей ИИ, и уже в этом году рассчитывает получить готовый к массовому производству цифровой проект. В тоже время, готовность Google предлагать свои ускорители сторонним клиентам говорит о смене вектора в политике компании. К ним уже присоединились Apple, а также стартапы Anthropic и Safe Superintelligence. Два последних были основаны выходцами из OpenAI, поэтому тенденция может считаться достаточно распространённой. Другое дело, что непосредственно OpenAI существенных надежд с применением ускорителей Google пока не связывает. Монополия Nvidia пошатнулась: OpenAI начала использовать чипы Google

28.06.2025 [18:06],

Владимир Мироненко

OpenAI начала использовать ИИ-ускорители TPU компании Google для поддержки работы ИИ-чат-бота ChatGPT и связанных с ним сервисов. Это стало её первым значительным шагом в направлении отказа от исключительного использования чипов Nvidia в рамках стратегии по снижению зависимости от инфраструктуры, управляемой Microsoft, сообщил The Information.

Источник изображения: Mariia Shalabaieva/unsplash.com OpenAI арендует у Google Cloud тензорные процессоры (TPU) с целью сокращения расходов, связанных с вычислениями инференса — процесса использования ИИ-модели для генерации результатов в ответ на запросы после завершения её обучения. Решение OpenAI использовать TPU от Google может означать повышение их статуса в качестве экономически эффективной альтернативы широко используемым GPU компании Nvidia, которая доминирует на рынке ИИ-ускорителей, отметил ресурс investing.com. Ранее OpenAI для обучения и развёртывания своих ИИ-моделей использовала оборудование на базе чипов Nvidia, в основном через партнёрство с Microsoft и Oracle. Новый партнёр, Google, хотя и предоставляет OpenAI некоторые вычислительные мощности на базе TPU, не предлагает ей самые мощные версии своих ускорителей, сообщают источники The Information. Следовательно, самые продвинутые версии TPU Google зарезервировала для внутреннего использования, включая работу над собственными большими языковыми моделями в рамках проекта Gemini. Тем не менее, для OpenAI доступ даже к более ранним версиям TPU представляет собой шаг в направлении диверсификации вычислительной инфраструктуры на фоне растущего спроса на ИИ-чипы в отрасли. На данный момент неясно, будет ли OpenAI использовать TPU Google для обучения моделей или ограничится только применением для инференса. По мере роста конкуренции и углубления ограничений ресурсов гибридная инфраструктура может обеспечить компании больше гибкости в использовании вычислительных мощностей для масштабирования. Google показала системы с собственными TPU, на которых обучаются ИИ-модели Gemini и Apple Intelligence

23.08.2024 [17:45],

Павел Котов

В большой лаборатории в штаб-квартире Google в калифорнийском Маунтин-Вью работают сотни серверных стоек, выполняя задачи, отличные от поисковой системы или рабочих нагрузок Google Cloud. Здесь тестируются тензорные процессоры (Tensor Processing Units —TPU), разработанные самой Google. Журналистам CNBC удалось заглянуть внутрь этой лаборатории.

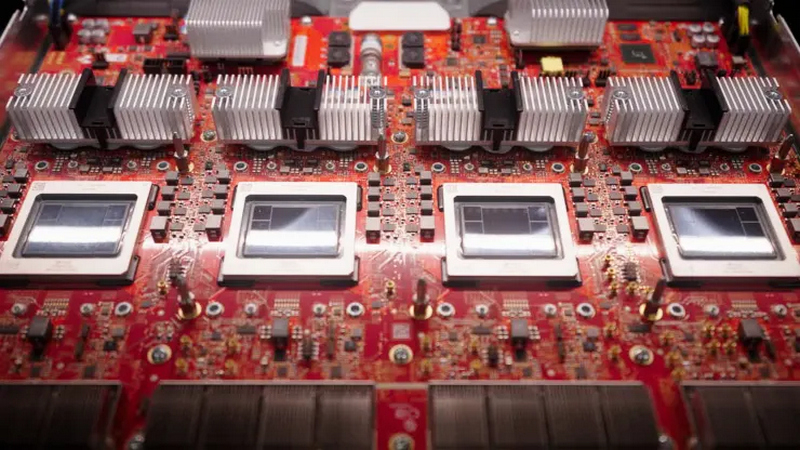

Источник изображения: alban / unsplash.com TPU от Google появились в 2015 и стали доступны облачным клиентам в 2018 году — они используются, в частности, для обучения моделей Apple Intelligence и Google Gemini. Google была первым поставщиком облачных услуг, который построил собственные чипы для ИИ — Amazon анонсировала свои Inferentia лишь три года спустя, а Microsoft представила Maia лишь в конце 2023 года. Но это первенство не помогло Google стать лидером в гонке генеративного ИИ: Gemini вышла более чем через год после OpenAI ChatGPT. При этом предложения в области ИИ помогли Google Cloud набрать обороты: этот сегмент в компании показал рост на 29 %, а квартальная выручка впервые превысила $10 млрд, гласит последний квартальный отчёт Alphabet. В Google пришли к мысли о создании собственного чипа, когда в 2014 году задумались, какими должны быть ресурсы, чтобы все пользователи сервисов компании смогли пользоваться голосовым интерфейсом хотя бы 30 секунд в день. Как выяснилось, число компьютеров в центрах обработки данных было необходимо удвоить. Google TPU помог поднять эффективность при выполнении некоторых задач в 100 раз. В компании до сих пор используют и традиционные центральные процессоры, и графические процессоры Nvidia. Но Google TPU — это интегральная схема специального назначения (ASIC), предназначенная только для конкретного типа задач. В распоряжении компании есть ещё один такой чип — Video Coding Unit, и используется он для обработки видео.  Собственные чипы Google по примеру Apple стала использовать и в устройствах своей разработки: в смартфонах Pixel 9 это процессор четвёртого поколения Tensor G4, а в наушниках Pixel Buds Pro 2 — Tensor A1. Но важной отличительной чертой Google является серверный TPU — сейчас он занимает 58 % рынка среди облачных ускорителей ИИ собственной разработки. Графические процессоры Nvidia более гибкие, но и более дорогие и дефицитные в сегодняшних условиях, когда бум ИИ взвинтил акции компании до небес, и теперь она соперничает за звание самой дорогой публичной компании в мире с Apple и Microsoft. Настоящее испытание Google TPU ждёт, когда платформа Apple Intelligence в следующем году начнёт в полную силу работать на iPhone и Mac. Разработка альтернативы ускорителям Nvidia — почти подвиг. Процесс настолько сложен и дорог, что даже Google не под силу сделать это в одиночку. С момента появления первого TPU компания заручилась поддержкой чипмейкера Broadcom, который помогает Meta✴ в решении той же задачи. Проект полностью разработанного чипа отправляется к полупроводниковому подрядчику — в его роли выступает TSMC, выпускающая 92 % передовой полупроводниковой продукции в мире.

Trillium. Источник изображения: CNBC/Marc Ganley В этом году у Google выйдет шестое поколение TPU Trillium; кроме того, в минувшем апреле компания анонсировала и Axion — свой первый центральный процессор, который появится в конце года. И здесь Google уже не первая: Amazon выпустила свой Graviton в 2018 году, китайская Alibaba последовала её примеру в 2021 году, а Microsoft представила чип Cobalt 100 в ноябре прошлого года. Все они основаны на архитектуре Arm, более гибкой и энергоэффективной, чем x86, которой привержены Intel и AMD.

Axion CPU. Источник изображения: CNBC/Marc Ganley Эффективность является важнейшим аспектом: если верить прогнозам, к 2027 году серверы ИИ будут потреблять столько же энергии в год, сколько Аргентина. Последний экологический отчёт Google показал, что выбросы компании с 2019 по 2023 гг. выросли на 50 % — отчасти из-за роста числа ЦОД для ИИ. Для охлаждения серверов для обучения и работы ИИ требуются огромные объёмы воды, поэтому с третьего поколения Google TPU охлаждение производится непосредственно на чипе — к такой же схеме прибегла и Nvidia с новейшими Blackwell. И, несмотря на сопутствующие трудности, оборудование Google для ИИ продолжает пользоваться большим спросом, и его ослабления в компании пока не отмечают. Google представила мощнейший серверный ИИ-процессор Trillium — почти в пять раз быстрее предшественника

14.05.2024 [22:21],

Николай Хижняк

В рамках конференции Google I/O компания Google представила шестое поколение своего фирменного тензорного процессора (Tensor Processing Unit) с кодовым названием Trillium. Он предназначен для центров обработки данных, ориентированных на работу с искусственным интеллектом. По словам компании, новый чип почти в пять раз производительнее предшественника.

Источник изображения: The Verge «Промышленный спрос на компьютеры для машинного обучения вырос в миллион раз за последние шесть лет и каждый год продолжает увеличиться в десять раз. Я думаю, что Google была создана для этого момента. Мы являемся новаторами в разработке чипов для искусственного интеллекта уже более десяти лет», — заявил генеральный директор Alphabet Сундар Пичаи (Sundar Pichai) в разговоре с журналистами. Разрабатываемые Alphabet, материнской компанией Google, специализированные чипы для центров обработки данных, ориентированных на ИИ, представляют собой одну из немногих жизнеспособных альтернатив решениям компании Nvidia. Вместе с программным обеспечением, оптимизированным для работы с тензорными процессорами Google (TPU), эти решения позволили компании занять значительную долю на рынке. По данным издания Reuters, Nvidia по-прежнему доминирует на рынке чипов для ИИ-дата-центров с долей 80 %. Значительная часть от оставшихся 20 % приходятся на различные версии TPU от Google. В отличие от Nvidia, компания Google не продаёт свои процессоры, а использует их сами и сдаёт в аренду облачные вычислительные платформы, которые на них работают. Для шестого поколения TPU под названием Trillium компания заявляет прибавку вычислительной производительности в 4,7 раза по сравнению с TPU v5e в задачах, связанных с генерацией теста и медиаконтента с помощью больших языковых моделей ИИ (LLM). При этом Trillium на 67 % энергоэффективнее, чем TPU v5e, отмечают в компании. Как пишет портал TechCrunch, значительного увеличения производительности у Trillium компания смогла добиться благодаря увеличения количества используемых матричных умножителей (MXU), а также повышения тактовой частоты чипа. Кроме того, компания удвоила для Trillium пропускную способность памяти. Более конкретных технических деталей Trillium не приводится. Вычислительные мощности нового процессора станут доступны для клиентов облачных сервисов Google к «концу 2024 года», отмечают в компании. Однако от решений Nvidia компания Google не отказывается. В рамках конференции Google I/O также было заявлено, Google станет одним из первых облачных провайдеров, который с начала будущего года будет предлагать облачные услуги на базе специализированных ИИ-ускорителей нового поколения Nvidia Blackwell. Google Cloud представила пятое поколение тензорных процессоров для обучения ИИ

30.08.2023 [18:04],

Николай Хижняк

На очередной ежегодной конференции Cloud Next компания Google Cloud объявила о выпуске пятого поколения своих тензорных процессоров (TPU) для обучения нейросетей — TPU v5e. Google анонсировала предыдущую, четвертую версию этих процессоров в 2021 году, но разработчикам они стали доступны только в 2022 году.

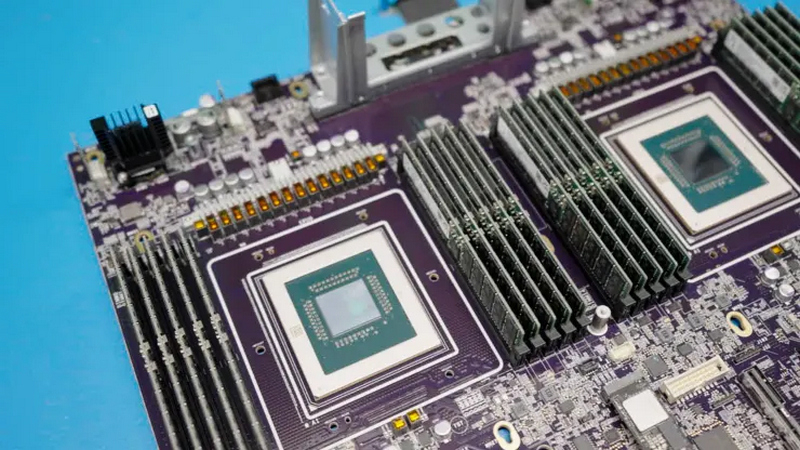

Источник изображения: Frederic Lardinois / TechCrunch Компания отмечает, что при создании новой версии чипа особое внимание уделялось его эффективности. По сравнению с предыдущим поколением, новый процессор обещает двукратное улучшение производительности в пересчёте на доллар для обучения больших языковых моделей (LLM) и генеративных нейросетей, а также 2,5-кратное улучшение производительности по тому же критерию для инференс-систем. «Это самый экономичный и доступный облачный TPU на сегодняшний день», — заявил на пресс-конференции перед сегодняшним анонсом Марк Ломейер (Mark Lohmeyer), вице-президент и генеральный директор по вычислительной и ML-инфраструктуре Google Cloud.

Источник изображения: Google В то же время он подчеркнул, что компания не экономила на технических характеристиках TPU v5e в угоду рентабельности. Кластеры могут включать до 256 чипов TPU v5e, объединённых высокоскоростным интерконнектом с совокупной пропускной способностью более 400 Тбит/с. Производительность такой платформы составляет 100 Попс (Петаопс) в INT8-вычислениях. «Мы предоставляем нашим клиентам возможность легко масштабировать свои модели искусственного интеллекта за пределы физических границ одного модуля TPU или одного кластера TPU. Другими словами, одна большая рабочая нагрузка искусственного интеллекта теперь может распределяться на несколько физических кластеров TPU, масштабируясь буквально до десятков тысяч чипов. При этом работа будет выполняться экономически эффективно. В результате, используя облачные графические процессоры и облачные TPU, мы действительно предоставляем нашим клиентам большой выбор, гибкость и дополнительные возможности для удовлетворения потребностей широкого набора рабочих задач, связанных с ИИ, которые, как мы видим, продолжают множиться», — добавил он. В дополнение к анонсу нового поколения TPU компания Google также объявила, что в следующем месяце сделает общедоступными для разработчиков виртуальные кластеры A3, оснащённые специализированными графическими процессорами Nvidia H100. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |