|

Опрос

|

реклама

Быстрый переход

Мошенники вооружились ИИ для вымогательства с помощью фейковых голосовых сообщений

10.01.2024 [14:43],

Дмитрий Федоров

Злоумышленники стали практиковать новый метод вымогательства через социальные сети и мессенджеры с использованием ИИ для создания поддельных голосовых сообщений. Получив доступ к аккаунту пользователя, они рассылают его знакомым и во все чаты, где он состоит, поддельные голосовые сообщения с просьбами о переводе денег.

Источник изображения: B_A / Pixabay При этом мошенники не ограничиваются созданием с помощью ИИ поддельных голосовых сообщений: они также используют фотографии банковских карт, указывая на них имя и фамилию владельца украденного аккаунта. Это делается для придания дополнительной достоверности их просьбам о переводе денег. Так, один из пользователей социальной сети «ВКонтакте» потерял 200 000 рублей, а другой — 3000 рублей. Важно отметить, что в некоторых случаях злоумышленники использовали данные паспорта пользователя украденного аккаунта, которые отличались от информации в его социальных сетях, что дополнительно затрудняло выявление обмана. Это свидетельствует о высокой степени изощрённости и планирования таких атак. Представители «ВКонтакте» подчеркнули, что подобные массовые мошеннические схемы на их платформе отсутствуют. Для борьбы с такими угрозами компания использует системы безопасности, в том числе автоматические инструменты на основе ИИ, которые способны оперативно реагировать на обращения пользователей. По словам Евгения Егорова, ведущего специалиста департамента Digital Risk Protection компании F.A.C.C.T., взлом аккаунтов в Telegram или WhatsApp чаще всего происходит через фишинговые атаки, в том числе с использованием фейковых голосований. После кражи аккаунта мошенники скачивают сохранённые голосовые сообщения пользователя и с помощью ИИ создают поддельные аудиозаписи с нужным содержанием. Диана Селехина, эксперт центра мониторинга внешних цифровых угроз Solar AURA ГК «Солар», сообщила о значительном росте числа случаев мошенничества в Telegram, связанных с кражей аккаунтов. Она добавила, что за последние 30 дней было выявлено более 500 новых доменных имён, созвучных с названием мессенджера, что указывает на активизацию мошенников. Селехина отметила, что в Telegram наряду с фейковыми голосованиями и схемами подписки Premium активно распространяются и другие мошеннические методы. Общим элементом всех этих схем является требование от пользователей вводить свой номер телефона и SMS-код, которые затем используются для несанкционированного доступа к аккаунтам. В последнее время эксперты фиксируют участившееся использование дипфейков в Telegram, часто сочетаемых с поддельными голосовыми сообщениями. Упомянутая ситуация требует повышенного внимания со стороны пользователей социальных сетей и мессенджеров. Важно быть бдительным и критически подходить к любым просьбам о переводе финансовых средств, в том числе от знакомых лиц. Развитие ИИ открывает новые горизонты не только для положительных инноваций, но и для мошеннических схем. Всё это подчёркивает важность осведомлённости и предосторожности в цифровом мире. В России впервые оштрафовали компанию за воровство видео с дипфейком — в нём есть липовый Киану Ривз и утюг

06.12.2023 [16:36],

Павел Котов

Арбитражный суд Москвы взыскал с ООО «Бизнес-аналитика», управляющего аналитическим сервисом Roistat, компенсацию в размере 500 тыс. руб. за несанкционированное использование видео с дипфейком. В ролике использовался образ канадского актёра Киану Ривза (Keanu Reeves). Компенсация была присуждена создателю видео, компании «Рефейс Технолоджис», которая работает под брендом Agenda Media Group (AMG), сообщает Forbes.

Источник изображения: agenda.media На видеоролике человек, которому при помощи технологии дипфейка было дорисовано лицо Киану Ривза, пытается выйти из дома, но несколько раз возвращается и проверяет, выключил ли он утюг, — в итоге герой уносит утюг с собой. В июне 2023 года сервис Roistat начал распространять в Telegram рекламный ролик, в котором использовалось это видео. AMG специализируется на создании роликов с использованием дипфейков — компания также выпускала короткие постановки, используя образы Джейсона Стейтема (Jason Statham) и Роберта Паттинсона (Robert Pattinson). Ставший предметом разбирательства ролик имеет пародийный и юмористический характер, он направлен на завладение вниманием аудитории, а не прямое извлечение коммерческой выгоды. После выхода рекламы глава AMG Алексей Парфун обратился в Roistat, но администрация сервиса ответила, что «продукция нейросетей авторским правом не регулируется, можно брать и использовать». В ответ создатели видео подали в суд, «чтобы разобраться в юридической практике».

Источник изображения: succo / pixabay.com Решение суда было вынесено 30 ноября 2023 года. Как гласит его мотивировочная часть, «доводы ответчика о том, что созданный видеоролик не является объектом авторского права по причине использования технологии deep-fake, отклоняются судом, поскольку технология дипфейк — это дополнительный инструмент обработки (технического монтажа) видеоматериалов, а не способ их создания». Иными словами, при создании ролика был подготовлен сценарий; произведена видеосъёмка артиста, чьё лицо было заменено на образ Киану Ривза; создано аудиосопровождение; а использованная для подмены лица нейросеть оказалась одним из использованных рабочих инструментов, установил суд. Опрошенные Forbes специалисты, в частности, отметили, что современным нейросетям пока не под силу полностью генерировать видеоролики с настолько глубокой драматургией — ИИ выступает лишь как один из многих инструментов при производстве. При этом создатели ролика должны были также заручиться разрешением Киану Ривза на использование его образа — права артиста также были потенциально нарушены. Недавно схожую претензию за несанкционированное использование своего голоса в рекламе подала актриса Скарлетт Йоханссон (Scarlett Johansson). В 2021 году российский мобильный оператор «МегаФон» показывал серию рекламных роликов с использованием образа актёра Брюса Уиллиса (Bruce Willis) — при производстве видео также использовалась технология дипфейка, о чем компания предупреждала зрителей. «МегаФон» заключил с артистом контракт, действие которого к настоящему моменту завершено. Разработана система защиты голоса от создания дипфейков

29.11.2023 [15:49],

Павел Котов

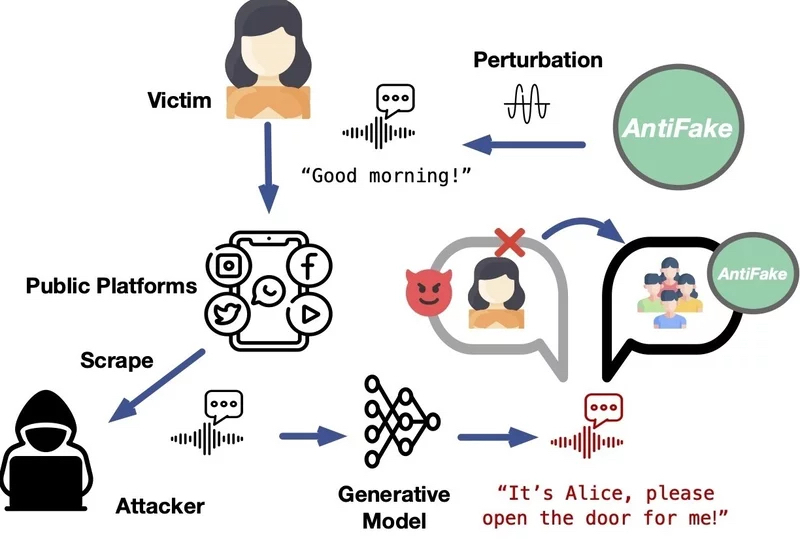

Технологии подделки голоса при помощи искусственного интеллекта являются довольно опасным инструментом — они способны правдоподобно воспроизвести человеческий голос даже по короткому образцу. Не допустить создание искусной подделки сможет предложенный американским учёным алгоритм AntiFake.

Источник изображения: Gerd Altmann / pixabay.com Дипфейки представляют собой достаточно опасное явление — с их помощью можно приписать знаменитому артисту или политику высказывание, которого он никогда не делал. Были также прецеденты, при которых злоумышленник звонил жертве и голосом друга просил срочно перевести деньги в связи с некой чрезвычайной ситуацией. Доцент кафедры компьютерных наук и инженерии Вашингтонского университета в Сент-Луисе Нин Чжан (Ning Zhang) предложил технологию, которая значительно усложняет создание голосовых дипфейков. Принцип работы алгоритма AntiFake состоит в формировании условий, при которых системе ИИ оказывается намного сложнее считывать ключевые характеристики голоса при записи разговора реального человека. «В инструменте используется техника состязательного ИИ, которая изначально применялась киберпреступниками, но теперь мы направили её против них. Мы немного искажаем записанный аудиосигнал, создавая возмущения ровно в той мере, чтобы для человека он звучал так же, а для ИИ — совершенно иначе», — прокомментировал свой проект господин Чжан.

Источник изображения: wustl.edu Это значит, что при попытке создать дипфейк на основе изменённой этим способом записи сгенерированный ИИ голос не будет похож на голос человека в образце. Как показали проведённые испытания, алгоритм AntiFake на 95 % эффективен для предотвращения синтеза убедительных дипфейков. «Что будет с голосовыми ИИ-технологиями дальше, я не знаю — новые инструменты и функции разрабатываются постоянно, — но всё же считаю, что наша стратегия использования техники противника против него самого так и останется эффективной», — заключил автор проекта. |