|

Опрос

|

реклама

Быстрый переход

Сэма Альтмана поймали за руку при попытке украсть видеокарту — это самое популярное ИИ-видео в Sora

02.10.2025 [16:06],

Павел Котов

По интернету начало гулять сгенерированное искусственным интеллектом ироничное видео, на котором генерального директора OpenAI Сэма Альтмана (Sam Altman) ловят при попытке украсть видеокарту из супермаркета. Ролик называют самым популярным на площадке OpenAI Sora на данный момент.

Источник изображения: x.com/GabrielPeterss4 В опубликованном на платформе X ролике виртуальный Альтман берет с полки видеокарту и пытается покинуть магазин, похожий на одну из точек американской сети Target, но на выходе его задерживает охранник, а глава OpenAI произносит: «Пожалуйста, она мне очень нужна для запуска Sora. Слишком уж хорошее видео». Опубликовал ролик один из сотрудников OpenAI. Видео сгенерировала модель Sora 2, и оно стало одним из самых популярных в выпущенном недавно приложении, которое сочетает средства для создания видео и некое подобие соцсети для их публикации — своего рода ИИ-аналог TikTok. Sora 2, по утверждению OpenAI, её самая точная и реалистичная модель на сегодняшний день, предлагающая широкий набор элементов управления. Есть, впрочем, и некоторые недостатки: после того как Альтман на ролике берет видеокарту с полки, соседняя коробка начинает сама по себе двигаться; да и реплика персонажа звучит несколько нелепо. Зато дефицит ИИ-ускорителей у OpenAI — проблема вполне ощутимая; ранее компании пришлось отложить выпуск модели GPT-4.5 из-за нехватки вычислительных ресурсов. К концу года она намеревается довести число имеющихся в её распоряжении ускорителей до миллиона, а конечная цель — 100 млн. Ещё один тревожный аспект — осознание, что распознавать созданные ИИ видео со временем будет всё труднее. Ролик с кражей видеокарты Сэмом Альтманом на первый взгляд смотрится вполне реалистично, и в будущем модели ИИ станут только совершенствоваться. А значит, всё острее встаёт вопрос об их надёжной маркировке. Учёные придумали невидимые для глаз световые водяные знаки для выявления дипфейков

12.08.2025 [18:48],

Сергей Сурабекянц

Поддельные видео становится всё сложнее выявлять, поэтому исследователи Корнеллского университета представили новую криминалистическую технологию, которая поможет специалистам удостовериться в подлинности видеоматериалов. Метод заключается во встраивании невидимых цифровых водяных знаков непосредственно в световой поток источников освещения, используемых при съёмке — например, на месте преступления.

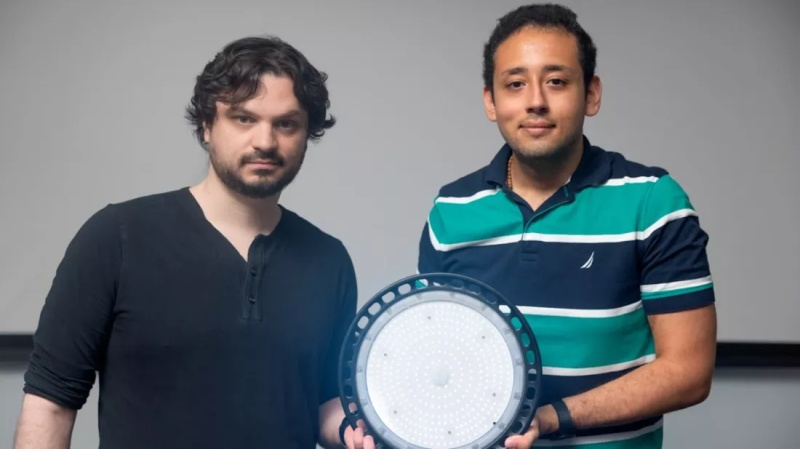

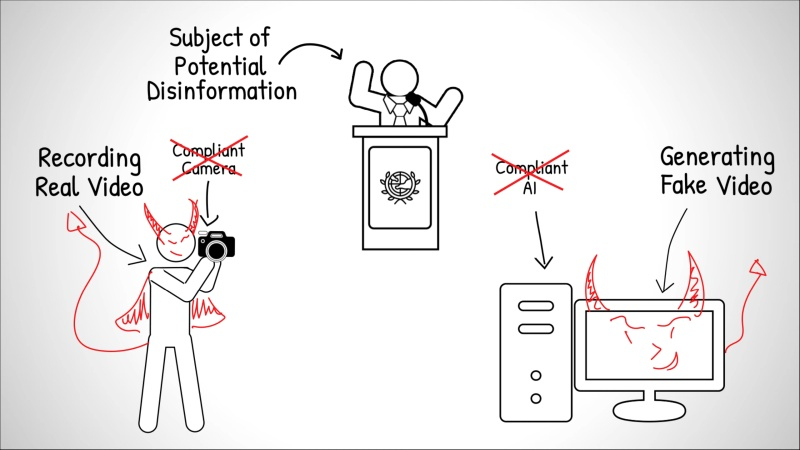

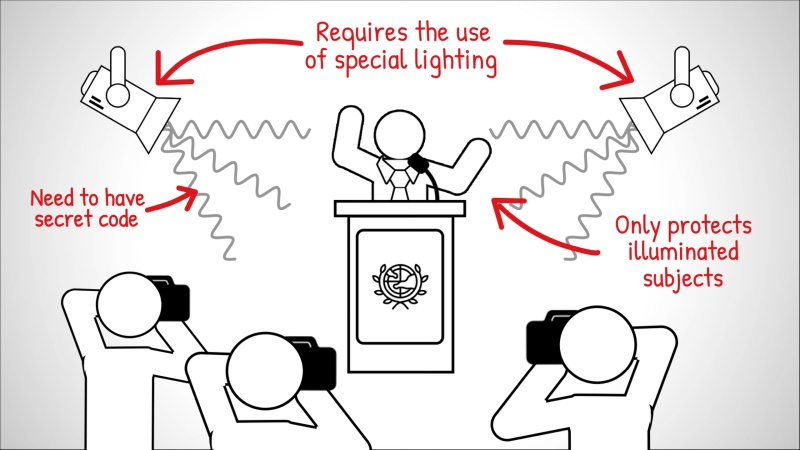

Источник изображений: Cornell University Концепция «шумокодированного освещения» была представлена 10 августа на конференции SIGGRAPH 2025 аспирантом факультета компьютерных наук Корнеллского университета Питером Майклом (Peter Michael). Впервые этот подход был предложен и разработан доцентом Эйбом Дэвисом (Abe Davis) (на фото слева).  Обычно водяные знаки встраиваются непосредственно в видеофайлы, изменяя мельчайшие элементы изображения для создания скрытого идентификатора. Такие системы достаточно эффективны в контролируемых условиях, но требуют взаимодействия с устройством или платформой, создающей видеоматериал. При использовании несовместимой камеры или программного обеспечения цифровой водяной знак просто не появится.  Разработчики предложили при записи «встраивать» водяной знак непосредственно в световой поток от источников освещения. Это гарантирует, что любая камера — от профессионального оборудования до смартфона — запечатлеет его во время съёмки сцены. В программируемые источники света, такие как компьютерные мониторы, студийное оборудование или некоторые светодиодные приборы, можно встроить кодированные шаблоны яркости с помощью ПО. Стандартные лампы также можно адаптировать, оснастив их компактным чипом размером примерно с почтовую марку, который плавно меняет интенсивность света в соответствии с секретным кодом.  Встроенный код, разработанный на основе исследований зрительного восприятия человека, состоит из минимальных изменений частоты и яркости освещения, практически незаметных невооружённому глазу и воспринимаемых мозгом как незначительный световой шум. Уникальный код каждого источника света фактически обеспечивает параллельную запись сцены с низким разрешением и временными метками, которые Дэвис называет «видеокодами». «Когда кто-то манипулирует видео, изменённые фрагменты начинают противоречить тому, что мы видим на этих видеокодах, — пояснил Дэвис. — А если кто-то попытается сгенерировать поддельное видео с помощью ИИ, полученные видеокоды будут выглядеть просто как случайные вариации освещённости». При анализе видеоматериала специалисты могут обнаружить пропущенные последовательности, вставленные объекты или изменённые сцены. Например, удалённый из интервью фрагмент отобразится как визуальный пробел в восстановленном видеокоде, а сфабрикованные элементы — как сплошные чёрные области. Исследователи показали, что в одной сцене можно использовать до трёх независимых кодов освещения. Такое наложение увеличивает сложность водяного знака и усложняет задачу потенциальных фальсификаторов. «Даже если злоумышленник знает об этой технике и сможет вычислить коды, его задача всё равно будет значительно сложнее, — добавил Дэвис. — Вместо того чтобы имитировать свет только для одного видео, ему придётся подделывать каждый ролик с кодами отдельно, и все подделки должны будут согласовываться между собой». Полевые испытания показали эффективность метода в определённых условиях и его стабильную работу при различных оттенках кожи. Исследователи отмечают, что технология шумокодированного освещения — многообещающий шаг вперёд, но не панацея от фейковых видео. По мере развития инструментов генеративного ИИ будут совершенствоваться и методы обхода средств проверки подлинности. «Раньше видео рассматривалось как источник достоверной информации, но теперь мы не можем быть в этом уверены, — считает Дэвис. — Сегодня можно сгенерировать практически любой ролик. Это интересно, но и проблематично, потому что отличить реальность от подделки становится всё сложнее». Сэм Альтман предупредил, что скоро мошенники начнут массово похищать деньги, подделывая личность с помощью ИИ

28.07.2025 [04:50],

Алексей Разин

Создатели систем искусственного интеллекта обеспокоены проблемой их неправомерного применения, и глава OpenAI Сэм Альтман (Sam Altman) не является исключением. Во время своей беседы с вице-председателем Федрезерва США Мишель Боуман (Michelle Bowman) он заявил, что скоро на нас хлынет поток высококачественных подделок не только голоса, но и внешности любого человека, которые могут быть использованы в противозаконных целях.

Источник изображения: OpenAI, Dall-E В качестве примера Альтман приводит процедуру аутентификации клиента банка при помощи голоса и кодовой фразы. Зная последнюю, злоумышленникам не составит труда сымитировать голос человека при помощи систем искусственного интеллекта, а затем отдать распоряжение о переводе денежных средств без ведома их реального собственника. «ИИ полностью освоил все методы аутентификации, которые люди сейчас используют, кроме паролей. Сейчас это может быть голосовой вызов, вскоре это будет видео или видеозвонок, которые будут неотличимы от настоящих», — пояснил свою обеспокоенность Сэм Альтман. Подделка голоса уже давно используется мошенниками для манипуляций своими жертвами, искусственный интеллект просто даёт им более простой и эффективный инструмент, который доступен буквально каждому. Постепенно осваивается и направление видеозвонков, в которых имитируется нужный образ, но подменяется содержание разговора. Жертвами подобных преступлений уже становятся известные личности, включая политиков и чиновников. OpenAI не так много делает для предотвращения подобных злоупотреблений, хотя и пытается разработать более надёжные способы биометрической аутентификации. Так или иначе, Альтман убеждён, что скоро в руки мошенников попадут программные средства, позволяющие поставить фальсификацию личности на поток. Конец цифрового насилия: Трамп ввёл уголовную ответственность за интимные дипфейки

20.05.2025 [13:22],

Павел Котов

Президент США Дональд Трамп (Donald Trump) подписал «Закон о немедленном удалении материалов» (Take It Down Act), который переводит в разряд уголовных преступлений распространение несогласованных с объектом изображений деликатного характера, в том числе созданных с помощью искусственного интеллекта подделок (дипфейков). Закон требует, чтобы администрации соцсетей немедленно удаляли такие материалы при поступлении соответствующих запросов.

Источник изображения: Donghun Shin / unsplash.com Законопроект утвердили обе палаты Конгресса; в его поддержку высказались несколько технологических компаний, защитники прав молодёжи и родителей, а также первая леди Мелания Трамп (Melania Trump). Есть, впрочем и мнение, что утверждённый в документе подход может иметь обратный эффект и навредить тем, кого призван защищать. Закон переводит в разряд уголовных преступлений публикацию изображений деликатного характера, в том числе дипфейков, без согласия лиц, которые в этих материалах представлены, — он предусматривает наказание до трёх лет лишений свободы плюс штрафы. Администрациям социальных сетей предписывается в течение 48 часов с момента получения соответствующего уведомления удалять все такие материалы и «прилагать разумные усилия» для удаления копий таких материалов. Правозащитники, в том числе некоммерческие организации Electronic Frontier Foundation (EFF) и Center for Democracy and Technology (CDT), однако, предупреждают, что положение о запрете контента может использоваться, чтобы принуждать ответственных лиц удалять более широкий спектр материалов, чем предполагается; не исключается также угроза для технологий защиты конфиденциальности, в том числе средств шифрования — операторы соответствующих платформ не видят и не имеют возможности удалять сообщения между пользователями. Не исключаются и другие злоупотребления, в том числе избирательное отношение Федеральной торговой комиссии (FTC) к соблюдению требований закона. Введение новых норм в практику правоприменения займёт около года, считают эксперты. Исследование Honor: из-за распространения дипфейков работодатели изменят способ проведения онлайн-собеседований

17.04.2025 [01:00],

Владимир Мироненко

Поступивший в продажу в России в апреле смартфон Honor Magic 7 получил поддержку целого ряда ИИ-технологий, включая функцию распознавания дипфейков для защиты от новых видов мошенничества при видеозвонках. Согласно исследованию Honor, приуроченному к выходу смартфона Magic 7, распространение дипфейков может отразиться на процессе найма специалистов на работу, собеседование с которыми, как правило, проводится в онлайн-режиме.  В ходе опроса, проведенного Honor, выяснилось, что 81,5 % респондентов готовы делегировать искусственному интеллекту (ИИ) стрессовые задачи, а 22,7 % хотели бы делегировать искусственному интеллекту прохождение собеседований за них. Что также интересно, 1,1 % участников опроса признались, что сами создают дипфейки.  ИИ-технология, встроенная в серию смартфонов Magic 7, позволяет пользователям определять, было ли фото или видео изменено или полностью создано с помощью ИИ. Распространение дипфейков обеспокоило рекрутеров. По словам Дарьи Барковой, HR-профайлера и предпринимателя IT-рекрутингового агентства Unicorn Search, технологии дипфейков и использование ИИ-инструментов, позволяющих имитировать человека на собеседовании, ставят под сомнение достоверность результатов найма. «Кандидат может полностью заменить себя на этапе оценки, превращая цифровые каналы рекрутинга из инструмента удобства в зону уязвимости. Стандартизированные вопросы и типовые кейсы теряют актуальность — их слишком легко автоматизировать», — говорит Баркова. Она подчеркнула, что будущее — за динамичными форматами с живым взаимодействием, позволяющим определить способность кандидата на вакансию к адаптации в реальном времени и проверить индивидуальную реакцию на нестандартные условия. Анна Осипова, руководитель внешних коммуникаций hh.ru в регионах, подтвердила актуальность проблемы дипфейков. Она отметила, что случаи использования технологий дипфейков для прохождения онлайн-собеседований пока единичны, но по мере развития технологий риски их использования могут стать довольно ощутимыми, и компаниям уже сегодня необходимо подумать о мерах противодействия. «Как минимум, важно проводить более тщательный первичный скрининг кандидата, не пренебрегать проверкой через внутреннюю службу безопасности. Во время онлайн-собеседований стоит обращать внимание на качество и “естественность” видео, манеру речи», — отметила она. По мнению экспертов, уже в ближайшее время компании будут вынуждены изменить методы подбора персонала, используя новые способы проверки личности кандидатов и подлинности видео во время онлайн-собеседований. «Сбер» предсказал всплеск ИИ-мошенничества, к которому никто не готов, к середине этого года

04.03.2025 [22:43],

Дмитрий Федоров

Мошенники в 2025 году начнут активно использовать ИИ для создания дипфейков, подделки голоса и телефонных звонков на разных языках. По оценке «Сбера», финансовые институты недостаточно подготовлены к подобным угрозам, что может привести к увеличению финансовых потерь среди рядовых граждан. Банкам и государственным структурам необходима срочная модернизация систем безопасности для предотвращения таких преступлений.

Источник изображения: Wesley Tingey / Unsplash Согласно прогнозу «Сбера», уже к середине 2025 года мошенники начнут активно применять технологии генеративного ИИ для создания реалистичных подделок изображений, видеозаписей и голосов. Эти методы уже используются при создании фишинговых сайтов, но вскоре выйдут на новый уровень. «Мы прогнозируем, что примерно к середине года появятся дипфейки», — заявил заместитель председателя правления «Сбера» Станислав Кузнецов. Особенно серьёзной угрозой, связанной с развитием ИИ, станет преодоление языкового барьера в телефонном мошенничестве. Кузнецов отметил, что в ближайшие три-четыре месяца злоумышленники начнут активно применять технологии генерации речи на различных языках. «Как только модели позволяют нам сегодня преодолеть последнюю границу — языковой барьер, как только нажатием одной кнопки можно звонить в любую страну или разговаривать на любом языке, следует задуматься о том, что телефонное мошенничество появится и на башкирском, и на татарском языках», — подчеркнул он. Согласно данным, представленным Кузнецовым, 81 % мошеннических звонков совершается через мессенджеры, sim-box и облачные АТС. Оставшиеся 19 % приходятся на классические телефонные звонки, причём лишь 1 % осуществляется с подменой номера. Это означает, что основная угроза исходит именно от мессенджеров, а не от традиционной телефонии. По данным Центрального банка России (ЦБ), в 2024 году мошенники похитили у клиентов банков 27,5 млрд руб., принуждая их совершать денежные переводы. Основной инструмент преступников — методы социальной инженерии, основанные на обмане и манипуляции жертвами. Банк России направил операторам связи почти 172 тысячи номеров, использовавшихся злоумышленниками, что подчёркивает масштаб проблемы. Несмотря на снижение числа мошеннических звонков через традиционную телефонную связь, преступники продолжают активно применять мессенджеры не только для звонков, но и для рассылки вредоносного программного обеспечения (ПО) и поддельных документов. ООН рассказала об использовании Telegram преступными сетями из Юго-Восточной Азии

07.10.2024 [20:02],

Сергей Сурабекянц

Представитель ООН заявил, что в Telegram открыто и в огромных масштабах продаются похищенные данные, а также доступны инструменты для киберпреступников и услуги по отмыванию денег. В недавно опубликованном докладе ООН утверждается, что преступные группировки Юго-Восточной Азии широко используют приложение, что позволяет им вести крупномасштабную незаконную деятельность.

Источник изображения: Pixabay В отчёте Управления ООН по наркотикам и преступности (УНП ООН) говорится, что в Telegram широко продаются похищенные персональные данные, что авторы отчёта связывают со слабой модерацией в приложении. Широко доступны также инструменты, используемые киберпреступниками, включая программное обеспечение для создания дипфейков и вредоносное ПО для кражи данных, а нелицензированные криптовалютные биржи предлагают в Telegram услуги по отмыванию денег. Юго-Восточная Азия стала крупным центром многомиллиардной криминальной индустрии, которая использует мошеннические схемы для поиска жертв по всему миру. По данным УНП ООН, отрасль ежегодно генерирует от 27,4 до 36,5 млрд долларов. В качестве примера цитируется рекламное объявление на китайском языке: «Мы ежедневно переводим 3 миллиона долларов США, украденных из-за рубежа». В докладе идёт речь о китайских преступных синдикатах, замешанных в торговле людьми и использовании рабского труда. «Есть убедительные доказательства того, что подпольные рынки данных перемещаются в Telegram, а поставщики активно ищут цели для транснациональных организованных преступных группировок, базирующихся в Юго-Восточной Азии», — говорится в отчёте. В августе в Париже создателю и главе мессенджера Павлу Дурову были предъявлены обвинения по шести пунктам, в том числе в отказе от сотрудничества. Самый тяжкий пункт — соучастие в администрировании онлайн-платформы для совершения незаконных транзакций. За это Дурову грозит наказание до десяти лет лишения свободы и штраф до €500 тыс. Поводом для ареста Дурова стал отказ администрации мессенджера от сотрудничества с властями Евросоюза, а политика модерации давно вызывала критику у властей. Париж также оказался разочарован отказом платформы сотрудничать конкретно с французскими властями. После ареста Дуров заявил, что приложение станет передавать IP-адреса и номера телефонов пользователей властям, подающим официальные юридические запросы. Он также пообещал, что будут удалены некоторые функции, которые использовались для незаконной деятельности. Арест Дурова привлёк внимание к ответственности поставщиков приложений, а также вызвал дебаты о том, где заканчивается свобода слова и начинается исполнение закона. В отчёте УГП ООН говорится, что размах деятельности преступных группировок в регионе привёл к внедрению ими инноваций и новых бизнес-моделей и технологий, включая вредоносное ПО, генеративный ИИ и дипфейки. Заместитель представителя УНП ООН Бенедикт Хофман (Benedikt Hofmann) заявил, что приложение является удобной средой для преступников. «Для потребителей это означает, что их данные подвергаются большему риску попасть к мошенникам или в другую преступную схему, чем когда-либо прежде», — считает он. По словам Хофмана, УНП ООН выявило более 10 поставщиков услуг программного обеспечения для создания дипфейков, «специально нацеленных на преступные группы, занимающиеся кибермошенничеством в Юго-Восточной Азии». В настоящее время регулирующие органы Южной Кореи проводят расследование о причастности мессенджера Telegram к распространению дипфейков сексуального содержания из-за недостаточной модерации. Сообщается, что в Telegram есть каналы с более чем 200 000 подписчиков, где распространяется такой контент. В прошлом месяце агентство Reuters сообщило, что чат-боты Telegram использовались для кражи данных из ведущей индийской страховой компании Star Health, что побудило страховую компанию подать в суд на онлайн-платформу. К преступникам могли попасть документы по страхованию и претензиям, содержащие имена, номера телефонов, адреса, налоговые реквизиты, копии удостоверений личности, результаты анализов и медицинские диагнозы. Напомним, что бот для передачи информации о нарушениях правил мессенджера Telegram заработал в России с 23 сентября. Южная Корея ввела уголовную ответственность за просмотр, хранение и распространение сексуальных дипфейков

27.09.2024 [18:14],

Сергей Сурабекянц

26 сентября южнокорейский парламент принял законопроект, предусматривающий уголовную ответственность за распространение, хранение и просмотр видео или изображений, содержащих дипфейки откровенно сексуального характера. За просмотр и хранение такого контента закон предусматривает наказание в виде тюремного заключения на срок до трёх лет или штрафа до 30 млн вон ($22,6 тыс.), а за создание подобных дипфейков грозит заключение сроком до пяти лет или штраф.

Источник изображения: Pixabay Только в этом году южнокорейская полиция получила более 800 заявлений о создании дипфейков сексуального содержания. В частности, регулирующие органы Южной Кореи проводят расследование о причастности мессенджера Telegram к распространению такого контента из-за недостаточной модерации. Сообщается, что в Telegram есть каналы с более чем 200 000 подписчиков, где распространяется такой контент. Чтобы нынешний закон вступил в силу, его должен подписать президент Южной Кореи Юн Сок Ель. Российские законодатели также на днях предложили добавить ответственность за дипфейки в Уголовный кодекс — в Госдуму внесён законопроект, предлагающий признать использование дипфейков отягощающим обстоятельством при мошенничестве и клевете. YouTube больше не станет терпеть дипфейки и ИИ-плагиат

06.09.2024 [07:46],

Анжелла Марина

YouTube сказал твёрдое «нет» дипфейкам и ИИ-плагиату, защищая права авторов на платформе. По данным The Verge, компания начинает разработку новых инструментов, которые дадут создателям контента больше контроля над использованием их голоса и образа, сгенерированного искусственным интеллектом.

Источник изображения: convertcrypto.ru Первый инструмент, получивший название «технология идентификации синтезированного пения», позволит артистам и авторам автоматически распознавать и управлять контентом YouTube, в котором их голоса имитируются с помощью искусственного интеллекта. Эта технология будет интегрирована в существующую систему идентификации авторских прав Content ID и запущена в рамках пилотной программы в следующем году. Решение YouTube связано с растущим беспокойством в музыкальной индустрии по поводу использования ИИ для создания копий песен и голосов артистов. В открытом письме, опубликованном ранее в этом году, более 200 артистов, включая Билли Айлиш (Billie Eilish), Pearl Jam (Pearl Jam) и Кэти Перри (Katy Perry), назвали несанкционированное ИИ-копирование «посягательством на человеческий творческий потенциал» и потребовали от видеохостинга большей ответственности в этом отношении. Помимо защиты голосов, YouTube на своей платформе также разрабатывает инструмент для выявления дипфейков лиц и образов авторов, актёров, музыкантов и спортсменов. Однако система ещё находится в разработке и не сообщается, когда она будет запущена. В дополнение к этому, YouTube обещает бороться с теми, кто собирает данные с платформы для обучения ИИ-моделей. «Мы ясно дали понять, что несанкционированный доступ к контенту авторов нарушает наши условия обслуживания», — заявили представители YouTube. Однако это не помешало таким компаниям, как OpenAI, Apple, Anthropic, Nvidia, Salesforce и Runway AI, обучать свои ИИ-системы на тысячах скачанных с YouTube видео. Для защиты контента от ботов-сканеров YouTube планирует блокировать им доступ полностью и для этого начнёт инвестировать в систему обнаружения сбора данных. Также заявляется, что разрабатываются способы предоставления авторам больше возможностей в отношении того, как сторонние компании, занимающиеся ИИ, всё же смогли бы использовать их контент на платформе, очевидно делясь заработками. Более подробная информация об этом выйдет позднее в этом году. Политические дипфейки оказались самой популярным направлением в злоупотреблениях ИИ

26.06.2024 [00:26],

Анжелла Марина

Исследование Google DeepMind выявило, что злоупотребления искусственным интеллектом (ИИ) в форме дипфейков — реалистичных поддельных изображений политиков и знаменитостей или их видео и аудио — намного превосходят использование ИИ для кибератак.

Источник изображения: Kandinsky Согласно анализу, проведённому совместно с исследовательским подразделением группы Jigsaw, наиболее распространённой целью злоупотреблений генеративным ИИ стало формирование общественного мнения или влияние на него, что составило 27 % всех случаев использования искусственного интеллекта, сообщает Ars Technica. Такие данные вызывают у экспертов серьёзные опасения по поводу влияния дипфейков на предстоящие во многих странах мира выборы в 2024 году. Отмечается, что в последние месяцы в социальных сетях, таких как TikTok, X и Instagram✴, появились дипфейки премьер-министра Великобритании Риши Сунака (Rishi Sunak) и других мировых лидеров. Избиратели Великобритании пойдут на всеобщие выборы уже на следующей неделе, и существует обеспокоенность тем, что, несмотря на усилия платформ социальных сетей по маркировке или удалению такого контента, аудитория может не распознать его как фейк, что потенциально повлияет на решения избирателей. Арди Янжева (Ardi Janjeva), научный сотрудник Института Алана Тьюринга (The Alan Turing Institute), отмечает, что распространение контента, созданного ИИ, может «искажать наше коллективное понимание социально-политической реальности», что представляет долгосрочные риски для демократических процессов, даже если прямое влияние на поведение избирателей пока не доказано. По мере роста популярности генеративных ИИ-продуктов, таких как ChatGPT от OpenAI и Gemini от Google, компании, разрабатывающие ИИ, начинают более пристально следить за потенциально вредным или неэтичным контентом, создаваемым их инструментами. Например, в мае OpenAI опубликовала исследование, показавшее использование их инструментов для создания и распространения дезинформации, связанное с Россией, Китаем, Ираном и Израилем. Второй по распространённости мотивацией злоупотреблений стало получение финансовой выгоды, например, через предложение услуг по созданию дипфейков, включая создание изображений реальных людей, или использование генеративного ИИ для создания фейковых новостных статей. Исследование показало, что в большинстве инцидентов используются легкодоступные инструменты, не требующие глубоких технических знаний, что в свою очередь только может увеличивать рост числа злоумышленников в среде ИИ. Одновременно результаты исследования Google DeepMind повлияют на действия ИИ-компаний для проверки моделей на безопасность и оценку не только пользы, но и потенциального вреда от использования генеративного ИИ. Поддельный Илон Маск продвигает мошеннические схемы с криптовалютой на YouTube Live

24.06.2024 [19:26],

Сергей Сурабекянц

Голос Илона Маска (Elon Musk), сгенерированный искусственным интеллектом, в сегодняшней прямой трансляции посоветовал зрителям разместить криптовалюту на сомнительном сайте. В пятичасовом эфире на YouTube Live был показан фрагмент видеоряда с мероприятия Tesla, где Маск якобы призывает зрителей внести криптовалюту, чтобы принять участие в розыгрыше. Всем участникам был обещан автоматический возврат внесённой суммы в двойном размере.

Источник изображений: Engadget В какой-то момент трансляцию одновременно смотрели более 30 000 зрителей (не исключена накрутка ботами), что подняло её на вершину рекомендаций YouTube Live Now. Учётная запись @elon.teslastream, имела значок подтверждённого официального канала, что может говорить о взломе учётной записи. Через некоторое время и видео, и канал были удалены. Число подобных дипфейковых мошенничеств от лица Маска резко возросло за последние месяцы. В каждом случае преступники используют учётную запись якобы одной из компаний Маска. Сегодняшнее видео имело подзаголовок «Tesla представляет шедевр: Tesla, которая навсегда изменит автомобильную промышленность». В начале июня, во время запуска Starship, сообщалось об аналогичных мошенничествах, проводимых 35 аккаунтами от лица SpaceX. Криптовалютные преступления, нацеленные на последователей Маска в социальных сетях, уже много лет является проблемой, как и мошенничество с участием знаменитостей в целом. 21 июня были одновременно взломаны сайт и аккаунт в социальной сети X рэпера 50 Cent. Точная сумма ущерба неясна, по слухам, преступники украли мемкойн GUNIT на сумму около $3 млн. Государство получит право использовать голоса россиян после их смерти без согласия родственников

31.05.2024 [13:00],

Павел Котов

Голоса россиян будут защищены от неправомерного использования — это регламентирует проект закона «Об охране голоса», разработанный Альянсом в сфере ИИ и Национальной федерацией музыкальной индустрии (НФМИ). Вместе с тем государство получит право использовать в общественных интересах голос гражданина после его смерти без согласия родственников. Об этом сообщили «Ведомости» со ссылкой на заявление члена Совета Федерации по конституционному законодательству и госстроительству Артёма Шейкина, а также разработчиков документа.

Источник изображения: Soundtrap / unsplash.com Законопроект предусматривает внесение изменений в Гражданский кодекс (ГК). В общем случае для обнародования и дальнейшего использования голоса гражданина требуется его согласие; после его смерти согласие необходимо получать у супруга, детей или родителей. Но если голос предполагается использовать в государственных или общественных интересах, то такое согласие не требуется — при условии, что голос записывался за плату или в публичных местах. Документ описывает механизм правовой защиты голоса от неправомерного использования и создания дипфейков на основе его записей. В рамках работы секции «Искусственный интеллект» Совета по развитию цифровой экономики при Совете Федерации анализировались предложения экспертов и профильных ведомств по определению дипфейка. «Сейчас мы находимся на завершающем этапе проработки этого определения, которое будет закреплено в законопроекте», — сообщил господин Шейкин. Уже готовится итоговая версия законопроекта — после получения отзыва от правительства он будет внесён в Госдуму.

Источник изображения: Studio_Iris / pixabay.com «Если голос гражданина, воссозданный с помощью специальных технологий, получен или используется в интернете с нарушением закона, гражданин вправе требовать удаления этой записи, а также пресечения или запрещения её дальнейшего использования и распространения», — считает Артём Шейкин. Нарушения ГК предусматривают последствия в виде возмещения убытков и вреда, выплат неустойки, приостановления или прекращения определённой деятельности, возврата неосновательного обогащения и другие меры. Российское законодательство в существующем виде охраняет лишь фотографическое изображение человека, а нормы, которые защищают артистов и дикторов от использования их синтезированных голосов и цифровых образов, пока отсутствуют, отметили в НФМИ. Речевые особенности человека не охраняются правом ни в одной стране мира, отмечают опрошенные «Ведомостями» эксперты, хотя в России действуют законы «О персональных данных» и «О биометрических данных», которые требуют обрабатывать данные, включая голос, лишь с согласия человека. Принятие нового закона сформирует базу для разрешения споров в области прав на голос — к примеру, до сих пор нет ясности, кому принадлежит воспроизведённый нейросетью голос человека: ему самому или разработчику этой нейросети. Так, американская актриса Скарлетт Йоханссон (Scarlett Johansson) уже минимум дважды была вынуждена отстаивать право на собственный голос. Сейчас также распространилась мошенническая схема с использованием сгенерированных голосовых записей, призванных убедить жертву перевести деньги злоумышленникам. Предложенный законопроект конкретных мер ответственности за неправомерное использование голоса не предусматривает, но есть и другой, который предусматривает внесение поправок уже в Уголовный кодекс РФ — он также ещё не внесён в Госдуму. McAfee продемонстрировала детектор звуковых дипфейков

09.05.2024 [15:08],

Павел Котов

На мероприятии RSA Conference компания McAfee продемонстрировала систему Deepfake Detector, работа над которой ведётся при участии Intel. Система, первоначально называвшаяся Project Mockingbird, предназначена для обнаружения звуковых дипфейков — аудиоподделок, созданных при помощи искусственного интеллекта.

Источник изображения: S. Keller / pixabay.com Технический директор McAfee Стив Гробман (Steve Grobman) показал работу Deepfake Detector на примере двух видеороликов — показ видео сопровождается информацией от ИИ-детектора, которая выводится в строке состояния. При запуске видеоролика, не подвергавшегося обработке, система показала нулевую вероятность подделки. Далее было запущено явно фейковое видео, на которое система сразу отреагировала показателем в 60 %, и по мере просмотра вероятность выросла до 95 %. С момента первой демонстрации на CES 2024 инженеры McAfee оптимизировали систему для работы с ИИ-ускорителями Intel NPU на чипах Meteor Lake, что позволило увеличить производительность на 300 %. Можно запускать несколько процессов Deepfake Detector для одновременного анализа нескольких видеороликов; хотя и видеозаписями возможности системы не ограничиваются — она может анализировать звук любого приложения в системе. А локальный режим её работы вместо запуска из облака означает высокую конфиденциальность — анализируемые данные не покидают компьютера. Авторы проекта преднамеренно ограничились работой со звуком: специалисты McAfee по борьбе с угрозами обнаружили, что во многих публикуемых мошенниками видеороликах используется настоящее видео с поддельным звуком. Фальшивый звук сопровождает и поддельное видео, а значит, постоянной величиной чаще всего оказывается подделка аудио. Сейчас компания работает над адаптацией технологии для потребителей — для этого управление программой будет необходимо сделать предельно простым и понятным. Мошенники с помощью голосового дипфейка пытались выдать себя за гендира LastPass

12.04.2024 [19:39],

Сергей Сурабекянц

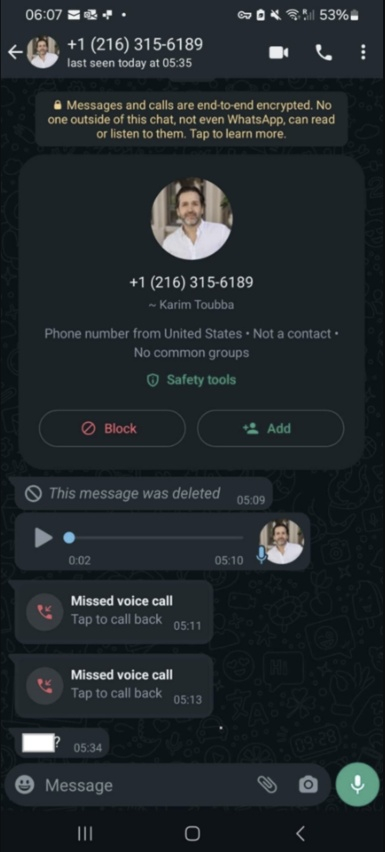

Менеджер паролей LastPass подвергся атаке мошенников, которые применили технологии искусственного интеллекта, пытаясь выдать себя за генерального директора LastPass Карима Туббу (Karim Toubba). Злоумышленники создали поддельную учётную запись Туббы в WhatsApp и начали переписку с одним из сотрудников компании. В процессе они отправляли голосовые сообщения, в которых имитировали голос руководителя Last Pass.

Источник изображения: insider.com Подвергшийся атаке сотрудник LastPass оказался достаточно опытным и стрессоустойчивым, поэтому попытка обмана силами дипфейка не удалась. Сотрудника насторожило то, что сообщения WhatsApp «выходили за пределы обычных каналов делового общения». Дополнительным поводом усомниться в реальности аудиосообщения от руководителя стало излишнее давление со стороны мошенников, тактика под названием «вынужденная срочность», которую преступники часто используют для манипулирования жертвами. Это окончательно убедило сотрудника LastPass, что вся переписка была фикцией.  LastPass сообщила, что попытка мошенничества не увенчалась успехом и сейчас расследованием инцидента занимается служба безопасности компании. Тем не менее, компания решила поделиться подробностями этого инцидента, чтобы привлечь внимание к тому, что дипфейки всё чаще используются для мошеннических кампаний с выдачей себя за руководителей. За последнее время многие компании, в том числе криптовалютная биржа Binance, столкнулись с мошенниками, выдающими себя за руководителей компаний при помощи искусственного интеллекта. Недавно в Гонконге занятый в финансовой сфере сотрудник международной компании, думая, что участвует в сеансе одновременной видеосвязи со своими коллегами, по указанию «финансового директора предприятия из Великобритании» перевёл $25,6 млн на указанный ему счёт. С 8 февраля 2024 года в США коммерческим компаниям запретили использовать голосовых ИИ-ботов в ходе автоматизированных «холодных звонков» потенциальным клиентам. Компания отдала мошенникам $25,6 млн после видеоконференции с дипфейками

05.02.2024 [18:19],

Владимир Мироненко

Транснациональная компания потеряла 200 млн гонконгских долларов ($26 млн) из-за мошенников, использовавших технологию дипфейка на новом уровне. Злоумышленникам удалось убедить сотрудника офиса компании в Гонконге перечислить указанную сумму с помощью фальшивого группового видеозвонка, в котором с помощью дипфейка участвовали поддельный финансовый директор и несколько сотрудников компании.

Источник изображения: Pixabay Полиция отметила, что это было первое дело такого рода для Гонконга, причём касающееся крупной суммы. По словам исполняющего обязанности старшего суперинтенданта Криминального бюро Барона Чана Шунь-цзина (Baron Chan Shun-ching), в предыдущих случаях мошенники обманывали жертв с помощью видеозвонков один на один. «В этот раз в ходе видеоконференции с участием нескольких человек все, кого можно было увидеть, оказались фальшивками», — сообщил он, добавив, что мошенникам удалось создать убедительные изображения целевых лиц, которые выглядели и звучали как настоящие люди. Сотрудник финансового отдела филиала компании сообщил полиции, что в середине января получил фишинговое сообщение, по-видимому, от финансового директора компании из Великобритании, в котором говорилось, что необходимо провести секретную транзакцию. Поначалу это вызвало у него сомнения, которые развеяла проведённая мошенниками групповая видеоконференция, на которой он увидел финансового директора, а также других сотрудников компании. По словам потерпевшего, сотрудники компании, участвовавшие в телефонной конференции, выглядели и говорили как настоящие люди. Затем мошенники поддерживали связь с жертвой через платформы обмена мгновенными сообщениями, электронную почту и видеозвонки один на один. В результате он, следуя указаниям фейкового руководителя, выполнил 15 переводов на общую сумму 200 млн гонконгских долларов на пять банковских счетов в Гонконге. Спустя неделю сотрудник начал подозревать неладное и обратился в головной офис компании. В результате проведённого расследования полиция установила, что участники видеоконференции были воссозданы в цифровом виде мошенниками, которые использовали общедоступные видео- и аудиозаписи этих лиц. «Они использовали технологию дипфейка, чтобы имитировать голос своих жертв, читающих текст», — отметил Чан. Он сообщил, что мошенники пытались найти подход к ещё несколькими сотрудникам компании из других филиалов, но отказался предоставить подробности обстоятельств дела. Расследование этого дела всё ещё продолжается. Старший инспектор Тайлер Чан Чи-Винг (Tyler Chan Chi-wing) сообщил, что существует несколько способов проверить, является ли человек, появившийся на экране, фальшивым цифровым фейком. Он предложил попросить собеседника делать движения головой, а также задавать вопросы, которые позволили бы определить подлинность персонажа, и сразу проявлять бдительность если тот попросит перечислить деньги. Полиция сообщила, что расширит свою систему оповещения, включив в неё систему быстрых платежей, чтобы предупреждать пользователей о том, что они переводят деньги на счета, связанные с мошенничеством. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |