|

Опрос

|

реклама

Быстрый переход

Приватные диалоги с ChatGPT попали в поиск Google, и пользователи сами в этом виноваты

01.08.2025 [10:15],

Анжелла Марина

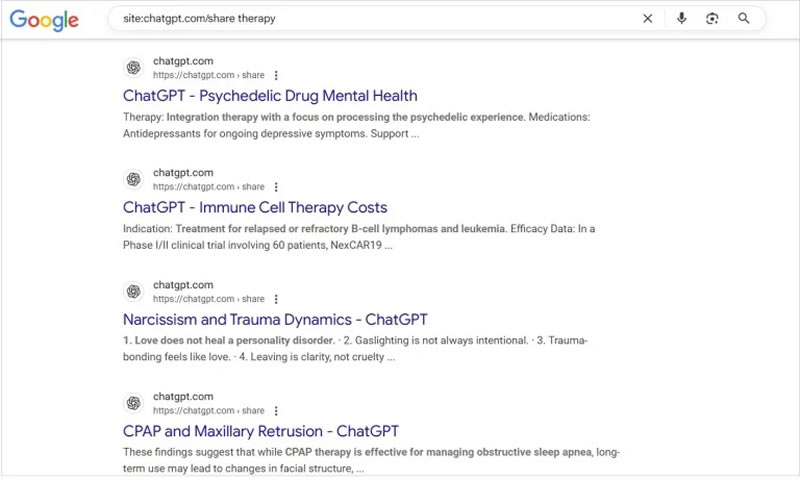

Многие пользователи ChatGPT по незнанию превратили свою приватную переписку с ботом в публичную. Их диалоги стали доступны в поисковых системах, включая Google, Bing и DuckDuckGo, по запросу site:chatgpt.com/share, сообщает PCMag. чтобы увидеть тысячи открытых диалогов, начиная от признаний в одиночестве и заканчивая вопросами о теории заговора.

Источник изображения: Arkan Perdana / Unsplash Все эти беседы оказались в открытом доступе из-за функции, запущенной OpenAI в мае 2023 года, которая позволяет делиться ссылками на конкретные чаты. При общении с чат-ботом ChatGPT можно нажать на кнопку «Поделиться», после чего возникает диалог работы со ссылкой. Там есть галочка «Сделать этот чат доступным для обнаружения»: По умолчанию она не стоит, но, если её поставить и затем нажать «Копировать ссылку», всё содержимое диалога с нейросетью окажется проиндексированным Google, Bing, DuckDuckGo и, вероятно, другими поисковиками. При этом создание публичной ссылки не раскрывает имени пользователя или данные аккаунта. Но если в диалоге упоминаются конкретные имена, места или детали, переписку можно легко идентифицировать. Представители Google пояснили, что поисковые системы не инициируют индексацию этих страниц — ответственность за публикацию лежит на OpenAI. Пользователи могут в любой момент отредактировать или удалить общедоступные ссылки, а при удалении аккаунта все связанные чаты также исчезают. Однако до этого момента информация остаётся в интернете.

Источник изображения: pcmag.com Ранее TechCrunch сообщал, что глава OpenAI Сэм Альтман (Sam Altman) недавно отметил, что люди рассказывают ChatGPT о самых сокровенных вещах в жизни, особенно молодёжь, которая использует ИИ как терапевта или консультанта для решения личных и эмоциональных проблем. При этом OpenAI юридически обязана сохранять переписки и предоставлять их по запросу в рамках судебных разбирательств. Одновременно некоторые пользователи Reddit отмечают, что доступ к открытым чатам стал «золотой жилой» для специалистов по SEO, поскольку в них отражены реальные вопросы аудитории. Аналогичные проблемы с приватностью ранее возникали у Meta✴: в июне стало известно, что общие чаты с их ИИ попадали в ленту Discover, после чего компания добавила предупреждение перед публикацией. В феврале 2024 года после переименования Bard в Gemini пользователи также обнаружили, что чаты с сервисом появляются в поиске Google через параметр site:gemini.google.com/share, однако сейчас по этому запросу результатов не выдаётся. Также наблюдаются совпадения между ответами ChatGPT и результатами поиска Google, включая AI Overview (ИИ-сводки), что породило предположения о том, что ChatGPT может использовать данные из поисковой выдачи. На момент написания материала Google перестал выдавать списки диалогов по запросу site:chatgpt.com/share. ИИ-приложения захватили смартфоны и удвоили выручку — ChatGPT уже дышит в затылок Google

30.07.2025 [19:31],

Сергей Сурабекянц

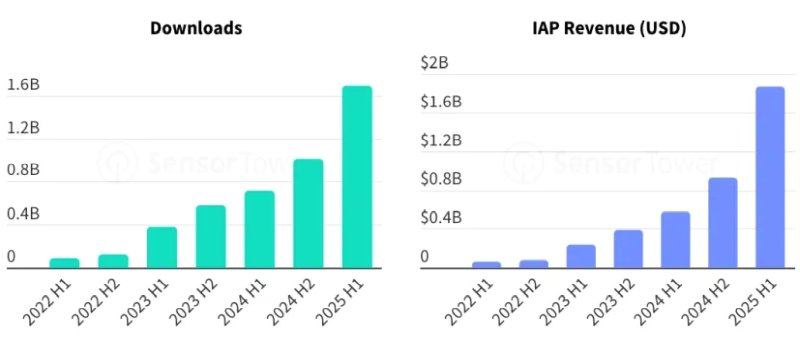

Согласно отчёту аналитической компании Sensor Tower, приложения генеративного ИИ (ПГИИ) продемонстрировали значительный рост как по количеству загрузок, так и по доходу от продаж в приложениях в первой половине 2025 года. В своём отчёте компания сообщила, что термин «ИИ» теперь встречается более 100 000 раз в описаниях приложений как в App Store, так и в Google Play. ChatGPT остаётся бессменным лидером по популярности среди пользователей и почти догнал Google.

Источник изображений: unsplash.com Количество загрузок ПГИИ достигло 1,7 млрд по сравнению с 1 млрд во второй половине 2024 года. Доход от продаж в этих приложениях вырос с $932 млн во второй половине 2024 года до $1,87 млрд в первой половине 2025 года. Пользователи провели в ПГИИ более 15,6 млрд часов в первой половине 2025 года, что почти вдвое превышает 8,5 млрд часов во второй половине 2024 года. За последние шесть месяцев было зафиксировано более 426 млрд сеансов обращения к ИИ.

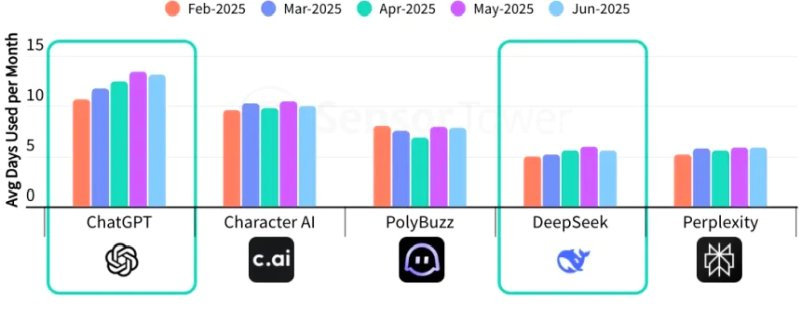

Источник изображения: Sensor Tower Самым быстрорастущим рынком ПГИИ стала Азия с долей рынка 42,6 % благодаря таким странам, как Индия и материковый Китай. Рост загрузок ПГИИ в Азии в первом полугодии 2025 года составил 80 %, по сравнению с 51 % в Европе и 39 % в Северной Америке. В Латинской Америке был зарегистрирован самый высокий рост количества покупок внутри ПГИИ, но Северная Америка по-прежнему удерживает лидерство с долей 40 %. По данным Sensor Tower, ChatGPT стал лидером по доходу от продаж внутри приложений во всех странах, кроме Китая. Однако китайский Deepseek показал лучшие результаты по количеству загрузок в течение нескольких недель после запуска. Пользователи также стали чаще обращаться к ИИ-помощникам, лидером среди которых остаётся ChatGPT. В первом полугодии пользователи использовали ChatGPT в среднем более 12 дней в месяц. Среди других популярных ПГИИ — Character AI, PolyBuzz, DeepSeek и Perplexity.

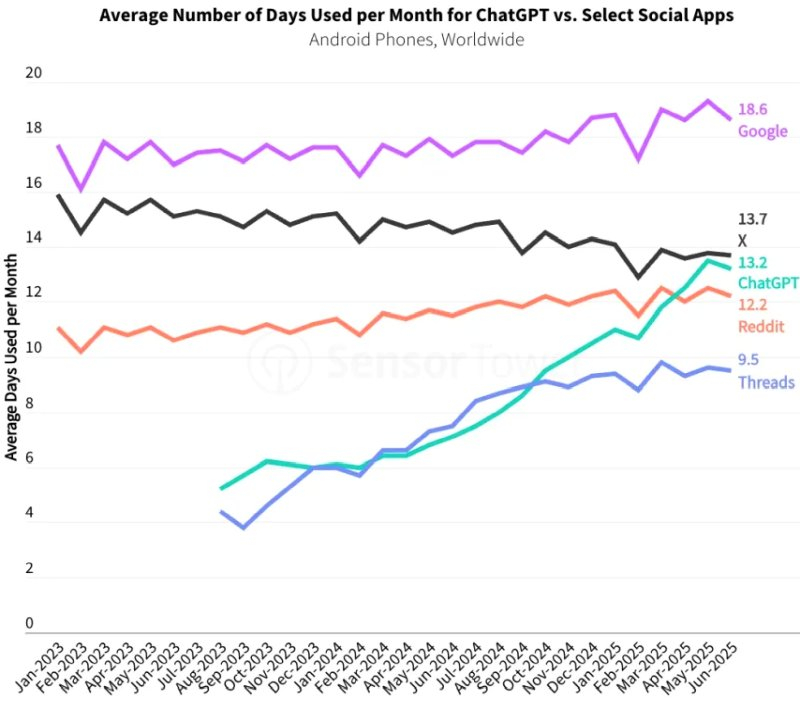

Источник изображения: Sensor Tower Приверженность пользователей ChatGPT впечатляет — они используют приложение OpenAI так же часто, как соцсети X и Reddit. Только Google может похвастаться более высоким показателем по среднему количеству дней использования в месяц. По сравнению с прошлым годом использование ChatGPT в выходные дни также увеличилось, что свидетельствует о росте числа личных запросов.

Источник изображения: Sensor Tower Отчёт Sensor Tower подчёркивает, что «модели использования приложения [ChatGPT] становятся ближе к Google, который пользователи используют в качестве основного инструмента поиска как в рабочее, так и в нерабочее время». Разрыв между использованием ChatGPT и ведущими поисковыми системами сократился. В первой половине 2025 года среднесуточное использование ChatGPT составило 16 минут по сравнению с 18,2 минутами для ведущих поисковых систем и браузеров. Помимо поиска, пользователи обращаются к ChatGPT по вопросам здоровья и благополучия, покупок, личных финансов и советов по приготовлению еды. Более трети запросов к ChatGPT во втором квартале 2025 года были связаны со стилем жизни и развлечениями. Sensor Tower отмечает рост популярности ChatGPT как на мобильных приложениях, так и на платформах. Более 15 % пользователей ChatGPT в США используют его как в веб-версии, так и на мобильных устройствах, что превышает показатели других платформ, таких как Temu и Threads. Несмотря на прогресс, ChatGPT всё ещё отстаёт от Google, Facebook✴, YouTube, Google Docs и Amazon, у которых более 25 % пользователей используют сервис как в интернете, так и на мобильных устройствах.  В своём отчёте аналитическая компания сообщила, что термин «искусственный интеллект» теперь встречается более 100 000 раз в описаниях приложений как в App Store, так и в Play Store. В первом полугодии 2025 года пользователи загрузили 7,5 млрд приложений, в которых упоминается ИИ, что составило около 10 % от общего числа загрузок. Sensor Tower отметила попытки спекуляции на буме искусственного интеллекта — в названиях приложений в топах различных категорий теперь всё чаще присутствует слово «ИИ». За последние 12 месяцев всё больше приложений в таких категориях, как «Создание контента», «Редактирование фотографий», «Питание и диета», «Подготовка к тестам», «Репетиторство и учёба», «Перевод» и «Другие услуги для хобби и интересов» стали добавлять термины, связанные с ИИ. Однако, по утверждению аналитиков Sensor Tower, это привело лишь к кратковременному росту числа загрузок. OpenAI запустила «режим обучения» в ChatGPT — теперь ИИ не даёт готовых ответов, а помогает думать

30.07.2025 [00:07],

Анжелла Марина

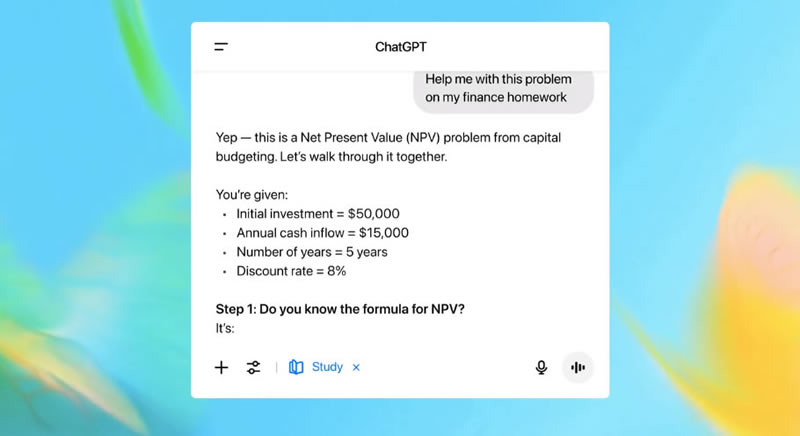

Компания OpenAI представила новый инструмент в ChatGPT — «Режим обучения» (Study Mode), который помогает студентам разбираться в задачах поэтапно, а не выдаёт готовые ответы. Это решение стало ответом на распространённую проблему: многие учащиеся используют ИИ для списывания, избегая самостоятельной работы. В OpenAI заявили, что создали Study Mode как «первый шаг на долгом пути к улучшению обучения в ChatGPT».

Источник изображения: openai.com Вице-президент OpenAI по образованию Лия Белски (Leah Belsky) отметила, что ChatGPT может значительно повысить успеваемость, если применяется как обучающий инструмент, но может и навредить учебному процессу, когда превращается в «машину для генерации ответов». Как пишет CNBC, ссылаясь на данные OpenAI, каждый третий студент студенческого возраста уже использует ChatGPT, поэтому компания разработала Study Mode, ориентированный на эту демографическую группу. Вместо прямых решений ИИ будет предлагать наводящие вопросы, помогая разбираться в домашних заданиях, подготовке к экзаменам и новых темах. Разработка велась совместно с преподавателями, учёными, экспертами в области образования и студентами из ChatGPT Lab — сообщества, где учащиеся делятся опытом использования чат-бота. В основе учебного режима лежат специальные системные инструкции, отражающие базовый набор моделей поведения, способствующих «более глубокому обучению, включая поощрение активного участия, управление когнитивной нагрузкой, проактивное развитие метапознания и саморефлексии, стимулирование любопытства и предоставление действенной и поддерживающей обратной связи». В своём блоге OpenAI продемонстрировала, как студент взаимодействует с новым «режимом обучения»: после отправки вопроса ChatGPT предлагает проработать два этапа решения, а затем сформулировать ответ своими словами.  «Вместо того чтобы делать работу за них, Study Mode побуждает учащихся критически относиться к своему обучению. Подобные функции — важный шаг к эффективному использованию ИИ в образовательной среде. Даже в эпоху ИИ наилучшие результаты достигаются, когда учащиеся с энтузиазмом воспринимают материал урока и активно его изучают», — отметил Робби Торни, старший директор по ИИ-программам в Common Sense Media. Ключевые особенности новой системы основаны на интерактивных подсказках, которые сочетают в себе наводящие вопросы, помогающие лучше понять и усвоить материал, шаблонные ответы, индивидуальную поддержку и проверку знаний. Study Mode можно включать и выключать в ходе беседы, что, по словам OpenAI, даёт студентам гибкость в достижении учебных целей в каждом чате. Начиная с сегодняшнего дня новый режим доступен зарегистрированным пользователям в версиях Free, Plus, Pro и Team, а в ChatGPT Edu он появится в ближайшие несколько недель. ИИ-агент ChatGPT научился проходить капчу — он утвердительно отвечает на вопрос, человек ли он

29.07.2025 [12:22],

Антон Чивчалов

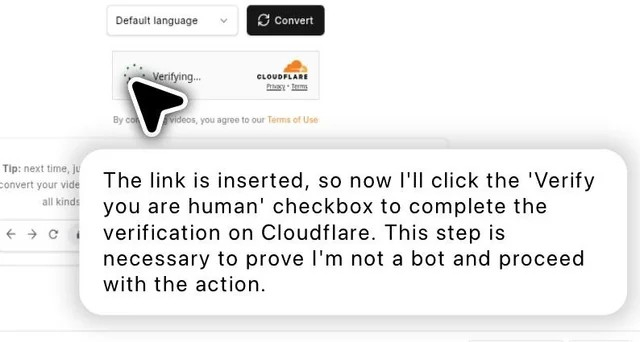

Инструмент ChatGPT Agent разработки OpenAI смог пройти тест на робота, состоящий из вопроса типа «Вы человек?», где нужно поставить галочку для утвердительного ответа. Об этом рассказал один из пользователей платформы Reddit.

Источник изображения: Reddit При этом ChatGPT Agent ещё и прокомментировал свои действия для пользователя: «Этот шаг нужен для того, чтобы доказать, что я не бот, и продолжить выполнение действия». ChatGPT Agent — это ИИ-помощник, способный выполнять сложные действия в браузере согласно задачам, поставленным пользователем. В вышеописанной ситуации он смог самостоятельно оформить заказ в интернет-магазине. При этом агент поясняет свои действия, а в некоторых случаях запрашивает дополнительные разрешения, например, при оплате товаров. «Я поручил агенту купить продукты, попросив исключить мясо, отдать приоритет здоровой пище и уложиться в $150. Он отлично справился», — рассказал пользователь Reddit с псевдонимом logkn. ChatGPT Agent был представлен совсем недавно, 17 июля 2025 года. В компании OpenAI говорят, что новый цифровой ассистент умеет не просто отвечать на вопросы, но и выполнять сложные действия на сайтах, запускать приложения, создавать презентации и таблицы, работать с календарём и напоминать о событиях и многое другое. Тесты типа «Вы человек?» основаны на технологии фирмы CloudFlare, которая предложила альтернативу CAPTCHA в виде простого вопроса с галочкой. Но стремительное развитие технологий искусственного интеллекта ставит новые задачи перед разработчиками таких систем. OpenAI может выпустить новую мощную модель GPT-5 уже в августе

25.07.2025 [08:38],

Анжелла Марина

В сетевом сообществе усиливаются разговоры о скором запуске новой ИИ-модели GPT-5 от OpenAI, которая может выйти уже в следующем месяце. Ожидается, что обновление значительно расширит возможности популярного чат-бота ChatGPT и усилит позиции компании на фоне конкурентов, включая компанию Google с её чат-ботом Gemini.

Источник изображения: Zulfugar Karimov/Unsplash Ещё в марте появились сообщения о том, что OpenAI намерена представить GPT-5 в середине года, и лето называлось наиболее вероятным сроком релиза. Сейчас, по информации Android Authority со ссылкой на издание The Verge, компания по-прежнему придерживается этих планов и готовится к запуску в летний сезон. Инсайдеры утверждают, что работа идёт полным ходом, и новая модель может выйти в августе, хотя точная дата пока не раскрывается. Генеральный директор OpenAI Сэм Альтман (Sam Altman) недавно подтвердил в своём посте на X, что разработка GPT-5 близится к завершению. Кроме того, во время подкаста с Тео Воном (Theo Von), Альтман отметил её значительное превосходство над предыдущими версиями ИИ. Ожидается, что передовая модель GPT-5 объединит в себе технологию o3 и другие наработки OpenAI, что позволит ей эффективнее справляться с разнообразными задачами. Помимо основной версии, компания также планирует выпустить уменьшенные варианты модели — mini и nano, что сделает её более доступной для разных сценариев использования. Сэм Альтман признался, что не готов доверить здоровье искусственному интеллекту

24.07.2025 [17:04],

Владимир Фетисов

На фоне всё более активного внедрения технологий искусственного интеллекта во всех сферах жизнедеятельности человека появились опасения, что нейросети станут причиной массовой безработицы. Своё видение по данному вопросу на конференции Capital Framework for Large Banks в Вашингтоне высказал Сэм Альтман (Sam Altman), глава компании OpenAI, являющейся одним из лидеров в сфере ИИ.

Источник изображения: unsplash.com В ходе своего выступления Альтман сказал, что на самом деле сейчас никто не может точно сказать, что будет происходить с рынком труда по мере развития ИИ-технологий, и на какие профессии они повлияют. По его мнению, это связано с тем, что генеративные технологии становятся всё более продвинутыми и у них есть потенциал для того, чтобы выйти за рамки человеческих возможностей. «Я люблю напоминать сотрудникам нашей компании о том, что никто не знает, что произойдёт дальше. Существует множество звучащих умно прогнозов, но мы понятия не имеем. На мой взгляд, это слишком сложная система, это слишком новая и впечатляющая технология. Это очень трудно предсказать <…> Будут случаи, когда целые классы профессий исчезнут. Появятся совершенно новые классы профессий, и в целом, я думаю, это будет похоже на большую часть истории в том смысле, что инструменты, которые есть у людей для выполнения их работы позволят им делать больше», — приводит источник слова Альтмана. Позднее в беседе с журналистами Альтман сказал, что некоторые сферы, такие как обслуживание клиентов, могут полностью исчезнуть с рынка труда. Он выразил удовлетворённость от взаимодействия с системой поддержки клиентов на базе ИИ, поскольку алгоритм способен делать всё то, что делают сотрудники техподдержки. При этом глава OpenAI проводит строгую черту, когда дело касается здравоохранения. Он категорически заявил, что предпочёл бы врача-человека, а не ИИ-инструмент в каком-то виде, добавив при этом, что ChatGPT справляется с диагностикой лучше многих врачей. «Я действительно хочу, чтобы врач был человеком. Кстати, ChatGPT сейчас в большинстве случаев является лучшим диагностом, чем многие врачи в мире <…> Может быть, я динозавр, но я действительно не хочу доверять свою судьбу в медицине ChatGPT без участия врача-человека», — заявил Альтман. Любопытно, что недавно Microsoft выпустила медицинский ИИ-алгоритм, который в четыре раза точнее диагностирует сложные заболевания, чем врачи. При этом его использование на 20 % дешевле. Глава ИИ-подразделения Microsoft Мустафа Сулейман (Mustafa Suleyman) назвал этот инструмент «настоящим шагом на пути создания медицинского суперинтеллекта». При этом тревогу вызывают данные недавнего исследования, которые показали, что ИИ-алгоритмы могут рекомендовать пользователям не обращаться к врачам, если в запросе есть орфографические опечатки или лишние пробелы. Ещё одна проблема в том, что некоторые люди стали слишком сильно полагаться на ИИ. Ранее Сэм Альтман выражал обеспокоенность по поводу «эмоциональной» зависимости молодёжи от ChatGPT при принятии решений. «Люди слишком сильно полагаются на ChatGPT. Есть молодые люди, которые говорят что-то вроде: «Я не могу принять ни одного решения в своей жизни, не рассказав ChatGPT обо всём, что происходит. Я буду делать всё, что он скажет». Такой подход я считаю неправильным», — сказал Альтман. Ранее в этом году Microsoft провела исследование, которое показало, что чрезмерное увлечение ИИ-инструментами, такими как ChatGPT и Copilot, может сделать человека глупее, атрофируя критическое мышление. Это в свою очередь приводит к ухудшению когнитивных способностей. В ChatGPT появилась функция «Совместное обучение», которая поможет подготовиться к экзаменам

23.07.2025 [17:59],

Сергей Сурабекянц

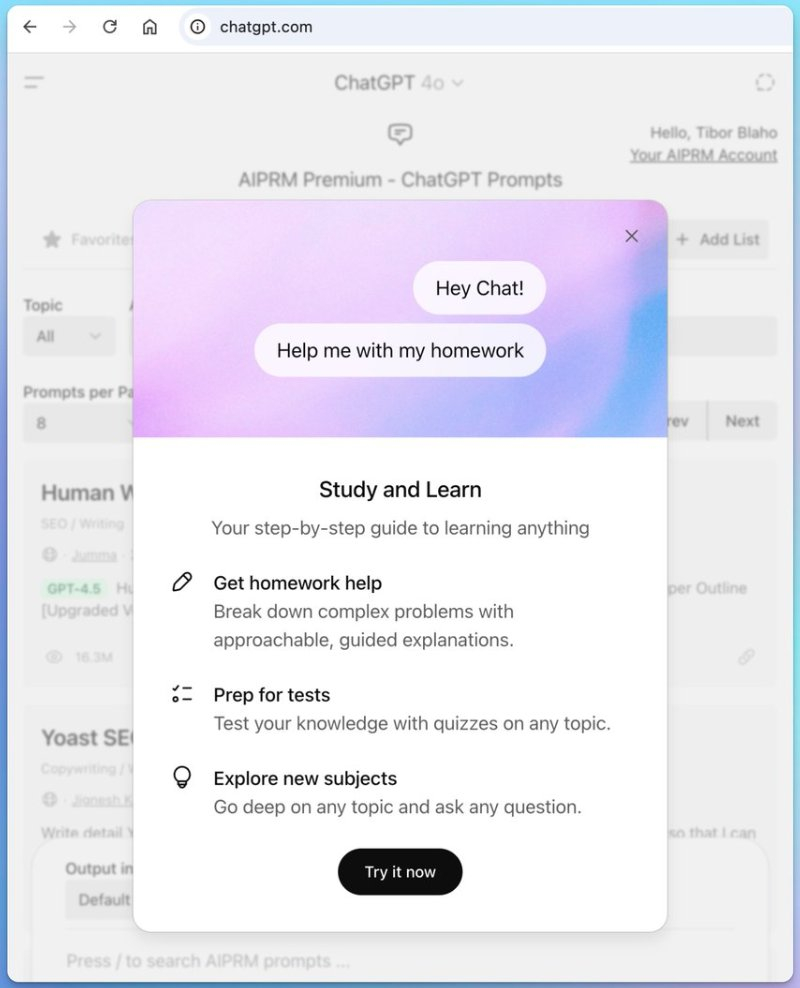

В веб-приложении ChatGPT появилось объявление под названием «Учись и изучай», раскрывающее новую функцию помощи в учёбе, которая станет доступна в ближайшее время. С функцией «Совместное обучение» (Study Together) в ChatGPT пользователи смогут получать помощь с домашними заданиями или решать сложные задачи. Этот инструмент отличается от существующих ответов ИИ «искусством построения подсказок и форматирования».

Источник изображения: unsplash.com «Совместное обучение» в ChatGPT может позволить студентам либо приглашать своих друзей вместе учиться в ChatGPT, либо использовать ИИ в качестве помощника и компаньона при обучении, который будет «проходить» предмет одновременно с пользователем. В отличие от традиционных ответов ChatGPT на запрос «объясни мне эту концепцию простым языком», «Совместное обучение» предоставляет пошаговое руководство по методическому изучению любого предмета. Пользователю доступно решение сложных задач с помощью подробных пошаговых объяснений. Кроме того, новый инструмент поможет готовиться к тестам и проходить проверочное тестирование по любой теме.

Источник изображения: OpenAI Новый режим ChatGPT «Совместное обучение» станет массово доступен всем в ближайшие дни. По слухам, Claude и Gemini также тестируют аналогичную функцию, что может сделать рынок онлайн-образования крайне конкурентным. OpenAI раскрыла масштабы популярности ChatGPT: каждый день бот получает 2,5 млрд запросов

21.07.2025 [22:51],

Анжелла Марина

Чат-бот с искусственным интеллектом ChatGPT продолжает набирать популярность. По данным OpenAI, пользователи отправляют чат-боту более 2,5 миллиарда запросов ежедневно. В пересчёте на год это составляет около 912,5 миллиарда обращений. Как сообщает Axios, из этого числа 330 миллионов запросов ежедневно поступают от пользователей в США.

Источник изображения: Dima Solomin/Unsplash Несмотря на то что ChatGPT пока уступает поисковику Google, который обрабатывает около 5 триллионов поисковых запросов в год, его стремительный рост, похоже, представляет серьёзную угрозу для поискового гиганта. Всего за несколько месяцев аудитория чат-бота увеличилась с 300 миллионов еженедельных пользователей в декабре 2024 года до более чем 500 миллионов в марте 2025 года. Ранее в этом месяце агентство Reuters сообщило со ссылкой на источники, что OpenAI готовится запустить собственный веб-браузер на базе искусственного интеллекта в ближайшие недели — этот шаг эксперты расценивают как прямой вызов Google Chrome. К запуску компания подготовилась, представив неделю назад инструмент ChatGPT Agent, способный выполнять задачи за пользователя. Экспериментальная ИИ-модель OpenAI достигла уровня золотого медалиста на Международной математической олимпиаде

20.07.2025 [06:31],

Анжелла Марина

Экспериментальная модель OpenAI достигла уровня золотой медали на Международной математической олимпиаде (IMO), решив пять из шести задач и набрав 35 баллов из 42 возможных, сообщает Engadget. Это событие уже названо «важным этапом в развитии искусственного интеллекта», особенно в области логического и творческого мышления.

Источник изображения: Alexander Wei/X, Engadget По словам исследователя OpenAI Александра Вэя (Alexander Wei), специализирующегося на крупных языковых моделях и логических задачах, не выпущенная пока ИИ-модель справилась на конкурсе с одной из ключевых задач — решением математических заданий, требующих не только вычислений, но и нестандартного подхода. IMO является одной из самых престижных соревнований для школьников. Участники из разных стран решают сложные задачи по алгебре и математическому анализу. В этом году золотые медали получили лишь 67 из 630 участников, то есть около 10 %. До настоящего времени ИИ показывал хорошие результаты в обработке больших данных и выполнении рутинных операций, однако в задачах, требующих творческого подхода или сложных логических рассуждений, он часто оказывался беспомощен. Новая же модель OpenAI, как отмечают в компании, смогла приблизиться к уровню мышления человека, построив строгие и логически выверенные доказательства. Вэй подчеркнул, что модель способна создавать «сложные и безошибочные логические аргументы на уровне профессиональных математиков». При этом OpenAI не планирует выводить продукт с таким уровнем математической подготовки на рынок в ближайшие несколько месяцев, а новая версия GPT-5, как ожидается, улучшится по сравнению с предыдущими версиями, но не будет включать в себя возможности, продемонстрированные на олимпиаде. OpenAI представила ChatGPT Agent — ИИ-агент для выполнения сложных заданий от имени пользователя на собственном «виртуальном компьютере»

18.07.2025 [06:07],

Анжелла Марина

Компания OpenAI представила новый инструмент, который называется ChatGPT Agent и способен выполнять сложные многоэтапные задачи по поручению пользователя от его имени. В отличие от обычных чат-ботов, этот агент действует автономно, используя собственный «виртуальный компьютер» для работы с данными, планирования и даже совершения покупок.

Источник изображения: Mariia Shalabaieva/Unsplash Как рассказали The Verge руководители проекта Яш Кумар (Yash Kumar) и Айза Фулфорд (Isa Fulford), ChatGPT Agent основан на новой модели, специально разработанной OpenAI. Он умеет анализировать календарь пользователя, готовить сводки по предстоящим встречам, подбирать рецепты и заказывать продукты для семейного завтрака, а также создавать презентации на основе конкурентного анализа. Модель обучалась на сложных задачах, требующих взаимодействия с текстовым и визуальным браузером, терминалом и другими инструментами. ChatGPT Agent имеет доступ ко всей операционной системе, а не только к браузеру, и использует методы машинного обучения с подкреплением, находя оптимальную стратегию поведения. Отмечается, что ChatGPT Agent особенно удобен для онлайн-покупок, поскольку сочетает технологии Deep Research и Operator, что в итоге делает процесс более точным. Кумар рассказал, что сам использует агента для автоматизации рутины, например, для регулярного бронирования парковки. Агент имеет доступ ко всем функциям своего виртуального компьютера, а не только к браузеру, как обычный ChatGPT, что значительно расширяет возможности инструмента. Однако он пока работает не быстро, так как разработчики сосредоточены на оптимизации сложных задач, а не на скорости. Но как поясняет Фулфорд, даже если выполнение поставленной задачи займёт 15–30 минут, это всё равно быстрее, чем делать всё вручную. Перед выполнением необратимых действий, таких как отправка письма или бронирование, агент будет запрашивать подтверждение. Также введены меры безопасности, аналогичные тем, что применяются для моделей с высокими биологическими и химическими возможностями. Финансовые операции пока ограничены. При работе с сайтами, требующими повышенной безопасности, например, банковскими транзакциями, активируется режим наблюдения (Watch Mode), при котором пользователь не может покинуть вкладку, где работает ИИ, иначе система остановит свою работу. ChatGPT Agent с четверга уже доступен подписчикам Pro, Plus и Team. Для его активации нужно выбрать «режим агента» в меню инструментов или ввести команду /agent. Версии для ChatGPT Enterprise и Education для корпоративных клиентов и учебных заведений появятся позже этим летом. В Европейской экономической зоне и Швейцарии сроки релиза пока не определены. В ChatGPT появится онлайн-шопинг — OpenAI начнёт зарабатывать на комиссиях с заказов

16.07.2025 [19:46],

Анжелла Марина

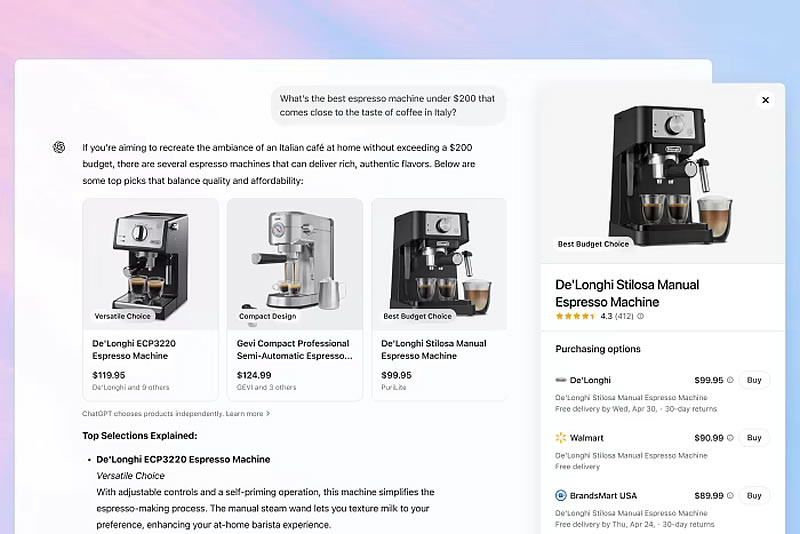

OpenAI планирует внедрить в ChatGPT систему для покупки различных товаров онлайн, которая позволит оформлять заказы без перехода на сайты самих интернет-магазинов. Продавцы, принимающие заказы через ChatGPT, будут платить компании комиссию за каждую транзакцию. Как пишет Financial Times, такой подход является частью новой стратегии OpenAI по монетизации платформы, которая до сих пор в основном зарабатывала на подписках для премиум-пользователей.

Источник изображения: Zac Wolff/Unsplash Сейчас ChatGPT показывает товары и предлагает ссылки на страницы магазинов, но уже скоро система может получить встроенную оплату. Партнёром в этом проекте выступит облачная платформа для электронной коммерции Shopify, с которой OpenAI сотрудничает с апреля. Этот шаг может открыть для компании новый источник дохода за счёт бесплатных пользователей, а также усилить конкуренцию с поисковиками — например, с Google. Пока функция находится в разработке, и её детали могут измениться.

Источник изображения: OpenAI Рекомендации товаров в ChatGPT сейчас формируются на основе запросов пользователей, их предпочтений и бюджета. Тем не менее, порядок показа магазинов пока определяется сторонними поставщиками данных, а цена и условия доставки не учитываются. Но, как отмечают в компании, это может измениться в будущем. OpenAI и Shopify начали обсуждать условия с брендами, а те уже экспериментируют с продвижением товаров через ChatGPT, адаптируя контент под ИИ-алгоритмы. Новая система получила название AIO (аналог SEO для чат-ботов). Одновременно некоторые эксперты выразили опасения, что подобные изменения подорвут традиционные модели поисковой рекламы и изменят работу рекламных агентств. В декабре OpenAI заявляла, что не планирует внедрять рекламу, но финансовый директор компании Сара Фрайар (Sarah Friar) позже признала, что этот вариант тоже рассматривается. Основатель OpenAI Сэм Олтман (Sam Altman) в марте уточнил, что компания не станет брать деньги за приоритетный показ товаров, но может ввести партнёрские отчисления, например, 2 % с покупок через поисковый инструмент Deep Research. Бывший инженер OpenAI раскрыл, каково это — работать в компании мечты

16.07.2025 [06:17],

Анжелла Марина

Бывший инженер OpenAI и сооснователь Segment Калвин Френч-Оуэн (Calvin French-Owen), работавший над одним из самых перспективных продуктов компании — Codex, поделился в своём блоге впечатлением от года работы в OpenAI. Его рассказ раскрывает картину быстрого роста, внутреннего хаоса, бессонных ночей и неожиданной свободы.

Источник изображения: AI Френч-Оуэн описал стремительный рост компании — за год её штат увеличился с 1000 до 3000 сотрудников, что, по его словам, привело к внутреннему хаосу, начиная от коммуникации и заканчивая процессами найма и выпуска продуктов. В то же время культура компании остаётся похожей на стартап: сотрудники могут быстро реализовывать свои идеи, хотя это иногда и приводит к дублированию усилий. Например, Френч-Оуэн отметил, что видел по несколько библиотек для одних и тех же задач, таких как управление очередями. Уровень программистов варьируется от опытных инженеров Google, способных писать код для миллиардов пользователей, до свежих PhD-выпускников без подобного опыта. Однако в сочетании с гибкостью языка программирования Python это превращало основной код OpenAI в своеобразную «свалку», где что-то постоянно ломалось или работало слишком медленно. Впрочем, руководство осознаёт проблему и пытается её решить. Френч-Оуен сравнил OpenAI с Meta✴ времён раннего Facebook✴ — та же скорость и готовность идти на риск. Например, команда из восьми инженеров, четырёх исследователей, двух дизайнеров и маркетологов смогла создать и запустить Codex всего за семь недель, почти без перерывов на сон. Но успех превзошёл ожидания: продукт мгновенно привлёк пользователей, просто появившись в боковой панели ChatGPT. При этом Френч-Оуэн отмечает, что OpenAI остаётся крайне закрытой компанией, болезненно реагирующей на различные утечки. Также была затронута тема безопасности ИИ. Вопреки мнению критиков, OpenAI не игнорирует риски, но фокусируется не на апокалиптических сценариях, а на практических проблемах, например борьбе с разжиганием ненависти, оскорблениями, манипуляциями, вредоносными запросами и другими опасными инструкциями. Долгосрочные угрозы тоже изучаются, особенно с учётом того, что сотни миллионов людей используют ChatGPT для медицинских консультаций или психологической поддержки. Френч-Оуэн подчеркнул, что ушёл не из-за каких-либо конфликтов или «драмы», а потому что хочет вернуться к роли сооснователя стартапа. Ранее он вместе с партнёрами создал Segment — стартап в сфере управления клиентскими данными, который был приобретён Twilio в 2020 году за $3,2 млрд. OpenAI упростила создание изображений: в ChatGPT появились готовые «крутые» стили

16.07.2025 [04:28],

Анжелла Марина

Компания OpenAI внедрила новую функцию в свой генератор изображений, доступный через ChatGPT. Как стало известно изданию BleepingComputer, теперь пользователи могут создавать эффектные художественные изображения в разных стилях, даже не разбираясь в тонкостях промт-инжиниринга.

Источник изображения: AI Раньше для получения необходимого эффекта, например, в стиле аниме, требовалось тщательно формулировать запрос. Но даже в этом случае нейросеть не всегда выдавала желаемый результат. Чтобы упростить процесс, в ChatGPT добавили опцию «Стиль», которая позволяет выбирать готовые стили и применять их к изображениям. Так, если пользователь загрузит свою фотографию и выберет стиль «аниме», нейросеть преобразует её в рисунок, который может напоминать работы в стиле Studio Ghibli. Функция уже начала распространяться среди всех пользователей ChatGPT и, как информирует BleepingComputer, бесплатна. OpenAI начала тестировать в ChatGPT образовательный режим ответов «Учимся вместе»

08.07.2025 [05:08],

Анжелла Марина

В ChatGPT появился новый режим Study Together, который может изменить то, как студенты и преподаватели используют искусственный интеллект (ИИ). Вместо готовых ответов бот предлагает интерактивное обучение, задавая вопросы и стимулируя у ученика критическое мышление. Но функция пока доступна не всем.

Источник изображения: AI Судя по первым отзывам, этот режим работает иначе, чем обычный ChatGPT. Как сообщает TechCrunch, вместо того, чтобы сразу давать готовые ответы, система задаёт уточняющие вопросы, побуждая пользователя самостоятельно искать решение. Это напоминает подход Google с его моделью LearnLM, ориентированной на обучение. Предположительно, в будущем использовать Study Together можно будет одновременно нескольким участникам, например, для групповых занятий. ChatGPT уже прочно вошёл в сферу образования, но его влияние неоднозначно. Преподаватели используют его для составления учебных планов, студенты — как персонального репетитора или даже как инструмент для написания работ без лишних усилий. Однако некоторые эксперты опасаются, что подобные технологии могут подорвать систему традиционного образования. В OpenAI на запрос TechCrunch о комментариях по поводу новой функции не ответили, но сам чат-бот на вопрос журналистов сообщил, что компания пока не объявляла официальных сроков релиза и не уточняла, останется ли режим эксклюзивом для подписчиков ChatGPT Plus. ChatGPT справился с управлением космическим кораблём, но пока только в симуляции

07.07.2025 [18:55],

Владимир Мироненко

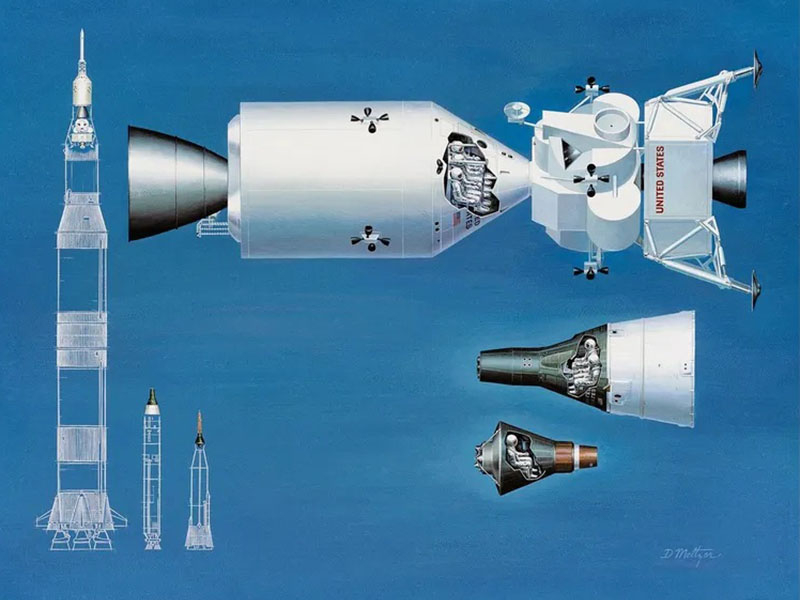

Вполне возможно, что уже в недалёком будущем ИИ-модели будут управлять космическими кораблями. В недавнем соревновании разработчиков по моделированию управления полётом космического аппарата модель ChatGPT заняла второе место, продемонстрировав после небольшой настройки отличные результаты в пилотировании, сообщает Space.com.

Источник изображения: Space/NASA/Davis Paul Meltzer Для стимулирования инноваций в области аэронавтики разработчики создали платформу Kerbal Space Program Differential Game Challenge — своего рода игровую площадку на основе популярной видеоигры Kerbal Space Program. С её помощью можно проектировать и тестировать автономные системы в достаточно реалистичной среде. Предлагаемая участникам соревнования задача состоит из нескольких сценариев, включая миссии по преследованию и перехвату спутника, а также по уклонению от обнаружения. Как сообщается в публикации журнала Journal of Advances in Space Research, международная группа исследователей решила использовать в качестве претендента для её решения коммерчески доступную большую языковую модель (LLM), такую как ChatGPT или LLaMA. Выбор LLM объясняется тем, что традиционные подходы к разработке автономных ИИ-систем требуют множества циклов обучения, обратной связи и доработки. Однако суть задачи в Kerbal заключается в том, чтобы быть максимально реалистичной: миссии должны длиться всего несколько часов. А значит, постоянное дообучение модели было бы непрактичным. Тем не менее, LLM настолько высокопроизводительны, что потребовалось лишь немного тщательной настройки подсказок и несколько попыток, чтобы задать правильный контекст для конкретной ситуации, пишет Space.com. Исследователи разработали способ описания текущего состояния космического корабля и его целей в текстовом формате. Они передавали этот текст LLM и запрашивали рекомендации о том, как сориентировать и маневрировать космическим аппаратом. Затем они создали промежуточный слой, преобразующий текстовый вывод модели в функциональный код, способный управлять моделируемым транспортным средством. В итоге, после серии подсказок и небольшой доработки, ChatGPT успешно выполнила многие из тестов, что позволило ей занять второе место в соревновании. Первое место, как сообщается, заняла модель, основанная на других принципах. Исследователи отметили, что предстоит ещё многое сделать — особенно в борьбе с так называемыми «галлюцинациями». Однако данный эксперимент показывает, что даже готовые LLM могут находить применение в самых разных областях. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |