|

Опрос

|

реклама

Быстрый переход

Google вживую продемонстрировала возможности Android XR

18.04.2025 [11:55],

Павел Котов

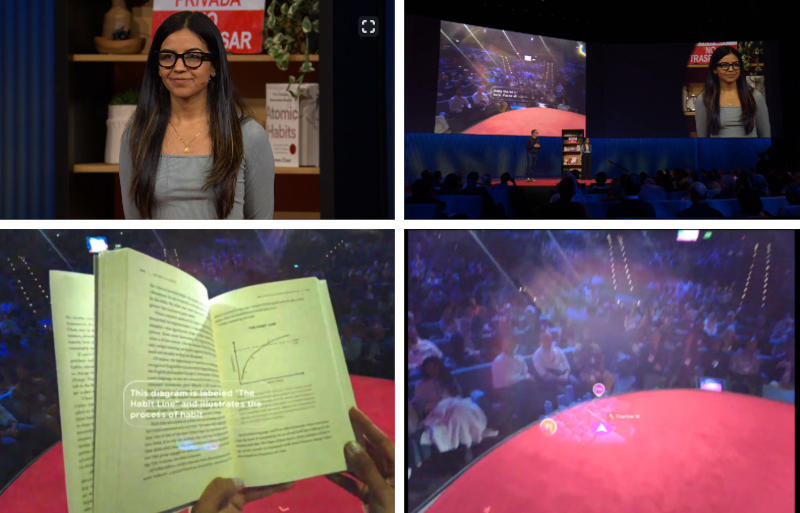

Google, занятая разработкой платформы для умных очков и гарнитур смешанной реальности Android XR, показала на конференции TED 2025, чего сумела добиться к настоящему моменту.

Источник изображений: ted.com С докладом выступил курирующий направление дополненной и виртуальной реальности вице-президент Google Шахрам Изади (Shahram Izadi) — в ходе своего выступления очки дополненной реальности были и на нём, а для демонстрации он пригласил менеджера по продуктам компании Ништу Бхатию (Nishtha Bhatia). В прототипе на господине Изади были установлены диоптрийные линзы, но на большой экран в зале вывели изображение, которое демонстрировал дисплей в очках его помощницы. Он пояснил, что на дисплее его очков выводились заметки для доклада — устройство подключается к смартфону и поддерживает вывод всех его приложений. Ключевой функцией умных очков под управлением Android XR является, конечно, подключённая к ним модель искусственного интеллекта Google Gemini. Ништа окинула взглядом стоящий на сцене стеллаж, отвернулась и попросила голосового помощника составить хайку — японское трёхстишие. А потом задала ИИ вопрос о том, что находилось на стеллаже. Gemini «на память» сообщил название стоящей книги и добавил, в каком месте лежит «забытая» хозяйкой ключ-карта из отеля.  Голосовой чат-бот продемонстрировал способность осуществлять в реальном времени перевод как с испанского на английский, так и с английского на более экзотический фарси. На запрос на хинди Gemini также с ходу дал ответ на хинди. Далее ИИ показали обложку виниловой пластинки, и система по просьбе пользователей запустила одну из песен с этого альбома, обнаружив его в библиотеке Google. В конце этого этапа демонстрации Gemini вызвался проводить Ништу до указанного ей пункта назначения. Во второй части демонстрации использовались не умные очки, а гарнитура смешанной реальности Samsung Project Moohan, выход которой намечен на этот год. ИИ снова показал, на что способен: открыл карту Кейптауна в режиме «Google Карт» Immersive View, распознал горнолыжный курорт на 360-градусном видео с YouTube, описал картинку с видеозаписи в духе фильма ужасов и дал несколько советов, когда запустили игру. Отчёт Google о Gemini 2.5 Pro раскритиковали за отсутствие прозрачности о безопасности ИИ

18.04.2025 [04:40],

Анжелла Марина

Эксперты раскритиковали Google за недостаток прозрачности и минимальное количество информации в техническом отчёте по Gemini 2.5 Pro. Они считают, что документ без полных данных не даёт адекватного представления о возможных рисках новой ИИ-модели .

Источник изображений: Google Отчёт был опубликован спустя несколько недель после запуска Gemini 2.5 Pro — самой мощной на сегодняшний день модели Google. Хотя такие документы обычно считаются важной частью обеспечения безопасности искусственного интеллекта (ИИ) и помогают независимым исследователям проводить собственные оценки рисков, в данном случае отчёт оказался «очень скудным», пишет TechCrunch. «В документе минимум информации, и он появился уже после того, как модель была доступна широкой публике, — заявил Питер Уилдефорд (Peter Wildeford), сооснователь Института политики и стратегии в области ИИ. — Невозможно проверить, выполняет ли Google свои публичные обещания, а значит невозможно оценить безопасность и надёжность моделей компании». Отдельную критику вызвало отсутствие упоминания о внутренней системе оценки рисков Frontier Safety Framework (FSF), которую Google представила в прошлом году для выявления потенциально опасных возможностей ИИ. В новом отчёте не содержится результатов тестов по опасным способностям модели — эти данные Google хранит отдельно и обычно не публикует вместе с основным документом. Эксперты считают, что Google, некогда выступавшая за стандартизацию отчётности по ИИ, теперь сама отходит от своих принципов. Отдельная обеспокоенность связана с тем, что компания до сих пор не представила отчёт по недавно анонсированной модели Gemini 2.5 Flash. Однако представитель Google заявил изданию TechCrunch, что этот документ выйдет в ближайшее время. Отмечается, что ситуация с Google, очевидно, является частью более широкой тенденции. Например, Meta✴ недавно также подверглась критике за поверхностный анализ рисков своей новейшей ИИ-модели Llama 4, а OpenAI вовсе не представила отчёт по линейке GPT-4.1. «Мы явно наблюдаем гонку на понижение стандартов, — заявил Кевин Бэнкстон (Kevin Bankston), старший советник по вопросам управления ИИ Центра демократии и технологий. — А на фоне сообщений о том, что другие компании, включая OpenAI, сокращают время на тестирование с месяцев до дней, такой уровень отчётности Google является тревожным сигналом». Google официально признана монополистом в интернет-рекламе

17.04.2025 [19:14],

Сергей Сурабекянц

Министерство юстиции США выиграло судебный процесс против Google по обвинению в монопольном положении в сфере рекламных технологий. Суд постановил, что Google «умышленно участвовала в серии антиконкурентных действий», а антиконкурентная практика технологического гиганта нанесла «существенный вред» клиентам и пользователям.

Источник изображений: unsplash.com Суд признал Google ответственной в соответствии с разделами 1 и 2 «Закона Шермана». По мнению суда, «истцы доказали, что Google сознательно прибегала к серии антиконкурентных действий, чтобы получить и сохранить монопольную власть на рынках площадок размещения рекламы и рекламных бирж для открытого веб-пространства». «Более десяти лет Google связывала свою рекламную платформу для издателей с рекламной биржей с помощью договорных условий и технологической интеграции, что позволило компании установить и поддерживать монополию на этих двух рынках», — отметил суд. Министерство юстиции утверждало, что Google незаконно монополизировала три сферы рекламных технологий: рынок рекламных инструментов для владельцев сайтов, платформу для рекламодателей и рекламные биржи, которые облегчают транзакции. В результате Google получала монопольную прибыль за счёт издателей и рекламодателей, которые находились в зависимом положении из-за отсутствия реальных альтернатив. По мнению юристов Google, обвинения Министерства юстиции были надуманными и оторванными от реальности. Google утверждала, что её инструменты помогают издателям и рекламодателям зарабатывать деньги, а наличие таких инструментов в разных сферах, наоборот, обеспечивает максимальное удобство для потребителей. Юристы Google утверждали, что у компании есть законные деловые причины для своих действий, а правительство просто хочет диктовать Google, как вести бизнес. Дополнительным подтверждением позиции Министерства юстиции, по мнению суда, стала неспособность Google предоставить суду внутренние коммуникации, из-за того, что внутреннее приложение для обмена сообщениями якобы «удаляло записи чатов между сотрудниками».  Сегодняшнее решение суда было принято в преддверии ещё одного судебного разбирательства между Google и Министерством юстиции о монополии технологического гиганта на поиск. В случае проигрыша компания может быть подвергнута принудительному разделению. ИИ-помощник Gemini «прозрел» у бесплатных пользователей на Android

17.04.2025 [11:54],

Владимир Мироненко

Компания Google сообщила о доступности с сегодняшнего дня для всех пользователей Android-устройств функции Gemini Live, которая реализована в приложении Gemini и позволяет ИИ-помощнику «видеть» и реагировать на изображения на экране и в камере. Ранее эта функция была доступна по подписке Gemini Advanced.

Источник изображения: Amanz/unsplash.com Функция Gemini Live на базе искусственного интеллекта была официально запущена в начале этого месяца для всех пользователей смартфонов Pixel 9 и Samsung Galaxy S25 с предустановленным приложением Gemini. «Мы получили отличные отзывы о Gemini Live с возможностью совместного использования камеры и экрана, поэтому мы решили предоставить её большему количеству людей, — сообщила Google на платформе X. — Начиная с сегодняшнего дня и в течение следующих недель мы предоставим её всем пользователям Android с приложением Gemini». Чтобы получить больше сведений о рецепте, который вы читаете, или о растении, которое заметили, можно обратиться к ИИ-помощнику, нажав кнопку «Поделиться экраном с Live» во вкладке Gemini, и он будет «видеть» именно то, о чем вы хотите узнать. Чтобы поделиться с ИИ-помощником изображением с камеры, необходимо перейти в полноэкранный интерфейс Gemini Live и нажать кнопку камеры. Откроется видоискатель, позволяющий переключаться между фронтальной и основной камерами. Сегодня Microsoft объявила, что её аналогичный ИИ-инструмент Copilot Vision теперь доступен бесплатно в браузере Edge. «Почти тотальное доминирование» поисковика Google может обойтись компании в £5 млрд

17.04.2025 [11:15],

Владимир Фетисов

На этой неделе в Апелляционный суд по вопросам конкуренции Великобритании поступил коллективный иск, авторы которого требуют взыскать с Google £5 млрд ($6,6 млрд). Американская компания обвиняется в использовании своего доминирующего положения в сегменте онлайн-поиска для повышения стоимости размещения рекламы в интернете.

Источник изображения: Mitchell Luo / Unsplash Авторы иска считают, что Google злоупотребляет своим рыночным положением, чтобы ограничить работу конкурирующих поисковых систем для укрепления собственных позиций. Эта деятельность делает Google единственной компанией, которая предлагает выгодные условия размещения рекламы в интернете. Иск подала эксперт в области антимонопольного права Ор Брук (Or Brook) от имени сотен тысяч британских компаний и организаций, которые пользовались услугами размещения рекламы в поисковике Google с 1 января 2011 года и до момента подачи иска. Её интересы в суде будет представлять юридическая компания Geradin Partners. «Сегодня у британских компаний и организаций, больших и малых, практически нет выбора, кроме как использовать рекламу Google для продвижения своих товаров и услуг», — говорится в иске. Ор Брук выразила уверенность в том, что Google пользуется своим доминирующим положении на рынке интернет-поиска и онлайн-рекламы для завышения цен на свои услуги. Судебный иск, по её мнению, позволит привлечь Google к ответственности за незаконные действия, а также поможет получить компенсацию пострадавшим рекламодателям из Великобритании. В Google дело назвали «спекулятивным и конъюнктурным», а также выразили готовность «решительно» оспаривать обвинения в суде. «Потребители и рекламодатели используют Google, потому что он полезен, а не потому, что нет альтернативы», — добавил представитель компании. Управление по конкуренции и рынкам (CMA) Великобритании в 2020 году провело исследование, которое показало, что 90 % от общего объёма доходов на рынке онлайн-рекламы приходится на долю Google. Авторы иска считают, что Google предприняла ряд шагов для ограничения конкуренции в сфере интернет-поиска. В числе прочего упоминаются сделки с производителями смартфонов, которые используют по умолчанию на своих устройствах поисковик Google и браузер Chrome. Также сказано, что Google заплатила Apple миллиарды долларов, чтобы сделать поисковиком по умолчанию в браузере Safari свой сервис. ИИ помог Google заблокировать более 39 млн подозрительных рекламных аккаунтов

16.04.2025 [16:42],

Павел Котов

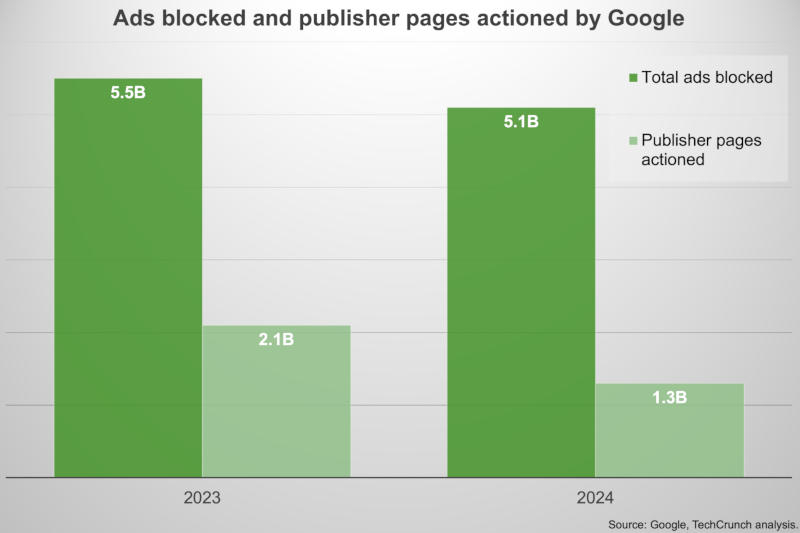

В 2024 году Google заблокировала на рекламной платформе 39,2 млн учётных записей — более чем в три раза больше, чем в предыдущем году. Такого результата компания добилась в рамках последней операции, направленной на борьбу с мошенничеством в рекламе.

Источник изображений: Google Большие языковые модели помогли учесть такие сигналы как выдача себя за другое лицо и не соответствующие действительности платёжные реквизиты — теперь компания уверена, что способна блокировать «подавляющее большинство» рекламных аккаунтов ещё до того, как их реклама начнёт демонстрироваться. В прошлом году Google внесла более 50 улучшений в большие языковые модели для улучшения механизмов безопасности на всех своих платформах. Компания собрала команду из более чем сотни экспертов, включая работников отдела Ads Safety, подразделения Trust and Safety и учёных из DeepMind — они проанализировали мошеннические схемы с присутствием фейков в рекламе, в том числе поддельных изображений известных людей, и разработали контрмеры. В прошлом году компания развернула технические контрмеры и внесла более 30 обновлений политики для рекламодателей и площадок. Это помогло заблокировать более 700 тыс. нарушающих правила учётных записей, и число жалоб на фейки в рекламе снизилось на 90 %.  Только в США Google за минувший год заблокировала 39,2 млн аккаунтов рекламодателей и удалила 1,8 млрд рекламных объявлений — основные нарушения были связаны со злоупотреблениями платформой, неправомерным использованием товарных знаков, заявлениями в области здравоохранения, персонализацией рекламы и искажением фактов. В Индии, самой густонаселённой стране мира и втором по величине интернет-рынке после Китая по количеству пользователей, в прошлом году компания заблокировала 2,9 млн учётных записей — по этому критерию страна стала второй в мире после США. Здесь были удалены 247,4 млн рекламных объявлений; самые частые нарушения были связаны с финансовыми услугами, неправомерным использованием товарных знаков, злоупотреблением рекламными сетями, персонализацией рекламы и азартными играми. Из всех случаев блокировки рекламных аккаунтов Google заблокировала 5 млн учётных записей за нарушения, связанные с мошенничеством, и около полумиллиарда объявлений по той же причине. В 2024 году, который в большинстве стран мира оказался годом выборов, компания проверила более 8900 новых рекламодателей по данному направлению и удалила 10,7 млн предвыборных объявлений. В общей сложности Google за минувший год заблокировала 5,1 млрд объявлений и удалила 1,3 млрд страниц — для сравнения, в 2023 году это были 5,5 млрд объявлений и 2,1 млрд страниц на сайтах издателей. Снижение этих показателей указывает на улучшение профилактических мер, считают в компании. Из-за работы механизмов раннего обнаружения и блокировки учётных записей, нарушающих условия обслуживания, создаются меньше рекламных объявлений с нарушениями. Прочие ограничения были наложены на 9,1 млрд объявлений. В Google не исключают и собственных ошибок, поэтому предусмотрена процедура подачи апелляции — каждый спорный случай рассматривает уже человек. Главный конкурент ChatGPT научился проводить глубокие исследования и рыться в Gmail

16.04.2025 [00:14],

Анжелла Марина

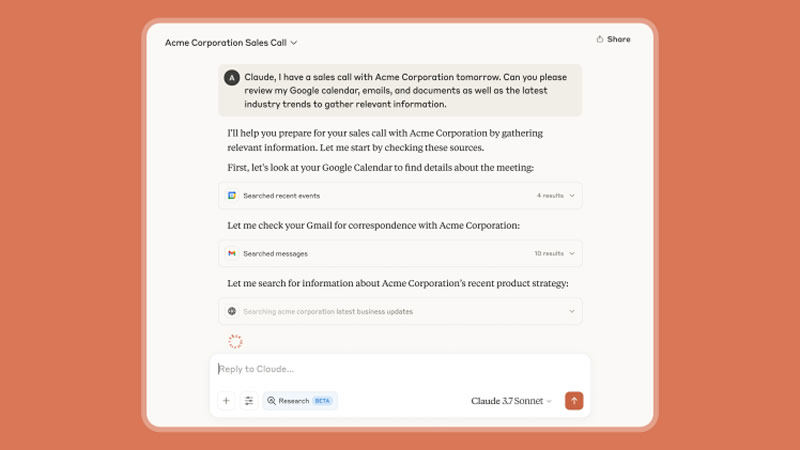

Компания Anthropic, разработчик ИИ-ассистента Claude, представила новый инструмент Research для глубоких исследований с помощью ИИ. Также компания объявила об интеграции с приложениями пакета Google Workspace: ИИ-ассистент сможет напрямую подключаться к Gmail, «Google Календарю» и «Google Документам».

Источник изображения: Anthropic Вместо ручного поиска информации в громадном количестве писем, приглашениях и документах, Claude будет делать это за пользователя. ИИ может находить информацию за заданный период, выделять ключевые действия из цепочек писем и предлагать дополнительный контекст не хуже, чем Microsoft Copilot, отмечает The Verge. Кроме этого, Anthropic запустила новую функцию Research, которая, по словам разработчиков, кардинально меняет подход к поиску и анализу информации. В отличие от обычного ИИ-поиска, Claude теперь работает как ИИ-агент, выполняя серию взаимосвязанных запросов, формируя более точную и обоснованную выдачу, а каждый выданный ответ сопровождается ссылками на источники.

Источник изображения: Anthropic Функция Research уже доступна в ранней бета-версии для пользователей тарифов Max, Team и Enterprise в США, Японии и Бразилии. Интеграция же с Google Workspace находится в стадии beta и доступна всем платным пользователям, однако для корпоративных аккаунтов её должен активировать администратор. Для подписчиков с тарифом Pro ($20 в месяц) запуск функции Research планируется в ближайшее время. Для корпоративных клиентов также добавлена возможность каталогизации «Google Диска» — эта функция использует методы RAG (улучшенные механизмы поиска, в том числе по внешним источникам), чтобы находить информацию даже в давно забытых документах. Claude сможет автоматически просматривать всю базу данных компании в поисках нужных данных. Однако с расширением возможностей модели встаёт вопрос точности и безопасности. Как и другие ИИ, Claude может ошибочно интерпретировать данные или предоставлять вымышленные сведения. «Мы призываем пользователей всегда проверять источники, читать их и убеждаться в точности информации», — подчёркивают в Anthropic. Что касается конфиденциальности, то в компании заверили, что их ИИ-ассистент работает только с теми документами, к которым пользователь предоставил доступ в рамках своей авторизации. Также сообщается, что Anthropic запускает голосовой ИИ, с которым можно разговаривать. Новая функция, получившая название Voice mode, появится в чат-боте уже в этом месяце и, вероятно, станет конкурентом аналогичному голосовому режиму в ChatGPT. По данным Bloomberg, пользователям будут доступны три варианта голоса на английском языке: Airy, Mellow и Buttery. Ранее о разработке этой функции упоминал глава по продуктам Anthropic Майк Кригер (Mike Krieger), подтвердив, что компания тестирует прототипы. Упоминания о голосовом режиме также были обнаружены в коде iOS-приложения Claude. Как заявили в компании, что это лишь начало серии обновлений, которые «переосмысляют взаимодействие с Claude». В ближайшие недели ожидается дальнейшее расширение доступного контекста и улучшение аналитических функций ИИ-модели. Платные пользователи Google Gemini получили доступ к ИИ-генератору кинематографических видео Veo 2

15.04.2025 [22:35],

Владимир Фетисов

Google предложила подписчикам Gemini Advanced опробовать Veo 2 — свой генератор видео на базе искусственного интеллекта, который, по словам компании, способен на основе текстового описания создавать кинематографические ролики в высоком разрешении. Желающим испытать алгоритм достаточно выбрать его в списке доступных инструментов, после чего они смогут сгенерировать на основе текстовой подсказки 8-секундный ролик в разрешении 720p.

Источник изображения: Google Предложение Google предусматривает ограничение на количество роликов, создаваемых с помощью Veo 2. В компании не предоставили более подробной информации, отметив лишь, что пользователи получат соответствующее уведомление при приближении к лимиту. Также известно, что Veo 2 генерирует ролики в формате MP4, а пользователи мобильных устройств смогут сразу загружать созданный контент в TikTok или на YouTube с помощью кнопки «Поделиться». По данным Google, обновлённая ИИ-модель «лучше понимает физику реального мира и движения человека», что позволяет ей передавать «плавные движения персонажей, реалистичные сцены и более тонкие визуальные детали в разных сюжетах и стилях». Генерируемые с помощью Veo 2 ролики дополняются цифровыми маркерами SynthID, которые указывают на то, что видео создано с использованием нейросети. Одновременно Google открывает для подписчиков One AI Premium доступ к инструменту Whisk Animate, который использует Veo 2 для создания 8-секундных роликов на основе изображения. Функция Whisk Animate доступна подписчикам по всему миру через Google Labs. Google.ru уйдёт в прошлое: поисковик переведёт пользователей со всего мира на google.com

15.04.2025 [21:19],

Владимир Фетисов

Исторически так сложилось, что в разных странах мира поисковик Google использует национальные домены верхнего уровня, например, google.ru в России или google.fr во Франции. В скором времени это изменится и поисковик Google будет доступен по адресу google.com для всех пользователей в мире, независимо от их территориального местоположения.

Источник изображения: Firmbee.com / Unsplash На первых порах Google использовала национальные домены верхнего уровня для предоставления локально релевантных результатов поиска. С 2017 года поисковая система компании предоставляет релевантные результаты независимо от того, используется ли региональный адрес или google.com. Теперь же IT-гигант будет перенаправлять весь трафик поисковика на google.com, что, как ожидается, упростит процесс взаимодействия пользователей с сервисом. Отмечается, что пользователи увидят новый URL-адрес, но это никак «не повлияет на работу поисковика». Это нововведение изменит то, что люди видят в адресной строке браузера, но на работе поисковой системы оно никак не скажется. Также отмечается, что в рамках этого изменения пользователям может быть предложено обновить настройки поиска. Перевод поисковика на домен google.com займёт несколько месяцев и не будет единовременным для всех пользователей сервиса. Android-смартфоны начнут самопроизвольно перезагружаться ради безопасности

15.04.2025 [18:43],

Павел Котов

В последнем обновлении сервисов Google Play на Android появилась новая функция безопасности — если устройство оставалось заблокированным более трёх дней подряд, оно уходит в автоматическую перезагрузку. В справочном разделе Google указано, что новая функция будет работать на «телефонах», что в действительности означает смартфоны и планшеты — автомобилей, приложения Google Play Games Windows, умных телевизоров и часов нововведение не коснётся. Автоматическая перезагрузка будет происходить, если смартфон или планшет не использовались более 72 часов. Перезапуск устройства возвращает его в состояние «до первой разблокировки», когда данные зашифрованы, и получить к ним доступ сложнее, а вход по биометрии ещё не включился. На устройствах Pixel указывается, что их необходимо «разблокировать для всех функций и данных». Функция автоматической перезагрузки есть в GrapheneOS — производной от Android, которая по умолчанию предлагает перезагрузку после 18 часов неактивности, но можно выбрать промежуток времени от 10 минут до 72 часов; она также появилась с выходом iOS 18.1. Обновление сервисов Google Play 25.14 будет развёртываться в течение ближайшей недели, но на её повсеместное включение уйдёт ещё какое-то время. Обновлять саму ОС не потребуется — новая функция появится на большинстве представленных сегодня на рынке Android-устройств. Об особенностях работы этой функции в Google пока не сообщили. Япония предписала Google прекратить навязывание своих приложений производителям смартфонов

15.04.2025 [14:00],

Павел Котов

Японская Комиссия по добросовестной конкуренции предписала холдингу Alphabet прекратить действия, которые ведомство расценило как злоупотребление доминирующим рыночным положением в отношении местных производителей смартфонов. Компании запретили навязывать партнёрам свои программные продукты.

Источник изображения: BoliviaInteligente / unsplash.com Выдав распоряжение, регулятор повторил своё прежнее заявление, что американский технологический гигант злоупотребляет своим положением поставщика экосистемы Google Play — единственной жизнеспособной альтернативы магазину приложений для Apple iPhone. Google, по версии ведомства, неправомерно вынуждает местных производителей смартфонов отдавать приоритет своим приложениям и службам, которые запускаются на устройствах. Комиссия выдала распоряжение незадолго до предстоящего на этой неделе визита главы японского Министерства по экономическому возрождению Рёсэя Аказавы (Ryosei Akazawa) в США, где он намерен добиться отсрочки введения пошлин на ввоз японских товаров в США. Ранее Управление торгового представителя США пожаловалось, что японский «Закон о цифровых платформах», направленный на повышение прозрачности в деятельности крупных поставщиков технологических решений, оказывает непропорциональное влияние на американские компании и отрицательно сказывается на их конкурентоспособности в Японии — для соблюдения требований закона им требуется увеличивать расходы. США поставляют в Японию относительно небольшие объёмы товаров, но значительные объёмы услуг — это, в частности, лицензионные сборы за экосистему приложений для Android и доходы от рекламы. По итогам прошлого года США поставили в Японию услуги на сумму $45 млрд. Google, по версии комиссии, заработала на стремлении японских производителей сохранить долю рынка в стране, где ведущим брендом смартфонов является Apple. Поисковый гигант потребовал, чтобы японские производители смартфонов, в том числе Sony и Sharp включали в комплект ПО браузер Chrome и размещали значок для его запуска на главном экране каждого устройства. Японские компании были вынуждены подчиниться, потому что экосистема Google Play необходима для работы смартфонов, способных конкурировать с продукцией Apple. Американский технологический гигант также предложил производителям долю в доходах от рекламы, если те согласятся не поставлять в комплекте ПО средства для работы с поисковыми системами конкурентов. Аналогичное соглашение Google заключила с Apple, которой ежегодно выплачивает миллиарды долларов. Японские власти впервые последовали примеру регулирующих органов мира и выдали такое предписание ведущей американской технологической компании. ЕС неоднократно предъявлял претензии в адрес Apple и Google из-за незаконных, по мнению властей региона, действий для установления и удержания доминирующего положения на рынке мобильного ПО; американский суд установил, что Google незаконно монополизировала рынок веб-поиска, и теперь компании грозит разделение. ИИ-модели Gemini позволили анализировать снимки в «Google Фото», но пока не у всех пользователей

15.04.2025 [12:38],

Владимир Фетисов

Компания Google начала интеграцию своей нейросети Gemini в сервис «Google Фото». Благодаря этому пользователи теперь имеют возможность объединения Gemini со своим аккаунтом в «Google Фото», благодаря чему можно искать нужные снимки на основе текстовых запросов об их содержимом. На данный момент нововведение доступно только на территории США для запросов на английском языке.

Источник изображения: BoliviaInteligente / Unsplash Согласно имеющимся данным, упомянутое нововведение доступно для всех пользователей устройств на базе Android, у которых установлено приложение Gemini. Для активации интеграции необходимо запустить приложение Gemini и в настройках профиля активировать соответствующую опцию. После этого алгоритм сможет помочь отыскать снимки, например, по сделанным пользователем меткам, местоположению, дате съёмки или описанию того, что изображено на фотографии. После того, как Gemini отобразит список найденных объектов, пользователь может нажать на миниатюру какого-то конкретного снимка или альбома, чтобы открыть его в «Google Фото». При необходимости снимки можно по одному перетаскивать из окна Gemini в другие приложения. Google не объявляла, когда интеграция Gemini с сервисом «Google Фото» станет доступна за пределами рынка США и получит поддержку большего количества языков. Вероятно, это произойдёт после того, как разработчики убедятся в том, что алгоритм работает полностью корректно. Google оставила миллионы смартфонов без обновлений безопасности — поддержка Android 12 прекращена

14.04.2025 [22:41],

Анжелла Марина

Пользователи устройств на базе Android 12 и 12L больше не будут получать обновления безопасности от Google. Компания прекратила поддержку этих версий операционной системы с 31 марта 2025 года. Производители устройств теперь самостоятельно должны исправлять уязвимости, однако не все смогут это делать.

Источник изображения: AI Согласно апрельскому бюллетеню безопасности Android, опубликованному на прошлой неделе, исправления уязвимостей больше не выпускаются для Android 12 и 12L, а владельцы устройств с этими версиями ОС остаются без официальной защиты от новейших киберугроз. Как сообщает портал Android Authority, мартовский бюллетень безопасности стал последним, в котором упоминались патчи для этих систем.

Источник изображения: wikipedia.org Производители устройств, желающие продолжить поддержку Android 12, должны самостоятельно внедрять обновления безопасности. Это возможно для крупных компаний, например, Huawei, чья оболочка EMUI, разработанная компанией для своих смартфонов, до сих пор основана на Android 12. Но это может стать проблемой для брендов с ограниченными ресурсами. Эксперты рекомендуют рассмотреть возможность обновления Android 12 или 12L до более современной версии ОС либо замену устройства. Хотя приложения Google и модули Project Mainline (система обновлений компонентов) могут продолжать получать обновления, ядро системы останется уязвимым. Поэтому специалисты советуют использовать устройства на этих операционных системах лишь в качестве медиаплеера или камеры видеонаблюдения. Напомним, Android 12 был выпущен 4 октября 2021 года, а Android 12L — 7 марта 2022 года. Таким образом, срок поддержки составил около 3,5 лет, что соответствует стандартной практике Google по обеспечению безопасности предыдущих версий Android. Google создала ИИ-модель DolphinGemma для общения с дельфинами

14.04.2025 [18:45],

Сергей Сурабекянц

Дельфины считаются одними из самых умных существ на планете. Они умеют сотрудничать, обучать друг друга новым навыкам и узнавать себя в зеркале. Десятилетиями учёные пытаются понять сложный набор свистов и щелчков, которые дельфины используют для общения. Похоже, что исследователи вскоре смогут существенно продвинуться в этом вопросе при помощи новой открытой ИИ-модели от Google и смартфонов Pixel.

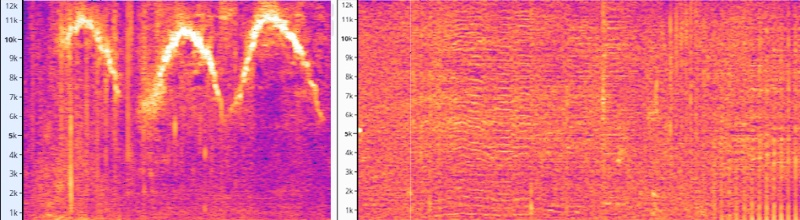

Источник изображений: Google В поисках новых областей для применения генеративного ИИ Google заинтересовалась сотрудничеством с проектом Wild Dolphin Project (WDP). Эта группа исследователей изучает поведение и взаимоотношения сообщества атлантических пятнистых дельфинов с 1985 года. Одной из главных задач, стоящих перед WDP, является анализ влияния издаваемых дельфинами звуков на их социальное взаимодействие. Понимание структуры и паттернов «голосового общения» дельфинов необходимо для определения того, достигает ли оно уровня полноценного языка. «Мы не знаем, есть ли у животных слова», — говорит Дениз Херцинг (Denise Herzing) из WDP.

Источник изображения: Wild Dolphin Project Благодаря десятилетиям подводных записей исследователям удалось связать некоторые базовые действия с определёнными звуками. Например, им удалось выявить характерные свисты, которые, по-видимому, используются как имена, что позволяет двум особям находить друг друга на большом расстоянии. Дельфины также постоянно издают звуковые паттерны, названные учёными «пронзительный крик», во время конфликтов. Конечная цель WDP — заговорить на дельфиньем языке, если он действительно существует. Это стремление привело к созданию огромного, тщательно размеченного набора данных, который слишком трудоёмок для анализа человеком, но, по словам Google, идеально подходит для обработки с помощью генеративного ИИ. Генеративная ИИ-модель DolphinGemma основана на открытых моделях искусственного интеллекта Gemma от Google. Она использует разработанную Google аудиотехнологию SoundStream. Модель была обучена с использованием акустического архива проекта Wild Dolphin. Команда надеется, что DolphinGemma поможет выявить сложные закономерности, которые позволят создать общий словарь. DolphinGemma работает так же, как языковые модели, ориентированные на человека: она получает запрос и предсказывает следующий токен. Учёные полагают, что эти предсказанные токены могут оказаться звуковыми последовательностями, которые будут поняты дельфинами.  Google разработала DolphinGemma с учётом исследовательского подхода WDP. Учёные используют телефоны Pixel в полевых условиях, что накладывает дополнительные требования к модели. Запуск моделей ИИ на смартфоне — сложная задача из-за ограниченных ресурсов. Чем больше и функциональнее модель, тем больше оперативной памяти и вычислительных мощностей ей требуется. DolphinGemma обучена примерно на 400 миллионах параметров, что совсем немного для типичных современных моделей, количество параметров которых исчисляется десятками миллиардов. В течение последних нескольких лет WDP использует устройство, созданное в Технологическом институте Джорджии, под названием CHAT (Cetacean Hearing Augmentation Telemetry), на основе смартфона Pixel 6. Команда применяет CHAT для записи, прослушивания и синтеза голосов дельфинов.

Источник изображения: Georgia Institute of Technology На летний исследовательский сезон 2025 года Google предоставит членам команды WDP смартфоны Pixel 9, что позволит CHAT одновременно запускать модели глубокого обучения и алгоритмы сопоставления шаблонов. Учёные на данном этапе не планируют передавать сгенерированные DolphinGemma звуки непосредственно в CHAT, то есть оба подхода будут использоваться параллельно. Конечно, маловероятно, что DolphinGemma и новый CHAT мгновенно позволят людям запросто общаться с дельфинами, но есть надежда, что со временем система обеспечит хотя бы базовое взаимодействие. Как и другие модели Gemma, DolphinGemma является проектом с открытым доступом. Google сделает модель общедоступной уже этим летом. Хотя DolphinGemma была обучена на звуках атлантических пятнистых дельфинов, Google предполагает, что её можно будет адаптировать и для других видов китообразных. В завершение трудно удержаться и не процитировать отрывок из романа Дугласа Адамса ( Douglas Noël Adams) «Автостопом по Галактике»: «Важный и широко известный факт: не всегда то, что кажется — правда. Например, на планете Земля человек всегда считал, что он разумнее дельфинов потому, что многого достиг — придумал колесо, Нью-Йорк, войны и так далее — в то время, как дельфины только тем и занимались, что развлекались, кувыркаясь в воде. Дельфины же, со своей стороны, всегда считали, что они намного разумнее людей — именно по этой причине». И ещё одна цитата — из книги «Человек-дельфин» знаменитого ныряльщика Жака Майоля ( Jacques Mayol): «Что же тогда? Чего мы хотим добиться? …А я отвечу вам : нам надо избавиться от нашего эгоизма, от этого подлого чудовища, которое в конце концов обернётся против человека и сотрёт его с лица земли к большой пользе всех других живущих видов, и прежде всего дельфина. Мы же лицемерны. Человек обожает дельфинов! Да, для своего личного удовольствия, чтобы сделать из них вассалов, домашних слуг, рабов, роботов, несущих на спине бомбы. И он близок к этому». Google устранила уязвимость в Chrome, существовавшую 23 года

14.04.2025 [15:21],

Анжелла Марина

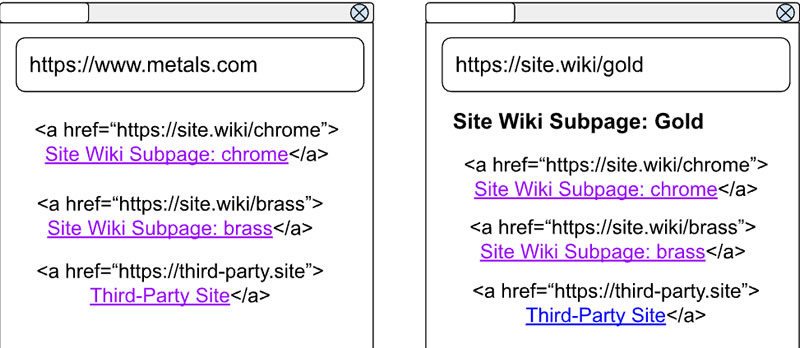

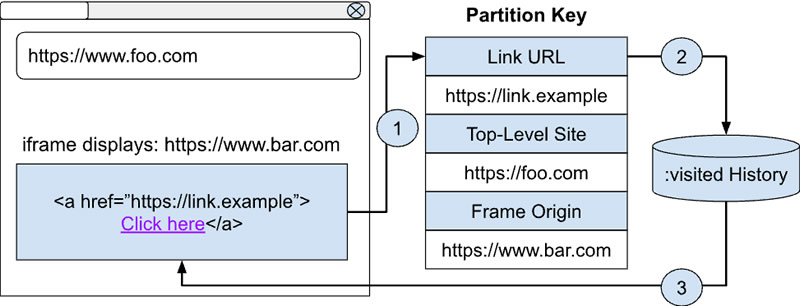

Google закрыла уязвимость в веб-обозревателе Chrome, которая могла раскрывать историю посещённых пользователем сайтов. Проблема существовала с начала 2000-х годов и была связана с тем, как браузеры отображают посещённые ссылки.

Источник изображения: Solen Feyissa / Unsplash Чтобы отобразить ссылки, которые пользователь посещал ранее (они помечаются фиолетовым цветом), браузер должен отслеживать эти страницы с помощью каскадных таблиц стилей через селектор :visited. Как объяснили в Google, суть ошибки заключалась в том, что информация о том, какие ссылки пользователь уже посещал, сохранялась без разделения конфиденциальности между посещаемыми сайтами. То есть, любой сайт мог определить, была ли ранее нажата определённая ссылка, даже если она отображалась на совершенно другом ресурсе.

Источник изображения: developer.chrome.com «Вы просматриваете сайт A и кликаете по ссылке на сайт B. Позже вы заходите на условно вредоносный сайт C, который тоже содержит ссылку на сайт B. Он может узнать, что вы уже были на сайте B, просто определив ссылку по цвету», — пояснили в Google.

Источник изображения: developer.chrome.com

Впервые на проблему обратил внимание исследователь безопасности Эндрю Кловер (Andrew Clover) ещё в 2002 году. Он визуально продемонстрировал все этапы возможной атаки, опираясь на исследовательскую статью Принстонского университета «Timing Attacks on Web Privacy». Исправление уже включено в бета-версию обновления Chrome 136. Теперь информация о посещённых ссылках будет храниться отдельно для каждого сайта и не будет передаваться между ресурсами. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |