⇣ Содержание

|

Опрос

|

реклама

Самое интересное в новостях

GPU из будущего: обзор GeForce GTX TITAN

Выпустят ли видеокарту на базе GPU GK110? Ответ на этот вопрос мы больше всего хотели услышать от NVIDIA и тогда, когда флагманскую позицию в линейке GeForce 600 занял более простой чип GK104, и тогда, когда GK110 дебютировал в составе профессиональных ускорителей Tesla K20/K20X. Вся история с задержкой выхода «большого Кеплера», а затем и спецификации Tesla K20/K20X заставили было усомниться в перспективах GK110 как игрового GPU. Всем известно, что у NVIDIA были трудности с освоением техпроцесса 28 нм на TSMC, которых не избежал даже гораздо более простой чип GK104, что же говорить о монстре из семи миллиардов транзисторов, которым является GK110. И вот мы видим, что новые модели Tesla получили довольно-таки скромные частоты GPU, а из 15 потоковых мультипроцессоров (SMX) GK110 работоспособны 13 или 14. При этом TDP карточек уже достигает 225-235 Вт. Подводя итоги 2012 года по дискретной графике, мы предположили два варианта развития событий. Либо NVIDIA все-таки решится попытать счастья с GK110, выпустив на его основе GeForce GTX 780, либо оправдается более скучная версия и в GTX 780 установят обновленную версию GK104. Однако NVIDIA опровергла все предположения о том, в каком качестве представят адаптер на GK110, когда и каков он будет вообще. ⇡#Технические характеристики, ценаПервая неожиданность состоит в том, что адаптер GeForce GTX TITAN на GK110 не относится к линейкам GeForce 600 или 700, он как бы сам по себе. И это значит, что место на плате GTX 780 все-таки зарезервировано для GK114. Второе — то, что TITAN вышел в свет уже сейчас, хотя первый продукт на базе архитектуры Kepler отмечает годовщину только в марте. Но главное — это тот факт, что GK110 выбрался из производственных неурядиц с минимальными потерями. Из 15 SMX, как и у Tesla K20X, не работает лишь один. Остальные 14 SMX дают фантастическое число активных вычислительных блоков: 2688 ядер CUDA, 224 текстурных модуля, 28 ROP. Сравните с формулой GK104: 1536 ядер CUDA, 128 текстурников, 32 ROP. GPU TITAN работает на базовой частоте 836 МГц, Boost Clock равняется 876 МГц. Кроме того, GK110 в GTX TITAN не имеет того слабого места, коим у GK104 является 256-битная шина памяти. Здесь шесть работающих контроллеров дают разрядность 384 бит — как у GTX 580 и Radeon HD 7970. Объем набортной памяти — щедрые 6 Гбайт, эффективная частота — стандартные для старших карт Kepler 6008 МГц. Вся эта роскошь, разумеется, далась ценой высокого энергопотребления. TDP GeForce GTX TITAN составляет 250 Вт против 195 Вт у GTX 680. TITAN также будет чрезвычайно дорогой картой. Рекомендованная цена в США составляет $999, в России — 34 990 руб. Столь дорогих видеоадаптеров с одним GPU свет еще не видел. Но скажем в защиту TITAN, что GTX 690 на момент релиза стоил дороже — 35 990 руб., а по производительности, судя по спецификациям TITAN, они вполне сопоставимы. В розничной продаже TITAN будет доступен начиная с 4 марта. Первыми вендорами, которые представят видеокарты в нашем регионе, станут ASUS, Gigabyte, Palit и Zotac.

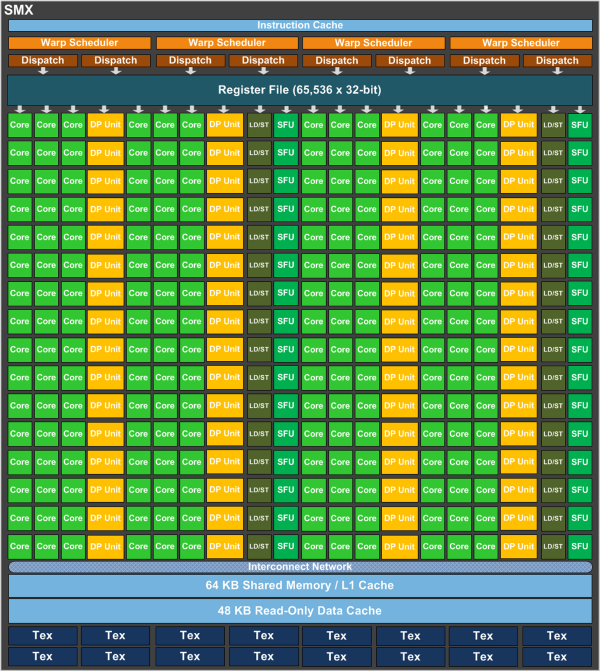

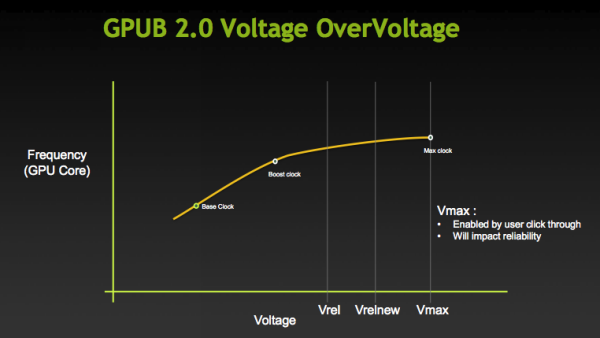

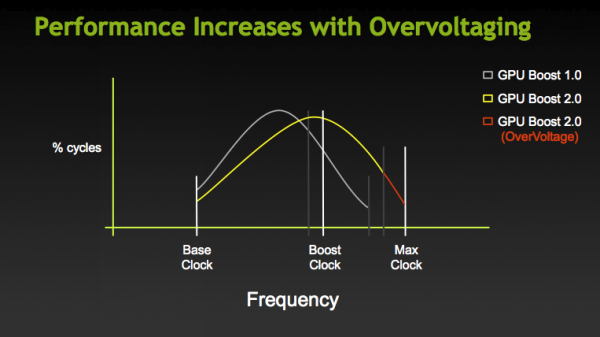

⇡#Архитектура GK110GK110 сохранил все черты архитектуры Kepler, которую мы подробно рассматривали в обзоре GeForce GTX 680, за одним важным исключением, касающимся устройства потоковых мультипроцессоров. Как и у GK04, SMX содержит 192 ядра CUDA, 32 блока Load/Store и 32 блока специальных функций (SFU). Но в GK110 к этому прибавили 64 ядра двойной точности (FP64). Всего в TITAN получается 896 активных ядер с поддержкой FP64.  GK104 в каждом SMX также имеет восемь специальных ядер, способных выполнять инструкции FP64 за один такт. Но поскольку ядер CUDA, поддерживающих лишь FP32, там 192, то теоретическая производительность GK104 в задачах с двойной точностью составляет 1/24 от задач с одинарной точностью. Для сравнения: GPU Tahiti от AMD способен обрабатывать FP64 со скоростью 1/2 от FP32. Так как число ядер FP64 и FP32 в кристалле GK110 соотносится как 1 к 3, то теоретически он в состоянии выполнять нагрузку FP64 на 1/3 от скорости FP32. Но на практике это может быть не совсем так. По умолчанию ядра FP64 работают на 1/8 частоты других компонентов SMX, что дает такую же скорость 1/24, как у GK104. Чтобы задействовать их на полной частоте, есть специальная опция в панели управления драйвера, но общая тактовая частота GPU при этом снижается. Кстати, SMX в GK110 по-прежнему пользуется статическим планировщиком, представленным в GK104, что негативно сказывается на производительности в неграфических вычислениях, но если GeForce GTX 680 по этой причине уступал GTX 580 в задачах на GP-GPU, то GK110 наверняка компенсирует недостаток огромным числом вычислительных блоков. Неспроста за счет Tesla K20 укомплектован суперкомпьютер Titan в Oak Ridge National Laboratory (ORNL), который возглавил Top 500 прошедшей осенью. Отсюда, кстати, и гордое имя GeForce GTX TITAN. ⇡#GPU Boost 2.0NVIDIA представила новую версию технологии динамического управления частотой и напряжением графического процессора. Первое изменение, которое произошло в алгоритме GPU Boost: в качестве переменной, от которой зависит частота и напряжение GPU, может быть не только лимит мощности (Power Target), как было раньше, но и температура процессора. Соответственно, в утилитах для разгона теперь появились два отдельных слайдера для того и другого критерия, и можно отдать приоритет одному из них. Что более интересно, NVIDIA, наконец, дала возможность повышать напряжение на GPU. Однако делается это не привычным способом, характерным для видеоадаптеров со статическим напряжением. В логике GPU Boost есть функция, связывающая значения частоты и напряжения. Если алгоритм решает, что лимит температуры или мощности позволяет поднять частоту, то устанавливается и соответствующее ей напряжение. И что нам позволяет сделать новоприобретенная функция OverVoltage, так это предоставить в распоряжение автоматики еще несколько ступенек частоты и напряжения. А вот доберется ли до них GPU под нагрузкой, уже зависит от температуры или мощности. Кроме того, в экспериментах с разгоном TITAN замечено, что даже в пределах диапазона частот и напряжений, которые доступны видеокарте без помощи OverVoltage (до отметки Vrel на графике), активация этой опции заставляет более агрессивно задействовать частотный потенциал.  К примеру, предельная частота Boost Clock, которую мы зарегистрировали в бенчмарках, составляет 1006 МГц, а напряжение — 1,162 В. Если максимизировать уровни Power Target, Temp Target и OverVoltage, то частота может подниматься вплоть до 1032 МГц, а напряжение — до 1,2 В. С другой стороны, если при максимальных Power Target и Temp Target в определенной сцене мы наблюдали частоту и напряжение 992 МГц и 1,15 В, то максимальный OverVoltage превращает их в 1019 МГц и 1,187 В.  В функции GPU Boost 2.0 также входит возможность разгонять дисплей. Да-да, с помощью утилиты, поддерживающей эту опцию, можно попробовать увеличить частоту вертикальной развертки, скажем, с 60 до 80 Гц, дабы одновременно наслаждаться высоким фреймрейтом и вертикальной синхронизацией. ⇡#КонструкцияФизически GeForce GTX TITAN выполнен в стилистике GeForce GTX 690. Такой же цельнометаллический корпус системы охлаждения и пластиковое (простите, поликарбонатное) окошко, открывающее взору ребра радиатора, а через несколько месяцев эксплуатации — залежи пыли. TITAN даже ближе к совершенству, чем его двухпроцессорный собрат, потому что из металла у него изготовлены абсолютно все детали корпуса, включая п-образные пластины, идущие вдоль длинных сторон. А у GTX 690 они сделаны из скучного крашеного пластика. NVIDIA GeForce GTX TITAN На торце карты — знакомый логотип со светодиодной подсветкой и бархатистой поверхностью soft-touch, чтобы от изделия можно было получить одновременно как визуальное, так и тактильное удовольствие. NVIDIA GeForce GTX TITAN NVIDIA GeForce GTX TITAN Система охлаждения включает радиатор с испарительной камерой в основании и массивную металлическую раму, которая целиком закрывает печатную плату и служит для отвода тепла от микросхем памяти и транзисторов системы питания. Чипы памяти на оборотной стороне PCB вынуждены охлаждаться «сами по себе». В хвосте платы за турбинкой к раме прикреплен дополнительный блок алюминиевых ребер, через который проходит часть забираемого турбинкой воздуха. Но основной выхлоп идет через прорези в крепежной планке, наружу из корпуса. Как и у GTX 680 и GTX 690, крыльчатка кулера TITAN изготовлена из звукопоглощающего материала. Видеокарта действительно очень тихо работает в штатном режиме и даже на 100% оборотов система охлаждения еще не очень сильно действует на нервы. NVIDIA GeForce GTX TITAN NVIDIA GeForce GTX TITAN Разводка портов на задней панели абсолютно такая же, как у старших представителей линейки GeForce 600. Есть два выхода Dual-Link DVI, а также полноформатные разъемы DisplayPort и HDMI с поддержкой 4K-разрешений. NVIDIA GeForce GTX TITAN ⇡#ПлатаКак и GK104 в GeForce GTX 680, процессор GK110 в GTX TITAN довольствуется шестью фазами питания. Контроллер — ON NCP4206. Еще две фазы достались видеопамяти. Видеопамять набрана микросхемами Samsung K4G20325FD-FC03 с номинальной эффективной тактовой частотой 6 ГГц. NVIDIA GeForce GTX TITAN NVIDIA GeForce GTX TITAN Сам GPU, вопреки ожиданиям и сомнительным фотографиям, появление которых предшествовало официальному релизу, установлен без теплорассеивателя, благодаря чему открывается вид на колоссальный кристалл, размером примерно с пятирублевую монету. ⇡#Методика тестирования

Набор бенчмарков

⇡#Участники тестированияВ тестировании приняли участие следующие видеокарты:

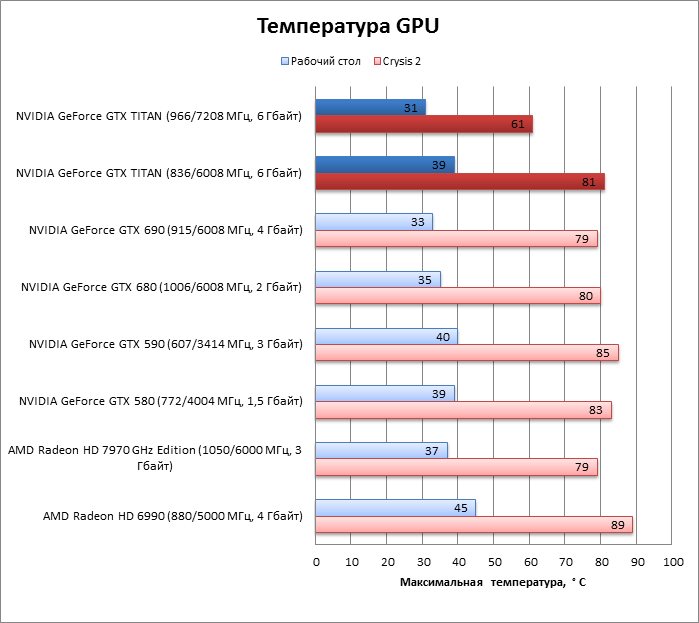

⇡#Разгон, температура, энергопотреблениеБазовая частота GPU составляет 836 МГц, а максимальное значение Boost Clock, зарегистрированное в бенчмарках, составило 1006 МГц (прибавка в 169 МГц). В разгоне базовую частоту удалось увеличить до 966 МГц. Значения Power Target и Temp Target по умолчанию установлены на уровне 100% и 80 °C. Для начала мы увеличили их до максимума — 106% и 94 °C, с приоритетом мощности. В таком режиме Boost Clock достигала 1124 МГц (+157 МГц к базовой частоте). Если же отдать приоритет температуре и прибегнуть к помощи OverVoltage, задав смещение напряжения на максимально допустимые три шага (+37 мВ), то Boost Clock начинает подниматься и до 1150 МГц (+183 МГц), а напряжение — вплоть до 1,2 В.

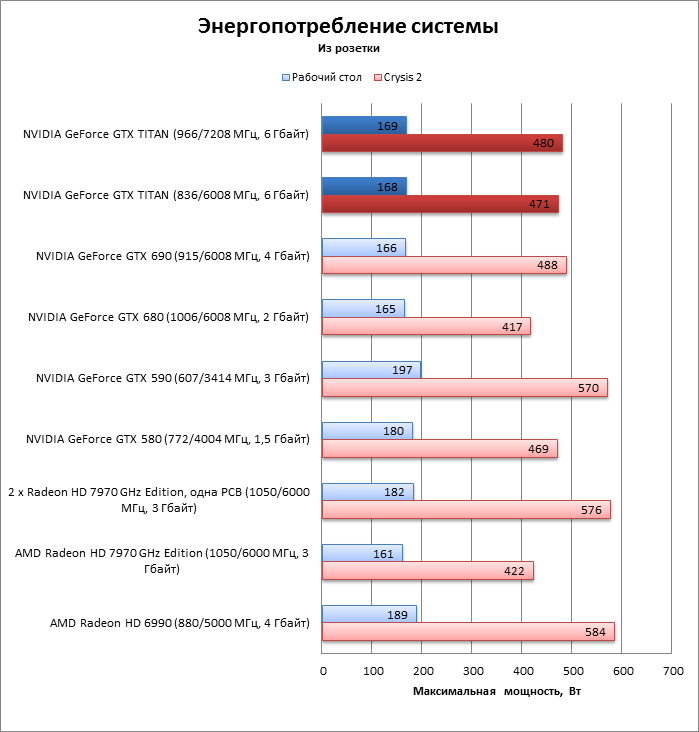

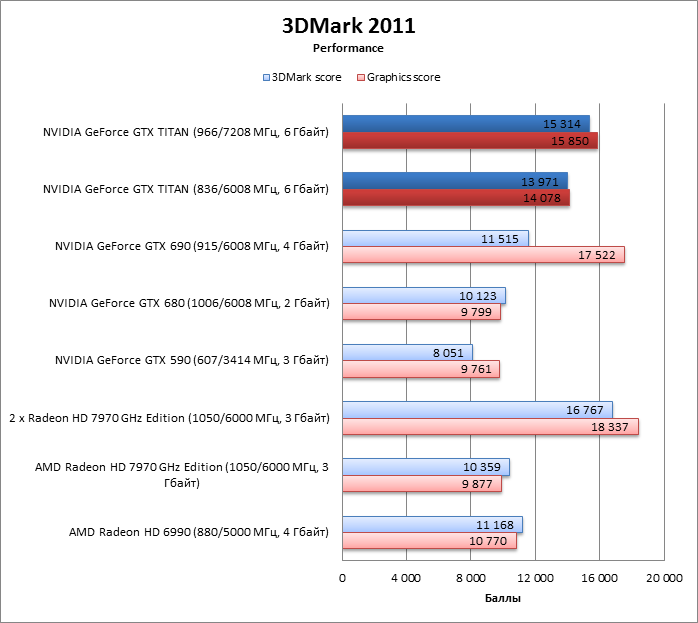

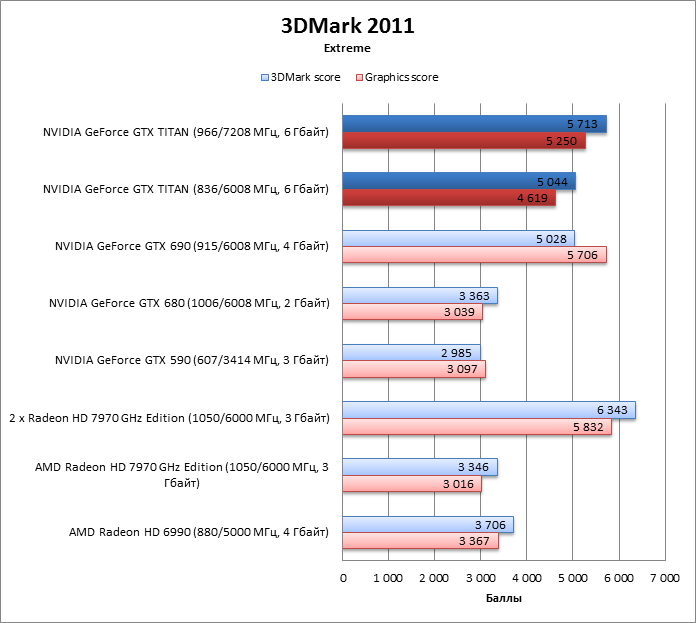

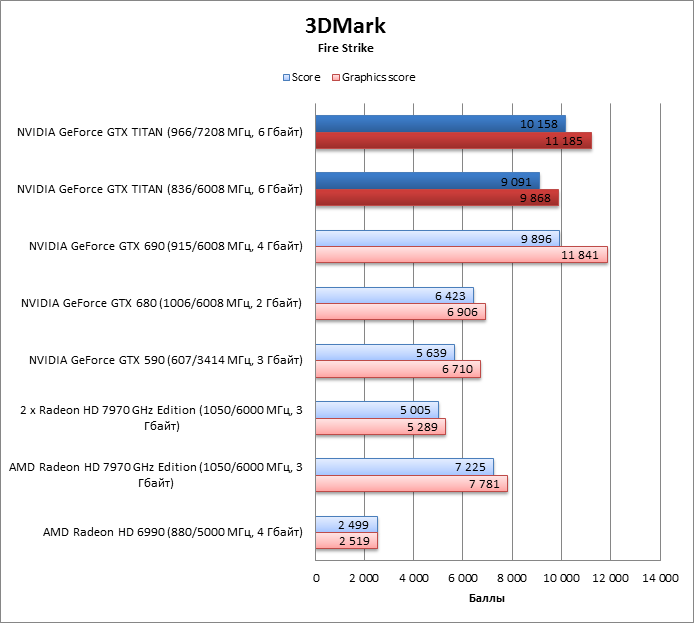

По пиковому энергопотреблению TITAN значительно превосходит как GeForce GTX 680, так и Radeon HD 7970 GHz Edition. Он кушает почти ровно столько же, что и GTX 580, тем самым вновь утверждая подзабытую истину, что GTX — это ПЕЧ. GeForce GTX 690 расположился на диаграмме поблизости: разница с TITAN составляет единицы ватт. В тесте также участвует наша «темная лошадка», условный Radeon HD 7990 GHz Edition — два GPU Tahiti XT2, расположенные на одной плате и работающие на стандартных для HD 7970 GHz Edition тактовых частотах. Пока мы не будем раскрывать название и штатные спецификации этой карты, так как в ближайшее время с ней состоится отдельное знакомство. Так вот, эта карта далеко не столь экономична, как GTX 690 или TITAN, и соперничает по максимальному энергопотреблению со знаменитыми своим аппетитом GTX 590 и HD 6990. Примечательно также то, что разгон TITAN почти никак не отражается на энергопотреблении. Похоже, что GPU Boost и в штатном режиме исчерпывает резерв мощности.  Система охлаждения TITAN оправдала возложенные на нее ожидания. Под нагрузкой чип GK110 нагревается не больше, чем вдвое меньший GK104 в составе GTX 680. А запаса мощности кулера достаточно для того, чтобы при разгоне адаптера снизить температуру еще на 20 °С.  ⇡#Производительность, синтетические тесты3DMark 2011 (DirectX 11)

3DMark

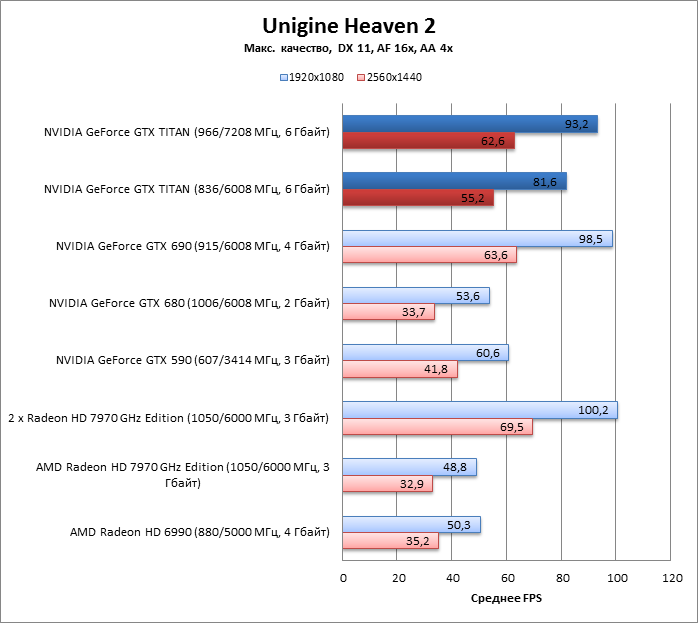

Unigine Heaven 2 (DirectX 11)

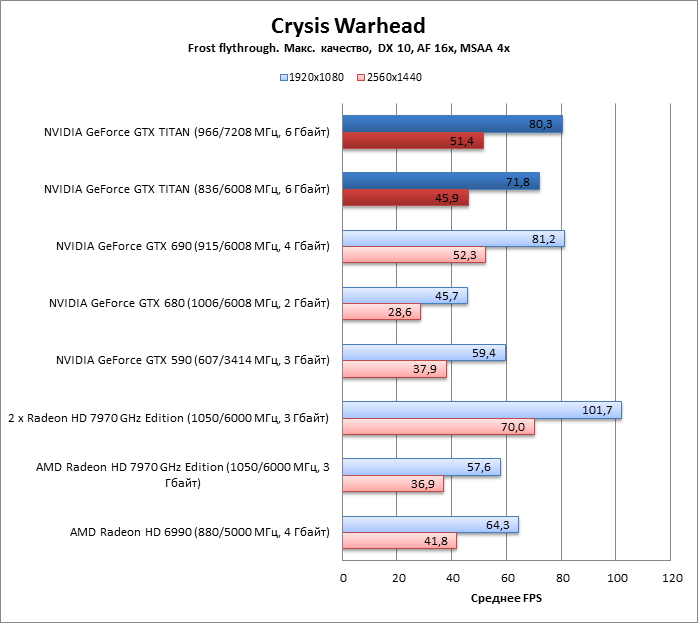

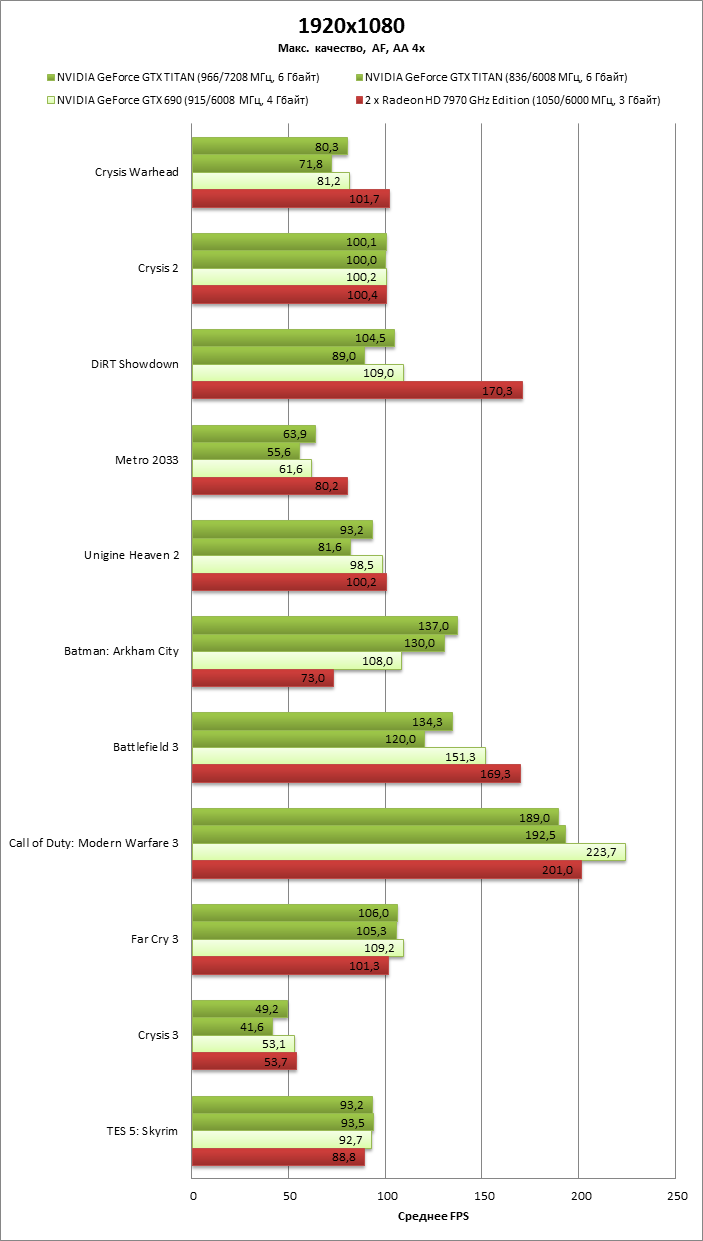

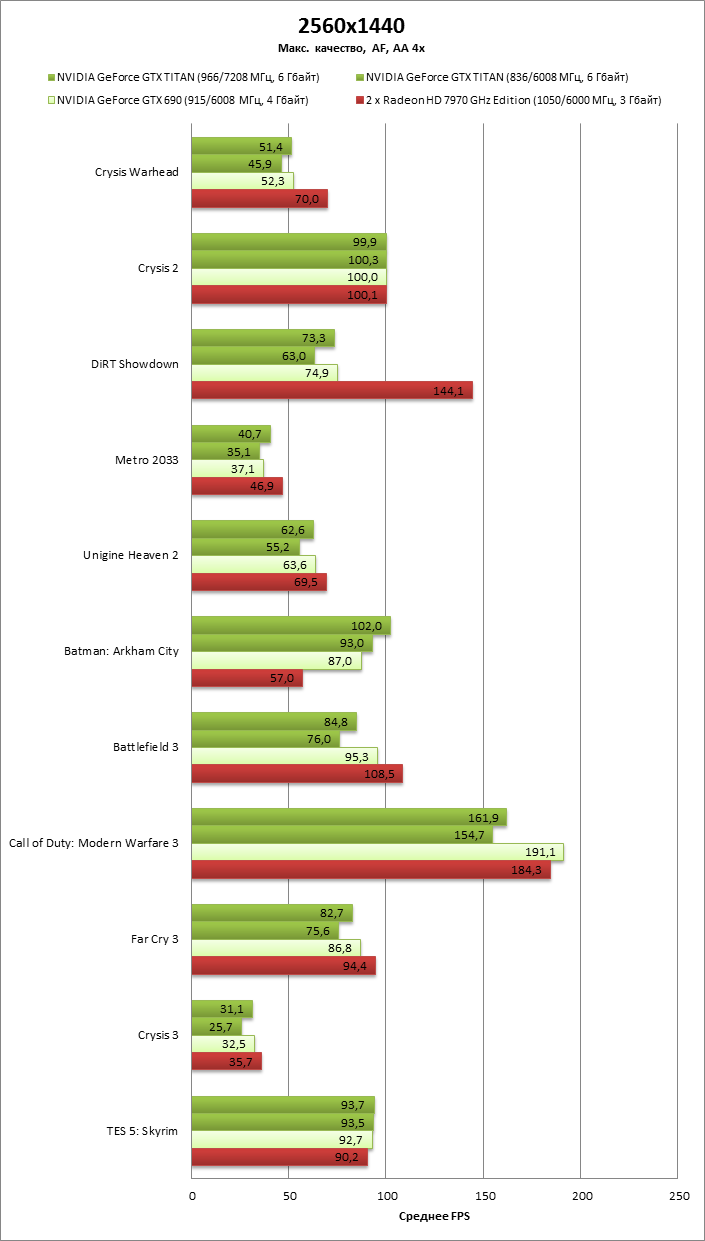

⇡#Производительность, игровые тестыCrysis Warhead (DirectX 10)

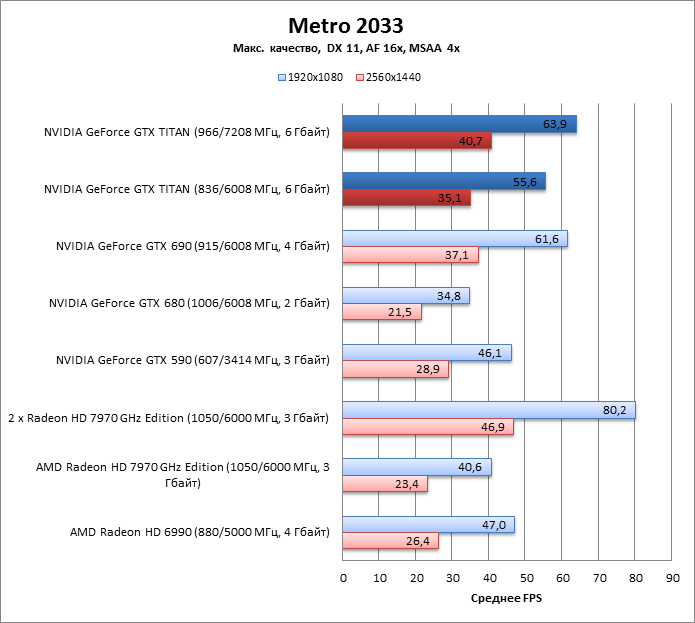

Metro 2033 (DirectX 11)

Crysis 2 (DirectX 11)

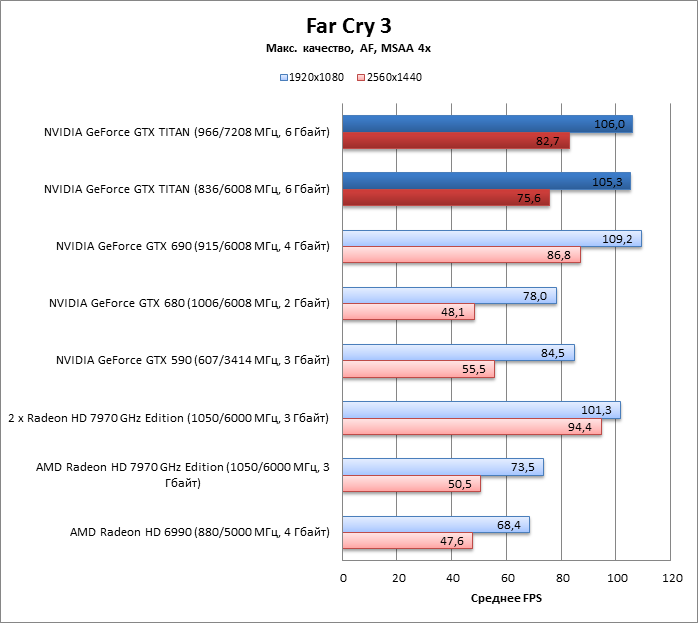

Far Cry 3 (DirectX 11)

Battlefield 3 (DirectX 11)

Crysis 3 (DirectX 11)

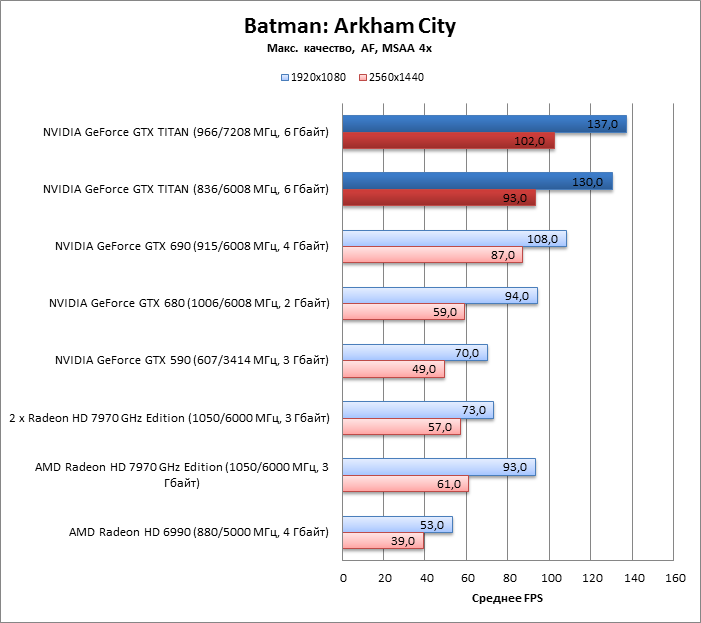

Batman: Arkham City (DirectX 11)

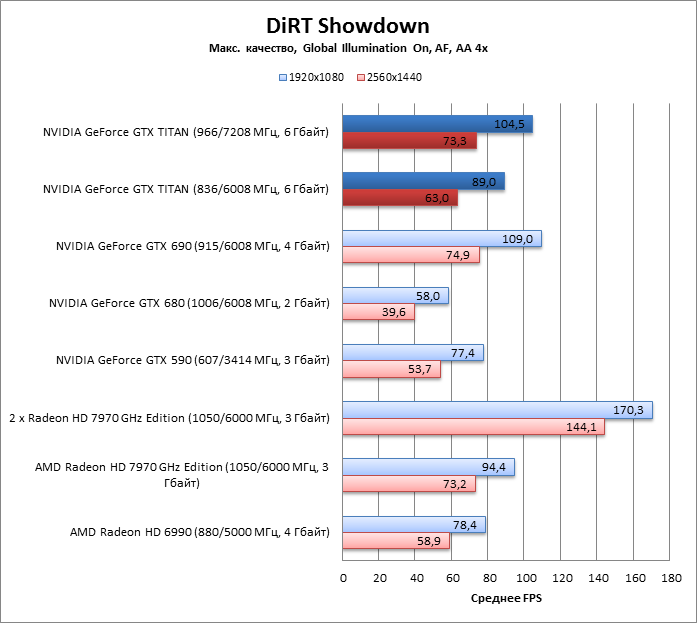

DiRT Showdown (DirectX 11)

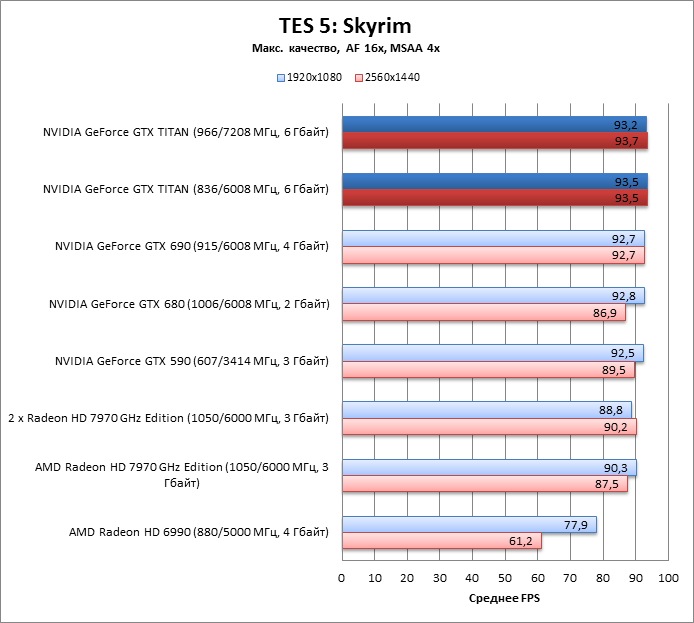

The Elder Scrolls 5: Skyrim (DirectX 9)

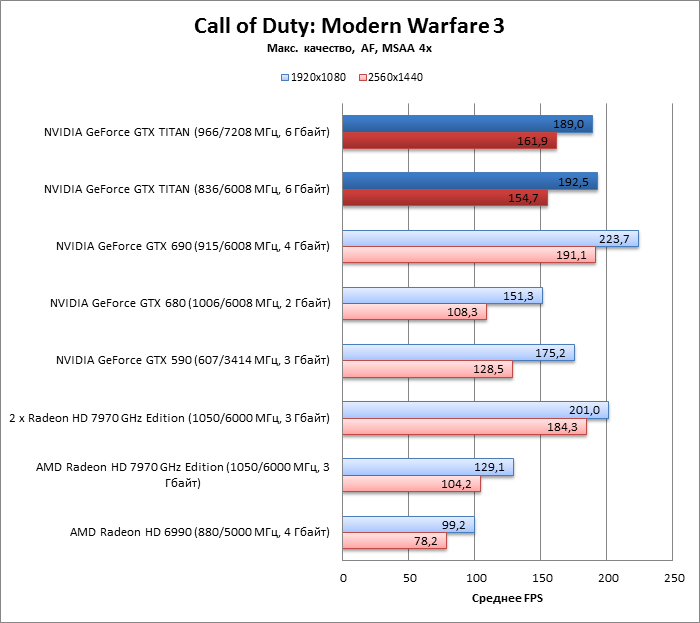

Call of Duty: Modern Warfare 3 (DirectX 9)

⇡#GeForce GTX TITAN vs GTX 690 vs 2xRadeon HD 7970 GHz EditionПервое, что бросается в глаза при взгляде на сводную таблицу, это то, что разгон TITAN хотя и корректирует его положение по сравнению с соперниками, но в абсолютных значениях не всегда дает значимую прибавку FPS. На увеличение частот хорошо откликаются DiRT Showdown, Unigine Heaven 2 и Battlefield 3. В других же тестах эффект от разгона совсем невелик. В общем, как и в случае с другими видеокартами семейства Kepler с технологией GPU Boost, мегагерцы у GTX TITAN подчас имеют отчетливый привкус кукурузы. Также видно, что TITAN всегда идет где-то рядом с GTX 690, а иногда даже опережает его. Вот двойной Radeon HD 7970 GHz Edition оказался более сильным соперником, TITAN догоняет его не так часто.   ⇡#ВыводыДля NVIDIA TITAN стал ярким достижением и демонстрацией ее инженерного потенциала. Несмотря на все трудности, которые сопровождали GK110 и архитектуру Kepler в целом на пути от проектирования к коммерческим продуктам, мы все-таки получили этот технологический шедевр. Мир еще не видел такого огромного GPU, и производительность поражает воображение. TITAN просто уничтожил теперь уже бывших однопроцессорных фаворитов – GeForce GTX 680 и Radeon HD 7970 GHz Edition и небезуспешно соревнуется с двумя GPU в лице GeForce GTX 690 или условного Radeon HD 7990 GHz Edition. В целом GTX 690 удерживает лидерство, но у TITAN есть другие преимущества, главное из которых — более предсказуемая производительность, которая не зависит от эффективности SLI в той или иной игре. А также поддержка вычислений с двойной точностью на скорости 1/3 от FP32 для тех, кому это необходимо. Кроме того, NVIDIA утверждает, что тройка «Титанов» в SLI имеет большую производительность, чем два GTX 690, во что мы охотно верим, зная, что при переходе от трех к четырем GPU скорость масштабируется не очень хорошо. Тандем Radeon HD 7970 GHz Edition — более серьезный противник для TITAN. Но посмотрите, как много энергии потребляет эта парочка, даже если GPU находятся на одной плате. Для AMD сравнение даже единственного HD 7970 GHz Edition с TITAN очень обидно, потому что они находятся в абсолютно одинаковом энергетическом бюджете 250 Вт, а по производительности совершенно несопоставимы. С другой стороны, хотя NVIDIA и удалось добиться столь впечатляющего соотношения двух важнейших качеств дискретного видеоадаптера — производительности и энергопотребления, но третье качество — цена, отчасти зависимая от себестоимости и выхода годных чипов, совершенно упущено. Ведь тысяча долларов за видеокарту с одним GPU — это тоже своеобразный рекорд. В принципе, в рознице все выглядит справедливо: если TITAN сравним по производительности с адаптерами на двух GPU, то не грех и попросить за него такие же деньги. Но если взглянуть шире, то ситуация говорит о том, что хотя мастерство разработчиков и изысканные энергосберегающие технологии уже позволяют создать GPU с 7,1 миллиарда транзисторов, но производство (по крайней мере, для NVIDIA) еще не готово выпускать таких монстров в по-настоящему больших количествах. GK110 и TITAN — это в своем роде привет из будущего. GPU такого масштаба наверняка станут привычным делом для топовых видеоадаптеров через одно-два поколения.  Если Вы заметили ошибку — выделите ее мышью и нажмите CTRL+ENTER.

|

||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||