⇣ Содержание

|

Опрос

|

реклама

Самое интересное в новостях

ИИтоги апреля 2024 г.: парад моделей — и не только

⇡#Генерация без регистрацииНа поверку не оказалось-таки шуткой опубликованное 1 апреля объявление в официальном блоге OpenAI о предоставлении всем желающим свободного доступа к ChatGPT на базе GPT 3.5 — свободного в том смысле, что окошко для ввода запроса появляется на страничке проекта сразу же, не требуя предварительной авторизации. Правда, (пока?) только при заходе с американских IP-адресов — и с целым рядом оговорок, включая невозможность экспорта чата и «несколько более жёсткую политику ограничений» на содержание пользовательских запросов. Кстати, всего-то год назад OpenAI пригрозила судом популярному проекту GPT4free из-за бесплатного использования GPT4 обходными путями, — и четвёртая версия нейросетевой модели по-прежнему остаётся основным источником дохода компании-разработчика. Так что по состоянию на конец апреля чат-бот на базе GPT 3.5 продолжал оставаться в свободном доступе — хотя многие эксперты в начале месяца опасались, что огромные толпы новоявленных ИИ-хакеров набросятся на модель, лишённую возможности блокировать учётные записи злонамеренных пользователей. В первую очередь, надо полагать, с намерением оттачивать навыки вредоносного промт-инжиниринга; но, как видно, опасения эти не оправдались. Возможно, генеративный ИИ, основанный на GPT 3.5, уже и не годится в качестве объекта для отработки таких навыков, которые были бы применимы к более актуальным моделям? Или у хакеров сегодня другие заботы — вроде поиска путей обхода ограничений на принимаемые Dall-E и Midjourney подсказки для рисования картинок?

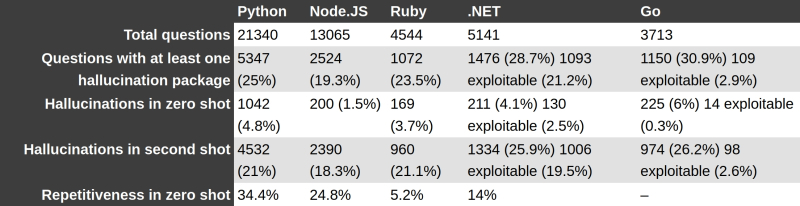

Неутешительные итоги исследования Бара Ланьядо для кода, выдаваемого GPT-4 на разных языках программирования: слишком много галлюцинаций! (Источник: The Register) ⇡#Галлюциногенные зависимостиОдна из основных претензий к генеративному ИИ вызвана его склонностью к «галлюцинациям», т. е. к выдаче не имеющих отношения к реальности ответов на вполне корректно поставленные операторами вопросы. С творческой точки зрения галлюцинации даже приветствуются, особенно в отношении моделей, преобразующих текстовые подсказки в статичные картинки и видеоролики, — но применять генеративный ИИ для научных, инженерных, финансовых и прочих изысканий из-за этой его особенности приходится с серьёзной оглядкой. Что, собственно, подтвердил Бар Ланьядо (Bar Lanyado), исследователь из компании Lasso Security: он заметил, что по крайней мере один вполне солидный проект на GitHub, Alibaba GraphTranslator, требует при установке вручную через Python Package Index (PyPI) инсталляции несуществующей зависимости — пакета под названием huggingface-cli. При этом на другом ИИ-ориентированном популярном программистском ресурсе, HuggingFace, размещён вполне добропорядочный пакет под названием huggingface-cli, который, очевидно, и должен в данном случае разворачиваться. Однако по какой-то причине его создатели предлагают применять для установки команду, аргумент которой не совпадает с именем самого пакета: pip install -U "huggingface_hub[cli]" Ещё в конце 2023 года, изучая — с точки зрения информационной безопасности — генерируемый ИИ-ботами код, Бар Ланьядо зафиксировал, что нередко в тех случаях, когда итоговый продукт опирался на пакет huggingface-cli, в тексте выдаваемой оператору программы проскакивал некорректный вызов — с самим собой напрашивающимся "huggingface-cli" вместо легитимного "huggingface_hub[cli]". Не говоря худого слова, исследователь создал и разместил в онлайновом репозитории подложный пакет, загружавшийся как раз по такому, некорректному, вызову, — и стал дожидаться, когда же произойдёт первое обращение. Вот, собственно, и дождался: уже в первые месяцы 2024-го на подготовленную приманку клюнула разработка такой крупной компании, как Alibaba, — сотрудники (либо контрактные программисты) которой, очевидно, склонны излишне доверять создаваемому генеративным интеллектом коду. Проблема, увы, гораздо шире, чем может показаться на первый взгляд. Эксперимент, проведённый Бар Ланьядо с GPT-4, показал, что в 24,2% случаев заданный ИИ-боту запрос, ответ на который подразумевал выдачу команды на установку некоего ПО через PyPI, приводил к указанию на несуществующие пакеты, — причём почти для 20% из этого количества галлюцинация повторялась с тем же именем. Модель Gemini брала с потолка названия пакетов аж в 64,5% случаев (повторяющихся среди них было 14%), Cohere — 29,1% галлюцинаций, среди которых 24% повторов. Понятно, что, проведя аналогичное исследование, злоумышленники смогут заблаговременно разместить в открытых репозиториях пакеты с «сюрпризами», ожидая, что с их помощью удастся скомпрометировать работу слишком полагающихся на ИИ программистов, — и это лишний аргумент в пользу крайней важности перепроверки выдаваемого ботами кода. ⇡#«Алиса» оживила МашуОтдавать себе полный отчёт в том, что высокотехнологичные решения могут быть несовершенными, готовы даже не все взрослые, — достаточно привести в пример официальный нью-йоркский умный чат-бот, предоставлявший посетителям городского портала недостоверные данные, или введённый американским Конгрессом запрет на использование Microsoft Copilot из-за риска утечки в облако чувствительной информации — просто по невнимательности либо неосторожности операторов, не говоря уже о возможном злом умысле. Тем осторожнее следует подходить к использованию ИИ-инструментов детьми — по крайней мере, такое мнение высказала Анна Митянина, занимающая должность уполномоченного по правам ребёнка в Санкт-Петербурге. В качестве примера госслужащая, которую цитирует РИА «Новости», привела ответ умной колонки «Яндекса» на вроде бы совершенно невинный вопрос о том, почему героиня популярнейшего мультсериала «Маша и медведь» живёт одна в лесу с дикими зверями: «Она всего лишь призрак убитой девочки; именно поэтому она не растёт, а видеть её могут только животные. Родители же не смогли выдержать потери ребёнка и уехали, оставив пустой дом. А донимает Маша медведя потому, что тот и лишил её жизни». Представители компании, что разработала колонку с выдавшей столь мрачный комментарий «Алисой», заявили, что голосовой помощник действительно в ряде случаев мог «некорректно» отвечать на подобные вопросы (хотя тут, скорее, следовало бы проконсультироваться с авторами сценария мультсериала, — может, ИИ попал со своей зловещей догадкой в точку?) — но теперь, по их утверждению, всё исправлено. Более того, колонка предусматривает активацию «детского режима» для ограждения ребёнка от нежелательного контента. Ну и родителям тоже стоит иметь в виду, что полную гарантию от непредсказуемости поведения роботов даёт только полное отсутствие этих самых роботов — по крайней мере, на актуальном этапе развития ИИ. ⇡#Когда проще уже ответитьНеалгоритмический характер работы генеративного ИИ разительно снижает эффективность волюнтаристских ограничений на выдачу контента, который признан нежелательным — по той или иной причине — контролирующими систему людьми. Если некая информация попала в базу данных, на которой модель тренировали, эти данные так или иначе могут быть впоследствии обнародованы уже готовым к эксплуатации чат-ботом, главное — суметь правильно задать ему вопрос. Иногда «правильно» означает просто «долго и упорно»: специалисты Anthropic выявили уязвимость современных генеративных моделей к «взлому длинной очередью» (many-shot jailbreaking), который сводится к заваливанию бота огромным количеством вопросов постепенно уменьшающейся степени невинности — после чего он с куда большей охотой отвечает на тот, на который с первой попытки наотрез отказался бы давать ответ. Детальное исследование, проведённое в рамках поиска серьёзных уязвимостей общедоступных генеративных систем, показало, что «взлому длинной очередью» подвержены прежде всего наиболее совершенные ИИ-модели, отличающиеся от своих предшественниц увеличенным контекстным окном, т. е. объёмом доступных системе данных в пределах одной и той же сессии. Первые популярные умные чат-боты оперировали в пределах буквально нескольких предложений, довольно быстро «забывая», с чего начинался данный конкретный разговор, поэтому вести с ними пространные диалоги не удавалось. Теперь же типичное контекстное окно исчисляется десятками тысяч слов, что повышает способность модели локально дообучаться — лучше решать определённого типа задачи, если они во множестве повторяются в пределах текущей сессии. В результате — постепенно повышая условную степень недопустимости отправляемых модели запросов — оператор может заставить ту выдать ответ, прежде блокировавшийся внутренними механизмами защиты. Понятно, что проще всего избежать «взлома длинными очередями» получится, если урезать размеры контекстного окна, — но это негативно скажется на способностях ИИ-бота и на его привлекательности. Придётся искать обходные пути — которые наверняка дополнительно удорожат общедоступные генеративные модели в облаках, а заодно сделают их ещё более дорогостоящими и ресурсоёмкими. ⇡#Можно играть вдвоёмСтуденты вовсю пользуются ChatGPT и подобными ему ботами для написания курсовых и дипломных работ — это давно уже не новость. Но теперь и преподаватели начинают применять генеративный ИИ для проверки работ учащихся — а почему, собственно, и нет? Стоит только взять фрагмент студенческого творения, подать его на вход модели с достаточно широким контекстным окном — и поинтересоваться у бота… нет, не степенью оригинальности анализируемого произведения: это было бы как раз контрпродуктивно. Особенно в отношении курсовых, которые и в докомпьютерную эпоху чаще всего представляли собой компиляции проведённых кем-то другим исследований — в идеале, конечно, с умом и тщанием отобранных. Гораздо разумнее задавать боту другой вопрос, а именно — каким образом можно улучшить предъявленную студенческую работу? По оценке консалтинговой компании Tyton Partners, осенью 2023 г. около половины учащихся американских колледжей применяли для создания своих трудов ИИ — в большей или меньшей степени. Доля же преподавателей, привлекавших хотя бы изредка генеративные модели в качестве инструмента при решении своих повседневных задач, составляла тогда 22% — и это притом, что немало учебных заведений прямо запрещают студентам пользоваться умными ботами. Однако многие преподаватели теперь чаще рекомендуют учащимся прогонять свои же собственные работы перед сдачей через ChatGPT или его аналоги — как раз в поисках рекомендаций по улучшению текста: в плане стилистики, фактологии, подбора источников и пр. ИИ может выступать в таком случае как полезный помощник и для студента, и для профессора — расширяя горизонты познания для первого и снимая часть нагрузки со второго. По крайней мере, уверены специалисты Google, в конечном итоге использование генеративного ИИ повлияет на образование в области computer science не меньше, чем появление портативного калькулятора — на преподавание математики. По каким-то направлениям оно будет исчезающе мало (для задач по теории групп, к примеру, даже «научный» калькулятор — не помощник), а по каким-то окажется попросту разрушающим — как всё тот же калькулятор практически убил навык сложного устного счёта (действия с натуральными дробями, извлечение корней и проч., — для всего этого были разработаны в своё время довольно эффективные методики вычислений в уме). Не исключено, что в некотором отдалённом будущем умные боты полностью заменят, к примеру, биологических программистов, — но пока до этого ещё очень и очень далеко. ⇡#А вот и рабочая сила!Нехватка наёмных работников ощущается сегодня практически во всех отраслях развитых экономик мира, причём решать эту проблему не помогает даже трансграничная миграция: острее всего недостаёт специалистов высокой квалификации, а их подготовка требует времени и финансов. Впрочем, если верить апрельскому отчёту компании по подбору персонала Adecco Group, который цитирует Reuters, около 41% высших руководителей крупных компаний по всему миру более не считают ситуацию безвыходной: по их мнению, уже в перспективе ближайших пяти лет генеративный ИИ поможет заметно сократить число замещаемых биологическими сотрудниками вакансий. В первую очередь это коснётся направлений, формально относимых к творческим, но по сути сводящихся к поточной рутинной работе, не предполагающей какой-то шедевральности получаемых результатов. Это создание на регулярной основе текстов информационной, рекламной и частично художественной направленности, разнообразных иллюстраций (рисунков, фотореалистичных изображений, диаграмм и т. п.), видеороликов, музыки. Безусловно, высвобожденная квалифицированная рабочая сила не пропадёт втуне — тот же ИИ наверняка породит множество новых видов занятости, конкретизировать которые пока не всегда возможно. Кстати, и ИБ-службам следовало бы напрячься: модель GPT-4, как выяснилось, способна писать вполне работоспособные эксплойты, имея «на руках» исходный программный код ПО и словесное описание обнаруженной в нём уязвимости, взятое хотя бы даже из интернет-новостей, — это недавно установили исследователи из Иллинойского университета в Урбан-Шампейне. Хотя, к примеру, Ларри Саммерс (Larry Summers), бывший министр финансов США, а ныне член совета директоров OpenAI, убеждён, что со временем искусственный интеллект сможет взять на себя «практически все» формы трудовой деятельности, — вот только технические предпосылки для этого сложатся не ранее чем лет через пять. Так или иначе, острый дефицит на мировом рынке труда, особенно усилившийся по завершении пандемии COVID-19, широкое внедрение генеративных моделей должно купировать — по крайней мере, на это явно рассчитывают крупнейшие мировые работодатели. Косвенное тому подтверждение — первое за 20 лет и сразу же масштабнейшее (целых 60 тыс. человек!) сокращение персонала ведущими индийскими сервисными ИТ-компаниями: TCS, Infosys и Wipro. А если учесть, что в США ИИ уже состязается едва ли не на равных с биологическими пилотами в воздушных боях, человечеству непросто будет отстаивать перед роботами своё право на труд, если вдруг что-то пойдёт не так.

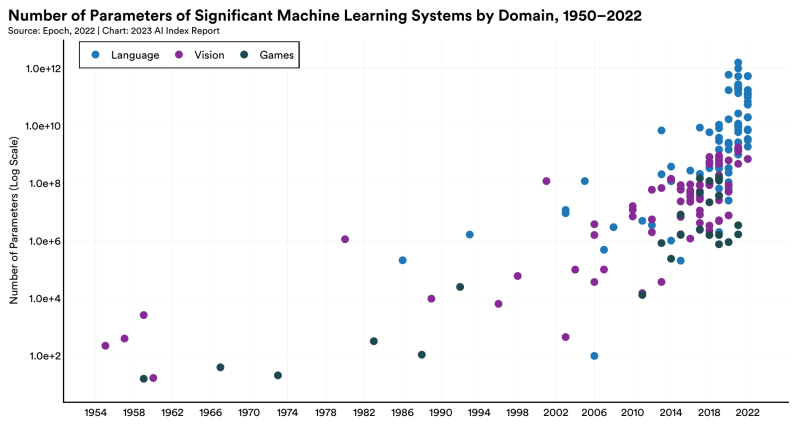

Типичное число параметров значимых систем машинного обучения по годам (логарифмическая шкала) в областях моделирования естественного языка, распознавания/генерации образов и игродельчества (источник: Institute for Human-Centered AI, Stanford University) ⇡#Титаны бьются за данныеВ области ИИ нет ничего ценнее данных: даже самая изощрённая нейросетевая модель в отсутствие должной тренировки на достаточно обширном материале не покажет сколько-нибудь удовлетворительных результатов. В то же время информации, пригодной для обучения всё более масштабных (по числу рабочих параметров — грубо говоря, весов на входах перцептронов во всех слоях нейросети) моделей, уже начинает недоставать. Так, для тренировки предполагаемой генеративной модели GPT-5, разработка которой пока официально не подтверждена, может попросту не хватить данных из всего Интернета — не говоря даже о неимоверных мегаваттах энергии и сотнях тысяч самых передовых серверных ГП, которые для этого потребуются. Согласно экспертной оценке, которую приводит The Wall Street Journal, для обучения GPT-5 предварительно необходимы 60-100 трлн токенов (свёрнутых в простые символьные строки слов и словосочетаний) — что уже превосходит весь объём содержащейся на данный момент в Сети высококачественной (достоверной, связной, без повторов и т. п.) информации по меньшей мере на 10-20 трлн токенов. Генерировать же данные имеющимися моделями для обучения перспективных тоже не выход: получающийся массив неизбежно будет изобиловать «галлюцинациями» и иными огрехами, что хорошо иллюстрирует, например, недавнее обнаружение в Google Books изрядного числа книг сомнительного качества, созданных как раз ИИ. OpenAI не прочь была бы воспользоваться данными, лежащими в открытом доступе на YouTube, скажем, — но Google активно противится этому, справедливо указывая, что выкладывавшие на видеохостинг свои файлы владельцы авторских прав не разрешали явно применять эти материалы для обучения сторонних генеративных моделей (тем более — закрытых и с платным доступом к наиболее занимательной функциональности). По этой причине разработчиков ИИ хотят заставить обнародовать сведения об использовании для тренировки данных, защищённых авторскими правами, — и это, безусловно, будет ввергать такого рода компании в дополнительные расходы. Кстати, по информации Forbes, ссылающегося на внутренние документы Stability AI и конфиденциальные беседы с её представителями, затраты компании только на аренду ИИ-серверов у различных облачных провайдеров вплотную подобрались в 2023 г. к 100 млн долл. США, — это сверх тех 54 млн, что необходимы на обеспечение текущих расходов: зарплаты, коммунальные услуги, транспорт и проч. Скорее всего, допускает издание, появившиеся в конце прошлого года планы сделать очередную модель Stable Diffusion платной для коммерческого использования (с подпиской около 20 долл./мес) связан как раз с растущими долгами разработчика на фоне необходимости заказывать всё больше серверных мощностей для тренировки ещё более передового ИИ. Неудивительно, что и Google рассматривает возможность взимать плату за поиск с применением искусственного интеллекта, — ведь чем более привлекательными для пользователя становятся генеративные модели, тем больше издержек влечёт за собой их активная эксплуатация. Ещё одна серьёзная проблема ИИ-генерации — высокое энергопотребление. В стремлении обеспечить себя доступным недорогим электричеством разработчики генеративных моделей принимаются выходить на энергетический рынок, — так, специализирующаяся на разработке и выпуске солнечных элементов питания компания Exowatt привлекла финансирование в том числе напрямую от Сэма Альтмана (Sam Altman), главы OpenAI. Совместно с известными венчурными компаниями Andreessen Horowitz и Atomic Альтман вложил в Exowatt около 20 млн долл., рассчитывая, что уже в текущем году первые создаваемые этим предприятием «тепловые аккумуляторы» (преобразуют солнечный свет в тепловую энергию, а уже из той потом добывается электричество) вступят в строй. В перспективе, как ожидается, себестоимость полученной таким образом электроэнергии может снизиться до 1 цента за киловатт-час.

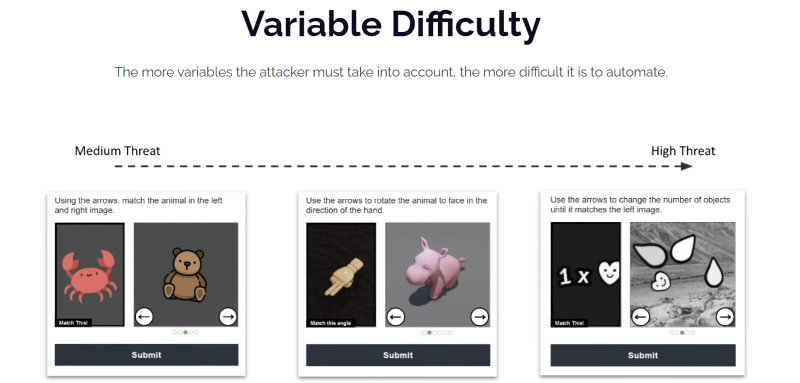

Три уровня сложности CAPTCHA для доступа к чату — и это, судя по всему, не предел! (Источник: OpenAI.com) ⇡#Кто бот? Сам ты бот!Строго говоря, уже летом прошлого года эксперты начали замечать, что боты решают графические задачи CAPTCHA (completely automated public Turing test to tell computers and humans apart — «полностью автоматизированный открытый тест Тьюринга для различения компьютеров и людей») быстрее и лучше биологических веб-сёрферов. Однако к апрелю 2024-го понимание того, что проверки на непринадлежность к ИИ-ботам стали за последнее время ощутимо сложнее, пришло и к широкой общественности. Теперь разработчики средств предотвращения нецелевого использования компьютерных ресурсов делают ставку не на статичные картинки из нескольких фиксированных категорий (светофоры, лестницы, пожарные гидранты…), а на задачки с подвохом. Вместо того, чтобы кликать по нужным квадратикам, пользователю приходится вести указателем мыши по простенькому — а то и не слишком простенькому — лабиринту, или нажимать на перечисленные значки в заданной последовательности, или напрягать зрение в попытке разглядеть едва проступающие контуры некоего символа на пёстром фоне и т. п. Эксперты The Wall Street Journal предсказывают, что дальше будет только хуже: уже зафиксированы «в дикой природе» вроде бы статичные CAPTCHA, но с нетривиальными изображениями — вроде картинки с енотом во фраке, который держит корзину с фруктами, причём посетителю предлагается с первой попытки ткнуть мышкой точно в галстук-бабочку. И всё же пока что даже самые изощрённые задачи «на выявление ботов» решаются, по приводимой экспертами Arkose Labs статистике, с первого раза почти в 95% всех случаев — причём в эту долю попадают далеко не одни только люди. Очевидно, что по мере дальнейшего развития ИИ попытки отсеивать ботов при входе на веб-страницы будут обходиться владельцам сайтов всё дороже и дороже.

Объёмная структура OpenCRISPR-1 (источник: Profluent) ⇡#Добрались и до геновОдной из передовых областей применения генеративного ИИ стала в апреле генная инженерия — благодаря стартапу Profluent из калифорнийского Беркли, разработавшему способ получения новых инструментов для редактирования генома. Ставший классическим за последние десятилетия метод такого редактирования берёт за основу методику CRISPR-Cas9 — упрощённую версию системы CRISPR-Cas, выработанной ещё на заре эволюции бактериями и археями для защиты от вирусов. Грубо говоря, это самонаводящийся наноскальпель, который, будучи доставленным внутрь клетки с целевым (обычно мутировавшим и подлежащим замене) геном, самостоятельно распознаёт положение нужного гена в структуре ДНК и разрезает молекулу именно на этом участке. Затем двойная спираль ДНК восстанавливается по сохранившейся целой ветви — и, если на той с соответствующим геном всё в порядке, происходит избавление данной копии генома от вредной мутации. Исследователи из Profluent создали при помощи большой языковой модели свою версию «наноскальпеля» — распространяемый бесплатно OpenCRISPR-1. Принципиальное его отличие от известных ранее инструментов CRISPR-Cas9 в том, что содержащиеся в нём белок и направляющая РНК синтезированы по рекомендациям ИИ и не встречаются в природе. Сама же генеративная модель была обучена на множестве последовательностей, соответствующих различным Cas9-белкам и РНК, — и в результате предложила такие биологические структуры, которые наилучшим образом (на основе предложенных нейросети данных, разумеется) исполнят своё предназначение. Пока синтетический «наноскальпель» не проходил клинических испытаний; неясно даже, окажется ли он в самом деле эффективнее более привычных генным инженерам инструментов CRISPR-Cas9. Однако OpenCRISPR-1 и его последователи дадут возможность, надеются разработчики, в будущем проводить персонифицированную генную терапию для значительно большего числа пациентов и для более широкого спектра заболеваний, чем это возможно в наши дни. ⇡#Дипфейки, дипфейки, кругом одни дипфейкиВерить на слово незнакомцам человечество должно было бы отучить еще изобретение телефона, но вот поди ж ты — до сих пор мошенничество с применением высоких технологий процветает. Искусственный интеллект, увы, тоже находит применение в этой области: к примеру, в США уже вовсю разбушевались «ИИ-адвокаты», рассылающие вполне добропорядочным компаниям сгенерированные умными ботами уведомления о нарушении авторских прав — на первый взгляд вполне основательные и грамотно составленные, но на деле не имеющие под собой реальной правовой основы. Вот и подразделение Microsoft Research Asia тоже внесло свою лепту в сокрушение безоглядной доверчивости наших современников (сизифов труд, конечно, — но вдруг да выйдет?), продемонстрировав нейросеть, способную «оживлять» любое одиночное статичное изображение человека, будь то фото или рисунок, заставляя его притом произносить какие угодно слова по единичному же образцу голоса — сопровождая речь, декламацию или даже пение широкой палитрой эмоций и естественной мимикой. ИИ-модель — разумеется, заявленная как «исследовательская демонстрация» — носит название VASA-1 (от «Visual Affective Skills Animator») и в будущем может применяться для создания локализованных на пользовательских гаджетах аватаров, способных к адекватному голосовому общению без необходимости подключаться к облачным сервисам. Пока, разумеется, о коммерческом применении VASA-1, не говоря уже о выпуске этого джинна в свободное плавание, речи не идёт, — но вполне вероятно, что аналогичная по функциональности модель с открытым кодом тоже может в обозримом будущем появиться. И как тогда, спрашивается, людям верить — если не держать их в ходе разговора непосредственно за руку? Даже документальному кино веры уже нет: в недавнем фильме-расследовании What Jennifer Did о нашумевшем убийстве, произошедшем в Канаде в 2010 г., работавшие над картиной сотрудники Netflix применяли, судя по всему, либо полностью сгенерированные ИИ, либо подправленные с использованием генеративной модели фотоснимки жертвы и её знакомых. По крайней мере, действительно заинтересовавшиеся историей энтузиасты обнаружили чрезвычайно похожие на ИИ-генерацию кадры (с недостающими пальцами на руках, с непарными серьгами, со странными складками на коже и т. п.), а продюсер ничего внятного на сей счёт так и не сказал. ⇡#Кучно пошлиАпрель ознаменовался выходом в свет сразу нескольких примечательных моделей генеративного ИИ. Так, Apple представила OpenELM — малую (в смысле аппаратных требований и, соответственно, несколько ограниченную по возможностям) модель, предназначенную для исполнения на персональных гаджетах с невысоким энергопотреблением: смартфонах и ноутбуках. Точнее, даже не одну модель, а сразу восемь, с числом рабочих параметров от 270 млн до 3 млрд (у запускающейся лишь на серверном «железе» GPT-3, напомним, рабочих параметров свыше 175 млрд), — все они доступны с открытым исходным кодом на хорошо известном ИИ-энтузиастам репозитории Hugging Face. Аналогичный продукт, генеративную модель Phi-3 Mini с 3,8 млрд параметров, натренированную на 3,3 трлн токенов, явила миру в том же месяце Microsoft — и также ориентировала свою разработку на локальное исполнение на смартфонах. Впоследствии планируется расширить это семейство моделями Phi-3 Small и Phi-3 Medium с 7 и 14 млрд параметров соответственно, натренированными на массиве в 14 трлн токенов — которые, в свою очередь, отражают массив «тщательно отфильтрованных данных из Всемирной паутины и из научных работ», как заявляется в сопровождавшей анонс публикации в журнале Computer Science. Тонкость заключается в том, что в Microsoft решили обучать Phi-3 на материалах, структурированных как книги для самых маленьких — написанные незаумными словами в составе простых по структуре предложений. При этом, поскольку литературы такого рода по всем необходимым направлениям (более 3 тыс.) в распоряжении команды тренеров, ясное дело, не оказалось, они дали поручение более сложным ИИ-моделям адаптировать к желаемому формату имеющиеся тексты, — так что особенно интересно будет сравнить Phi-3 Mini с OpenELM и другими подобными «малютками»: есть подозрение, что первая будет «галлюцинировать» заметно чаще, чем прочие. Meta✴, в свою очередь, продемонстрировала очередное поколение собственных языковых моделей, Llama 3 8B и Llama 3 70B с 8 и 70 млрд рабочих параметров соответственно, заодно интегрировав их в свои основные пользовательские приложения с многосотмиллионными аудиториями (правда, не по всему миру разом, а лишь на избранных страновых рынках). Руководство компании делает упор на серьёзное повышение производительности новых моделей по сравнению с предшествующим их поколением: так, Llama 3 8B превосходит на совокупности общепризнанных ИИ-бенчмарков (MMLU, ARC, DROP и т. д.) как Mistral 7B разработки одноимённой компании, так и Google Gemma 7B, пусть и на единицы процентов, а Llama 3 70B вполне сопоставима с Gemini 1.5 Pro — наиболее передовой разработкой Google. Наконец, многострадальная Stability AI (вынужденная сократить до 10% своего персонала из-за роста затрат и усиления конкуренции) расширила доступ к Stable Diffusion 3, своей новейшей генеративной модели для преобразования текста в изображения. Пока избранному кругу допущенных к «Тройке» доступен лишь её API в облаке, а широкое коммерческое использование новой модели, скорее всего, окажется платным — в отличие от её предшественниц SD 1.x, SD 2.x и SDXL. Энтузиастов ИИ-рисования несколько нервирует чётко артикулированное намерение Stability AI «принять разумные меры для предотвращения неправомерного использования Stable Diffusion 3 злоумышленниками», — но, с другой стороны, ИИ-хакинг никто не отменял, тем более в отношении локально устанавливаемой модели. Российский же «Сбер» в апреле не только представил усовершенствованную версию своей генеративной нейросети Kandinsky 3.1 для создания картинок по текстовым подсказкам, отличившуюся резким ростом скорости создания изображений, но и открыл доступ к ней для всех пользователей «без ограничений» (в кавычках потому, что авторизоваться на сайте Fusion Brain для пользования редактором через веб-интерфейс всё же придётся). Помимо получения картинок в ответ на введённую строку текста, модель предлагает генерацию разных вариантов предложенного изображения, смешивание картинок и текста, создание стикерпаков, а также локальное редактирование части изображения без нарушения композиции. Заодно анонсирована и модель для создания коротких видеороликов, Kandinsky Video 1.1, — но для доступа к соответствующему боту через Telegram необходимо подать заявку. Кстати, вниманию фрилансеров и бильдредакторов: согласно п. 3.1 Пользовательского соглашения пользователь (далее — цитата с сохранёнными стилистикой и пунктуацией оригинала) «обязуется осуществлять Использование Сервиса исключительно в некоммерческих целях, то есть, для личного использования в соответствии и на условиях настоящего Соглашения. Использование Сервиса для коммерческих целей и иных целей, не предусмотренных условиями настоящего Соглашения, предоставление дополнительных функций Сервиса, в том числе возможности взаимодействия с Сервисом посредством API допускается в соответствии с отдельным соглашением, заключаемым с Банком или Партнером». Так что, если кому-то захочется сопровождать свои оплачиваемые материалы творениями этой генеративной модели, имеет смысл предварительно позаботиться о юридической безупречности такого акта.

⇣ Содержание

Если Вы заметили ошибку — выделите ее мышью и нажмите CTRL+ENTER.

|

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |