|

Опрос

|

реклама

Быстрый переход

Microsoft выпустила первые собственные ИИ-модели: одна генерирует речь, а другая — текст

29.08.2025 [00:43],

Николай Хижняк

До сих пор Microsoft в значительной степени полагалась на модели искусственного интеллекта компании OpenAI. Каждый раз, когда OpenAI представляла свои новейшие модели, Microsoft объявляла об их доступности в инфраструктуре Azure и во всех своих продуктах и сервисах. Сегодня Microsoft представила две собственные модели искусственного интеллекта: MAI-Voice-1 и MAI-1-preview.

Источник изображения: Microsoft MAI-Voice-1 — это модель генерации речи. Она уже доступна в приложениях Copilot Daily (аудиосводка новостей и погоды на основе ИИ) и Podcasts. Чтобы ознакомиться со всеми возможностями этой голосовой модели, Microsoft создала новый интерфейс Copilot Labs, который каждый может попробовать уже сегодня. С помощью функции Copilot Audio Expressions пользователи могут вставить текстовый контент и выбрать голос, стиль и режим для создания высококачественного, выразительного звука. При необходимости можно скачать сгенерированный аудиофайл. Microsoft подчёркивает, что модель MAI-Voice-1 работает очень быстро и эффективно: она способна сгенерировать минуту аудио менее чем за секунду при использовании одного GPU. Модель MAI-1-preview доступна в виде публичной бета-версии на платформе LMArena для оценки сообществом. Это первая фундаментальная модель MAI, прошедшая комплексное обучение, и она даёт представление о будущих возможностях Copilot. MAI-1-preview — это модель MoE (смешанная модель экспертов), обученная на почти 15 000 специализированных ускорителях Nvidia H100. Это первая фундаментальная ИИ-модель Microsoft, прошедшая комплексное обучение собственными силами. Компания утверждает, что она эффективно выполняет инструкции и может давать полезные ответы на повседневные вопросы пользователей. Microsoft планирует внедрить MAI-1-preview для некоторых текстовых сценариев Copilot в ближайшие недели. При этом Microsoft уточняет, что MAI-1-preview не заменяет модели OpenAI в Copilot. Компания планирует использовать лучшие решения как собственной команды, так и партнёров, включая сообщество разработчиков ПО с открытым исходным кодом. Помимо платформы LMArena, модель MAI-1-preview также доступна через API для доверенных тестировщиков. «Т-Банк» представил ИИ-модель T-Pro 2.0 с гибридными рассуждениями, которая вдвое экономнее DeepSeek R1-Distil

18.07.2025 [15:43],

Владимир Мироненко

Группа «Т-Технологии» представила свою первую большую языковую модель (LLM) с гибридным режимом рассуждений — T-Pro 2.0, входящую в семейство моделей Gen-T. Сообщается, что новая модель обеспечивает более высокое качество ответов на сложные запросы при двукратной экономии вычислительных ресурсов для русскоязычных задач по сравнению с аналогами Qwen3 и DeepSeek R1-Distil. Гибридные модели способны в зависимости от запроса выбирать между быстрыми, простыми ответами и глубоким анализом, что снижает затраты на вычисления при внедрении ИИ. По данным «Т-Технологий», расходы на разработку модели, включая затраты на вычислительные мощности для R&D и финального дообучения, а также зарплаты сотрудников, не превышают 120 млн рублей. Такие модели лучше справляются со сложными аналитическими задачами, что позволяет использовать их в качестве основы для ИИ-агентов нового поколения, способных выполнять задачи без вмешательства человека. Например, в службе поддержки ИИ-агенты не просто помогают генерировать ответы, но и самостоятельно решают часть пользовательских запросов. В «Т-банке» доля таких обращений уже составляет 40 %. Согласно данным «Т-Технологий», модель T-Pro 2.0 продемонстрировала более высокие результаты на русскоязычных бенчмарках — MERA, ruMMLU, Ru Arena Hard, ruAIME, ruLCB — по сравнению с другими открытыми моделями на 30 млрд параметров. «Т-банк» планирует использовать новую модель для повышения качества работы своих ИИ-ассистентов, доступных всем клиентам банка, а также для повышения эффективности операционных процессов за счёт копайлот-решений и автономных агентов. Сообщается, что благодаря переходу на внутреннюю версию T-Pro 2.0, обученную на собственных данных «Т-банка», повысилось качество работы автономных агентов поддержки: они стали на 10 % чаще решать задачи пользователей без участия оператора и дополнительных затрат на разработку или операционные процессы. Модель T-Pro 2.0 с числом параметров 32 млрд находится в открытом доступе на платформе Hugging Face под лицензией Apache 2.0. Meta✴ похвасталась, что число загрузок ИИ-моделей Llama перевалило за 1,2 млрд

29.04.2025 [22:21],

Николай Хижняк

В середине марта Meta✴ заявила, что количество загрузок открытых моделей искусственного интеллекта Llama достигло 1 млрд. На начало декабря прошлого года этот показатель составлял 650 млн, что соответствует росту более чем на 50 % за квартал. Во вторник на своей первой конференции разработчиков LlamaCon Meta✴ сообщила, что количество загрузок моделей Llama достигло 1,2 млрд.

Источник изображения: Me «У нас есть тысячи разработчиков, которые создают десятки тысяч производных моделей, загружаемых сотни тысяч раз в месяц», — заявил директор по продуктам Meta✴ Крис Кокс (Chris Cox) во время основного доклада. Между тем количество пользователей Meta✴ AI — цифрового ИИ-помощника, работающего на моделях Llama, — составляет около миллиарда, добавил Кокс.

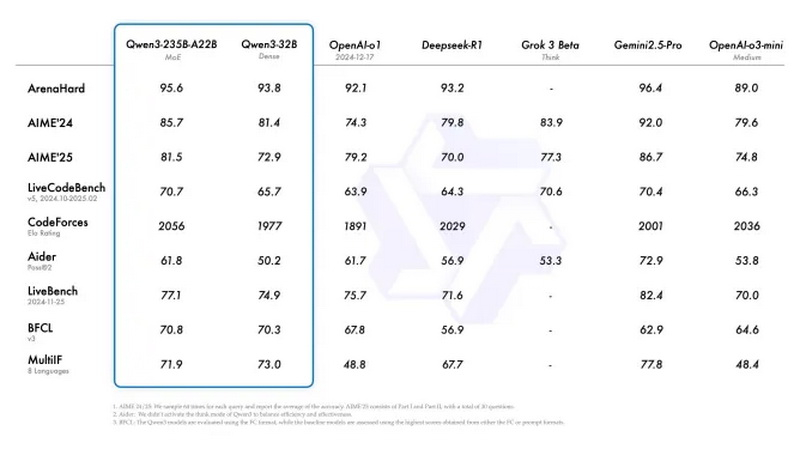

Источник изображения: Alibaba Экосистема ИИ-моделей Llama от Meta✴ растёт стремительными темпами, но технологический гигант сталкивается с конкуренцией со стороны ряда серьёзных игроков в сфере ИИ. Так, буквально в понедельник китайская компания Alibaba представила Qwen3 — семейство флагманских ИИ-моделей, которое по ряду показателей является весьма конкурентоспособным. Google представила рассуждающую ИИ-модель Gemini 2.5 Flash с высокой производительностью и эффективностью

09.04.2025 [17:46],

Николай Хижняк

Google выпустила новую ИИ-модель, призванную обеспечить высокую производительность с упором на эффективность. Она называется Gemini 2.5 Flash и вскоре станет доступна в составе платформы Vertex AI облака Google Cloud для развёртывания и управления моделями искусственного интеллекта (ИИ).

Источник изображения: Google Компания отмечает, что Gemini 2.5 Flash предлагает «динамические и контролируемые» вычисления, позволяя разработчикам регулировать время обработки запроса в зависимости от их сложности. «Вы можете настроить скорость, точность и баланс затрат для ваших конкретных нужд. Эта гибкость является ключом к оптимизации производительности Flash в высоконагруженных и чувствительных к затратам приложениях», — написала компания в своём официальном блоге. На фоне растущей стоимости использования флагманских ИИ-моделей Gemini 2.5 Flash может оказаться крайней полезной. Более дешёвые и производительные модели, такие как 2.5 Flash, представляют собой привлекательную альтернативу дорогостоящим флагманским вариантам, но ценой потери некоторой точности. Gemini 2.5 Flash — это «рассуждающая» модель по типу o3-mini от OpenAI и R1 от DeepSeek. Это означает, что для проверки фактов ей требуется немного больше времени, чтобы ответить на запросы. Google утверждает, что 2.5 Flash идеально подходит для работы с большими объёмами данных и использования в реальном времени, в частности, для таких задач, как обслуживание клиентов и анализ документов. «Эта рабочая модель оптимизирована специально для низкой задержки и снижения затрат. Это идеальный движок для отзывчивых виртуальных помощников и инструментов резюмирования в реальном времени, где эффективность при масштабировании является ключевым фактором», — описывает новую ИИ-модель компания. Google не опубликовала отчёт по безопасности или техническим характеристикам для Gemini 2.5 Flash, что усложнило задачу определения её преимуществ и недостатков. Ранее компания говорила, что не публикует отчёты для моделей, которые она считает экспериментальными. Google также объявила, что с третьего квартала планирует интегрировать модели Gemini, такие как 2.5 Flash в локальные среды. Они будут доступны в Google Distributed Cloud (GDC), локальном решении Google для клиентов со строгими требованиями к управлению данными. В компании добавили, что работают с Nvidia над установкой Gemini на совместимые с GDC системы Nvidia Blackwell, которые клиенты смогут приобрести через Google или по своим каналам. |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |