|

Опрос

|

реклама

Быстрый переход

Открытая ИИ-модель Google DeepMind Cell2Sentence-Scale 27B совершила прорыв в терапии рака, который подтвердили учёные

17.10.2025 [10:53],

Геннадий Детинич

Проблема с лечением онкологии заключается в том, что зачастую она остаётся невидимой для иммунной системы человека до тех пор, когда помощь уже мало что решает. Множество усилий учёных направлено на то, чтобы заставить опухоль проявить себя на ранних этапах — это почти наверняка спасёт пациентам здоровье и жизнь. Теперь к этому процессу подключили искусственный интеллект, который сходу обозначил прорыв в терапии рака.

Источник изображения: ИИ-генерация Grok 4/3DNews Как сообщается в блоге компании Google, в ходе сотрудничества подразделения DeepMind и Йельского университета (Yale University) открытая модель искусственного интеллекта Gemma была адаптирована для анализа поведения раковых клеток, что привело к прорыву в лечении онкологии. Разработанная на базе Gemma версия Cell2Sentence-Scale 27B (C2S-Scale) с 27 млрд параметров позволила интерпретировать «язык» отдельных клеток, выявив скрытые связи в их взаимодействии. Что особенно важно, представленная модель не только оптимизировала решение предложенных ей задач, но и смогла выработать новые и неожиданные для учёных гипотезы. Исследование было сосредоточено на так называемых «холодных» опухолях — тех, которые слабо распознаются иммунной системой из-за недостаточной презентации антигенов. Виртуальный скрининг более 4000 потенциальных препаратов, проведённый моделью, выявил кандидатов, способных выборочно усиливать иммунный сигнал в таких опухолях, делая их «горячими» и, по сути, уязвимыми для иммунотерапии. Ключевым открытием стал ингибитор киназы CK2 — силмитасертиб (CX-4945), который в комбинации с низкой дозой интерферона продемонстрировал синергетический эффект: усиление презентации антигенов на 50 % в иммуноположительной среде с низким уровнем интерферона. Проще говоря, иммунная система уже ощущала, что в организме происходит что-то неладное, но количества враждебного биологического материала в виде клеток опухоли было недостаточно для её активации. Введение силмитасертиба усилило действие естественных защитных механизмов организма и стало своего рода спусковым крючком для атаки на раковые клетки. Ранее учёные не рассматривали подобный эффект и само это вещество, что стало настоящим открытием вне компетенции человека. ИИ «додумался» до этого самостоятельно — и это само по себе открытие. Эта гипотеза сразу же была подтверждена экспериментами в лаборатории на человеческих клетках, не использовавшихся при обучении модели. Тем самым можно сказать, что модель способна обобщать знания, распространяя их на ранее неизвестные области. Такой подход может радикально повысить эффективность иммунотерапии, превращая невидимые для иммунитета опухоли в цели для T-клеток, и открыть пути для персонализированного лечения. Модель C2S-Scale уже доступна бесплатно на платформе Hugging Face, что должно стимулировать международное научное сообщество к дальнейшим исследованиям. Команды Йеля продолжают изучать механизмы действия выявленных кандидатов и тестировать другие предсказания модели, потенциально расширяя её применение на другие типы рака и стратегии их лечения. Это хорошая иллюстрация того, как открытые ИИ-технологии ускоряют фундаментальные открытия, обеспечивая доступ к передовым инструментам биомедицины для более широкого круга исследователей. Также это исследование показало, что масштаб буквально имеет значение. Сравнительно небольшие модели ИИ не смогли справиться с той же задачей. Только значительное увеличение числа параметров модели привело к открытию. В данном случае масштаб стал фактором откровения, а не просто ускорения расчётов. Возникло совершенно новое знание — и это, само по себе, дорогого стоит. Новая статья: Авторегрессионные ИИ-модели: лизоблюдство вместо силы

16.10.2025 [00:10],

3DNews Team

Данные берутся из публикации Авторегрессионные ИИ-модели: лизоблюдство вместо силы Intel представила Crescent Island — GPU для ИИ на архитектуре Xe3P и со 160 Гбайт LPDDR5X

14.10.2025 [21:52],

Николай Хижняк

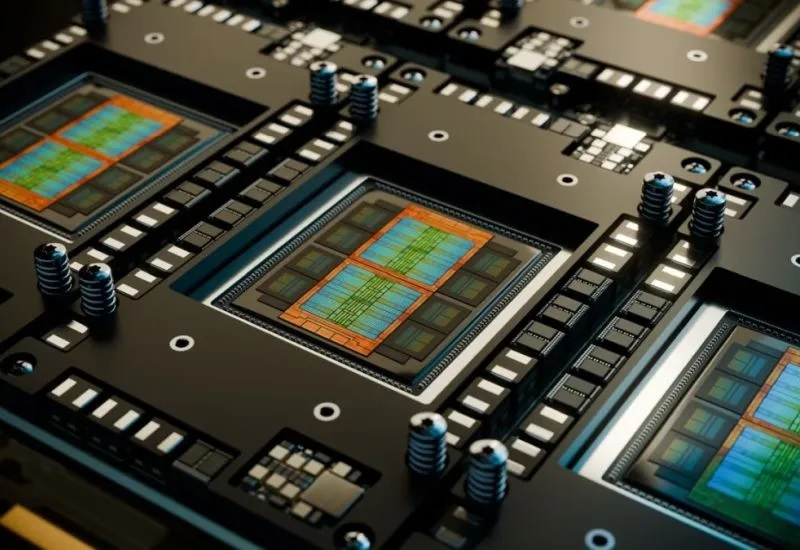

Компания Intel анонсировала новый графический процессор, предназначенный для центров обработки данных, разработанный специально для выполнения задач логического вывода (ИИ). Новинка имеет кодовое название Crescent Island и построена на базе архитектуры Xe3P.

Источник изображений: Intel Графический процессор Crescent Island основан на архитектуре Xe3P. Она представляет собой усовершенствованную версию графической архитектуры Xe3, анонсированной в составе процессоров Panther Lake для ноутбуков и компактных ПК. В перспективе Xe3P будет также использоваться в семействе потребительских видеокарт Arc следующего поколения — Arc C-Series. Новый графический процессор для ЦОД под кодовым названием Crescent Island разработан с учётом оптимизации энергопотребления и стоимости для корпоративных серверов с воздушным охлаждением, а также с акцентом на большой объём памяти и пропускную способность, оптимизированные для рабочих процессов вывода. Ключевые особенности Crescent Island:

Примечательно, что Intel выбрала память LPDDR5X для своего специализированного GPU. Конкуренты в лице Nvidia и AMD предлагают свои решения для ИИ-центров обработки данных с использованием высокоскоростной памяти HBM (например, HBM3E) и уже обсуждают применение ещё более производительной памяти HBM4 для решений будущих поколений, таких как Rubin и MI400. На фоне возросшего спроса и, как следствие, роста цен на память HBM использование LPDDR5X может предоставить решению Intel значительное преимущество в соотношении цены и производительности. Кроме того, поддержка широкого спектра типов данных делает архитектуру универсальной для различных задач, связанных с ИИ. Intel отмечает, что открытый и унифицированный программный стек для Crescent Island разрабатывается и тестируется на графических процессорах Arc Pro серии B для обеспечения ранней оптимизации и итераций. Ожидается, что образцы нового графического процессора для центров обработки данных под кодовым названием Crescent Island будут представлены клиентам во второй половине 2026 года. Итальянцы приделали ИИ к ветрякам — и те дали жару

14.10.2025 [20:52],

Геннадий Детинич

Итальянская компания Gevi Wind разработала систему ИИ-регулирования угла атаки лопастей ветряной турбины. Искусственный интеллект корректирует угол лопастей ветряного генератора каждые несколько миллисекунд, получая информацию не только о направлении и силе ветра, но даже о турбулентности, создаваемой соседними лопастями. Это заметно повышает эффективность выработки ветряной энергии, что может стать основой городской ветроэнергетики по всей Европе.

Рендер полномасштабной турбины. Источник изображений: Gevi Wind Компания Gevi Wind с офисами в Пизе и Риме основана в 2022 году. Она разрабатывает ветрогенераторы с вертикально расположенными лопастями. Такие установки могут иметь относительно небольшие размеры и быть приспособлены для выработки энергии в городской черте. Фирменный генератор Gevi Wind высотой 3 м и диаметром ротора 5,4 м способен вырабатывать 3–5 кВт мощности при скорости ветра от 2,5 м/с. Благодаря компактным габаритам его можно устанавливать на крышах зданий и в других условиях плотной застройки. Заявлен низкий уровень шума — одно из ключевых требований к ветрякам, размещаемым рядом с жилыми домами. Так, система Gevi Wind не будет создавать шум выше 38 дБ на расстоянии около 10 м. Кроме того, небольшие размеры конструкции позволят монтировать её без привлечения высотных кранов — обязательного элемента при установке башенных ветряков. Обслуживание таких установок также будет значительно проще и дешевле. Эксперименты с моделями «умных» ветряков небольших размеров показали, что турбины, оснащённые системой искусственного интеллекта, автоматически подстраивающей угол атаки лопастей в реальном времени, повышают выработку энергии на 60 % по сравнению с ветряками с фиксированными лопастями. Также ИИ позволяет на 80 % снизить механическую нагрузку на лопасти, что продлевает срок службы установки.

Модель с ротором высотой 1,7 м и диаметром 1,8 м вырабатывает 1 кВт·ч чистой энергии в год при средней скорости ветра 5,2 м/с Итальянский проект заинтересовал целый ряд инвесторов, среди которых — 360 Capital и CDP Venture Capital при поддержке фонда Acceleratori, фонда соинвестирования MiSE, фонда Toscana Next, а также NextSTEP One. Для ускорения перехода к полномасштабным изделиям компания получила финансирование в размере €2,7 млн. В случае успеха ветряки с ИИ появятся во многих городах Европы. Oracle купит 50 000 ИИ-ускорителей AMD — альтернатива Nvidia набирает обороты

14.10.2025 [20:08],

Владимир Фетисов

Компания Oracle Cloud Infrastructure на этой неделе объявила о планах по развёртыванию 50 тыс. графических ускорителей AMD с целью повышения уровня вычислительных мощностей для обеспечения нужд искусственного интеллекта. Реализация этого плана начнётся во второй половине 2026 года. На этом фоне акции AMD выросли в цене примерно на 2 %, тогда как ценные бумаги Oracle и Nvidia подешевели на 4 % и 3 % соответственно.

Источник изображения: AMD Этот шаг стал очередным признаком того, что облачные провайдеры всё чаще обращаются к ИИ-ускорителям AMD, рассматривая их как альтернативу решениям Nvidia, которая занимает доминирующее положение в этом сегменте. Oracle задействует ускорители Instinct MI450, представленные AMD ранее в этом году. Это первые ИИ-ускорители компании, которые можно объединять в более крупные системы внутри одной стойки. Возможность задействовать до 72 ускорителей в стойке должна способствовать развёртыванию и обучению самых передовых нейросетей. Ранее в этом месяце OpenAI объявила о заключении многолетнего соглашения о стратегическом партнёрстве с AMD. В рамках достигнутых договорённостей компании планируют построить инфраструктуру на базе сотен тысяч ИИ-ускорителей AMD разных поколений общей мощностью 6 ГВт. Первый кластер мощностью 1 ГВт должен быть развёрнут уже в следующем году. Сделка также предусматривает вариант, при котором OpenAI сможет приобрести до 160 млн обыкновенных акций AMD (около 10 % от общего количества) по мере достижения контрольных целей. OpenAI исторически тесно связана с Nvidia, чьи ускорители использовались для создания ChatGPT. В настоящее время Nvidia доминирует в сегменте ускорителей для центров обработки данных, занимая более 90 % рынка, и продолжает инвестировать в OpenAI. На этом фоне руководство OpenAI заявило, что компании требуется как можно больше вычислительных мощностей, поэтому она готова использовать ускорители разных производителей. В дополнение к этому OpenAI совместно с Broadcom намерена разработать собственные ИИ-ускорители. Google Meet теперь умеет накладывать виртуальный макияж с помощью ИИ

14.10.2025 [19:52],

Сергей Сурабекянц

В Google Meet наконец-то появился фильтр макияжа на базе ИИ для пользователей, которые не хотят наносить настоящий макияж перед встречей. Этот новый инструмент поможет Google Meet конкурировать с другими приложениями для видеоконференций, такими как Microsoft Teams и Zoom, которые уже поддерживают функцию виртуального макияжа.

Источник изображений: Google Meet Google Meet предлагает 12 различных вариантов макияжа на выбор. Они доступны в меню «Внешний вид» в разделе «Ретушь портрета», который появился в 2023 году и предоставляет пользователям такие возможности, как выравнивание тона кожи, осветление под глазами и отбеливание век. Google утверждает, что виртуальный макияж не зависит от движений пользователя на экране, что делает его более реалистичным. То есть, если пользователь сделает глоток кофе, фильтр останется на лице, а не переместится на кружку. После нанесения виртуального макияжа Google Meet запомнит предпочтения пользователя и применит их на будущих встречах. По умолчанию виртуальный макияж будет отключён, но его можно активировать в любой момент — как до начала, так и во время видеозвонка.

Виртуальный макияж в Google Meet на базе искусственного интеллекта стал доступен с 8 октября в мобильных приложениях и веб-браузерах. OpenAI превратится в чипмейкера — Broadcom поможет проложить «путь к будущему ИИ» на 10 ГВт

13.10.2025 [19:33],

Сергей Сурабекянц

OpenAI и Broadcom сегодня объявили о сотрудничестве по созданию и дальнейшему развёртыванию специализированных ИИ-ускорителей разработки OpenAI общей мощностью 10 ГВт. В своих чипах OpenAI планирует интегрировать опыт и знания, полученные в ходе создания передовых моделей ИИ, непосредственно в аппаратное обеспечение. Начало работ запланировано на вторую половину 2026 года, а завершение — на конец 2029 года.

Источник изображения: unsplash.com Партнёрское соглашение предусматривает развёртывание полностью масштабируемых стоек на базе ИИ-ускорителей разработки OpenAI и сетевых решений Broadcom на объектах OpenAI и в партнёрских центрах обработки данных. Для Broadcom это сотрудничество подтверждает важность специализированных ускорителей и выбор Ethernet в качестве технологии для вертикального и горизонтального масштабирования сетей в центрах обработки данных искусственного интеллекта. «Партнёрство с Broadcom — критически важный шаг в создании инфраструктуры, необходимой для раскрытия потенциала ИИ и предоставления реальных преимуществ людям и бизнесу, — заявил глава OpenAI Сэм Альтман (Sam Altman). — Разработка собственных ускорителей дополняет более широкую экосистему партнёров, которые вместе создают потенциал, необходимый для расширения возможностей ИИ на благо всего человечества». «Сотрудничество Broadcom с OpenAI знаменует собой поворотный момент в развитии общего искусственного интеллекта, — считает президент и генеральный директор Broadcom Хок Тан (Hock Tan). — OpenAI находится в авангарде революции ИИ с момента появления ChatGPT, и мы рады совместно разработать и внедрить 10 гигаватт ускорителей и сетевых систем нового поколения, чтобы проложить путь к будущему ИИ».

Источник изображения: Broadcom «Наше сотрудничество с Broadcom станет движущей силой прорывов в области ИИ и позволит полностью раскрыть потенциал этой технологии, — уверен соучредитель и президент OpenAI Грег Брокман (Greg Brockman). — Создавая собственный чип, мы можем интегрировать знания, полученные при создании передовых моделей и продуктов, непосредственно в аппаратное обеспечение, открывая новые возможности и уровень интеллекта». «Наше партнёрство с OpenAI продолжает устанавливать новые отраслевые стандарты в области разработки и внедрения открытых, масштабируемых и энергоэффективных кластеров ИИ, — полагает президент группы полупроводниковых решений Broadcom Чарли Кавас (Charlie Kawwas). — Специальные ускорители прекрасно сочетаются со стандартными сетевыми решениями […] Стойки включают в себя комплексное портфолио решений Broadcom для Ethernet, PCIe и оптических соединений, подтверждая наше лидерство в сфере инфраструктур искусственного интеллекта». В конце прошлого месяца Nvidia объявила о планах инвестировать до $100 млрд в OpenAI в течение следующего десятилетия. OpenAI планирует развернуть системы на базе ИИ-ускорителей Nvidia общей мощностью 10 ГВт, что на момент объявления эквивалентно от 4 до 5 миллионов графических процессоров.

Источник изображения: Nvidia В начале октября было подписано соглашение между OpenAI и AMD, которое предусматривает приобретение компанией Сэма Альтмана до 10 % акций производителя чипов. AMD предоставила OpenAI право на покупку до 160 миллионов своих обыкновенных акций с контрольными сроками, привязанными к объёму развёртывания и к цене акций AMD. OpenAI в течение ближайших нескольких лет произведёт массированное развёртывание графических процессоров AMD Instinct нескольких поколений в дата-центрах OpenAI общей мощностью 6 ГВт.

Источник изображения: AMD Количество активных пользователей OpenAI превысило 800 миллионов в неделю, а сама компания получила широкое распространение среди глобальных корпораций, малого бизнеса и разработчиков. OpenAI утверждает, что миссия компании — обеспечить, чтобы искусственный интеллект приносил пользу всему человечеству. Несмотря на это, многие эксперты полагают, что масштабные инвестиции в компанию лишь подтверждают опасения по поводу «циклического характера» некоторых сделок в сфере ИИ-инфраструктуры. ИИ спас США от рецессии, став единственным драйвером роста в 2025 году

12.10.2025 [15:12],

Владимир Фетисов

Беспрецедентный всплеск инвестиций в инфраструктуру для сферы искусственного интеллекта стал основным двигателем экономического роста США в нынешнем году. Эта тенденция наглядно демонстрирует, насколько сильно ИИ трансформирует экономику, а также заставляет специалистов задуматься над тем, насколько новая американская модель роста является устойчивой.

Источник изображения: techspot.com Экономист из Гарварда Джейсон Фурман (Jason Furman) провёл анализ сложившейся ситуации. В результате он пришёл к выводу, что при исключении объёма расходов на технологическую инфраструктуру, годовой рост ВВП США в первом полугодии нынешнего года составил бы лишь 0,1 %. Это подчёркивает исключительное влияние инвестиций в цифровую инфраструктуру на общие экономические показатели. «Инвестиции в оборудование для обработки данных и программное обеспечение составляют 4 % от ВВП. Но на них пришлось 92 % роста ВВП в первом полугодии этого года. ВВП за вычетом этих категорий рос в первом полугодии с годовым темпом всего 0,1 %», — говорится в сообщении Фурмана. Результаты анализа экономиста указывают, что стремительный рост спроса на передовые вычислительные ресурсы спровоцировал масштабное увеличение капитальных затрат крупнейших технологических компаний США. Некоторые аналитики считают, что всплеск инвестиций в сферу строительства центров обработки данных для ИИ стал настолько выраженным, что впервые превзошёл потребительские расходы в США, которые традиционно составляют две трети ВВП страны, и стал основным фактором экономического роста. Фурман отметил, что влияние инвестиций в ИИ-инфраструктуру могло быть менее выраженным, если бы не повышенные процентные ставки и рост расходов на электроэнергию. «Если бы не бум в сфере ИИ, у нас, вероятно, были бы более низкие процентные ставки и стоимость электроэнергии, что дало бы некоторый дополнительный рост в других секторах. Грубо говоря, это могло бы компенсировать около половины того, что мы получили от бума в сфере ИИ», — считает Фурман. Резкий рост расходов отчётливо виден в стратегиях капитальных затрат отраслевых лидеров, таких как Microsoft, Google, Amazon, Meta✴ и Nvidia. Эти компании направили десятки миллиардов долларов на строительство, расширение и модернизацию своей инфраструктуры ЦОД. Компании инвестировали в покупку современного оборудования, специализированных ИИ-ускорителей, передовых систем управления энергопотреблением и др. Директор по инвестициям Morgan Stanley Wealth Лиза Шаллет (Lisa Shallet) в рамках собственного исследования пришла к выводу, что крупнейшие технологические гиганты за последние годы увеличили собственные капитальные затраты на ЦОДы для ИИ и связанную с ними инфраструктуру в четыре раза. При этом общий объём расходов приближается к $400 млрд в год. Она отметила, что стремительный рост расходов среди IT-гигантов составляет почти треть от всех капитальных затрат в масштабах отрасли. Это искажает общую экономическую картину и увеличивает примерно на 100 базисных пунктов реальный рост ВВП США. «Скорость роста и масштабы инвестиций искажают их совокупное экономическое влияние», — считает Шаллет. В других секторах экономический рост был значительно более сдержанным. Создание новых рабочих мест в первом полугодии заметно замедлилось. В это же время отрасли, такие как обрабатывающая промышленность, недвижимость, розничная торговля и традиционные услуги, внесли минимальный вклад в общий ВВП или даже оказали отрицательное влияние. Такая динамика вызывает опасения у аналитиков по поводу того, что без инвестиций в технологический сектор экономика США могла столкнуться с рецессией. Вопросы относительно дальнейшего экономического роста остаются открытыми. Пользователи ChatGPT снова могут удалять свои чаты безвозвратно

12.10.2025 [12:08],

Владимир Фетисов

Ранее в этом году суд обязал компанию OpenAI хранить логи пользовательских чатов даже в случае их удаления. Теперь же пользователи снова могут удалять свои чаты безвозвратно.

Источник изображения: Unsplash / Levart_Photographer Судебное постановление о необходимости хранения логов пользовательских чатов было вынесено в рамках продолжающегося многомиллиардного разбирательства, в рамках которого New York Times и ряд других компаний обвинили OpenAI в нарушении авторских прав. Окружной суд Нью-Йорка вынес постановление о хранении логов чатов, посчитав, что в них могут содержаться доказательства того, что пользователи задействовали ChatGPT для генерации новостных постов на основе контента, защищённого авторским правом. Это судебное постановление затронуло сотни миллионов пользователей ChatGPT на разных тарифных планах, а также пользователей API OpenAI. При этом распоряжение не распространялось на пользователей тарифов ChatGPT Enterprise и Edu, а также тех, чье соглашение на использование API компании предусматривает опцию нулевого хранения данных. Решение суда вызвало негативную реакцию со стороны сообщества пользователей ChatGPT. Юристы OpenAI обвинили NYT в «злоупотреблении правом», заявив, что требование суда противоречит обязательствам по обеспечению конфиденциальности, которые компания взяла на себя перед пользователями. Глава OpenAI Сэм Альтман (Sam Altman) в одном из постов в соцсети X назвал требование суда «недопустимым». Ранее в этом году он также предупреждал, что информация из бесед с ChatGPT не защищена юридически и может использоваться в судебных разбирательствах. На этой неделе мировой судья Она Ванг (Ona Wang) утвердила ходатайство об отмене распоряжения о хранении данных. Это означает, что пользователи ChatGPT снова могут удалять свои беседы с ChatGPT безвозвратно. При этом все удалённые ранее чаты, логи которых OpenAI уже сохранила, по-прежнему останутся доступны для юристов The New York Times, и они смогут задействовать эти данные в качестве доказательства в продолжающемся судебном разбирательстве. Российские студенты стали активнее использовать ИИ для написания работ

10.10.2025 [23:22],

Владимир Фетисов

По данным компании «Антиплагиат», доля студенческих работ с признаками использования генеративных нейросетей достигла 24 % в нынешнем году. Это почти в четыре раза больше, чем два года назад.

Источник изображения: Mary Harris / Unsplash В период с января по сентябрь 2025 года в системе «Антиплагиат» было проведено 7 млн проверок по более чем 2 млн работам студентов. Следы применения генеративного искусственного интеллекта были выявлены почти в четверти работ. Для сравнения, годом ранее этот показатель составлял 17,8 %, а в 2023 году — 5,3 %. При этом уровень плагиата снизился с 30 % до 21,7 %, а средний объём работ увеличился с 45 до 48 страниц. В общей сложности система «Антиплагиат» выявила более 56 тыс. страниц с заимствованиями из открытых источников. В сообщении сказано, что студенты стали реже копировать готовые тексты. Вместо этого они активнее используют генеративный ИИ для редактирования и доработки имеющихся материалов. Рост применения ИИ фиксируется во всех российских вузах. В выпускных квалификационных работах доля текста с признаками генерации в нынешнем году составила 22,7 %. В топ-10 университетов данный показатель составил 16 %, а среди вузов из второй десятки — почти 25 %. Использование ИИ отличается и по направлениям подготовки: на гуманитарные и социальные науки пришлось 26,5 %, на технические — 13,4 %, на естественные — 10,4 %. Исследование проводилось на основе данных системы «Антиплагиат», которые были получены в период с 1 января по 30 сентября 2025 года. В общей сложности было проведено 7 млн проверок академических текстов, в том числе 2,07 млн курсовых и выпускных работ. Алгоритмы системы выявляли не только следы генеративных нейросетей, но и заимствования, а также определяли уровень плагиата. ИИ-браузер Dia стал доступен всем пользователям macOS

09.10.2025 [15:01],

Владимир Фетисов

В конце прошлого года разработчики из The Browser Company, создавшие браузер Arc Browser, анонсировали новый интернет-обозреватель Dia, сфокусированный на использовании инструментов на базе искусственного интеллекта. Теперь же они объявили, что продукт стал доступным всем пользователям компьютеров Apple Mac (до этого взаимодействовать с ним можно было только после получения приглашения).

Источник изображения: The Browser Company «Теперь Dia открыт для всех пользователей macOS», — говорится в заявлении компании The Browser Company, которую в прошлом месяце приобрел софтверный гигант Atlassian за $610 млн. Dia впервые стал доступным ограниченному кругу пользователей с момента начала его тестирования в июне этого года. Центральным элементом веб-обозревателя является искусственный интеллект. В нём реализованы разные функции на базе нейросетей, включая ИИ-помощника, а также инструменты для поиска, анализа и обработки информации непосредственно в окне интернет-обозревателя. Отметим, что на данный момент разработчики выпустили стабильную версию приложения только для компьютеров с macOS. Информации о том, когда может появиться версия Dia для Windows, и планирует ли вообще The Browser Company выпускать её, озвучена на была. Дженсен Хуанг «удивился» условиям сделки между AMD и OpenAI, но назвал её «хитрым ходом»

08.10.2025 [18:18],

Сергей Сурабекянц

Глава Nvidia Дженсен Хуанг (Jensen Huang) заявил, что удивлён соглашением между OpenAI и Advanced Micro Devices, которое предусматривает приобретение компанией Сэма Альтмана (Sam Altman) до 10 % акций производителя чипов. AMD предоставила OpenAI право на покупку до 160 миллионов обыкновенных акций AMD с контрольными сроками, привязанными как к объёму развёртывания, так и к цене акций AMD.

Источник изображения: Nvidia В совместном пресс-релизе компании сообщили, что OpenAI в течение ближайших нескольких лет произведёт массированное развёртывание графических процессоров AMD Instinct нескольких поколений в дата-центрах OpenAI общей мощностью 6 ГВт. На первом этапе во второй половине 2026 года должны быть развёрнуты специализированные чипы AMD общей мощностью 1 ГВт, после чего OpenAI сможет купить часть выделенных акций. Последующие транши будут разблокированы по мере масштабирования систем OpenAI и достижения ключевых технических и коммерческих целей. Эта сделка ставит под сомнение доминирование Nvidia в индустрии чипов для ИИ. «Это оригинально, это уникально и удивительно, учитывая, что они были так воодушевлены своим продуктом следующего поколения, — заявил Хуанг. — Я удивлён, что они отдали 10 % компании ещё до его [продукта] создания. В любом случае, это хитрый ход, я думаю». В конце прошлого месяца Nvidia объявила о планах инвестировать до $100 млрд в OpenAI в течение следующего десятилетия. OpenAI согласилась развернуть системы Nvidia общей мощностью 10 ГВт, что на момент объявления эквивалентно от 4 до 5 миллионов графических процессоров. Хуанг заявил, что эти инвестиции «сильно отличаются» от сделки OpenAI с AMD, поскольку позволяют Nvidia продавать свои продукты напрямую создателю ChatGPT. Инвестиции Nvidia в OpenAI подчеркнули опасения по поводу «циклического характера» некоторых сделок в сфере ИИ-инфраструктуры. На вопрос о том, как OpenAI будет финансировать сделку с Nvidia, Хуанг ответил: «У них пока нет денег». «Им придётся привлечь эти деньги, прежде всего, за счёт своих доходов, которые растут экспоненциально, будь то акционерный капитал или заёмные средства», — рассказал он, добавив, что он «жалеет только о том, что мы не инвестировали больше» в OpenAI. Хуанг также подтвердил участие Nvidia в последнем раунде финансирования xAI, в рамках которого, по данным Bloomberg, стартап Илона Маска (Elon Musk) в области ИИ стремится привлечь около $20 млрд. Он заявил, что «очень рад» этой возможности, добавив: «Почти во всём, в чём участвует Илон, вы тоже хотите участвовать». Nvidia также поддержала оператора центров обработки данных на базе ИИ CoreWeave, что, по словам Хуанга, является одной из нескольких «потрясающих инвестиций», сделанных компанией в последнее время. «[Это] действительно особенные компании, и они создают, они являются частью нашей экосистемы, создавая инфраструктуру ИИ для всего мира», — считает Хуанг. Настольные суперкомпьютеры Nvidia DGX Spark на суперчипе GB10 снова не вышли в назначенные сроки

08.10.2025 [15:01],

Николай Хижняк

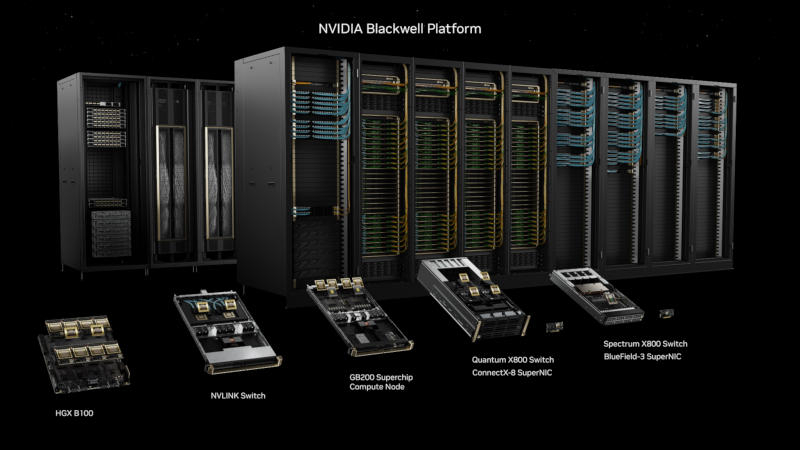

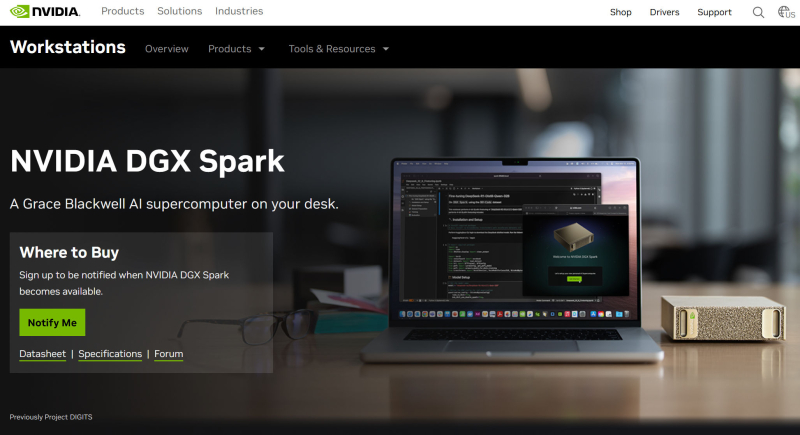

Nvidia, судя по всему, снова задерживает выпуск своего суперчипа для ИИ — GB10. Как пишет VideoCardz, компания могла перенести выпуск предназначенного для компактных рабочих станций DGX Spark процессора, на четвёртый квартал этого года. Эти системы ориентированы на ИИ-разработчиков, исследователей и других специалистов, занимающихся созданием прототипов, настройкой и доработкой больших ИИ-моделей.

Источник изображения: VideoCardz По мнению VideoCardz, GB10 на архитектуре Blackwell, вероятно, является ближайшим конкурентом AMD Strix Halo — однопроцессорной системы, разработанной в первую очередь для задач ИИ и сочетающей в себе два кристалла CPU, а также мощный графический процессор. Каждый чип Nvidia GB10 оснащён 128 Гбайт унифицированной памяти LPPDR5X, явно предназначенной для задач обучения ИИ. Изначально Nvidia планировала выпустить рабочие станции DGX Spark в мае, затем выпуск был смещён на июль. Лето прошло, но в продаже новинки до сих пор так и не появились, на что указывает полное отсутствие каких-либо обзоров или демонстраций систем. На пороге четвёртого квартала на странице продукта на официальном сайте Nvidia по-прежнему отображается всё то же сообщение «Уведомите меня» о поступлении DGX Spark в продажу.

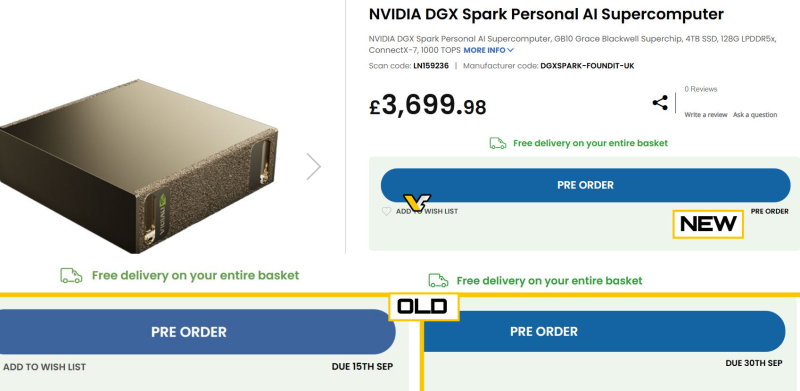

Источник изображения: Nvidia Партнёры Nvidia в лице Asus и HP в свою очередь подтверждают, что их системы DGX Spark должны выйти в четвёртом квартале, хотя никто не называет конкретных дат. VideoCardz отмечает, что за пределами Nvidia никто точно не знает, когда DGX Spark поступит в продажу. Например, британский магазин электроники Scan UK, изначально указывавший, что компактные рабочие станции поступят в продажу 15 сентября, а затем 30 сентября, теперь даже не называет дату.

Источник изображения: VideoCardz / Scan UK Ранее ходили слухи, что Nvidia также собиралась представить SoC серии N1 для потребительских ноутбуков и настольных компьютеров, но ни на CES, ни на Computex компания не анонсировала такой продукт. Более того, Nvidia никогда официально не подтверждала такие планы. Недавно генеральный директор Nvidia сообщил, что суперчип GB10 носит внутреннее кодовое название «N1», что подтверждает ранние слухи о том, что эти два чипа не просто похожи по характеристикам, а фактически являются одним и тем же. Возможно, имя «N1» изначально предназначалось для внутреннего использования, и Nvidia вообще не планировала выпускать продукт с именно таким названием на потребительский рынок. Разработчик Baldur’s Gate 3 бросил тень на план Илона Маска «сделать игры снова великими» с помощью ИИ

08.10.2025 [13:51],

Дмитрий Рудь

Глава издательского отдела выпустившей Baldur’s Gate 3 студии Larian Майкл Даус (Michael Douse) прокомментировал недавние заявления бизнесмена Илона Маска (Elon Musk) в отношении видеоигр, сгенерированных ИИ. Напомним, прошлой осенью Маск пообещал «сделать игры снова великими» с помощью ИИ, а на днях заверил, что игровая студия xAI до конца 2026 года выпустит «отличную игру, сгенерированную ИИ». По мнению Дауса, ИИ не решит главные проблемы индустрии. Это инструмент, однако все современные инструменты не могут заменить нехватку вменяемого руководства и видения, от которой страдают игры. «Нам нужно больше человеческого самовыражения, не меньше. <...> Нам не нужно по-быстрому заработать. Нам нужна стабильность. Для этого хороши инструменты, а точно не для замены людей», — считает Даус. Даус поделился, что отрасли требуются не «математически произведённые и психологически натренированные геймплейные циклы, а более экспрессивные миры, с которыми люди взаимодействуют или хотят взаимодействовать». «Без взаимоуважения не может быть отклика. Без уважения к ремеслу не может быть взаимоуважения. Без человека не может быть ремесла. <...> Превратить игры в цифровой, безэмоциональный контент — лишить их всякого отклика, ради которого люди и играют!» — подытожил Даус. Larian Studios знает, как делать игры, которые находят отклик у пользователей. Baldur’s Gate 3 стала главным хитом студии, но на достигнутом команда останавливаться не собирается и уже переключилась на разработку «двух крайне амбициозных RPG». Qualcomm приобрела Arduino — икону мира DIY-электроники

07.10.2025 [18:45],

Сергей Сурабекянц

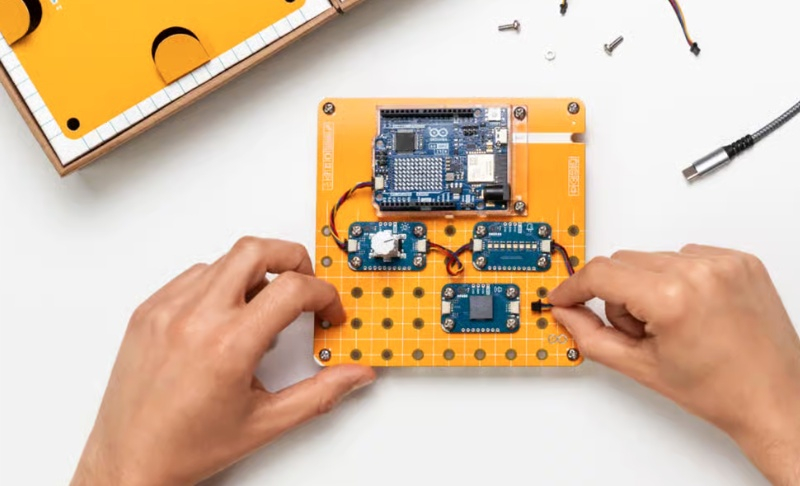

Qualcomm сегодня объявила о приобретении итальянской компании Arduino — производителя электроники, чьи недорогие программируемые платы и компьютеры широко используются стартапами, робототехническими лабораториями и широким кругом энтузиастов для создания прототипов. Представитель Qualcomm заявил, что Arduino станет независимым дочерним предприятием Qualcomm. Сумма сделки осталась неизвестной.

Источник изображений: Arduino Эта сделка даёт Qualcomm прямой доступ к масштабному сообществу разработчиков и энтузиастов робототехники. Компания рассчитывает, что поглощение Arduino поможет ей завоевать их лояльность и признание. Продукты Arduino, в силу их низкой производительности, нельзя использовать для создания коммерческих продуктов, но они отлично подходят для экспериментов, тестирования новых идей, проверки концепций и творчества. Когда некоторые из этих экспериментов приведут к созданию прототипов перспективных продуктов, Qualcomm планирует продавать их разработчикам свои чипы на коммерческой основе. «Вы начинаете двигаться к созданию прототипов, проверке концепций, и как только вы будете готовы, можно выходить на рынок, с чем мы, очевидно, хорошо знакомы», — пояснил генеральный менеджер Qualcomm по автомобильному, промышленному и встраиваемому интернету вещей (IoT) Накул Дуггал (Nakul Duggal).  Другой целью Qualcomm является стремление диверсифицировать бизнес, отказавшись от концентрации на мобильных чипах и модемах. В последнем квартале автомобильный и IoT-бизнес Qualcomm, включающий чипы, применяемые в промышленных и робототехнических продуктах, принёс компании в общей сложности 30 % от общей выручки. До сих пор небольшим разработчикам было сложно получить доступ к чипам Qualcomm, поскольку они обычно поставляются большими партиями корпоративным заказчикам. В то же время конкурирующая Nvidia всего за $249 предлагает в розничной продаже комплекты для разработчиков робототехники. Компания считает проектирование и разработку роботов самой большой возможностью для роста компании после ИИ. Дуггал сообщил, что в прошлом году Qualcomm приобрела две другие компании, Foundries.io и Edge Impulse, стремясь стать ближе к разработчикам робототехники. По его словам, Qualcomm рассчитывает на создание на базе своих чипов человекоподобных роботов, которые по уровню требований к ИИ схожи с беспилотными автомобилями. Сегодня была анонсирована первая плата Arduino — Uno Q с чипом Qualcomm Dragonwing QRB2210. Этот процессор может работать под управлением Linux, поддерживает программное обеспечение Arduino и обладает возможностями машинного зрения. Цена новой платы находится в диапазоне от $45 до $55. Платы, в настоящее время выпускаемые Arduino, используют менее производительные процессоры, которые не располагают поддержкой ИИ. Это чипы таких компаний, как STMicroelectronics, Renesas Electronics, Microchip и NXP Semiconductors. Qualcomm клятвенно заверила сообщество разработчиков Arduino, что не собирается вносить существенных изменений и продолжит производить и продавать эти платы. «Наш критерий успеха заключается в том, чтобы экосистема Arduino даже не ощутила смены владельца», — заверил Дуггал.  |

|

✴ Входит в перечень общественных объединений и религиозных организаций, в отношении которых судом принято вступившее в законную силу решение о ликвидации или запрете деятельности по основаниям, предусмотренным Федеральным законом от 25.07.2002 № 114-ФЗ «О противодействии экстремистской деятельности»; |