Компания AMD ответила на недавнее заявление NVIDIA о том, что ускорители вычислений NVIDIA H100, при использовании оптимизированных библиотек TensorRT-LLM для ИИ-расчётов, быстрее справляются с поставленными задачами, чем новые ускорители AMD Instinct MI300X. По мнению AMD, её ускорители всё равно выигрывают.

Источник изображения: Wccftech

Двумя днями ранее компания NVIDIA опубликовала свои результаты тестов специализированных ускорителей вычислений Hopper H100 и заявила, что они значительно быстрее новейших ИИ-ускорителей AMD MI300X, которые были представлены на мероприятии Advancing AI на прошлой неделе. По словам NVIDIA, AMD при сравнении своих MI300X с H100 не использовала для последних специальные оптимизированные программные библиотеки TensorRT-LLM, которые повышают эффективность ИИ-чипов NIVDIA.

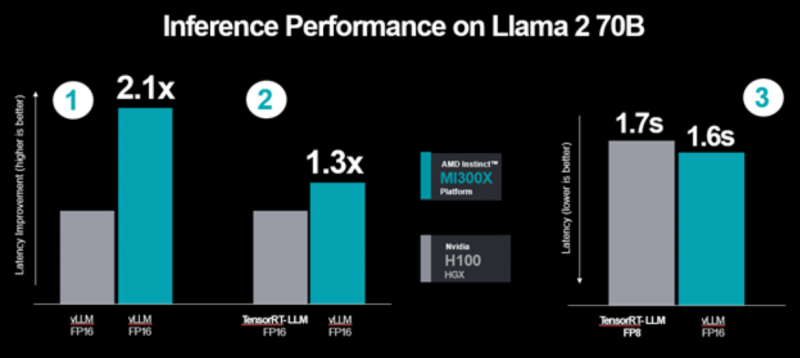

NVIDIA опубликовала данные своих тестов с использованием библиотек TensorRT-LLM, которые показали практически 50-процентное преимущество над ускорителями AMD MI300X. AMD решила ответить на это заявление, показав на новых графиках, как MI300X по-прежнему оказывается быстрее ускорителей H100, даже если последние используют оптимизированный под них стек программного обеспечения. По словам AMD, свои данные NVIDIA приводит:

- на основе тестов H100 с библиотеками TensorRT-LLM вместо библиотек vLLM, которые использовались для тестов ускорителей AMD;

- сравнивает производительность ускорителей AMD Instinct MI300X в вычислениях на числах FP16, а для тестов своих H100 использует данные типа FP8;

- в графиках инвертировала данные AMD об относительной задержке в показатель абсолютной пропускной способности.

Согласно новым тестам AMD, её ускорители MI300X, работающие с библиотеками vLLM, на 30 % производительнее ускорителей NVIDIA H100, даже если последние работают с библиотеками TensorRT-LLM. Ниже показан новый график результатов тестов ускорителей H100 и MI300X, предоставленный AMD.

Ниже приведено заявление AMD.

- «Тесты MI300X и H100 с библиотеками vLLM

- В рамках нашего анонса MI300X в начале декабря, мы сообщили, что наше решение в 1,4 раза производительнее H100 в условиях эквивалентных типов данных и программного обеспечения для расчётов. С нашими последними оптимизациями производительность MI300X оказалась в 2,1 раза выше, чем у конкурента;

- Мы выбрали vLLM, основываясь на их широком распространении среди пользователей и разработчиков, а также с тем учётом, что эта программная среда поддерживается графическими процессорами AMD и NVIDIA.

- MI300X с vLLM против H100 с оптимизированными библиотеками TensorRT-LLM

- Сравнение H100 с оптимизированным ПО TensorRT-LLM с MI300X с vLLM показывает, что MI300X с vLLM обеспечивает в 1,3 более высокую производительность в операциях FP16.

- Замеры задержки для MI300X с данными типа FP16 против H100 с TensorRT-LLM и типом данных FP8

- Ускорители MI300X продолжают демонстрировать преимущество в производительности при измерении показателя абсолютной задержки, даже в том случае, когда H100 с TensorRT-LLM работает с типами данных FP8 и сравнение приводится с MI300X, которые работают с более точными типами данных FP16. Мы (AMD) используем FP16 из-за их популярности, кроме того, vLLM не поддерживают операции FP8.

- Новые результаты снова показывают, что MI300X в работе данными FP16 сравнимы по производительности с H100, для которых используются рекомендованные настройки NVIDIA, учитывающие типы данных FP8 и программную среду TensorRT-LLM».

Публичный спор между AMD и NVIDIA в очередной раз демонстрирует, что в сегменте ИИ-вычислений наблюдается очень высокая конкуренция между производителями аппаратного обеспечения, которые готовы бороться за каждого клиента.

Источники:

MWC 2018

MWC 2018 2018

2018 Computex

Computex

IFA 2018

IFA 2018

Сравнительный тест камер флагманских смартфонов (2024) — голосуют читатели

61

Сравнительный тест камер флагманских смартфонов (2024) — голосуют читатели

61

ASML и TSMC придумали, как удалённо испортить EUV-оборудование в случае вторжения Китая

61

ASML и TSMC придумали, как удалённо испортить EUV-оборудование в случае вторжения Китая

61

AMD представила настольные процессоры EPYC 4004 — Socket AM5, до 16 ядер Zen 4 и встроенная графика

38

AMD представила настольные процессоры EPYC 4004 — Socket AM5, до 16 ядер Zen 4 и встроенная графика

38

«Вояджер-1» перестал бредить и впервые за полгода прислал научные данные

33

«Вояджер-1» перестал бредить и впервые за полгода прислал научные данные

33

Подписаться

Подписаться